Forschungsprojekt Propedes

Mehr Sicherheit für Fußgänger

Fortsetzung des Artikels von Teil 4

Fusionsverfahren

Die Fusion bildgebender Sensoren ist auf drei Ebenen realisierbar: Auf der Bildpunktebene, der Merkmalsebene und der Objektebene. Bei der Fusion müssen dabei die durch die Fusionsebene definierten Strukturen in den Bildern der zu fusionierenden Sensoren identifiziert werden. Dies kann bei der Fusion auf der Bildpunktebene für an unterschiedlichen Stellen im Fahrzeug verbaute Sensoren nicht eindeutig gelöst werden und fällt aus diesem Grund für die praktische Anwendung aus. Bei der Fusion auf der Merkmalsebene müssen in den jeweiligen Sensorbildern aus mehreren Bildpunkten zusammengesetzte Strukturen einander zugeordnet werden. Dies ist mit vertretbarem Such- und damit Rechenaufwand möglich. Bei der Fusion auf Objektebene müssen lediglich die im Einzelsensorsystem detektierten Objekte einander zugeordnet werden. Dies ist im Regelfall mit einfachen Mitteln, d.h. mit geringem Rechenaufwand möglich.

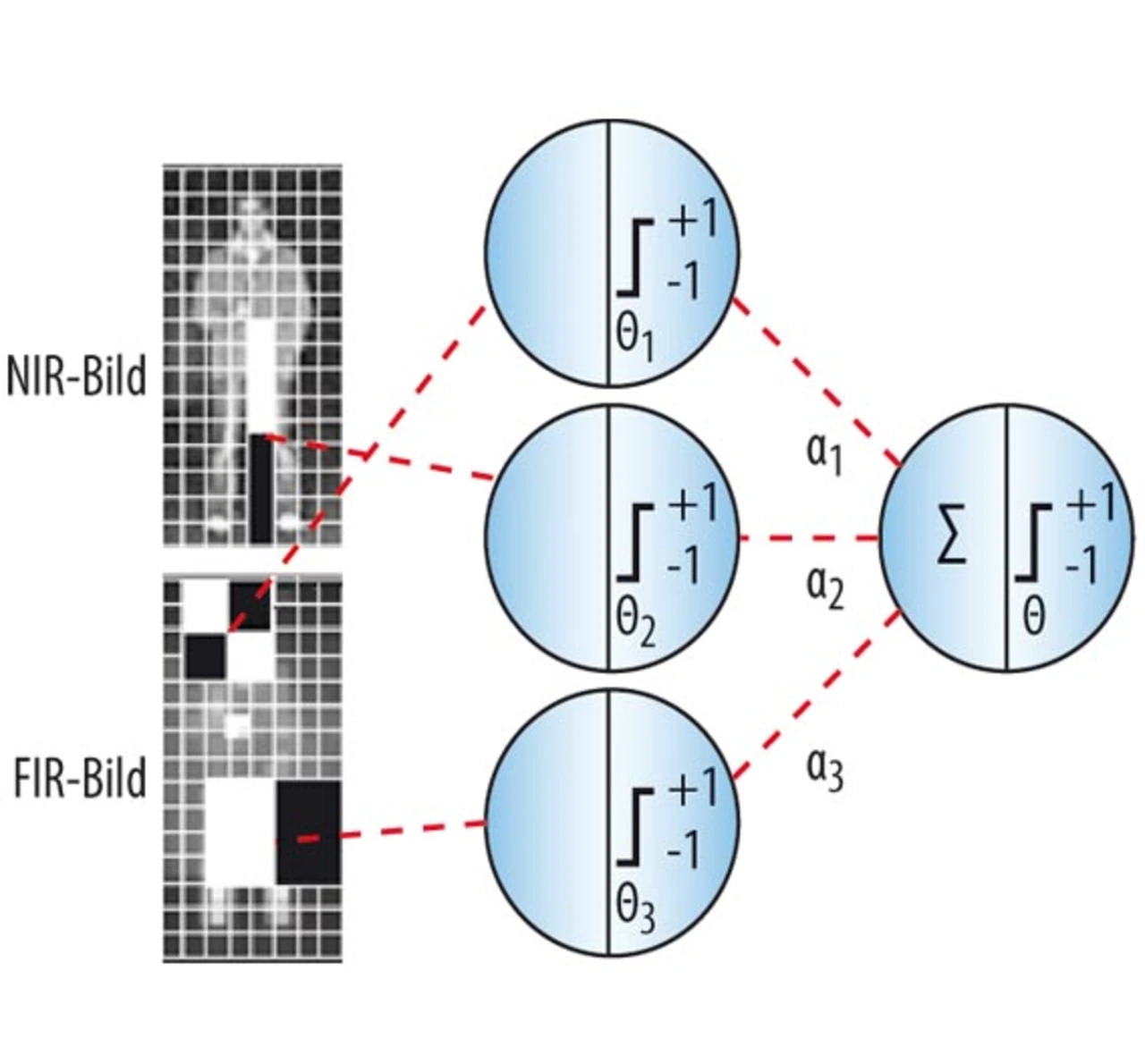

Das in Propedes entwickelte Fusionsverfahren lässt sich auf alle bildgebenden Sensoren, d.h. sowohl auf NIR-Radar-Bilder als auch für NIR-FIR-Bilder anwenden. Es arbeitet auf der Merkmalsebene und ist in Bild 3 für die Sensorkombination NIR-FIR dargestellt. Dies ermöglicht - im Gegensatz zur Fusion auf Objektebene, in der die Ergebnisse der Einzelsensorsysteme kombiniert werden - eine Systemleistung (Detektionsrate gegenüber Falschalarmrate), die deutlich über der eines Einzelsensorsystems liegt. Untersuchungen ergaben, dass im NIR-FIR-System 93 Prozent der Fußgänger im Entfernungsbereich bis 127 m detektiert wurden, während im gleichen Test ein FIR-Einzelklassifikator lediglich 78 Prozent der Fußgänger detektieren konnte.

- Mehr Sicherheit für Fußgänger

- Nachtsichtassistenten der nächsten Generation

- NIR-Radar

- NIR-FIR

- Fusionsverfahren

- In Propedes entwickelte Software-/Hardware-Architekturen für mehr Rechenleistung

- Anbindung an das ADTF-Framework

- Optimale Partitionierung der Videoalgorithmen

- Applikationsspezifisch konfigurierbare Soft-Core-Prozessoren

- Umsetzung auf Multi-FPGA-Hardware-Plattform

- FPGA-basierter Ansatz bietet viel Potential

- Die Autoren