»Kompaktheit & KI sprechen für Embedded«

Was tut sich auf dem Markt für Embedded Vision?

Welche Trends zeigen sich derzeit bei Embedded Vision? Welche Vor- und gegebenenfalls Nachteile haben Embedded-Vision-Systeme gegenüber PC-basierten, und was müssen Embedded-Vision-Entwickler beachten? Peter Behringer, Marketingleiter für die Region EMEA bei Basler, gibt nähere Informationen.

Elektronik: Wie sind heutige Embedded-Vision-Systeme aufgebaut?

Peter Behringer: Grundsätzlich unterscheiden sich Embedded-Vision-Systeme in ihren Komponenten gar nicht so sehr von klassischen, also PC-basierten. Das bedeutet, dass im Wesentlichen ähnliche Komponenten zum Einsatz kommen. Auf der Hardware-Seite sind das im Großen und Ganzen fünf Komponenten.

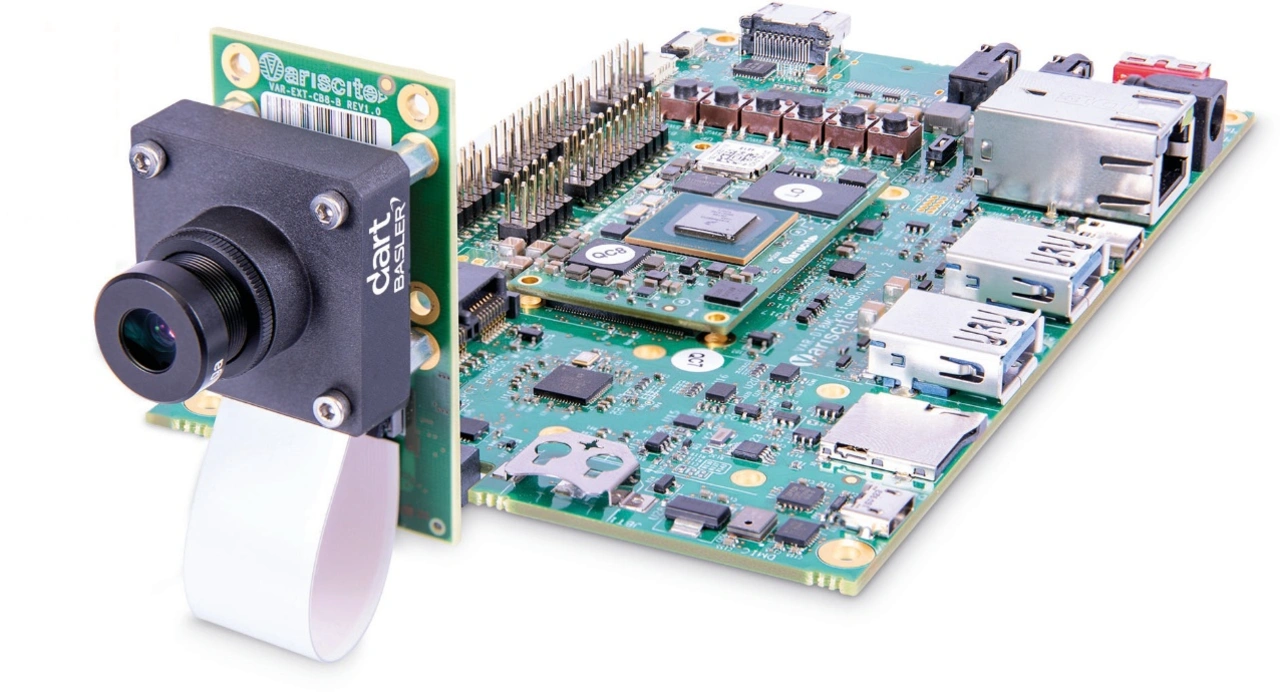

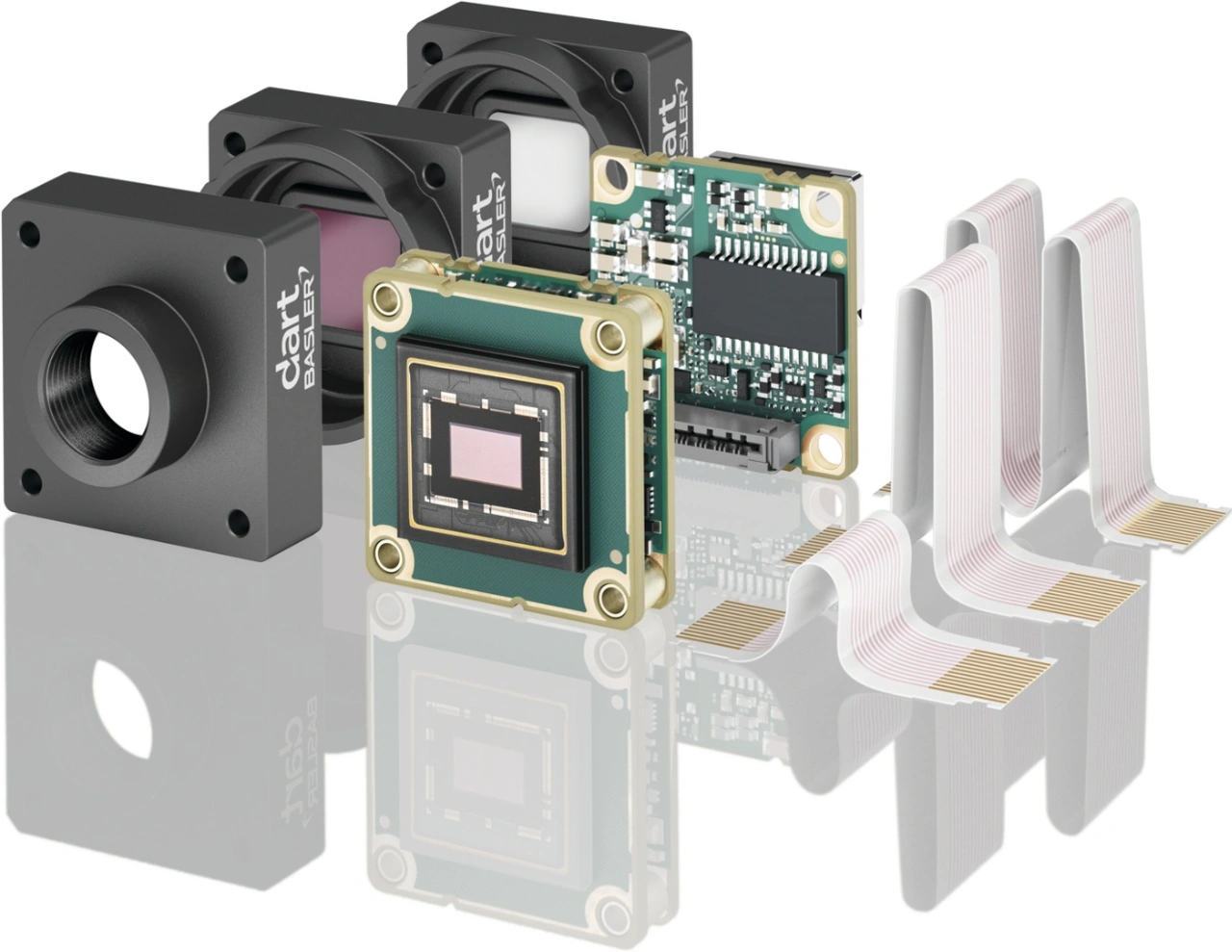

Zunächst wird das Licht über ein Objektiv gebündelt. Bei Embedded-Vision-Systemen ist das in der Regel eher ein S-Mount- als ein C-Mount-Objektiv. Das gebündelte Licht gelangt auf den Bildsensor, der typischerweise in einer Kamera verbaut ist. Die Kamera ist über ein Kabel mit einer Recheneinheit verbunden. Diese Recheneinheit unterscheidet sich bei einem Embedded-System dann tatsächlich von einem PC-basierten System. Bei dem Embedded-System besteht sie im Kern aus einem SoC, einem System on Chip. Die nächstgrößere Einheit, auf der das SoC sitzt, ist das SoM, ein System on Module. Ob Kunden die SoCs einzeln kaufen können, hängt vom jeweiligen Hersteller ab. Während NXP und Qualcomm ihre SoCs einzeln anbieten, können Kunden bei Nvidia nur ein SoM kaufen.

Das SoM ist wiederum auf einem Carrier-Board aufgesteckt, das aber eigentlich ein sehr passives Bauteil ist, weil es letztlich nur die Anschlüsse, die im SoC und SoM vorgesehen sind, nach außen führt. Das heißt, ein Kunde, der ein Display an sein Embedded-Vision-Device anschließen will und dafür einen HDMI-Ausgang braucht, baut den HDMI-Ausgang auf sein Carrier-Board. Andere Kunden möchten vielleicht zehn USB-Ausgänge auf dem Carrier-Board, weil sie nur Kameras haben. Wieder andere möchten hingegen Wi-Fi. Die fünfte Komponente schließlich ist das Gehäuse. Es umschließt die anderen Komponenten, also Objektiv, Kamera, Kabel und Recheneinheit, und komplettiert das Embedded-Vision-System – und dann gibt es natürlich die Software.

Welche besonderen Eigenschaften hat die Software in Embedded-Vision-Systemen?

Es ist sinnvoll, drei verschiedene Arten von Software zu unterscheiden. Zum Ersten gibt es die Bildvorverarbeitung der Pixeldaten. Sie ist sehr wichtig – nicht von ungefähr geschieht sie bei Lösungen von Basler überwiegend in der Kamera selbst. Dann gibt es die Bildverarbeitung. Diese kann unterschieden werden in die klassische Bildverarbeitung und die KI-basierte Bildverarbeitung. Die klassische Bildverarbeitung arbeitet mit deterministischen Algorithmen. Anders als bei der KI-basierten Bildverarbeitung werden diese Algorithmen nicht trainiert, und sie beruhen nicht auf neuronalen Netzen.

Warum unterteile ich die klassische Bildverarbeitung und die KI-basierte Bildverarbeitung nochmals? Weil die für Embedded Vision verwendeten Chips, also zum Beispiel GPU, NPU, TPU, so entwickelt sind, dass sie bestimmte Rechenarten besonders gut ausführen können, wohingegen bei PC-basierten Systemen traditionell alles über die CPU läuft. In unseren Kameras sind FPGAs verbaut, Field Programmable Gate Arrays, die Bildvorverarbeitung sehr gut beherrschen, weil sie Pixeldaten parallel verarbeiten können und beispielsweise eine Faltungsoperation besonders gut durchführen können. Die CPU selbst, die beim PC normalerweise sehr groß ist, ist bei Embedded-Boards üblicherweise recht schmalbrüstig. Dagegen haben Embedded-Boards eine vergleichsweise große GPU, Graphics Processing Unit, die sich auch für die KI-Beschleunigung eignet. Hier lässt sich ein Trend zur Verwendung eigener kleiner AI Accelerators beobachten, also kleine Chips, die nur für die Aufgabe gebaut sind, neuronale Netze auszuführen.

Das wären dann NPUs, Neural Processing Units, richtig?

Ja, und es wären in diesem Fall separate Chips. Wir reden intern von xPUs, weil jeder Hersteller an die erste Stelle einen anderen Buchstaben setzt. Bei NXP heißt es NPU, beim Google-Coral-Chip heißt es TPU, Tensor Processing Unit. Es gibt eine Vielzahl derartiger Chips. Und es gibt Start-ups, die damit ihr Geld verdienen, diese Chips zu bauen, etwa das israelische Unternehmen Hailo.

Gehen Sie also bei Embedded Vision eher vom getrennten AI Accelerator und nicht vom im SoC integrierten AI Accelerator aus?

Ich glaube, die großen Firmen werden sich die Butter nicht vom Brot nehmen lassen. Möglicherweise arbeitet auch Nvidia an noch dedizierteren Chips. GPUs eignen sich ja schon gut für die KI-Beschleunigung, aber die Chips, die nur neuronale Netze ausführen, sind eben noch energieeffizienter, sodass in den neuesten Chip-Generationen die Co-Accelerators auch bei den Großen kommen könnten.

Bieten sich Embedded-Vision-Systeme also generell eher für Anwendungen mit KI-Modellen an als PC-basierte Vision-Systeme?

Ja, dieser Trend zeigt sich auf jeden Fall. Es ist nicht ausschließlich so, aber dadurch, dass dedizierte AI Accelerators auf den Embedded-Boards solche Fähigkeiten mitbringen und so die Voraussetzungen für KI-Anwendungen schaffen, liegt es nahe, sich als Entwickler mit künstlicher Intelligenz zu beschäftigen.

Nvidia Jetson ist das Embedded-Board, das heutzutage sicherlich am meisten genutzt wird in unserer Industrie. Denn Nvidia Jetson hat sich von der Performance her so positioniert, dass es von Entwicklern bevorzugt wird, die von PC-basierten Systemen herkommen. Außerdem gibt es Lösungen, die sich für sehr hohe Stückzahlen anbieten, aber auch einen sehr großen Entwicklungsaufwand mit sich bringen. Sie beruhen auf SoCs von Anbietern wie etwa Ambarella, NXP oder Qualcomm, die dann nochmal günstiger sind.

Aber eine der Kerntatsachen, an denen man bei Embedded Vision nicht vorbeikommt, ist folgende: Je günstiger es am Ende werden muss, desto größerer Entwicklungsaufwand entsteht. Wenn also die Stückkosten sehr günstig sein sollen, habe ich sehr hohen Entwicklungsaufwand, und wenn ich keinen hohen Entwicklungsaufwand habe, ist das Projekt kostenoptimiert nicht so ausdifferenziert. Die Strategie von Basler ist, diesen Entwicklungsaufwand möglichst zu schmälern, um letztlich Entwicklern zu ermöglichen, auch mit Embedded-Systemen so umzugehen, als wären es PC-basierte Systeme, ohne dass sie dazu gezwungen sind, Treiber oder passende Kabel für die Kameras zu suchen.

Ist das Nvidia-Jetson-Board also faktisch gleichbedeutend mit dem SoM?

Ja, korrekt. Wie gesagt, ist es bei Nvidia eine Besonderheit, dass sie das SoC nicht als solches anbieten. Das SoC ist bei Nvidia immer auf einem SoM integriert. Und alles, was die Hersteller dann noch machen können, ist ein Carrier-Board darunter zu packen und das System in ein Gehäuse zu verbauen. In dieser Art gibt es viele Angebote am Markt.

Für welche Anwendungen eignen sich eher Embedded-Vision-Systeme, für welche klassische Bildverarbeitungssysteme?

Unsere Kunden legen bei Embedded vor allem Wert auf zwei Aspekte. Zum einen sollen die betreffenden Geräte sehr kompakt sein, was bei mobilen Geräten meist der Fall ist. Embedded kommt dagegen so gut wie nicht zum Einsatz bei Inspektionssystemen, die Computer Vision auf Förderbändern durchführen und dort 15 Jahre ihren Dienst tun. Anders verhält es sich bei portablen Inspektionssystemen, etwa in den Bereichen Medizin und Lebenswissenschaften. Diese Geräte sollen klein und kompakt sein, vielleicht neben einem Patientenbett stehen und eine Blutanalyse durchführen, manchmal sogar batteriebetrieben. Hier überlegt man sich, wie sich die Aufgabenstellung möglichst kompakt umsetzen lässt, und dann wird Embedded Vision in Betracht gezogen, einfach weil man dort keinen kompletten PC aufstellen kann, sondern die Processing Unit klein sein muss. Damit einher gehen bestimmte Anforderungen an die Kabel, etwa dass Flachbandkabel zum Einsatz kommen, die geknickt werden können, ohne Schaden zu nehmen. Häufig verwendet man außerdem Einplatinen- oder Board-Level-Kameras. Das sind keine Kameras mehr, die in einem Gehäuse stecken, sondern solche, die nur noch ein Board mit dem Sensor darauf umfassen und die Bildvorverarbeitung durchführen.

Ein weiterer Grund sind die Kosten. Unsere Kunden achten genau auf die Kosten der Hardware, stellen dann aber oft fest, dass der Entwicklungsaufwand höher ist als erwartet. Die Annahme, dass durch Embedded Vision mit einer bestehenden R&D-Truppe massiv Kosten eingespart werden können, ist falsch. Denn je mehr Embedded gewünscht wird, desto teurer wird die Entwicklung und desto teurer werden auch die Entwickler. Embedded-Entwickler, die sich mit SoCs und SoMs auskennen und diese programmieren können, sind deutlich teurer als Entwickler PC-basierter Systeme.Nac

- Was tut sich auf dem Markt für Embedded Vision?

- Hat Embedded Vision auch Nachteile?