»Kompaktheit & KI sprechen für Embedded«

Was tut sich auf dem Markt für Embedded Vision?

Fortsetzung des Artikels von Teil 1

Hat Embedded Vision auch Nachteile?

Ist das entscheidende Thema also nicht Kostenersparnis, sondern eher, wie ein System am besten in bestimmte Anwendungen passt?

Ja, so ist es. Die Kunden ziehen Embedded Vision in Betracht, oft zunächst aus Kostengründen, und bei hohen Volumina und Stückzahlen ist das auch sinnvoll. Wir haben einige Kunden, die Embedded-Lösungen anbieten, besonders im Verkehrswesen, also bei der intelligenten Verkehrsüberwachung, aber auch in der Robotik, in der Logistik sowie im Medical- und Life-Science-Markt. Im Medical-Markt setzen die Kunden am ehesten Embedded-Lösungen ein. Bei wenigen 100 bis 1000 Geräten ist es in puncto Kosten auf der Schwelle. Aber wenn man plant, mehr als 1000 Geräte pro Jahr abzusetzen, dann ist es schnell sinnvoll, auch Embedded-Devices einzusetzen, besonders bei echten High-Volume-Projekten mit mehreren 1000 Geräten pro Jahr. Bei solchen Projekten zeigen sich mit Embedded-Systemen wirklich signifikante Kostenvorteile, aber auch erst ab diesen Stückzahlen. Wenn also ein Unternehmen 50 Geräte absetzen und dabei Kosten sparen will durch den Sprung auf Embedded, wird das im Zweifel nur klappen, wenn der Kamerahersteller alle notwendigen Treiber und Einplatinen-Kameras bereitstellt und so etwas nicht erst entwickelt werden muss.

In der Robotik dienen Embedded-Vision-Systeme als Augen von Roboterarmen oder AMRs, Autonomous Mobile Robots. Sind in diesem Fall immer Platinenkameras integriert oder lassen sich Embedded-Vision-Systeme auch mit Gehäusekameras kombinieren?

Beides ist möglich, wobei der Normalfall bei sehr kompaktem Bauraum eine Einplatinen-Lösung wäre. Mit zunehmender Kompaktheit neigen die Kunden eher zu Einplatinen- oder Zweiplatinen-Kameras ohne Gehäuse.

Wo sehen Sie generell die Nachteile von Embedded-Vision- gegenüber PC-basierten Systemen?

Als einen Nachteil von Embedded-Vision-Systemen betrachte ich, wie gesagt, auf jeden Fall den Entwicklungsaufwand, vor allem dadurch, dass beim Wechsel vom PC zum Embedded-System die Software-Architektur angepasst werden muss.

Ein weiterer wichtiger Aspekt ist das Thema Bildvorverarbeitung. Aus unserer Sicht hat es sich bewährt, die Bildvorverarbeitung in der Kamera anzusiedeln. Auch unsere Einplatinen-Kameras haben deshalb FPGAs integriert, die die Bildvorverarbeitung erledigen. Dadurch sind unsere Einplatinen-Kameras nicht die preisgünstigsten, aber im Gesamtsystem sind sie in puncto Aufwand und Kosten viel attraktiver, als wenn man sich mit dem ISP, Image Signal Processor, des Boards herumschlagen müsste – gerade wenn es nur um wenige hundert Geräte geht.

Generell raten wir unseren Kunden, sich frühzeitig damit zu befassen, wo die Bildvorverarbeitung stattfinden soll, also etwa das Debayering, eine Vignetting Correction oder ein Tone Mapping, also bestimmte Bildvorverarbeitungs-Funktionen. Dass hinter einem Bild der Weißabgleich und eine komplexe Signalverarbeitung steckt, muss man eben mitbedenken, besonders bei Embedded-Vision-Systemen, sonst wird es teuer.

Ist das bei Systemen auf PC-Basis einfacher?

Ja, bei ihnen ist es der Normalfall, dass die Bildvorverarbeitung in der Kamera geschieht. Manche Anbieter haben dafür die CPU eingeplant und belasten sie also damit. Aus unserer Sicht ist das nicht sinnvoll, sodass alle unsere Kameras die Bildvorverarbeitung übernehmen. Das hat große Vorteile für die Kunden, weil dann die CPU genügend Kapazität für die eigentliche Applikation hat und nicht noch die Pixeldaten berechnen muss. Denn wenn man einem Embedded-Device wie etwa einem Raspberry Pi nicht-debeyerte Daten gibt, dann ist seine CPU sehr lange damit beschäftigt.

Es zeigt sich, dass es viel zu beachten gibt, um für bestimmte Anwendungen das Optimale aus den Chips und den SoMs herauszuholen und eine entsprechende Kombination hinzubekommen. Genau deshalb setzen wir eigentlich nur noch auf die größten Player, die wir im Markt sehen, und das sind eben Nvidia und NXP. Nvidia bringt die Leistung mit und ist sozusagen immer up to date, was die Performance anbelangt. Und NXP setzt auf Langzeitverfügbarkeit – ein großer Vorteil für Industriekunden, wobei Nvidia nachgebessert hat, indem sie ihre Produkte jetzt auch länger anbieten als typische Konsumentenzyklen. NXP setzt aber mit einer Verfügbarkeit von 10 bis 15 Jahren immer noch den Industriestandard.

Was ändert sich durch den Trend von klassischen Bildverarbeitungssystemen zu Embedded Vision für Entwickler – abgesehen von Entwicklungsaufwand und -kosten?

Wichtig ist außerdem, dass es bei Embedded Vision generell weniger Standards gibt. MIPI CSI-2 als das Kamera-Interface schlechthin hat keinen physikalischen Konnektor spezifiziert, das heißt, man muss sich immer selbst überlegen, wie man den Konnektor baut, ob man einen Raspberry-Konnektor nimmt oder nicht. Hinzu kommt das schon erwähnte Thema CPU-Load: Bildvorverarbeitung in der Kamera ist durchaus sinnvoll, weil die CPU in Embedded-Systemen sehr klein ist, sodass es wichtig ist, sie mit Aufgaben zu betrauen, die genau zu ihr und zur Applikation passen. Wenn ich beispielsweise ein Gesichtserkennungsgerät bauen will, dann ist es mir als Entwickler wichtig, dass die CPU und die GPU auch wirklich für die Gesichtserkennung genutzt werden und nicht noch Bildvorverarbeitung machen müssen.

Wie lässt sich Embedded-KI auf konkrete Bildverarbeitungsanwendungen vorbereiten und in Embedded-Vision-Hardware implementieren?

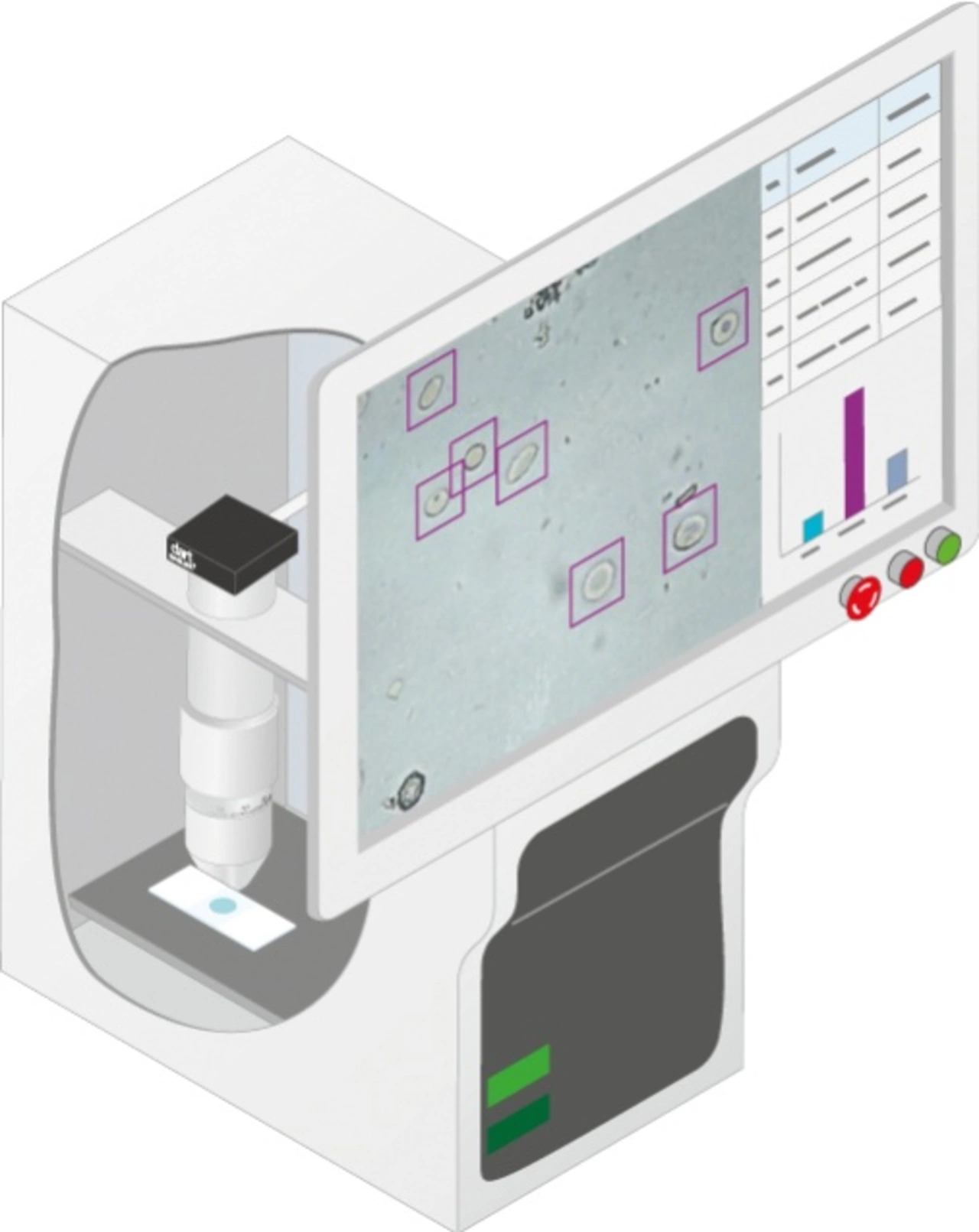

Es gibt dafür entsprechende Tools. Auch wir bieten eines an, »pylon AI«. Mit pylon AI können Anwender mit Bildmaterial trainierte Modelle ablaufen lassen und benchmarken. Wenn ich das Modell trainiert habe, muss ich sicherstellen, dass die Hardware das trainierte Modell in der benötigten Geschwindigkeit ausführen kann. Das ist oft nicht so einfach, aber wir haben dafür eine Lösung geschaffen, mit der Anwender simulieren können, wie schnell trainierte Modelle in welchem Ziel-Hardware-System ablaufen können. Sprich: Wenn ein trainiertes neuronales Netz vorhanden ist, das beispielsweise Gesichter erkennt, sehen Anwender schon früh im Entwicklungsprozess, wie viele Frames pro Sekunde ein PC-basiertes System mit Nvidia-Einsteckkarte, ein Nvidia-Jetson-Board oder ein Embedded-Device von NXP bewältigen kann. Auf dieser Basis können sie beispielsweise entscheiden, ob sie eine Nvidia-Lösung nutzen oder beim PC bleiben wollen.

Entwickler entscheiden also erst relativ spät, welche Art von Hardware sie verwenden?

Ja, mit unserer Lösung ist das so. Damit lösen wir aber das Problem im Markt, dass Entwickler ihre Anwendungen schon halb fertigstellen mussten, um klären zu können, welches Ergebnis sie mit Nvidia und welches mit NXP bekommen. Generell sollten Kamerahersteller ihren Kunden erläutern, welche Boards und SoCs für deren Anwendungen überhaupt in Frage kommen. Wir können unseren Kunden für ihre Anwendungen alles bieten, das SoM-Modul, das Carrier-Board und die Kamera plus Gehäuse, und liefern bei entsprechenden Stückzahlen alles komplett.

Wie entwickelt sich der Anteil von Embedded-Vision-Anwendungen an den Bildverarbeitungsanwendungen generell?

Er steigt inzwischen relativ stark an, das kann man auf jeden Fall sagen. Und das Thema KI wird in der Bildverarbeitung sicherlich ganz neue Dinge hervorbringen. Heutzutage nutzen unsere Kunden KI überwiegend aus zwei Gründen. Erstens: Sie wollen eine bestehende Bildverarbeitungslösung noch besser machen. Zweitens, und das ist der weitaus größere Teil, nutzen sie KI für Bildverarbeitungsaufgaben, die vorher einfach nicht zu lösen waren. Mit klassischer Algorithmik lässt sich beispielsweise eine Oberflächeninspektion von Textilien überhaupt nicht bewältigen, aber mit Bildverarbeitung auf KI-Basis funktioniert das jetzt zum ersten Mal. Hinzu kommt, dass immer mehr Systeme mobil werden und dadurch von KI-basierter Bildverarbeitung profitieren – mobile HMI, mobile Robotik, mobile Medizingeräte und auch mobile Flugobjekte wie Drohnen.

- Was tut sich auf dem Markt für Embedded Vision?

- Hat Embedded Vision auch Nachteile?