Bewegte Partikel sichtbar machen

Event-basierte Kameras in der 3D-Strömungsdiagnostik

Wie lässt sich die Bewegung von Luft oder Wasser sichtbar machen, und zwar in drei Dimensionen? Industriekameras mit Event-basierter Sensorik liefern dafür eine neue Datenbasis: Sie erfassen nur das, was sich wirklich verändert, und ermöglichen so eine präzise Strömungsanalyse mit minimalem Aufwand.

Besonders spannend wird es, wenn mehrere dieser Kameras kombiniert werden, etwa zur 3D-Verfolgung Tausender Partikel in Echtzeit.

Die präzise Analyse von Strömungen – sei es von Luft, Wasser oder anderen Medien – ist ein zentrales Werkzeug in Forschung und Entwicklung. Um die Bewegung einzelner Partikel sichtbar zu machen, kommen bislang meist teure High-Speed-Kameras zum Einsatz. Diese liefern zwar beeindruckend detaillierte Bilder, erzeugen aber enorme Datenmengen, die aufwendig gespeichert, übertragen und verarbeitet werden müssen. Und selbst bei hohen Frameraten sind die Ergebnisse stark abhängig von der richtigen Wahl der Belichtungszeit, der Lichtverhältnisse und der optischen Konfiguration. Ohne umfangreiches Know-how zur Bildgebung kann es schnell zu Bewegungsunschärfen, zu dunklen Bildbereichen oder zu unvollständiger Abtastung kommen, was die Qualität der Messdaten erheblich beeinträchtigt.

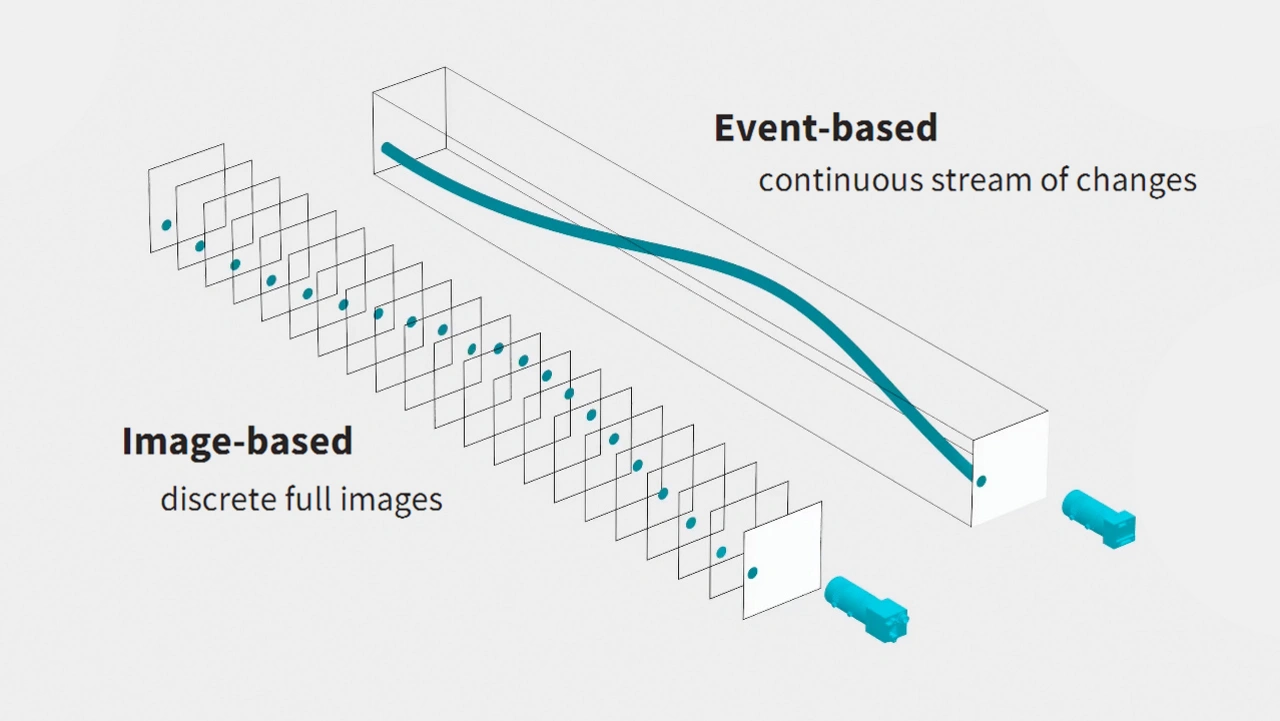

Eine neue Technologie verspricht hier Abhilfe: Event-basierte Kameras erfassen nicht kontinuierlich komplette Bilder, sondern registrieren ausschließlich Veränderungen im Sichtfeld – mit mikrosekundengenauer Präzision. Diese neuromorphe Sensortechnologie reduziert den Datenstrom drastisch und ermöglicht zugleich eine hochdynamische Analyse von Bewegungen. Besonders spannend wird es, wenn mehrere dieser Sensoren kombiniert werden: So lassen sich erstmals auch komplexe 3D-Strömungsanalysen realisieren – kostengünstig, skalierbar und mit bisher unerreichter Effizienz. Eine echte »Enabling Technology«, die neue Türen für Forschungseinrichtungen und industrielle Anwendungen öffnet.

Mit mehreren Blickwinkeln in die dritte Dimension

Strömungsdiagnostik lebt von der Fähigkeit, Bewegungen präzise zu erfassen – idealerweise nicht nur in zwei, sondern in drei Dimensionen. Event-basierte Kameras bieten hier einen völlig neuen Ansatz. Im Gegensatz zu konventionellen Bildsensoren erfassen sie ausschließlich Kontraständerungen im Sichtfeld – und das mit Ansprechzeiten im Sub-Millisekundenbereich. Die daraus resultierende Datenmenge ist nicht nur deutlich geringer, sondern auch hochgradig relevant. Kombiniert mit ihrer hohen Lichtempfindlichkeit und kompakten Bauform eröffnen sich neue Einsatzmöglichkeiten, die bislang nur mit deutlich teureren High-Speed-Systemen realisierbar waren.

Besonders spannend wird es, wenn mehrere Event-basierte Kameras miteinander kombiniert werden. Denn erst durch unterschiedliche Blickrichtungen lassen sich Partikel im Raum eindeutig identifizieren und ihre Bewegung dreidimensional rekonstruieren. Anwendungen wie die etablierte Particle Image Velocimetry (PIV) oder die Visualisierung komplexer Verdichtungsstoß-Konfigurationen – etwa zwischen Triebwerksschaufeln – profitieren enorm von dieser Technologie. Der reduzierte Datenstrom ermöglicht sogar eine Echtzeitauswertung, wodurch sich neue Konzepte zur aktiven Strömungsbeeinflussung auf Basis bildgebender Messtechnik realisieren lassen.

Von Events zu 3D-Daten

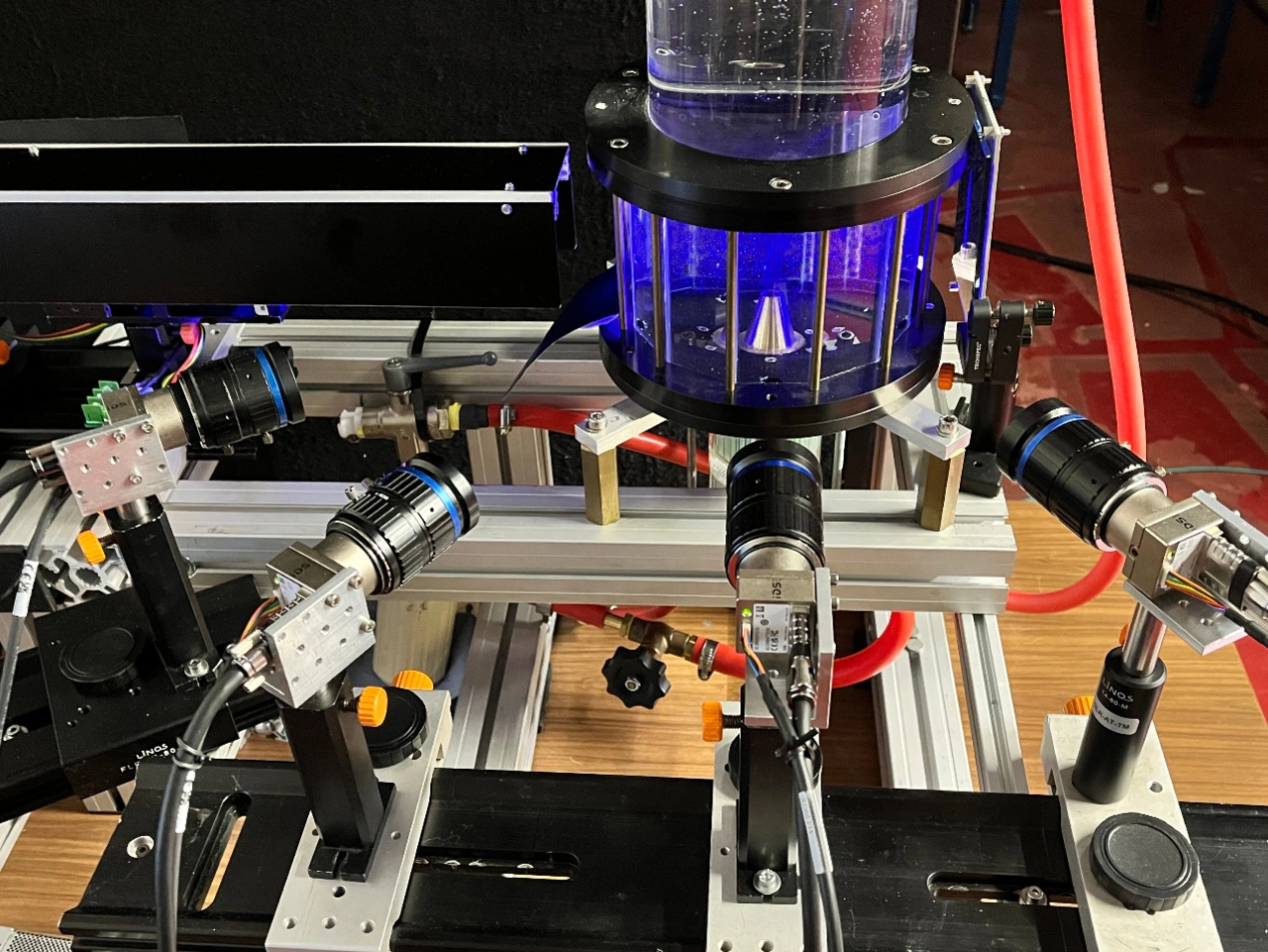

Um die Bewegung einzelner Partikel in einem Strömungsfeld dreidimensional zu erfassen, reicht eine einzelne Kamera nicht aus. Erst durch die Kombination mehrerer Perspektiven – typischerweise drei bis vier Kameras – lassen sich die Partikel-Positionen im Raum eindeutig bestimmen. Die Kameras werden dazu in photogrammetrischer Anordnung platziert, damit sie das gleiche Volumenobjekt aus unterschiedlichen Perspektiven mit leicht überlappenden Bildbereichen erfassen. Aus den korrespondierenden Bildpunkten und den bekannten Kamerapositionen können die 3D-Position der Partikel durch Triangulation im Raum berechnet werden. Je mehr Blickwinkel zur Verfügung stehen, desto präziser und robuster wird die Rekonstruktion der Partikelbahnen.

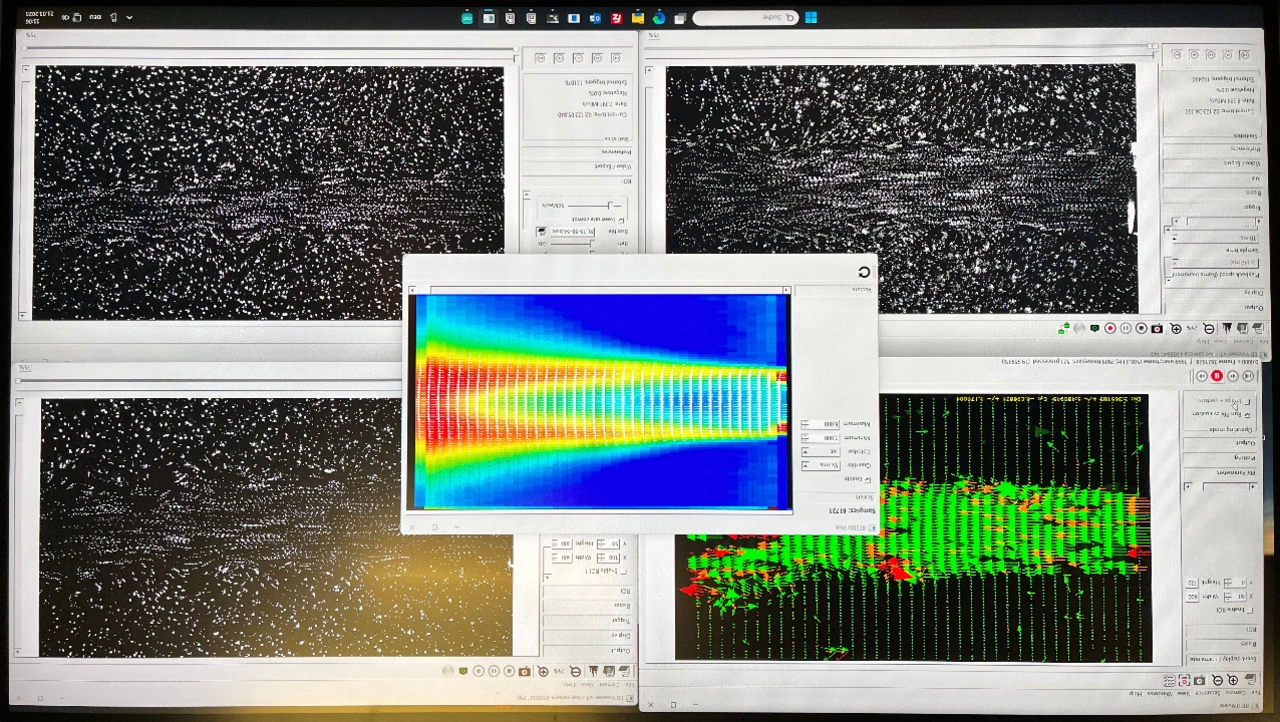

Damit sich die Daten aus den Kameras später korrekt zusammenführen lassen, ist eine exakte Synchronisation entscheidend. Die vier zum Einsatz kommenden eventbasierten Industriekameras von IDS Imaging Development Systems bieten hierfür zwei besonders hilfreiche Schnittstellen:

• Trigger-Input: Er ermöglicht die Platzierung eines eindeutigen Zeitstempels in allen Datenströmen, sodass die Events später exakt einander zugeordnet werden können.

• Hardware-Inhibit (TDRSTN): Diese Funktion ermöglicht es, alle Kameras simultan zu starten, selbst wenn sie an unterschiedlichen Rechnern betrieben werden.

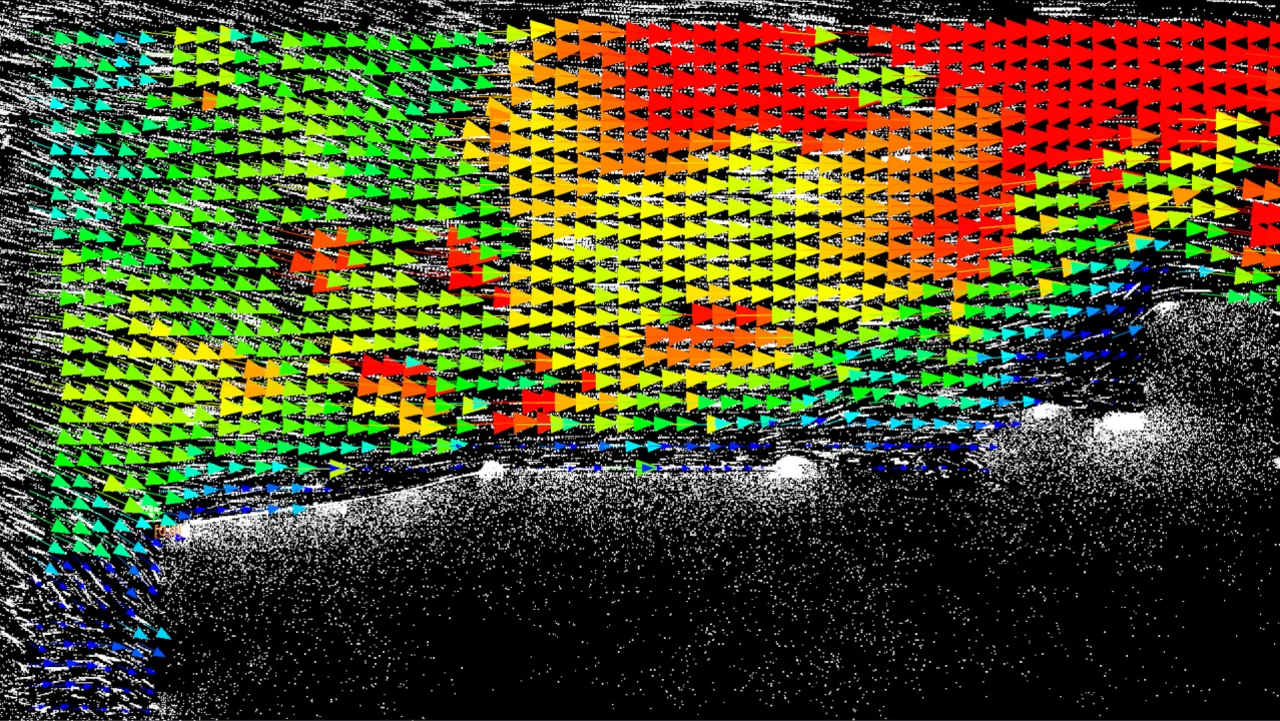

Nach der Datenerfassung beginnt die eigentliche Herausforderung: Die Events der einzelnen Kameras müssen zunächst geometrisch zueinander registriert werden (Kamerakalibrierung). Anschließend erfolgt die Lokalisierung der Partikel im Raum, entweder direkt aus den synchronisierten Events oder über ein zweistufiges Verfahren, bei dem die Partikel zunächst in den Einzelansichten getrackt und anschließend ihre Bewegungspfade rekonstruiert werden. Dabei werden die Positionen und Zeitstempel einzelner Pixel-Ereignisse über einen definierten Zeitraum hinweg akkumuliert, also zeitlich und räumlich zusammengeführt. Das Ergebnis ist eine Art »Bewegungsspur« im Raum, die zeigt, wie sich Partikel innerhalb eines Volumens über die Zeit hinwegbewegen.

Diese Form der Visualisierung ist besonders hilfreich, um komplexe Strömungsverläufe zu verstehen: Man erkennt, ob sich Partikel in Bahnen bewegen, ob Turbulenzen auftreten oder wie sich Stoßwellen ausbreiten. Auch Rückströmungen, Wirbelbildungen oder lokale Geschwindigkeitsänderungen lassen sich auf diese Weise sichtbar machen. Solche qualitativen Darstellungen sind nicht nur für die Forschung und Lehre von großem Wert, sondern auch für die Entwicklung und Optimierung technischer Systeme, etwa in der Luft- und Raumfahrt, der Strömungsmechanik oder der Mikrofluidik.

Vorteile, Grenzen und Herausforderungen

Wie leistungsfähig das System ist, hängt unter anderem von der zeitlichen und räumlichen Auflösung des Sensors ab. Der verwendete Sensor IMX636 von Sony bietet eine zeitliche Präzision von etwa 100 µs. Damit lassen sich bei einer Taktrate von 1 kHz bis zu 10.000 Partikel gleichzeitig verfolgen – bei 10 kHz sind es etwa 1000 Partikel. Diese Zahlen verdeutlichen das Potenzial, aber auch die Grenzen der Technologie: Eine höhere Auflösung würde zwar mehr Partikel ermöglichen, erhöht jedoch auch den Datenstrom und die Anforderungen an die Verarbeitung.

Event-Kameras bieten jedoch eine kostengünstige Alternative zu Highspeed-Systemen. Sie erzeugen weniger Daten, benötigen weniger Speicher und ermöglichen damit auch kleineren Forschungseinrichtungen den Zugang zu präzisen Bewegungsinformationen etwa für 3D-Strömungsanalysen. Durch ihre kompakte Bauweise und ihren geringen Energie- und Peripheriebedarf sind EVS-Kameras (Event-based Vision Sensor) ideal für mobile und autonome Systeme und eröffnen damit neue Einsatzmöglichkeiten.

Ein besonders innovativer Aspekt ist die Möglichkeit zur Echtzeitauswertung von Strömungsfeldern mit über 250 Feldern pro Sekunde. Dabei steht jedes »Feld« für eine vollständige Momentaufnahme der Partikelbewegung innerhalb eines definierten Volumens. Diese hohe zeitliche Dichte ermöglicht nicht nur eine präzise Analyse dynamischer Strömungen, sondern auch die Grundlage für adaptive Systeme, bei denen die Strömung aktiv beeinflusst werden kann – etwa durch Regelung von Klappen, Düsen oder anderen mechanischen Komponenten. Für Dr. Christian Willert, Leiter der Abteilung Triebwerksmesstechnik am Institut für Antriebstechnik des Deutschen Zentrums für Luft- und Raumfahrt e.V. (DLR), ist diese Echtzeitauswertung ein echter Meilenstein in der Weiterentwicklung bildbasierter Messtechnik.

Enabling statt Revolution

Event-basierte Vision steht nicht in Konkurrenz zu klassischen bildbasierten Systemen – sie ersetzt sie nicht, sondern ergänzt sie sinnvoll. Während Highspeed-Kameras nach wie vor dort ihre Stärken ausspielen, wo hohe räumliche Auflösung und vollständige Bildinformationen erforderlich sind, bietet die Event-Technologie eine neue, niedrigschwellige Möglichkeit, dynamische Prozesse effizient zu erfassen. Sie macht präzise Bewegungsanalysen zugänglich – auch für Labore und Forschungseinrichtungen mit begrenztem Budget oder begrenzter Infrastruktur.

Die Kameras der Serie »uEye EVS« von IDS bieten hierfür eine passende Kamera-Plattform: kompakt, energieeffizient und mit geringem Peripheriebedarf. Sie ermöglichen den Aufbau skalierbarer Mehrkamerasysteme ohne komplexe Hardware-Setups und arbeiten nahtlos mit dem Metavision SDK von Prophesee, dem Hersteller der neuartigen EVS-Sensortechnologie, zusammen. Das eröffnet neue Anwendungsfelder, etwa in der mobilen Strömungsdiagnostik, in Windkanalmodellen oder sogar auf Drohnen.

Dass Event-basierte Vision als »Enabling Technology« verstanden werden kann, zeigt auch das weitere Engagement von Prophesee im Embedded-Bereich: Mit einem speziell entwickelten Kit lassen sich Hochgeschwindigkeits-Ereignisdaten mit geringer Latenz direkt in einem Raspberry Pi 5 verarbeiten. Damit wird die Technologie auch für kompakte Embedded-Systeme nutzbar – etwa in der Robotik, der Industrieautomatisierung oder für autonome Flugplattformen. So wird aus einer spezialisierten Hochleistungstechnologie ein flexibles Werkzeug für eine Vielzahl neuer Anwendungen.

Die hier vorgestellte Methodik baut auf mehrjährigen Forschungsarbeiten zur Event-basierten Bildverarbeitung in der Strömungsdiagnostik auf, wie sie besonders in der Abteilung »Optische Triebwerksmesstechnik« am DLR-Institut für Antriebstechnik in Köln vorangetrieben wurden.