CES 2019

ZF mit sechsfacher KI-Rechenleistung und autonomem Rufbus

Fortsetzung des Artikels von Teil 1

e.GO People Mover kommt 2019 und erster Kunde angekündigt

Ein weiteres CES-Highlight von ZF ist der e.GO People Mover, der gemeinsam mit dem deutschen Start-up e.GO Mobile entwickelt und über das Joint Venture e.GO Moove vertrieben wird. Jetzt wird die Produktionskapazität in Deutschland mit dem Ziel ausgebaut, bereits 2019 fünfstellige Stückzahlen zu fertigen.

Das Konzept und die Verfügbarkeit des e.GO People Mover haben weltweit großes Interesse bei Mobilitätsanbietern und Städten geweckt – auf der CES gaben ZF und e.GO Moove auch ihren ersten Kunden bekannt: Transdev ist einer der führenden internationalen Mobilitätsanbieter mit täglich 11 Mio. Kunden. ZF wird mit Transdev zusammenarbeiten, um das Mobility-as-a-Service-Geschäft auf Basis des e.GO People Mover weiter auszubauen.

Yann Leriche, CEO von Transdev Nordamerika und Leiter Autonomous Transportation Systems, erklärte dazu: »Wir sind davon überzeugt, dass der öffentliche Nahverkehr das erste Segment sein wird, für das echte autonome Dienste für die Allgemeinheit entwickelt werden. Die Kooperation mit ZF und e.GO ist eine hervorragende Gelegenheit, unsere bestehenden Mobilitätslösungen mit neuen autonomen Fahrzeugen zu ergänzen, um unseren Kunden noch bessere Lösungen bieten zu können.«

Den erzeitigen Stand der Technik zeigt das Ride-Hailing-Innovationsfahrzeug, das auf der CES vorgestellt wurde: ein voll funktionsfähiger Technologieträger, der den kompletten Systemansatz von ZF für »Next Generation Mobility«-Lösungen abdeckt.

Ohne Lenkrad und Pedale vereint das Fahrzeug Sensortechnologie, Rechenleistung, Vernetzung, mechatronische Aktuatorik sowie Sicherheitssysteme unter einem Dach und liefert damit alle wesentlichen Elemente für ein »Autonomous Ride-Hailing«. Neben der ZF ProAI-Platform integriert der Versuchsträger, sechs Radar- und sechs Lidarsensoren sowie neun Kameras.

Damit senkt ZF die Einstiegsschwelle für neue Automobilkunden, die Robo-Taxis entwickeln wollen. »Unsere Systemlösungen für den Ride-Hailing-Van oder den e.GO People Mover zeigen bereits heute, wie wir die Mobilität der nächsten Generation gestalten«, erklärte Scheider. »Noch wichtiger ist, dass die in den Fahrzeugen eingesetzten Technologien die Automobilindustrie einen großen Schritt weiter auf dem Weg zu einersauberen, sicheren und erschwinglichen individuellen und öffentlichen Mobilität für alle bringt.«

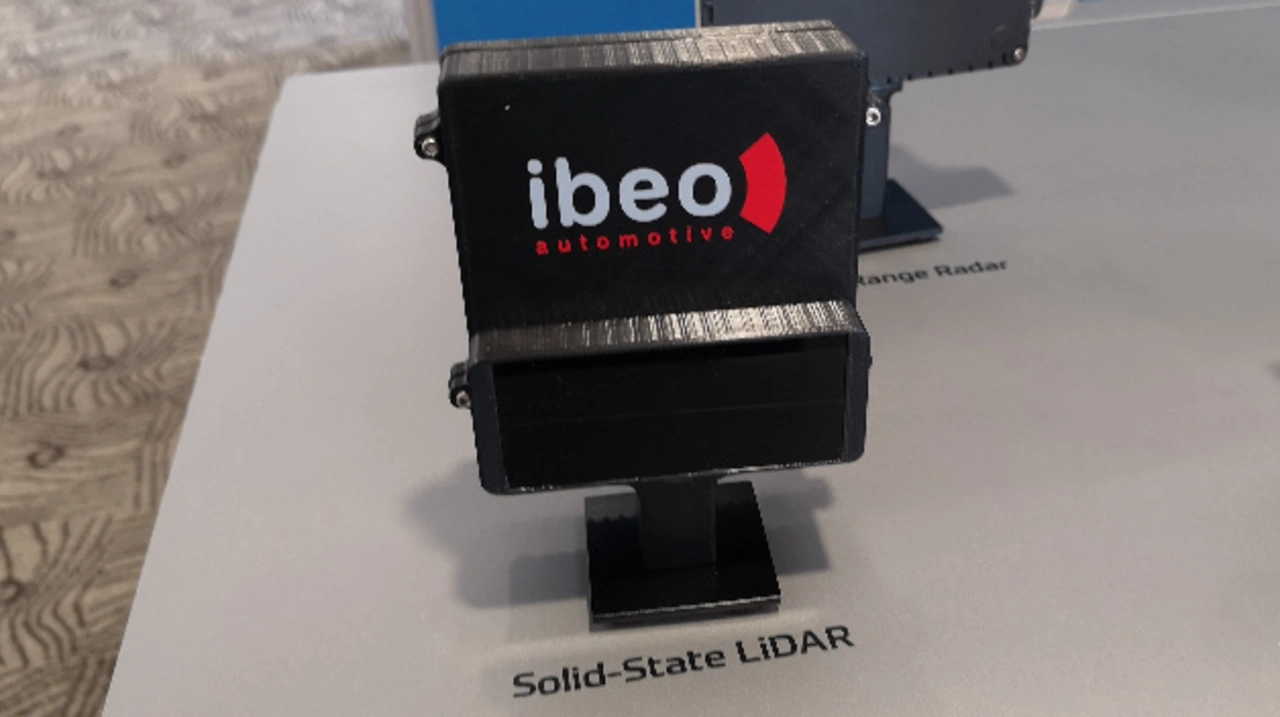

Von 3D-Full-Range-Radar bis zu Solid-State-Lidar

ZF hat einen eigenen Satz an Umfeld-Sensoren entwickelt, der die Automatisierung ermöglicht. »Als Systemarchitekten des autonomen Fahrens haben wir ein Sensorset entwickelt, das Autos mit allen notwendigen Sinnen ausstattet, um ihre Umgebung digital wahrnehmen zu können«, erklärte Torsten Gollewski, Leiter der ZF-Vorentwicklung und Geschäftsführer der Zukunft Ventures GmbH. »Es kann die Umfelddaten sehr genau und redundant in Echtzeit ermitteln und verarbeiten, was elementar ist, um sichere automatisierte Fahrfunktionen zu ermöglichen.«

Das ZF Sensorset umfasst Radar, Kameras, Lidar und akustische Sensoren der neuesten Generation, sowie – im Bereich der Software – Tools und Algorithmen für das Erkennen und Klassifizieren von Objekten sowie der Steuerung des Fahrzeugs, die vom Zentralrechner ProAI verwaltet werden. Die gesamte Architektur ist auf anspruchsvolle Automotive-Anforderungen ausgelegt, etwa auf extreme Temperaturen und Vibrationen. Die Sensorsysteme sind besonders wichtig, um kommende Sicherheitsanforderungen (z.B. nach NCAP) zu erfüllen.

Der an der Fahrzeugfront verbaute, hochauflösende Full-Range Radar von ZF bietet eine hervorragende Detektionsleistung in den vier Dimensionen Geschwindigkeit, Abstand, Seitenwinkel und Höhe. Dieses leistungsfähige 77-GHz-System wurde für fortschrittlichste ADAS-Anwendungen, für automatisiertes und autonomes Fahren entwickelt. Wie andere Radarsysteme sendet es elektromagnetische Wellen aus, um nach dem Echo-Prinzip den Abstand, Winkel und Geschwindigkeit von Objekten zu erfassen. Der hochauflösende Sensor kann zusätzlich noch genaue Höhenmessungen vornehmen, um ein dreidimensionales Bild der Umgebung zu erfassen. Das funktioniert auch bei schlechten Wetter-, Licht- und Sichtverhältnissen.

Lidar-Sensoren, die auf Lasern basieren, können zusammen mit Software-Tools zudem ein genaues 3D-Modell der Fahrzeugumgebung erstellen. Damit können sie helfen, Objekte und Freiraum sehr präzise zu erkennen – und damit auch komplexe Verkehrssituationen bei fast allen Lichtverhältnissen. Die neuen, hochauflösenden Solid-State Lidar-Sensoren, die ZF mit der Tochterfirma Ibeo entwickelt, können auch Fußgänger und kleine Hindernisse dreidimensional im Blick behalten. Das spielt für das hochautomatisierte Fahren ab Level 3 und höher eine wichtige Rolle. Der Verzicht auf bewegliche Komponenten (Solid-State) macht diese Innovation wesentlich robuster als bisherige Lösungen. Dank modularem Design mit wählbaren Sichtfeld-Optionen eignen sich diese LiDAR-Systeme für ein breites Anwendungsspektrum.

Die S-Cam4 von ZF steht für die Weiterentwicklung und den Ausbau des S-Cam-Portfolios. Mit 100-Grad-Sichtwinkel und einem 1,7-Megapixel-Bildsensor mit High Dynamic Range (HDR) erkennt die Kamera Fußgänger und Fahrradfahrer im urbanen Umfeld. Gleichzeitig kann sie mit Längs- und Quersteuerungsalgorithmen für die adaptive Geschwindigkeitsregelung (ACC), das automatische Notbremsen (AEB), den Spurhalteassistenten (LKA) sowie weiteren Funktionen kombiniert werden.

Darüber hinaus tragen Remote Camera Heads, die in sehr kleinen Gehäusen Platz finden, dazu bei, die gesamte unmittelbare Umgebung um ein Fahrzeug herum zu erfassen und per Video an den Fahrer zu streamen, oder die vorhandenen Objekte zu kategorisieren. Bis zu zwölf Kameras können miteinander kombiniert werden und lassen so ein 360-Grad-Abbild des Fahrzeugumfeldes entstehen. Bei jeder Remote-Kamera lässt sich eine Sensorauflösung zwischen 1,2 und 8 Megapixel sowie ein Sichtfeld zwischen 28 und 195 Grad wählen. Damit lässt sich ein Multi-Kamera-System an die spezifischen Anforderungen des Kunden anpassen.

Mit dem hochautomatisierten Fahren werden sich die Bewegungsspielräume der Insassen im Fahrzeuginnenraum erweitern. Eine 3D-Innenraumkamera von ZF kann dabei neue Komfort- und Sicherheitsvorteile bieten. Als Teil des ZF Interior Observation System (IOS) ermöglicht sie, Echtzeit-Informationen über Größe, Position und Haltung der Passagiere zu sammeln. Das trägt dazu bei, unterschiedliche Sicherheitskomponenten des Fahrzeugs im Notfall so einzustellen, dass Folgen eines Aufpralls möglichst abgemildert werden.

Fahrerüberwachungssysteme werden auch bei Übergabeszenarien zwischen Mensch und dem Autopiloten eine sehr wichtige Rolle spielen: mit dem IOS lässt sich so auch feststellen, ob der Fahrer die Hände am Lenkrad hat, ob er das Fahrzeug aktiv steuert und ob sein Blick auf die Straße gerichtet ist.

Per Sound.AI hilft ZF dabei, Autos zusätzlich das Hören zu ermöglichen: Unter anderem erkennt dieses System anhand der Signale eines Martinshorns, aus welcher Richtung sich Einsatzfahrzeuge nähern (»siren detection«). Das System kann dem Fahrer auch wichtige Informationen über das Display liefern – samt Handlungsempfehlungen wie »rechts heranfahren« oder »Rettungsgasse bilden«. Vollautomatisierte Fahrzeuge ab Level 4 können diese Manöver selbst übernehmen.

- ZF mit sechsfacher KI-Rechenleistung und autonomem Rufbus

- e.GO People Mover kommt 2019 und erster Kunde angekündigt