Intelligente Szenarienerkennung

Verkehrssituationen erlernen

Fortsetzung des Artikels von Teil 1

Sensor-Überwachung im Testfeld

Das schnelle Erkennen von Fehlverhalten neuer Systeme kann mithilfe intelligenter Sensor-Überwachung im Testfeld optimiert werden – gerade bei neuen Systemen, die unerwartete Verhaltensweisen aufzeigen, vom zu- vor erkannten Standardverhalten abweichen und besondere Beachtung erfordern.

Eine derartige Überwachung der Sensoren und die automatische Erfassung von Szenarien reichern die aufgenommenen Daten mit zusätzlichen Meta-Informationen an. Das kann die Validierung neuer Systeme erheblich vereinfachen, indem eine Fokussierung auf das Wesentliche effektiv unterstützt wird.

Künstliche Intelligenz zur Optimierung

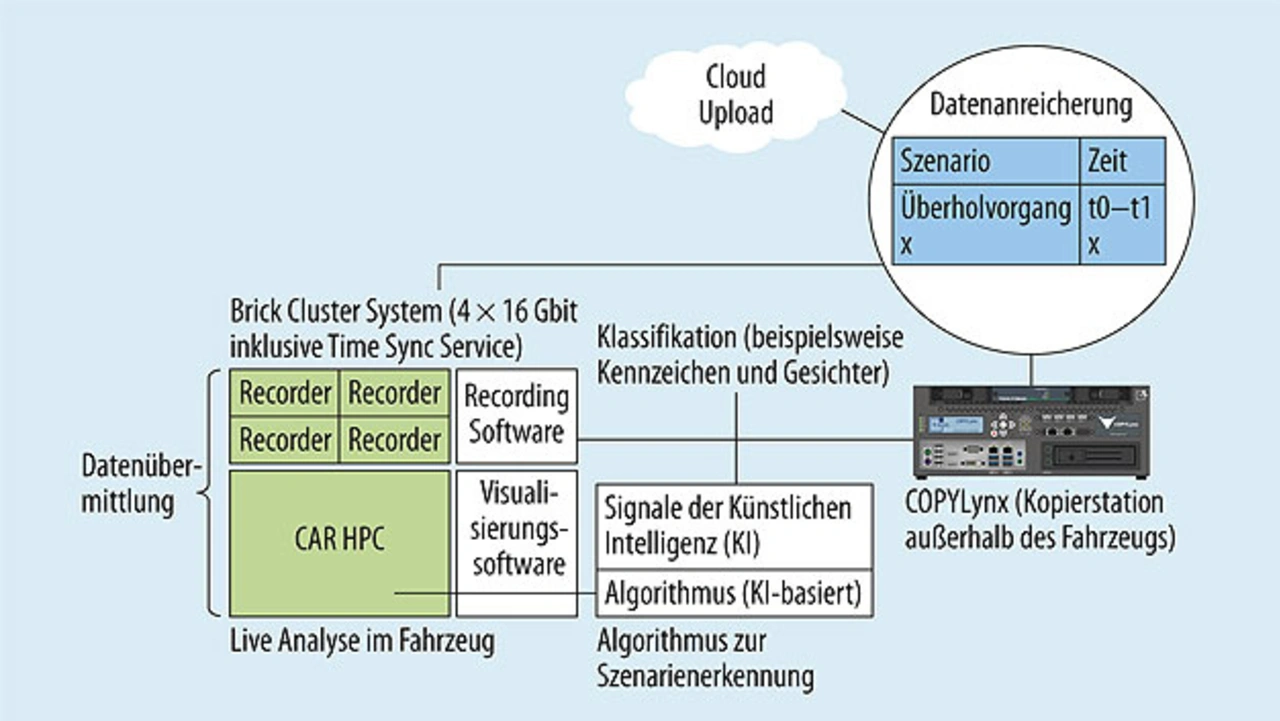

Künstliche Intelligenz kann dabei helfen, die Umweltwahrnehmung und -interpretation von Sensoren zu verbessern. Im Kofferraum von Testfahrzeugen integrierte Recording-Systeme nehmen über die fahrzeugseitigen Sensoren zahlreiche Daten auf (Bild 2).

Die Informationen müssen anschließend zeitsynchron verarbeitet werden, um die Fahrzeugumgebung realitätsgetreu zu interpretieren und entsprechende Szenarien richtig zuzuordnen. Adaptive Lernalgorithmen, die parallel das Zusammenspiel der Sensorik und erkannte Objekte im Kamerabild überwachen, können zudem überprüfen, ob Testfahrzeuge beziehungsweise deren Sensoren korrekt auf ihre Umwelt reagieren. So können beispielsweise Abweichungen von zuvor erlernten Standardverhalten extra protokolliert oder Gesamtanforderungen wie eine stabile Lage des Fahrzeugs gesondert überwacht werden.

Damit eine KI-basierte Software die vielen Bilder und Daten richtig interpretiert, muss vorab ein Training stattfinden, das sich in sich abwechselnde Lern- und Testphasen gliedert.

Lernphase

In der Lernphase werden die Parameter so adaptiert, dass sie in der Testphase die gewünschten Objekte erkennen oder Situationen korrekt zuordnen. Ähnlich wie bei einer Internetsuchmaschine ist für die Realisierung des autonomen Fahrens eine große Menge an realen Daten erforderlich, die das breite Spektrum auftretender Situationen möglichst gut abdecken, um ein repräsentatives Training durchzuführen (Bild 3).

Testphase

In der Testphase werden nun für das System noch unbekannte Daten zur Überprüfung eingespielt. Das geschieht sowohl im Labor zur ersten Bewertung der Robustheit und Praxistauglichkeit, als auch auf Testfahrten mit Live-Informationen. Die Testphase zeigt nun auf, wie gut die Software wirklich gelernt hat und ob auch neue Daten richtig interpretiert werden.

Entwicklung autonomer Fahrzeuge auf KI-Basis

In einem Kraftfahrzeug fließen mittlerweile eine Vielzahl an Sensorinformationen zusammen. Darunter befinden sich einfache Daten von Beschleunigungssensoren aber auch zahlreiche Kamerabilder – eine einfache 800 x 600-p-RGB-Kamera mit 24 Hz liefert bereits einen unzusammenhängenden Informationsgehalt von mehr als 250 Mio. bit/s. Jeder Sensor erfasst dabei die Daten für unterschiedliche Verkehrssituationen: Sei es das Beschleunigen bei einem Überholmanöver oder das Abbremsen vor einer roten Ampel. Die klassische Software-Entwicklung stößt hier an ihre Grenzen, da eine fast unendliche Anzahl an Verkehrssituationen es nahezu unmöglich machen, die Szenarien eindeutig zu beschreiben beziehungsweise passende Wenn-Dann-Verhaltensweisen zu definieren.

Die zur Verarbeitung eingesetzten Verfahren auf Basis künstlicher Intelligenz verfolgen einen anderen Ansatz. Anstatt für jede einzelne Situation einen passenden Algorithmus fest vorzugeben, erlernt der Computer die Vorgehensweisen selbst, indem er sie aus einer großen Menge an Beispieldaten adaptiert und den Input bestmöglich auf den Output abbildet (Bild 4).

Die hierzu eingesetzten neuronalen Netze sind dabei den Nervenzellenvernetzungen im menschlichen Gehirn nachempfunden. Das bietet den Vorteil, auch komplexe Situationen abbilden und sogar auf neue Situationen reagieren zu können – was bei einer fast unendlichen Anzahl möglicher Verkehrssituationen auch erforderlich ist.

Bei allen Vorteilen bringt das sogenannte »Deep Learning« jedoch auch einen großen Nachteil mit sich: Aufgrund der Flexibilität der Verfahren, um hoch komplexe Situationen verarbeiten zu können, ist deren Nachvollziehbarkeit schwierig. Das bringt neue Herausforderungen bei der Validierung solcher Systeme, beispielsweise hinsichtlich der Einhaltung der Norm ISO 26262, mit sich.

Klassische Systeme, die Gefahren zumindest bei einfachen Situationen nachvollziehbar abwenden können, werden daher im Auto auch künftig notwendig sein. So besitzt auch der Mensch Reaktionssysteme/Reflexe, um bei Schmerz direkt die Hand wegzuziehen – ohne darüber nachdenken zu müssen.

Neue Methoden aus dem Machine Learning erweitern zusätzlich die Möglichkeit, auch komplexe Verkehrssituationen sinnvoll zu verarbeiten. Wichtig ist dabei, dass derartige Systeme auch ihre eigene Unsicherheit einschätzen lernen. Wann ist demnach eine Situation noch so neu und unbekannt, dass eine automatische Reaktion zu unvorhersehbar wäre? Unabhängig davon, wird die Bedeutung intelligenter Systeme im Kraftfahrzeug weiter zunehmen.

Die Autoren

Christine Schäfer

studierte Medientechnik in Deggendorf und fing anschließend 2015 bei b-plus im Marketing an, mit dem Schwerpunkt Technische Kommunikation. 2019 wechselte Schäfer zum Technischen Direktor und unterstützt ihn aktuell als CTO-Assistentin.

Klaus Zaeper

studierte Informatik mit Schwerpunkt Bioinformatik und KI an der Uni Marburg. Zaeper besitzt langjährige Erfahrung in der Entwicklung medizinischer Software und der Bildverarbeitung in der Dentalbranche und Waferproduktion. Er ist Mitglied im OpenSecenario-Projekt der ASAM und arbeitet aktuell als Software-Entwickler im Bereich Machine Learning und Image Processing bei b-plus.

- Verkehrssituationen erlernen

- Sensor-Überwachung im Testfeld