Tools für die Umsetzung von KI

Machine Learning kann so zum Mainstream werden

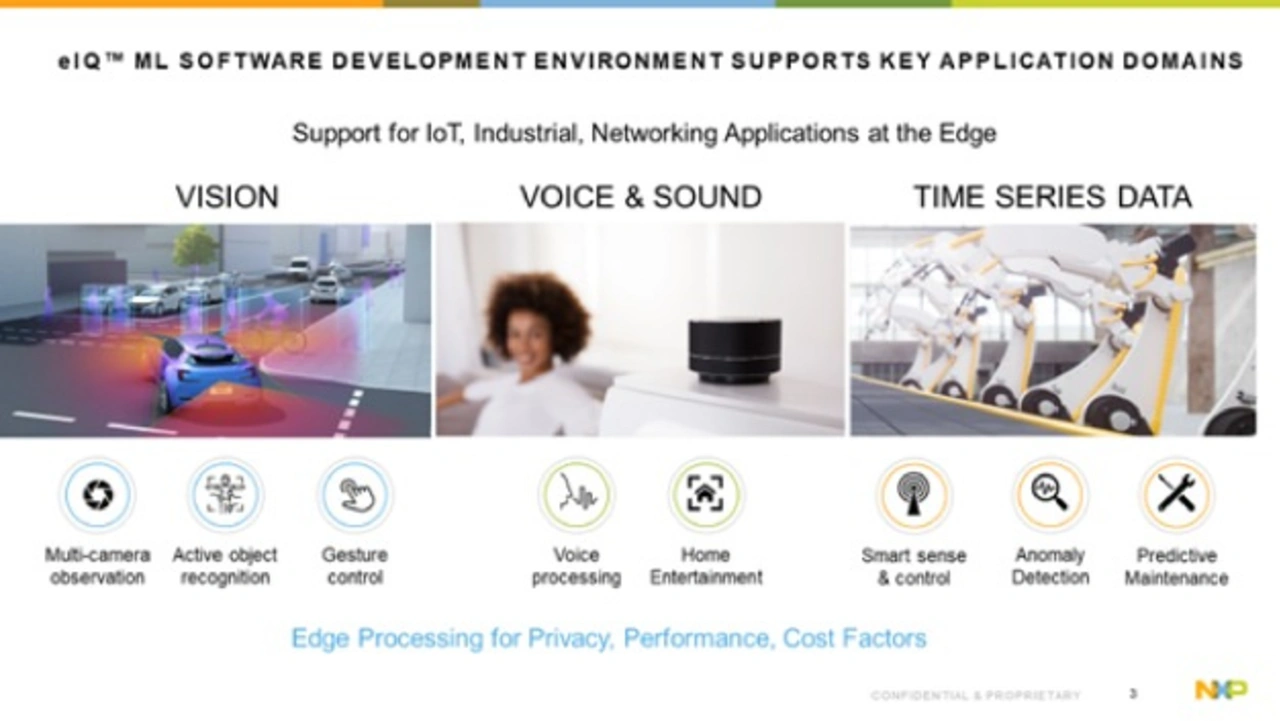

NXP Semiconductors bietet kosten-, leistungs- und energieoptimierte Recheneinheiten, mit denen ML-Algorithmen im Edge und damit die Vorteile einer verbesserten Sicherheit, eines höheren Datenschutzes und geringerer Latenzzeiten genutzt werden können - plus die erforderlichen Tools.

Die Entwicklung von ML- (ML: Machine Learning), DL-Algorithmen (DL: Deep Learning) und neuronalen Netzen ist traditionell die Domäne von Datenwissenschaftlern und KI-Experten. Dies ändert sich jedoch, da immer mehr ML-Tools und -Technologien zur Verfügung stehen, die einen Teil der Komplexität der Entwicklung von ML-Anwendungen beseitigen. Ein Beispiel dafür ist die ML-Entwicklungsumgebung eIQ (Edge Intelligence) von NXP. eIQ umfasst eine Reihe von Workflow-Tools, Inferenz-Engines, Neural Network-Compilern (NN-Compilern), optimierten Bibliotheken und Technologien, die die ML-Entwicklung für Anwender aller Qualifikationsstufen vereinfachen und beschleunigen – angefangen bei Embedded-Entwicklern, die ihre ersten Deep-Learning-Projekte in Angriff nehmen, bis hin zu Experten, die sich auf fortschrittliche Objekterkennung, Klassifizierung, Anomalieerkennung oder Spracherkennungslösungen konzentrieren.

Die eIQ ML-Software, 2018 eingeführt, wurde ständig weiterentwickelt, um Anwendungen auf Systemebene und ML-Algorithmen für die i.MX-Serie von NXP zu unterstützen – angefangen bei den stromsparenden i.MX RT Crossover-Mikrocontrollern bis hin zu den Multicore-Prozessoren i.MX 8 und i.MX 8M, die auf Cortex-M- und Cortex-A-Kernen basieren.

Jobangebote+ passend zum Thema

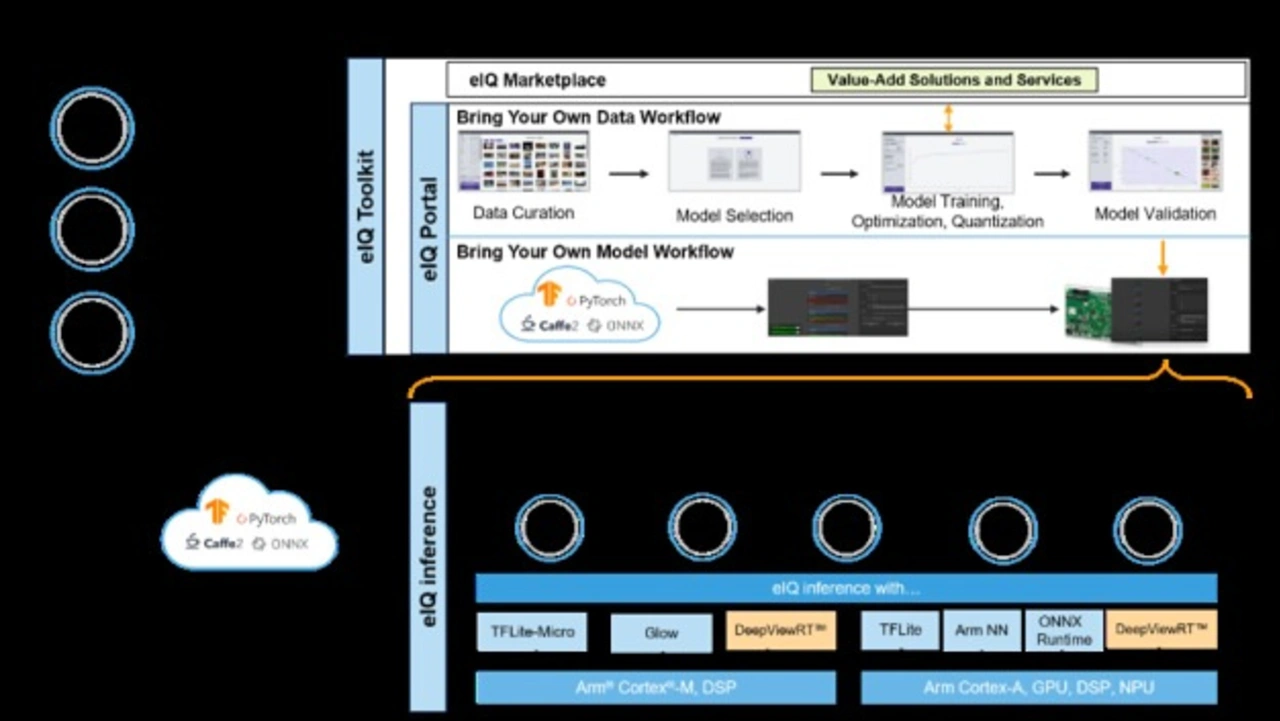

Um ML-Entwickler dabei zu unterstützen, noch produktiver und kompetenter mit den i.MX 8-Plattformen von NXP zu werden, haben wir unsere eIQ-Softwareumgebung erheblich erweitert. Dazu gehören neue eIQ-Toolkit-Workflow-Tools, die GUI-basierte eIQ-Portal-Entwicklungsumgebung und die DeepViewRT-Inferenz-Engine, die für i.MX- und i.MX RT-Bausteine optimiert ist.

Wie tragen diese leistungsstarken Ergänzungen der eIQ-Softwareumgebung dazu bei, die ML-Entwicklung zu straffen, die Produktivität zu steigern und den Entwicklern mehr Optionen und größere Flexibilität zu bieten.

eIQ ToolKit: »Damit kann jeder ML«

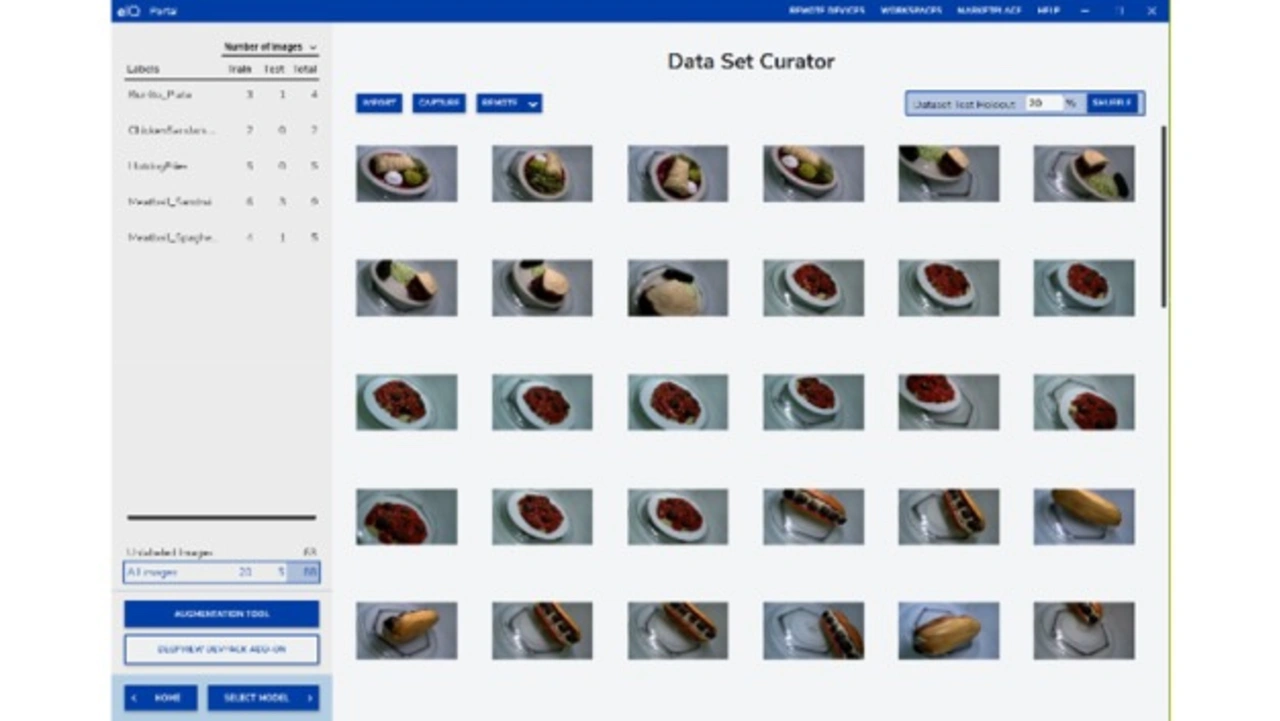

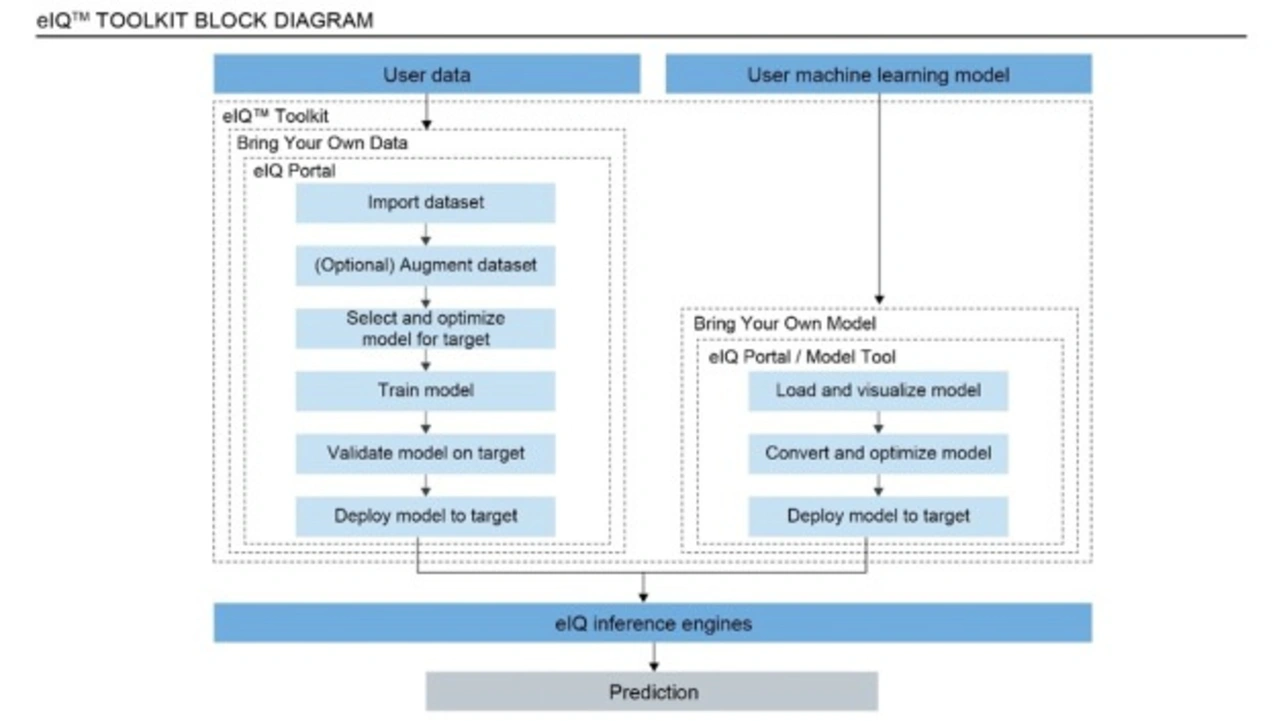

Angesichts der Komplexität von maschinellem Lernen, neuronalen Netzen und Deep-Learning-Anwendungen und den unterschiedlichen Bedürfnissen seitens der ML-Entwickler ist ein einfaches »Einheits-Tool« nicht die richtige Lösung. Besser ist es, wenn umfassende und flexible Toolkits verfügbar sind, die sich an die Fähigkeiten und Erfahrungen von ML-Entwicklern anpassen lassen. Deshalb hat NXP die eIQ ML-Entwicklungsumgebung um das leistungsstarke, aber einfach zu bedienende eIQ-Toolkit erweitert. Damit können Entwickler Datensätze und Modelle importieren und neuronale Netzwerkmodelle und ML-Workloads auf den Anwendungsprozessoren der i.MX 8M-Familie von NXP und dem i.MX RT Crossover MCU-Portfolio trainieren, beschneiden, quantisieren, validieren und einsetzen. Ganz gleich, ob es sich um einen Embedded-Entwickler handelt, der mit seinem ersten ML-Projekt beginnt, oder um einen erfahrenen Datenwissenschaftler oder KI-Experten, alle finden die richtigen Toolkit-Funktionen, die Ihrem Kenntnisstand entsprechen, so dass Sie Ihr ML-Projekt optimieren können.

Das eIQ-Toolkit bietet unkomplizierte Workflows und ML-Anwendungsbeispiele. Darüber hinaus steht mit dem Toolkit und dem eIQ-Portal auch eine GUI-basierte Entwicklungsoption zur Verfügung, die dem Entwickler die Möglichkeit bietet, Kommandozeilen-Tools zu verwenden. Wenn Entwickler Entwicklungsansätze »von der Stange« nutzen möchten, oder ganz im Gegensatz, professionelle Dienstleistungen und Support von NXP oder einem unserer vertrauenswürdigen Partner benötigen, in allen Fällen bietet das Toolkit einen einfachen Zugang zu einer wachsenden Liste von Optionen im eIQ-Marketplace von NXP, dazu zählen auch Unternehmen wie Au-Zone Technologies.

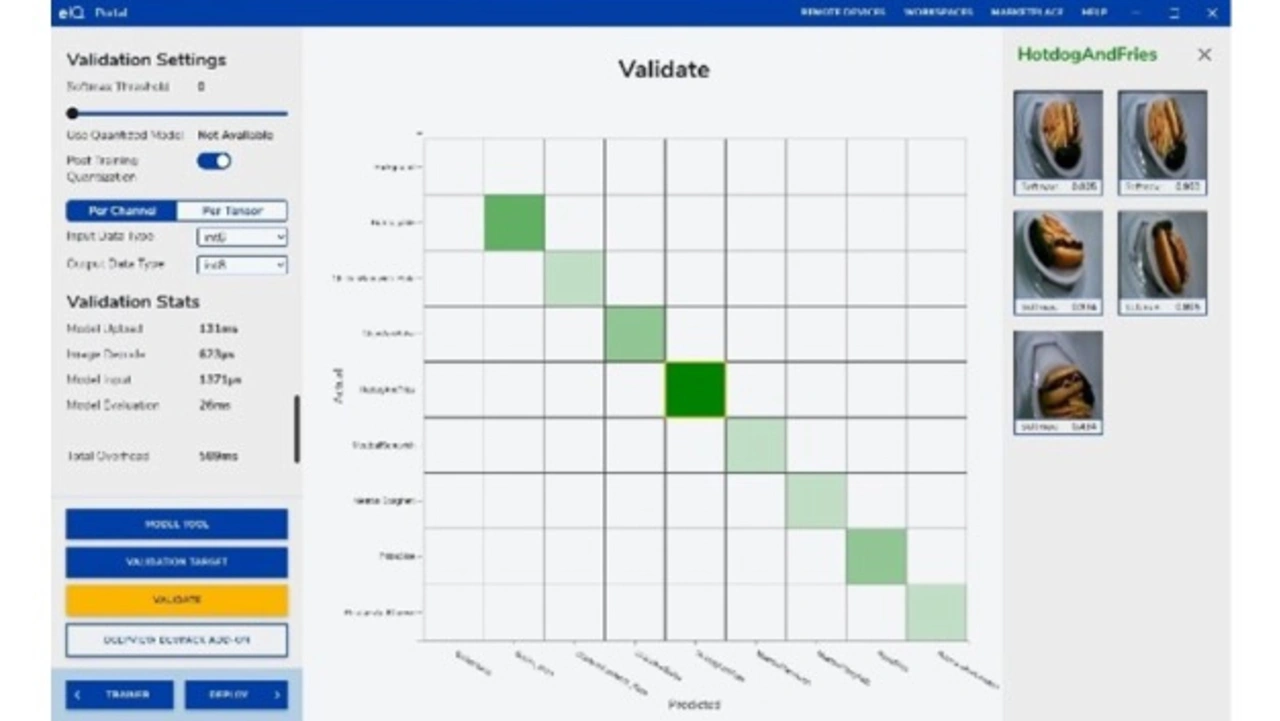

Mit dem eIQ Portal können Entwickler ML-Modelle einfach erstellen, optimieren, debuggen, konvertieren und exportieren. Sie können damit aber auch Datensätze und Modelle aus den ML-Frameworks TensorFlow, ONNX und PyTorch importieren. Darüber hinaus können sie ein Modell mit eigenen Daten mithilfe des »BYOD-Flows« (BYOD: Bring your own data) trainieren, ein vortrainiertes Modell aus einer Datenbank auswählen, oder ein vortrainiertes Modell mit dem »BYOM-Flow« (BYOM: Bring your own model) importieren. Dazu gehören zum Beispiel auch die Erkennungsmodelle von Au-Zone Technologies. Mit dem einfachen BYOM-Prozess können Entwickler ein trainiertes Modell mit öffentlichen oder privaten Cloud-basierten Tools erstellen und dann das Modell in das eIQ-Toolkit übertragen, um es auf der entsprechenden Silizium-optimierten Inferenzierungs-Engine auszuführen.

Auf der Ziel-Hardware unterstützen Grafikgestützte Profiling-Möglichkeiten die Entwickler mit Einblicken in die Laufzeit, um Systemparameter, Laufzeit-Performance, Speichernutzung und Architekturen für neuronale Netze auf i.MX-Bausteinen feinabzustimmen und zu optimieren.

Die neueste eIQ-Inferenzierungs-Engine

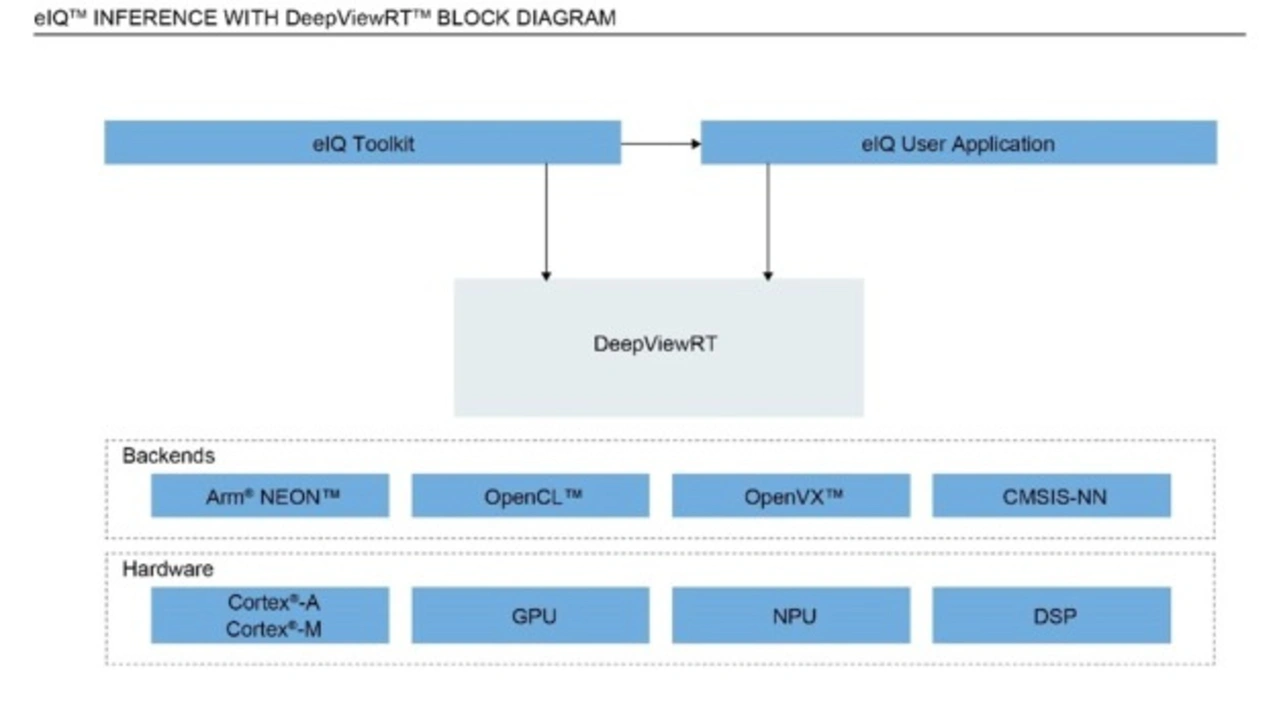

Im Mittelpunkt eines ML-Projekts steht die Inferenzierungs-Engine – die entscheidende Laufzeit-Komponente in ML-Anwendungen. Deshalb unterstützt NXP nicht nur Open-Source-, Community-basierte Inferenzierungs-Engines, die für die i.MX-Bausteine und MCUs optimiert wurden, einschließlich Glow, ONNS und TensorFlow Lite, sondern auch die DeepViewRT Inferenzierungs-Engine.

DeepViewRT wurde in Zusammenarbeit mit dem NXP-Partner Au-Zone Technologies entwickelt. Dabei handelt es sich um eine proprietäre Inferenzierungs-Engine, die eine stabile, langfristig verfügbare (vom Hersteller gewartet) Lösung darstellt, die das Angebot seitens der Open-Community ergänzt.

Die DeepViewRT-Inferenzierungs-Engine ist als Middleware im MCUXpresso-SDK von NXP und im Yocto-BSP Release für Linux OS-basierte Entwicklung verfügbar.

Zusammenfassung

Die eIQ ML-Entwicklungsumgebung mit allen grundlegenden Funktionen, einschließlich des eIQ-Toolkits, des eIQ-Portals und der eIQ-Inferenz mit DeepViewRT, wird ohne Lizenzgebühren bereitgestellt.

Die ML/AI-Training-Academy von NXP bietet Lernmodule zum Selbststudium zu verschiedenen Themen im Zusammenhang mit der ML-Entwicklung und »Best Practices« bei der Verwendung von eIQ-Tools mit den i.MX- und i.MX RT-Bausteinen von NXP. Die ML/AI Training Academy steht allen NXP-Kunden offen und kann mit einer wachsenden Sammlung von Schulungsmodulen aufwarten, die Entwicklern den Einstieg in ML-Anwendungen erleichtert.

Das eIQ-Toolkit, einschließlich eIQ-Portal, kann mit einem einzigen Klick unter eIQ-Toolkit heruntergeladen werden. Die eIQ ML-Software, einschließlich der DeepView RT Inferenzierungs-Engine für i.MX-Anwendungsprozessoren, wird von der aktuellen Yocto Linux-Version unterstützt. Die eIQ ML-Software für i.MX RT-Crossover-MCUs ist vollständig in die MCUXpresso-SDK-Version von NXP integriert.

Autor:

Ali Osman Örs ist Director, AI ML Strategy and Technologies, Edge Processing, NXP Semiconductors