IEDM 2018

Zukünftige Rechner-Architekturen für Künstliche Intelligenz

Heutige Systeme setzen bei der Verarbeitung von Algorithmen in KI-Anwendungen typischerweise auf Heterogenes Computing. Für die Zukunft sieht Jeff Welser von IBM allerdings neue Ansätze, wie vom Gehirn-inspiriertes Approximate Computing, analoge KI-Cores und schließlich Quanten-Computing.

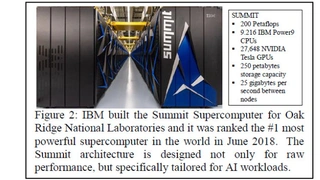

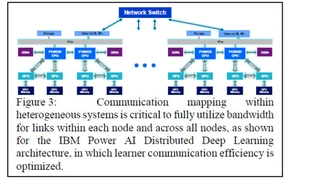

Den amerikanischen Part der IEDM-Keynotes übernahm Jeff Welser von IBM Research in Almaden und er gab einen Ausblick, wie zukünftige Rechner-Architekturen für Künstliche Intelligenz aussehen könnten. Hardware hat seiner Ansicht nach bisher eine unterstützende Rolle im Reifeprozess und bei der Verbreitung von »Narrow AI« (Single-Task, Single-Domain) eingenommen, wird aber künftig eine Schlüsselrolle bei der Innovation und Einführung von »Broad AI« (Multi-Task, Multi-Domain) spielen. Die gleichzeitige Evolution von Broad AI mit speziell entwickelter Hardware wird die traditionelle Balance zwischen Cloud und Edge verschieben, zwischen strukturierten und unstrukturierten Daten sowie Training und Inferenz (Schlussfolgerungen). Heterogene Systemarchitekturen werden bereits ausgerollt, wo unterschiedliche Rechenressourcen, einschließlich CPUs mit hoher Bandbreite, spezialisierte KI-Beschleuniger und Hochleistungsnetzwerke in jedem Knoten eingesetzt werden, um signifikante Verbesserungen bei der Rechenleistung zu erzielen. Mit Blick auf die Zukunft stellt Welser eine Roadmap von spezialisierten Technologien zur Beschleunigung von KI vor: Angefangen bei heterogenen digitalen Von-Neumann-Maschinen über Beschleunigerarchitekturen mit reduzierter Genauigkeit (Approximate Computing), analoge KI-Cores bis hin zu Quanten-Computing für KI.

Jobangebote+ passend zum Thema

Was ist Narrow AI, Broad AI und General AI?

Narrow AI, gekennzeichnet durch ihre Leistung in einer einzigen Domäne mit menschlicher oder supramenschlicher Genauigkeit und einer hohen Geschwindigkeit bei bestimmten Tasks, findet weitgehend Verbreitung in Anwendungen von der Gesichtserkennung bis zur natürlichen Sprachübersetzung. Wir befinden uns erst am Anfang der Broad AI, die Multitasking, Multi-Domain, Multi-Modell sowie verteilte und erklärbare KI umfasst. Transferlernen und Schlussfolgerungen sind von zentraler Bedeutung für die Erweiterung der KI auf kleine Datensätze. Die Reduzierung des Zeitbedarfs und der Leistungsaufnahme von KI-Computing ist von grundlegender Bedeutung für die Entwicklung und Einführung von Broad-AI-Systemen und wird ihre Entwicklung in Richtung von »General AI« (Cross-Domain Learning and Reasoning) ermöglichen. Ganz allgemein lassen sich die Methoden Maschinelles Lernen und Tiefgehendes Lernen (Machine / Deep Learning — ML / DL) in zwei Betriebszustände aufteilen: Training und Inferenz. Die Trainingsphase ist zunächst ein Optimierungsproblem in einem multi-dimensionalen Parameter-Raum, bei dem ein Modell gebaut wird, das eine weitere Verallgemeinerung im Inferenz-Prozess zulässt. Beim Tiefgehenden Lernen besteht ein Modell typischerweise aus einem Multilayer-Netzwerk mit vielen freien Parametern (Gewichten), dessen Werte während des Trainingsprozesses gesetzt werden. Anschließend muss das trainierte Modell im Inferenz-Modus mit Daten aus der Realwelt zurechtkommen. In vielen Anwendungen erfordert der Inferenz-Schritt ein festes trainiertes Modell aus Gründen der Konsistenz, Reproduzierbarkeit, Zuverlässigkeit, Leistungsfähigkeit oder Gesetzeskonformität.

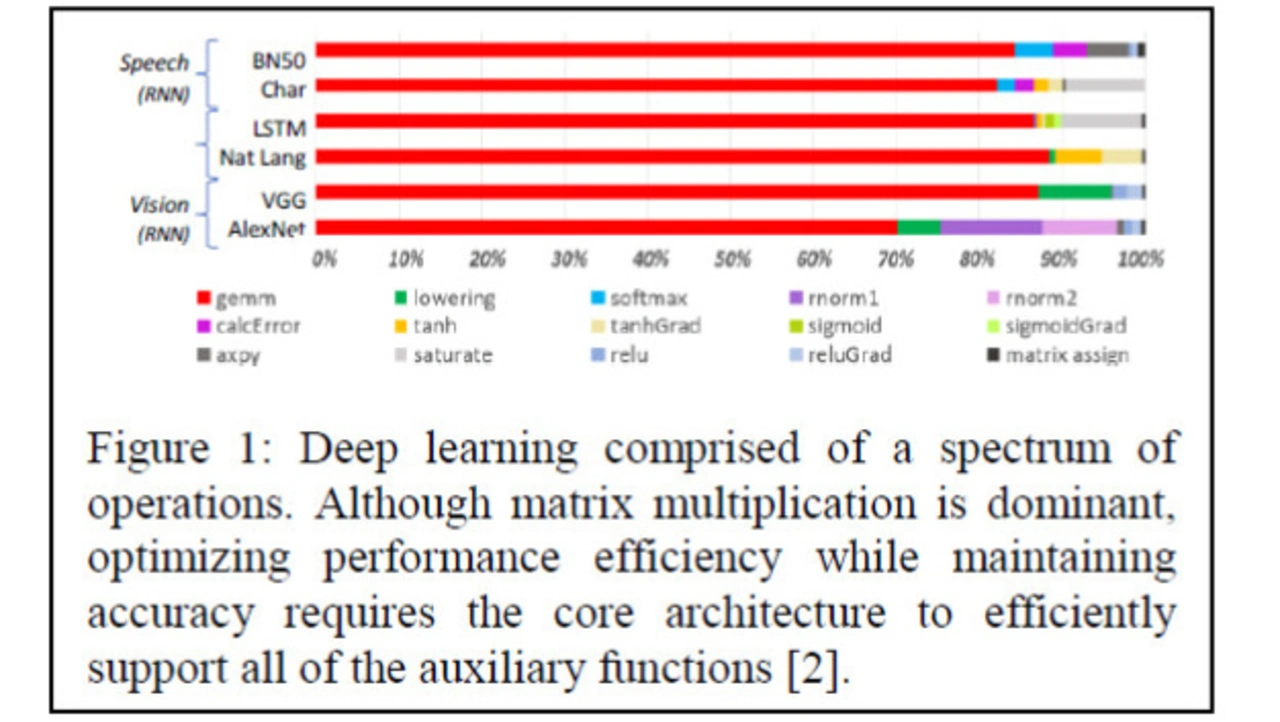

Um über zukünftige KI-Hardware zu sprechen, lohnt es sich, KI-Algorithmen zu analysieren. In tiefen neuronalen Netzen sind Matrix-Multiplikationen der Kern von Deep-Learning-Netzen. In vollständig verdrahteten Netzen reisen die Daten durch das Netzwerk in Form von Vektor-Matrix-Multiplikationen. Um die Computer-Ressourcen dabei besser auszulasten, werden mehrere Datenpunkte zu Stapeln (mini-batch) zusammengefasst. In neuronalen Faltungs-Netzen (Convolutional Neural Networks — CNN) lässt sich die Eingangs-Faltungs-Operation als Matrix beschreiben und der erste Schritt ist dann eine Matrix-Matrix-Multiplikation. Für diese Aufgabe optimierte Systeme zu entwickeln erfordert eine Betrachtung des Ende-zu-Ende-Systems, einschließlich der Transistorstrukturen, Hardware, Software und der Programmierung.

Zukünftige Rechner-Architekturen für Künstliche Intelligenz

- Zukünftige Rechner-Architekturen für Künstliche Intelligenz

- Heterogene KI-Systeme

- Analoge KI-Cores — jenseits digitalen Computings