IEDM 2018

Zukünftige Rechner-Architekturen für Künstliche Intelligenz

Fortsetzung des Artikels von Teil 2

Analoge KI-Cores — jenseits digitalen Computings

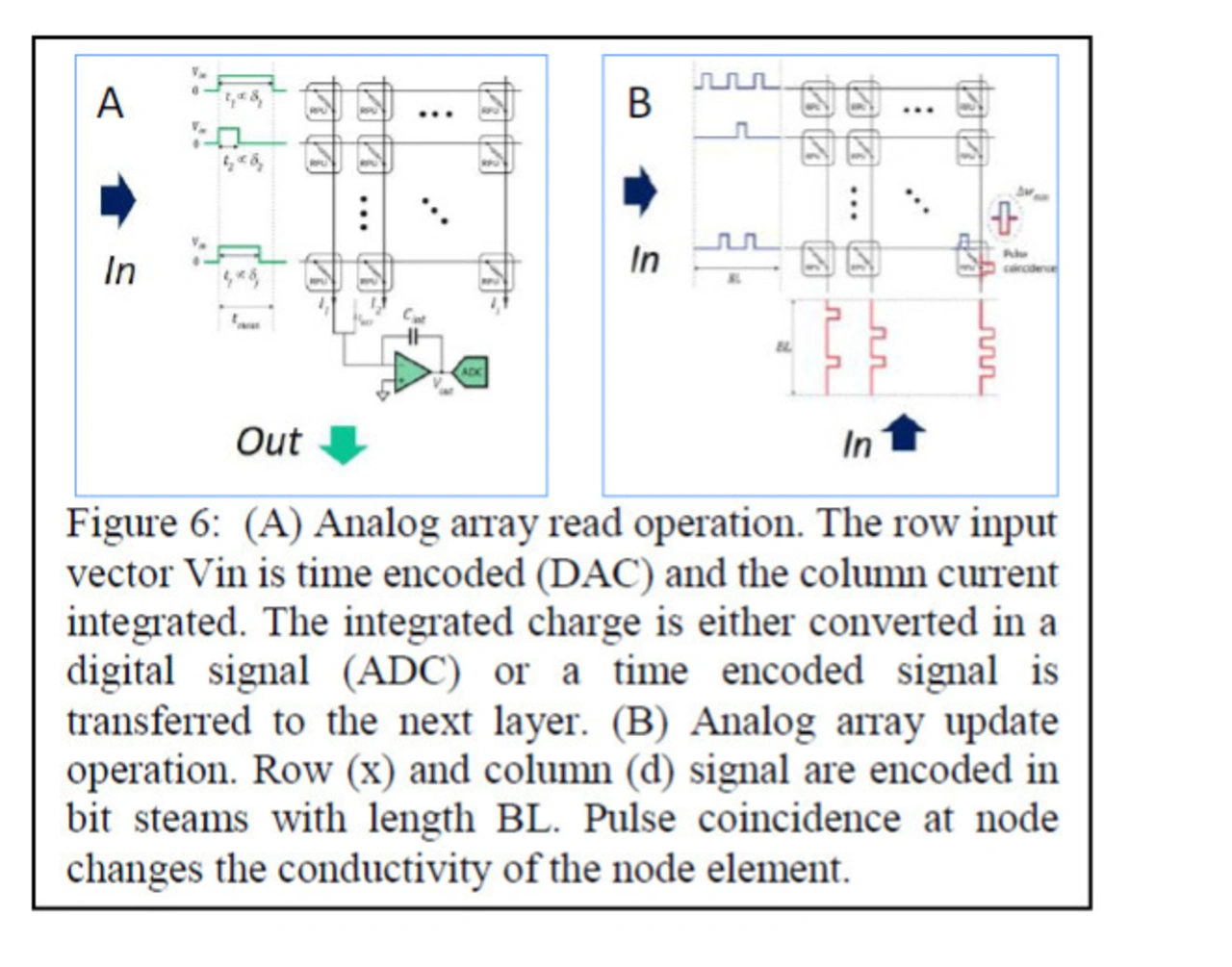

Selbst mit all diesen Verbesserungen im Wirkungsgrad kostet die Datenübertragung Zeit und Energie. Die Abbildung von mathematischen Operationen auf analoge Schaltelemente vermeidet den Flaschenhals bei der Datenübertragung zwischen Speicher und Prozessor. Analoge Beschleuniger verarbeiten die Daten direkt im Speicher (In Memory Computing). Die Toleranz von niedriger Genauigkeit in KI-Modellen eröffnet die Möglichkeit analogen Computings, die intrinsisch rauschanfällig sind. Wenn man Rauschen tolerieren kann, dann ist es möglich, Matrix-Operationen für Tiefgehendes Lernen in konstanten Zeitintervallen auf Arrays von analogen nichtflüchtigen Speichern auszuführen. Analoges Computing für DL bildet dabei die Gewichte der trainierten KI in den Speicherknoten ab. Bei IBM erforscht man derzeit gemischt digital-analoge wie rein analoge Schaltungsansätze auf Basis von Phasenwechselspeichermaterialien (PCM). Im gemischt digital-analogen Fall speichert ein nichtflüchtiges Speicher-Array die synaptischen Gewichte mit einer digitalen Verarbeitungseinheit und einer zusätzlichen Speichereinheit werden die akkumulierten Gewichte-Updates in hoher Genauigkeit abgelegt. Beim rein analogen Ansatz, der eine mit GPUs vergleichbare Genauigkeit bietet, lässt sich eine potenzielle Steigerung des Wirkungsgrads von zwei Größenordnungen beim Training eines vollständig verdrahteten Netzwerks gegenüber GPUs erzielen.

Parallel zu üblichen nichtflüchtigen Speichern entwickelt und evaluiert IBM auch ein Elektro-Chemisches synaptisches Element (ECRAM) als Baustein für KI-Computing. Für das ECRAM konnte ein symmetrisches analoges Verhalten bei Sub-Mikrometer-Strukturen und Sub-Mikrosekunden-Verzögerungen in einem dreipoligen Bauelement nachgewiesen werden, das auf einem Gated Ionenaustausch mit einem abstimmbaren Oxid-Kanal basiert.

Jobangebote+ passend zum Thema

Quanten-Computing für KI?

Quanten-Computing auf KI angewandt, verspricht Probleme zu lösen, die wir derzeit noch überhaupt nicht anpacken können, selbst mit leistungsfähigen heterogenen Systemen wie dem Summit Supercomputer. Die Stärke des Quantencomputings kommt von den qubits — Quantenbit, die einen exponentiellen Zustandsraum durch Überlagerung aufspannen, und einem Rechenprozess, bei dem Probleme durch Verschränkung und Interferenz von Quanteninformationen gelöst werden, um die richtige Antwort konstruktiv zu erhalten. IBMs Ansatz für das Quantencomputing basiert auf einer Reihe von Qubits, die aus supraleitenden Schaltungen konstruiert und miteinander verbunden sind, die einen universellen Gatesatz unterstützen, der alle logischen Operationen ermöglicht, ähnlich wie ein NAND-Gate zum Aufbau jeder herkömmlichen Logikschaltung verwendet werden kann. Da Quanteninformationen fragil sind, braucht man Fehlervermeidung oder Fehlerkorrektur-Codes, um fehlerfreie oder fehlertolerante Quantenoperationen durchzuführen. Zukünftige Maschinen werden über einen physikalischen Quantenprozessor verfügen, der Low-Level-Gates über HF-Signale steuert und Informationen ausliest, die durch einen topologischen Paritätscode geschützt sind. Dieser Code bildet »logische« qubits aus vielen physischen qubits. Algorithmen, die auf logische qubits angewendet werden, arbeiten fehlerfrei, aber derzeit ist der Overhead hoch. Die Konstruktion einer solchen Maschine ist entmutigend und weiterhin Gegenstand der aktiven Forschung.

- Zukünftige Rechner-Architekturen für Künstliche Intelligenz

- Heterogene KI-Systeme

- Analoge KI-Cores — jenseits digitalen Computings