IEDM 2018

Zukünftige Rechner-Architekturen für Künstliche Intelligenz

Fortsetzung des Artikels von Teil 1

Heterogene KI-Systeme

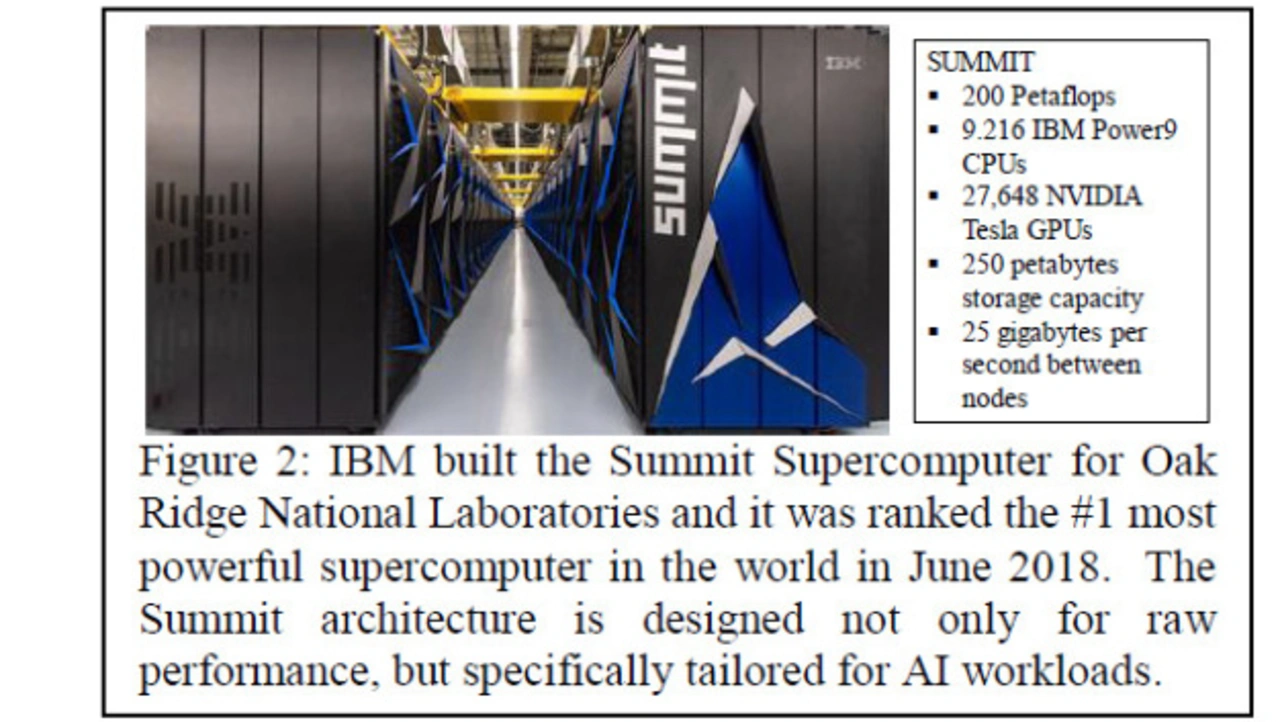

Gegenwärtige KI-Systeme stützen sich häufig auf GPUs (Graphics Processing Units), die eigentlich für Computerspiele und 3D-Grafik entwickelt wurden, aber sich gut zur Beschleunigung von DL-Trainings eignen. Die einfache mathematische Struktur der Rückführung lässt sich einfach parallelisieren, was der parallelen Struktur von GPUs gut entspricht. Der nächste Schritt ist, GPUs in optimierte heterogene Systeme zu bringen und die Rechenleistung zu maximieren indem man CPU, GPU und Speicher ausbalanziert. Als Beispiel führt Welser den Summit Supercomputer der Oak Ridge National Labs mit 9216 IBM Power9-CPUs, 27.648 Nvidia Tesla GPUs und 250 Petabytes an Speicher an. Das System leistet 200 Petaflops.

Letztendlich kann der Kommunikationsaufwand, der mit der Verteilung von Rechenmodellen des maschinellen Lernens über ein skaliertes Rechenzentrum verbunden ist, eine Quelle für sinkende Gewinne bei der zur Modellierung eingesetzten Zeit sein.

Jobangebote+ passend zum Thema

Gehirninspirierte Architekturen und Approximate Computing

Die meisten Rechner basieren auf der Von-Neumann-Architektur, die Rechenoperationen und Speicher voneinander trennt. Im Gegensatz dazu integrieren biologische Gehirne eng das Rechnen in niedriger Genauigkeit, Speicher und Kommunikation, und erreichen so einen außergewöhnlichen Wirkungsgrad. Ebenso hat sich das Computing in der Vergangenheit auf hochpräzise 64- und 32-bit-Gleitkomma-Arithmetik verlassen, die für KI-Workloads typischerweise nicht erforderlich ist. Inzwischen wurden neue Architekturen in konventioneller digitaler CMOS-Technologie demonstriert, die eine höhere Leistungseffizienz basierend auf einer vom Gehirn inspirierten Architektur und approximativem Computing versprechen. Inspiriert von der Struktur des Gehirns, um Effizienz, Skalierbarkeit und Flexibilität zu erreichen, verwendet die IBM TrueNorth-Architektur parallele digitale Neuronen, die eng bei den zugehörigen Synapsen (die die Berechnungs- und Speicherelemente tiefer Netzwerke bereitstellen) sitzen. Die Neuronen rechnen mit niedriger Genauigkeit und stellen sowohl lokale als auch weiter reichende Kommunikationskanäle bereit. Mit seinen 4096 neurosynaptischen Cores ist TrueNorth bis dato der größte neuromorphe Prozessor. Verbunden über ein On-Chip-Netzwerk stehen über 1 Million programmierbare feuernde Neuronen und über 256 Millionen konfigurierbare Synapsen mit niedriger Rechengenauigkeit zur Verfügung. Bei Approximate Computing wird Recheneffizienz durch einen Verlust an Genauigkeit erkauft. Im Labor hat IBM 64 TrueNorth-Chips zu einem System mit 64 Millionen Neuronen und 16 Milliarden Synapsen zusammengeschaltet.

- Zukünftige Rechner-Architekturen für Künstliche Intelligenz

- Heterogene KI-Systeme

- Analoge KI-Cores — jenseits digitalen Computings