Blick auf die Zukunftstechnologie

Wie funktioniert ein Quantencomputer?

Quantencomputer werden die klassischen Rechner nicht ersetzen – aber die Koexistenz wird sehr fruchtbar sein. Hier erfahren Sie, wie die Zusammenarbeit der beiden grundsätzlich funktioniert.

Für die Forschung an Quantencomputern stehen weltweit Milliarden zur Verfügung – entsprechend wird intensiv geforscht und an den technischen Herausforderungen gearbeitet. Das ist offensichtlich auch nötig. So beschreibt etwa Wikipedia einen Quantencomputer als »ein überwiegend noch theoretisches Konzept mit ersten speziellen und funktional eingeschränkten Prototypen«.

Superpositionsprinzip und Quantenverschränkung

Betrachten wir das Thema unter dem Aspekt eines Quantenprozessors, also als Zusatz-Recheneinheit, die die Gesetzmäßigkeiten der Quantentheorie nutzt. Statt mit binären Zuständen arbeitet der Quantenprozessor mit quantenmechanischen Zuständen wie dem Superpositionsprinzip oder der Quantenverschränkung (»Wissenschaft der Möglichkeiten«).

Die Schwierigkeit: Quantenprozessoren brauchen extrem niedrige Temparaturen

Um diese Effekte nutzen zu können, sind heute noch komplexe Versuchsaufbauten erforderlich. Diese isolieren Quantensysteme von äußeren Einflüssen. Sie erfordern das Arbeiten auf extrem niedriger Temperatur, derzeit noch nahe dem absoluten Nullpunkt.

Eine der zentralen Herausforderungen für den praktischen Einsatz besteht also darin, Quantenprozessoren auch bei Zimmertemperatur einsetzen zu können. Dass dies grundsätzlich möglich ist, beweist uns unser Gehirn jeden Tag.

Der Motivator für all diese Anstrengungen: Erste Quantenprozessoren sind heute schon in der Lage, bestimmte komplexe Berechnungen erheblich schneller zu leisten als traditionelle Rechenzentren.

Jobangebote+ passend zum Thema

Die hohen bewilligten Forschungsgelder lassen zwei Schlüsse zu; beide befeuern das Rennen um einen einigermaßen praxistauglichen Quantenprozessor:

- Für das Quantencomputing existieren sehr konkrete Ansätze – aber die Technologie steckt noch in den Kinderschuhen.

- Beim Quantencomputing geht es um einen potenziell riesigen Markt. Wichtig ist daher eine hohe Geheimhaltung. Jede Weitergabe von Wissen oder Ideen könnte die Wettbewerber beflügeln.

IBMs Quantenprozessor in Deutschland läuft seit 2021

Im Labor werden derzeit Rechenprozesse erforscht, die auf die jeweiligen Versuchsaufbauten abgestimmt sind. Der Quantenprozessor von IBM in Baden-Württemberg, der 2021 seinen Betrieb aufnahm, arbeitet beispielsweise mit 27 supraleitenden Qubits, dem Äquivalent der Recheneinheit Bit im klassischen Computer. Zum Vergleich: Der größte öffentlich bekannte Quantenprozessor verfügte im November 2021 laut Wikipedia über 127 Qubits und ein Jahr später über 433 Qubits.

Einfachere Laboraufbauten schafften es immerhin mit 7 Qubits, die Zahl 15 in ihre Primzahlen 3 und 5 zu zerlegen. Neben der Anzahl von Qubits, die zum Einsatz kommen, ist es für den Versuchsaufbau wichtig, eine geringe Fehlerquote zu garantieren. Denn nur wenn es gelingt, das Quantensystem möglichst lange in einen stabilen Zustand zu bringen, entsteht beim Auslesen der Ergebnisse eine hohe Aussagekraft (»Grover-Algorithmus«). Deshalb hält sich auch hartnäckig die Meinung, Quantenprozessoren seien fehleranfällig und nur mäßig skalierbar.

Das Potenzial von Quantencomputern

Aufgrund fehlender standardisierter Hardware von Quantenprozessoren gibt es wenig konkrete Aussagen zur Qualität der diskutierten Algorithmen. Allerdings zeigen theoretische Studien, dass mit Quanteneffekten bestimmte Probleme der Informatik wie das Durchsuchen von riesigen Datenbanken (Grover-Algorithmus) oder das Zerlegen von großen Zahlen in Primzahlen (»Shor-Algorithmus«) wesentlich effizienter erledigt werden können. Quantensysteme können zahlreiche Zustände gleichzeitig annehmen. Daher können solche Aufgabenstellungen mit einer wesentlich geringeren Rechenzeit bewerkstelligt werden als mit traditionellen Computern. Das mag dann auch für weitere mathematische oder physikalische Problemstellungen mit großen Datenmengen anwendbar sein.

Computing und Quantencomputing gehören zusammen

Häufig wird allein vom Quantencomputer gesprochen – ohne zu erwähnen, dass Quantencomputing nicht ohne traditionelle Rechner auskommt. Auch wenn der Quantenprozessor das gesuchte Ergebnis schneller liefert als jedes konventionelle Rechenzentrum: Um ihn ansteuern und seine Ergebnisse auswerten und weiterverarbeiten zu können, benötigt man traditionelle Rechnereinheiten. Daher werden die beiden Rechner- oder Prozessorarten in Symbiose miteinander leben (müssen).

Bevor Missverständnisse entstehen: Unter Computing im klassischen Sinne versteht man eine Informationsverarbeitung, die auf einer logischen Abfolge von Entscheidungen beruht, welche nach einem fest definierten Algorithmus ausgeführt werden. Ein klassischer Computer verarbeitet die Daten durch die Steuerung von logischen Schaltelementen (Gatter, Multiplexer etc.) und speichernden Elementen (Flip-Flops, Register), die mit Transistoren aufgebaut sind. Diese funktionieren, abstrakt gesehen, wie Schalter, sie kennen nur »0« oder »1«. Der Computer ist ein riesiges Netzwerk von Schaltern, die auf einen Input reagieren und als logisches Ergebnis wieder »0« oder »1« ausgeben. So entsteht der klassische Rechenvorgang.

Quantencomputing – der wesentliche Unterschied zum Computing

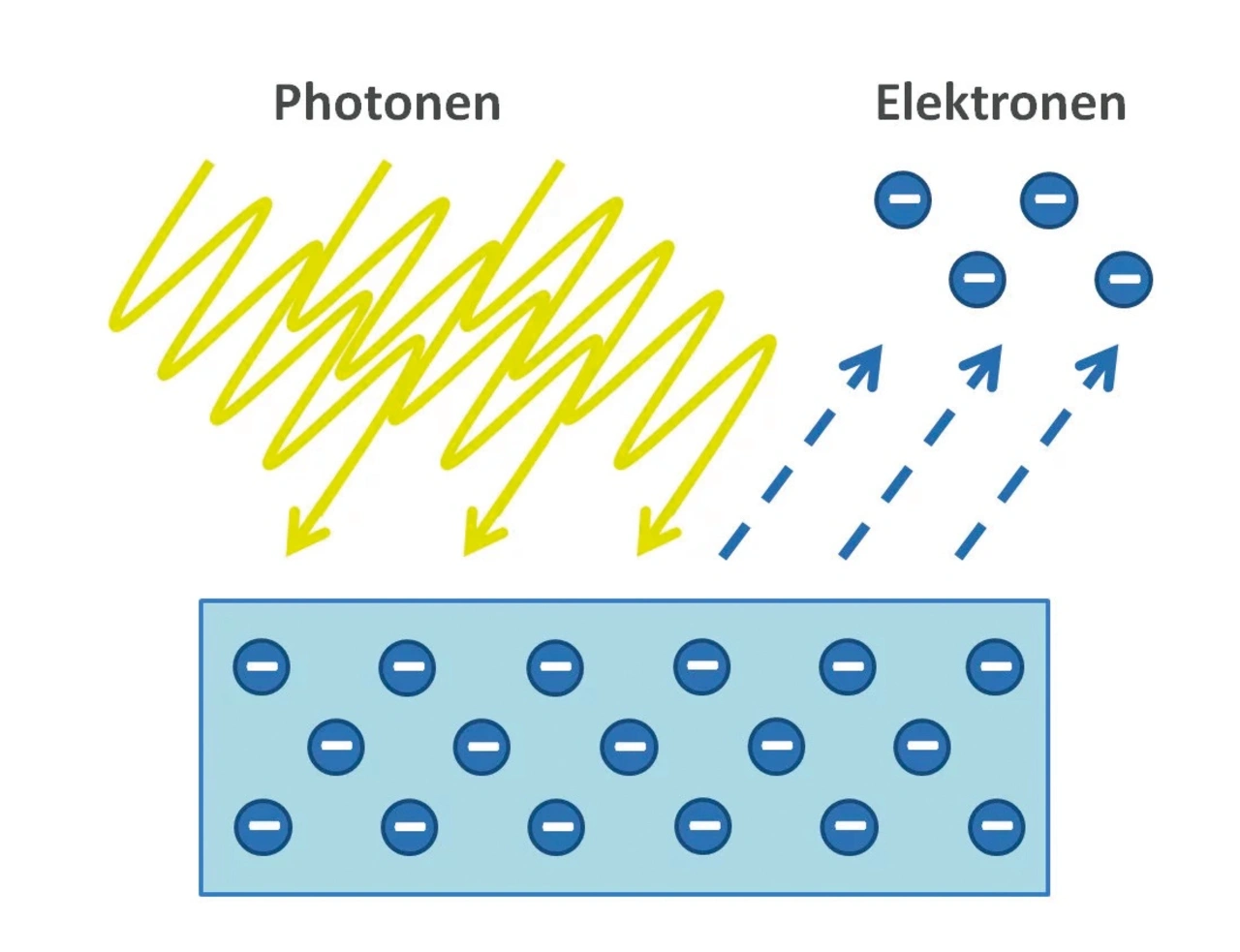

Traditionelle Computer arbeiten lediglich mit den Zuständen »0« oder »1«. Die Kombinationen aus diesen Zuständen erfolgen additiv. Ein Quantenprozessor hingegen rechnet auch mit sämtlichen Zwischenzuständen, erzeugt durch Superpositionen im Qubit.

Die Quantentheorie

Gemäß der Quantentheorie kann die Kombination aus all diesen Zuständen nicht nur additiv erfolgen, sondern auch multiplikativ. Das ist der Grund dafür, dass mit Quantencomputing wesentlich komplexere Strukturen erzeugt werden können.

Das Problem dabei: Es gibt bislang keine etablierte Software für das Quantencomputing. Die Fähigkeit eines Quantenprozessors, gleichzeitig mit einer unglaublich großen Anzahl an unterschiedlichen Zuständen zu rechnen, ist zunächst schwer nutzbar. Einfach nur alle Zustände des Quantencomputers auszulesen hilft da wenig. Gesucht sind Quanten-Algorithmen, die dafür sorgen, dass mit möglichst großer Wahrscheinlichkeit nur der richtige Zustand übrig bleibt. Die beiden bisher bekannten Quanten-Algorithmen (Shor, Grover) sind in separaten Kästen erklärt.

Quantencomputing in der Realität

Eine Berechnung im Quantencomputer (im Zusammenspiel klassischer Rechner mit einem Quantenprozessor) beginnt damit, dass die notwendigen Daten mithilfe eines klassischen Computers erhoben und aufbereitet werden, um sie anschließend dem Quantenprozessor bereitzustellen. Gemäß einem bestimmten Algorithmus werden die Daten im Quantenprozessor verändert. Dazu sind vorgegebene und in ihrer Reihenfolge festgelegte Eingriffe von außen erforderlich, die beispielsweise durch genau bestimmte Laserstrahlen erfolgen. Gesteuert wird der Laser wiederum durch klassische Computer. Am Ende des Rechenvorgangs im Quantenprozessor bestimmt der klassische Computer aus der Fülle der Quantenmöglichkeiten das Ergebnis, meist durch Berücksichtigung der Häufigkeit und Wahrscheinlichkeit. Anschließend wird das Ergebnis dann mit klassischen Methoden weiter aufbereitet oder verarbeitet.

Hardware des Quantenprozessors

Die Ergebnisqualität all dieser Schritte hängt von der Hardware des Quantenprozessors ab, also von dem quantischen Versuchsaufbau, welcher mit der Polarisation von Photonen, den Interferenzen von Molekülen oder den Energieniveaus von Ionen oder Ähnlichem arbeitet.

Quantencomputer sind mit ihrer Leistung und parallelen Berechnungsweise in der Lage, riesige Datenmengen besonders schnell und effizient zu bearbeiten. Deshalb werden in folgenden Bereichen große Verbesserungen durch den Einsatz der Technologie erwartet:

- Optimieren von Logistik- und Transportprozessen in Echtzeit

- Entwicklung von Medikamenten und Impfstoffen durch Nachbildung von Molekülen

- Simulation und Entwicklung neuer Materialien mit spezifischen Eigenschaften und verlässlichen Vorhersagen

- Wettervorhersage unter Einbeziehen unterschiedlichster Faktoren

- Auswerten riesiger Datenmengen mittels künstlicher Intelligenz

Damit bietet Quantencomputing ein enormes Potenzial, das heutige Supercomputer nicht erreichen.

Wissenschaft der Möglichkeiten

Die Quantentheorie ist nicht nur die Physik im Kleinen; sie ist auch die Physik der Möglichkeiten und der Beziehungen. Sie zeigt beispielsweise, dass Möglichkeiten bereits in der unbelebten Natur reale Wirkungen erzeugen.

Ein Quantenzustand umfasst gleichzeitig eine Fülle von Möglichkeiten, die alle mit diesem Zustand verträglich sind. Dieses Spektrum von Zuständen, die gleichzeitig existent sind und gleichzeitig gehandhabt werden, ist der Grund für die große und schnelle Rechenleistung von Quantensystemen und damit die Basis für Berechnungen im Quantencomputing.

Eine weitere Tatsache der Quantenphysik ist die Superposition oder die Überlagerung von Quantenzuständen, die selbst wieder zu Quantenzuständen werden. Ein Quantenprozessor nutzt damit den Vorteil, dass neben einem vorhandenen Quantenzustand gleichzeitig auch alle anderen damit verträglichen Quantenzustände erfasst sind.

Der Shor-Algorithmus

|

Dieser bereits 1994 von Peter Shor veröffentlichte Algorithmus, damals Mitarbeiter der AT&T Bell Laboratories, ist der mathematischen Zahlentheorie zuzuordnen. Er berechnet einen nichttrivialen Teiler einer zusammengesetzten Zahl und zählt somit zur Klasse der Faktorisierungsverfahren. Praktisch ist der Shor-Algorithmus (noch) nicht anwendbar, da (Stand 2020, neuere Informationen sind öffentlich nicht verfügbar) keine hinreichend großen und fehlerarmen Quantencomputer zur Verfügung stehen. Eine Forschungsgruppe von IBM hatte vor mehr als 20 Jahren einen Quantenprozessor mit sieben Qubits eingesetzt, um die Zahl 15 mithilfe des Shor-Algorithmus in die Faktoren 5 und 3 zu zerlegen. |

|---|

Grover-Algorithmus

|

Bei der sprichwörtlichen Suche nach der Stecknadel im Heuhaufen kann der Algorithmus von Lov Grover helfen. Er unterstützt die Suche nach einem bestimmten Wert in einer unsortierten Datenbank. Veröffentlicht wurde der Algorithmus 1996 – und er kann für sich in Anspruch nehmen, bisher der einzige Algorithmus zu sein, bei dem bewiesen ist, dass Quantenprozessoren prinzipiell schneller sind als traditionelle Computer. Dabei ist der Grover-Algorithmus ein sogenannter probabilistischer Algorithmus. Das heißt: Er liefert mit einer hohen Wahrscheinlichkeit richtige Ergebnisse – und zudem kann die Wahrscheinlichkeit einer fehlerhaften Antwort durch wiederholte Ausführung des Algorithmus verringert werden. Für Profis: Mit dem Shor-Algorithmus ist ein polynomiell schneller probabilistischer Faktorisierungsalgorithmus für Quantencomputer bekannt, während kein bekannter klassischer Faktorisierungsalgorithmus polynomielle Laufzeit besitzt. Allerdings gibt es bisher keinen mathematischen Beweis, dass nicht doch ein solcher Algorithmus existiert. |

|---|