ISSCC 2020

Chip-Innovation treibt KI-Revolution

Fortsetzung des Artikels von Teil 3

Gesucht: Das universell einsetzbare ML-System der Zukunft

In der ML-Forschungs-Community gibt es derzeit einige interessante Forschungsstränge, die wahrscheinlich noch interessanter werden, wenn man sie zusammenführt.

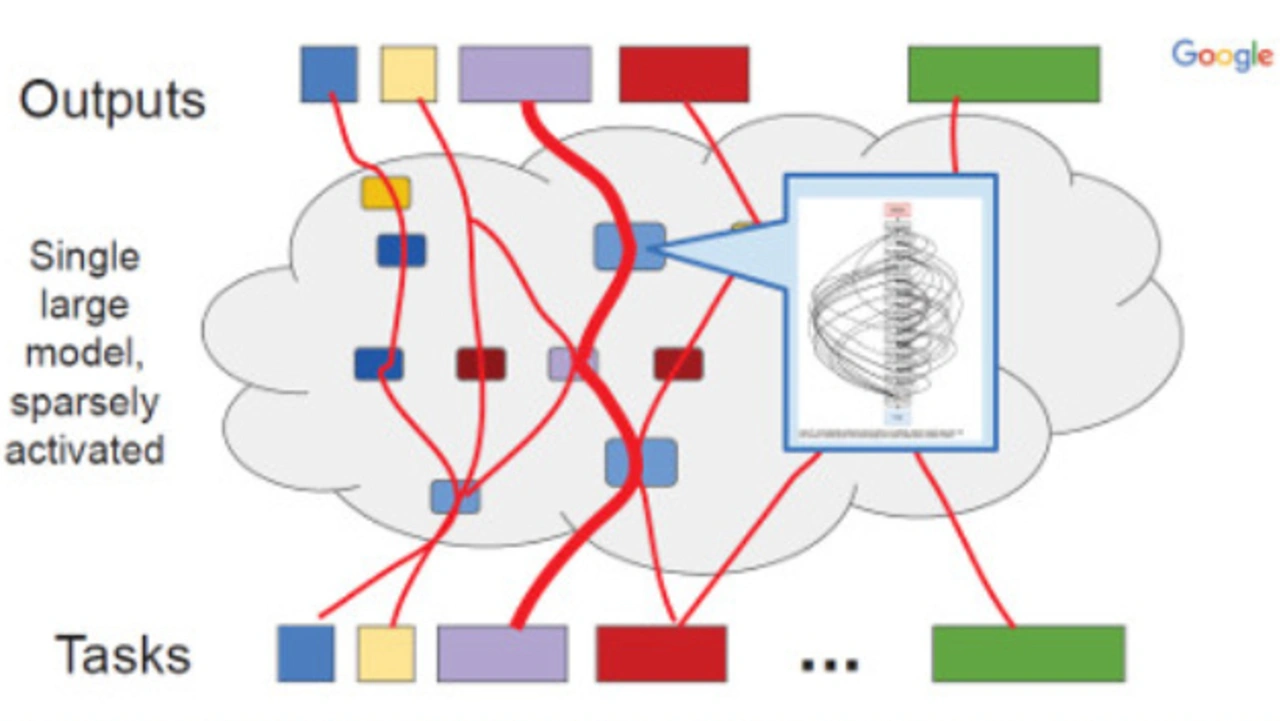

Ein erster Forschungstrend ist die Arbeit an spärlich-aktivierten Modellen (sparsely activated models), wie dem Modell der spärlich gestaffelten (sparsely-gated) Mischung von Experten-Modellen, wie man Modelle mit sehr großer Kapazität aufbauen kann, bei denen nur ein Teil des Modells für ein bestimmtes Beispiel »aktiviert« wird (z.B. nur 2 oder 3 Experten von 2048 Experten). Die Routing-Funktion in solchen Modellen wird gleichzeitig und gemeinsam mit den verschiedenen Experten trainiert, so dass die Routing-Funktion lernt, welche Experten welche Art von Beispielen gut beherrschen, und die Experten gleichzeitig lernen, sich auf die Eigenschaften des Stromes von Beispielen zu spezialisieren, denen sie zugeordnet werden. Dies steht im Gegensatz zu den meisten heutigen ML-Modellen, bei denen für jedes Beispiel das gesamte Modell aktiviert wird. Dean zitierte dazu ein Paper von Shazeer et al. 2017, das zeigte, dass ein solcher Ansatz gleichzeitig ca. neun mal effizienter beim Training und ca. 2,5 mal effizienter bei der Inferenz (Schlussfolgerung) sein kann sowie eine höhere Genauigkeit (+1 BLEU-Punkt für eine Sprachübersetzungsaufgabe) aufweisen kann.

Als zweiten Trend führt Dean die Arbeiten zum automatisierten maschinellen Lernen (AutoML) an, bei denen Techniken wie die Suche nach neuronalen Architekturen oder die evolutionäre Architektursuche in der Lage sind, automatisch wirksame Strukturen und andere Aspekte von ML-Modellen oder -Komponenten zu lernen, mit dem Ziel die Genauigkeit für eine bestimmte Aufgabe zu optimieren. Diese Ansätze beinhalten oft die Durchführung vieler automatisierter Experimente, von denen jedes mit einem erheblichen Rechenaufwand verbunden sein kann.

Beim dritten Trend geht es um Multi-Task-Training in bescheidenem Umfang von einigen wenigen bis zu einigen Dutzend verwandten Tasks, oder um das Transfer-Lernen von einem Modell, das mit einer großen Datenmenge für eine verwandte Aufgabe trainierte wurde und dann per Feinabstimmung mit einer kleinen Datenmenge an eine neue Aufgabe angepasst wird. Dieses Vorgehen hat sich gezeigt bei einer Vielzahl von Problemen als sehr effektiv erwiesen, zitiert Dean Devlin et al. 2018. Bislang zielen die meisten Fälle von Multi-Task-ML auf eine einzige Modalität ab (z.B. alle visuellen Aufgaben oder alle textlichen Aufgaben), obwohl einige wenige Autoren mittlerweile auch multimodale Einstellungen in Betracht ziehen, wie Ruder 2017.

Jobangebote+ passend zum Thema

Eine besonders interessante Forschungsrichtung führt diese drei Trends zusammen, mit ein System, das auf groß angelegter ML-Beschleuniger-Hardware läuft, mit dem Ziel ein Modell zu trainieren, das Tausende oder Millionen von Aufgaben in einem einzigen Modell ausführen kann. Ein solches Modell könnte aus vielen verschiedenen Komponenten unterschiedlicher Strukturen bestehen, wobei der Datenfluss zwischen den Beispielen relativ dynamisch einer Beispiel-für-Beispiel-Basis folgt. Das Modell könnte Techniken verwenden, wie die spärlich-gestaffelte Mischung von Experten und ein erlerntes Routing, um ein Modell für große Kapazitäten zu schaffen, aber wo eine bestimmte Aufgabe oder ein Beispiel nur einen kleinen Teil der gesamten Komponenten im System aktiviert (dies hält den Rechenaufwand und den Energieverbrauch pro Trainingsbeispiel oder Inferenz viel niedriger). Eine interessante Richtung, die es zu erforschen gilt, ist die Verwendung von dynamischen und adaptiven Mengen von Berechnungen für verschiedene Beispiele, so dass »einfache« Beispiele sehr viel weniger Rechenaufwand brauchen als »schwere« Beispiele (eine relativ ungewöhnliche Eigenschaft bei heutigen ML-Modellen). Bild 7 zeigt ein solches System.

Jede Komponente könnte selbst eine AutoML-ähnliche Architektursuche ausführen, um die Struktur der Komponente an die Arten von Daten anzupassen, die an diese Komponente weitergeleitet werden. Neue Aufgaben können sich Komponenten nutzen, die auf andere Aufgaben trainiert wurden, sofern dies sinnvoll ist. Dean hat die Hoffnung, dass durch sehr groß angelegtes Multi-Task-Lernen, gemeinsam genutzte Komponenten und ein gelerntes Routing, die Modelle sehr schnell lernen, neue Aufgaben mit hoher Genauigkeit zu erfüllen. Dabei kommt ein Modell mit relativ wenigen Beispielen für jede neue Aufgabe aus, weil es in der Lage ist, das Fachwissen und die internen Repräsentationen zu nutzen, die sie bereits entwickelt hat, um andere, verwandte Aufgaben zu erfüllen.

Der Aufbau eines einzigen universellen ML-Systems, das Millionen von Aufgaben bewältigen kann, und das lernen kann, neue Aufgaben automatisch und erfolgreich zu bewältigen, ist eine echte Herausforderung auf dem Gebiet der künstlichen Intelligenz und der Computersystemtechnik: Sie wird Fachwissen und Fortschritte in vielen Bereichen erfordern, die sich auf das Design integrierter Schaltungen, Computernetze, ML-orientierter Compiler, verteilter Systeme und Algorithmen des maschinellen Lernens erstrecken, um damit das Gebiet der künstlichen Intelligenz voranzutreiben. Ziel ist der Aufbau eines Systems, das verallgemeinert werden kann, um neue Aufgaben selbstständig zu lösen über die gesamte Bandbreite der Anwendungsbereiche des maschinellen Lernens hinweg.

- Chip-Innovation treibt KI-Revolution

- Spezielle Hardware für maschinelles Lernen

- Maschinelles Lernen für den Schaltungsentwurf und in der Halbleiterfertigung

- Gesucht: Das universell einsetzbare ML-System der Zukunft