ISSCC 2020

Chip-Innovation treibt KI-Revolution

»Es ist schwieriger einen Computer zu programmieren, dass er clever ist, als ihn zu programmieren, dass er lernt, clever zu werden«, stellte Jeff Dean von Google in seiner Keynote auf der ISSCC fest und begab sich auf die Suche nach dem universell einsetzbaren ML-System der Zukunft.

Die Plenarsitzung der International Solid-State-Circuits Conference 2020 (ISSCC) im Marriott Marquis San Francisco startete auch in diesem Jahr wieder mit vier angesehenen Keynote-Sprechern. Passend zum Konferenzthema »Integrierte Schaltkreise, die die KI-Ära antreiben« haben die diesjährigen Plenarvorträge wichtige Innovationstrends skizziert, die den Weg nach vorn in die aufkommende Ära der KI ebnen sollen.

Die Serie von vier Plenarsitzungen begann mit einer Präsentation über KI/Deep-Learning-Implikationen in Bezug auf Computerarchitektur und Chipdesign. Für die Auftakt-Keynote konnte Jeff Dean, Google Senior Fellow und SVP of Research, gewonnen werden, der die jüngsten Fortschritte beim Deep Learning erörterte und auch Möglichkeiten beleuchtete, wie maschinelles Lernen (ML) möglicherweise bei bestimmten Aspekten des Schaltungsentwurfs helfen kann.

Jobangebote+ passend zum Thema

»Die Deep Learning Revolution«

Für Jeffrey Dean von Google Research in Mountain View war die ISSCC in San Francisco ein Heimspiel: Sein Vortrag »Die Deep Learning Revolution und ihre Implikationen für Computer-Architekturen und Chip-Design« befasste sich mit den Fortschritten beim maschinellen Lernen (ML) und insbesondere bei den auf künstlichen neuronalen Netzen basierenden Deep-Learning-Ansätzen (DL), um die Fähigkeiten zum Aufbau präziserer Systeme in einem breiten Spektrum von Bereichen zu verbessern, darunter Computer-Vision, Spracherkennung, Sprachübersetzung und die Aufgaben des natürlichen Sprachverstehens (NLP – Natural Language Processing). Es wurden auch einige der Möglichkeiten diskutiert, wie maschinelles Lernen in der Lage sein wird, bei einigen Aspekten des Schaltungsentwurfsprozesses zu helfen. Schließlich skiizziert er die Richtung hin zu viel größeren Multi-Task-Modellen, die nur wenig genutzt werden und auf ein viel dynamischeres, beispiel- und aufgabenbasiertes Routing setzen als die heutigen Modelle des maschinellen Lernens.

Computing in der Post-Moore’s-Law-Ära

Viele der Schlüsselideen und Algorithmen, die dem Deep Learning und künstlichen neuronalen Netzen zugrunde liegen, gibt es seit den 1960er, 1970er, 1980er und 1990er Jahren. In den späten 1980er Jahren und Anfang der 1990er Jahre gab es in der ML- und KI-Gemeinschaft einen Aufschwung, da Menschen erkannten, dass neuronale Netze einige Probleme auf interessantem Wege lösen können. Die erheblichen Vorteile ergeben sich aus ihrer Fähigkeit, sehr rohe Formen von (manchmal heterogenen) Eingabedaten zu verarbeiten und ein Modell mit hierarchischen Repräsentationen automatisch im Rahmen des Trainingsprozesses zu erzeugen, um eine prädiktive Aufgabe zu erfüllen. Zu dieser Zeit waren Computer jedoch nicht mächtig genug, um diesen Ansatz auf etwas anderes als kleine Probleme von der Größe eines Spielzeugs anzuwenden. Einige Forschungsarbeiten gingen damals in die Richtung, die verfügbare Rechenleistung für das Training neuronaler Netze durch den Einsatz paralleler Algorithmen zu steigern. Aber zum größten Teil entfernte sich das Interesse der meisten Forscher in der AI- und ML-Community von den Ansätzen neuronaler Netze. Erst in der späteren 2000er-Dekade, nach zwei weiteren Jahrzehnten von Verbesserungen der Rechenleistung durch das Moore'sche Gesetz wurden Computer endlich leistungsfähig genug, um große neuronale Netze zu realistischen, realen Problemen wie »Imagenet« zu trainieren. Insbesondere das Paradigma, GPU-Karten (GP-GPU) wegen Ihrer hohen Gleitkomma-Rechenleistung als Standardrechner einzusetzen, ermöglichte die Implementierung von neuronalen Netzen, die interessante Ergebnisse bei schwierigen, realen Problemen zeigten.

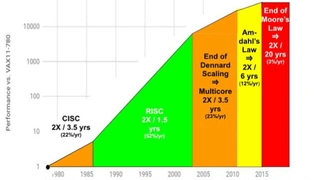

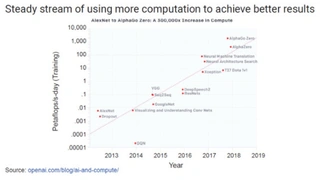

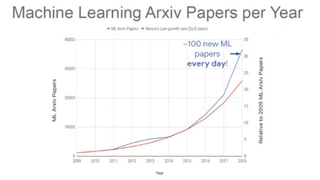

Es ist vielleicht ein bisschen unglücklich, dass die Computerindustrie insgesamt eine dramatische Verlangsamung der jährlichen Verbesserung der allgemeinen CPU-Leistung erlebt, gerade als genug Rechenleistung zur Verfügung steht, um interessante Probleme der realen Welt in Angriff zu nehmen, und als der zunehmende Umfang und die Anwendbarkeit des maschinellen Lernens zu einem dramatischem Hunger nach zusätzlichen Rechenressourcen zur Bewältigung größerer Probleme führt. Bild 1 zeigt diese dramatische Verlangsamung, wobei die Branche von einer Verdoppelung der CPU-Leistung alle 1,5 Jahre (1985 bis 2003) oder 2 Jahre (2003 bis 2010) nun in eine Ära wechselt, in der sich die Rechenleistung von CPUs nur alle 20 Jahre verdoppeln soll. In Bild 2 ist der dramatische Anstieg der Rechenanforderungen für einige wichtige Fortschritte beim maschinellen Lernen in der jüngsten Vergangenheit zu sehen. Man beachte die logarithmische Y-Achse, wobei die Linie für die beste Anpassung eine Verdoppelungszeit der Rechenanforderungen von 3,43 Monaten für diesen ausgewählten Satz von wichtigen ML-Forschungsergebnissen bedeutet. Bild 3 zeigt den dramatischen, sprunghaften Anstieg der wissenschaftlichen Veröffentlichungen im Bereich des maschinellen Lernens und seiner Anwendungen. Erhoben wurde die Anzahl der Veröffentlichungen, die in der Kategorie maschinelles Lernen von Arxiv gelistet sind, einem beliebten Hosting-Service für Papers. Die Anzahl der Papers hat vom Jahr 2009 auf 2018 um den Faktor 32 zugelegt, eine Wachstumsrate von mehr als einer Verdoppelung alle 2 Jahre. Es gibt jetzt mehr als 100 Forschungsarbeiten pro Tag, die in Arxiv in den Unterbereichen des maschinellen Lernens veröffentlicht werden, und dieses Wachstum zeigt keine Anzeichen einer Verlangsamung.

»Die Deep Learning Revolution«

- Chip-Innovation treibt KI-Revolution

- Spezielle Hardware für maschinelles Lernen

- Maschinelles Lernen für den Schaltungsentwurf und in der Halbleiterfertigung

- Gesucht: Das universell einsetzbare ML-System der Zukunft