GTC 2023

»Beschleunigtes Computing« ist der Weg vorwärts«

Die kürzlich stattgefundene GTC 2023 war bereits die 14. Entwicklerkonferenz von Nvidia. Jensen Huang, Gründer und CEO von Nvidia, zeigte sich in seiner Keynote überzeugt, dass KI und beschleunigtes Computing für jeden offensichtlich im Markt angekommen sind; ChatGPT sei erst der Anfang.

KI und beschleunigtes Computing kommen aus der Sicht von Nvidia-CEO Jensen Huang genau zur richtigen Zeit, denn »früher war es so, dass das Mooresche Gesetz uns alle fünf Jahre eine Verzehnfachung der Leistung bei etwa gleichem Preis und etwa gleicher Leistung bescherte«. Alle fünf Jahre das 10-Fache, alle zehn Jahre das 100-Fache, alle 20 Jahre das 10.000-Fache, und genau diese Leistungssteigerungen sind der Grund dafür, »dass unsere PCs so leistungsfähig und nützlich geworden sind, obwohl der Preis in etwa gleich geblieben ist«. Aber: »Diese grundlegende Dynamik ist vorbei. Wenn wir in den nächsten Jahrzehnten die Rechenleistung weiter steigern wollen, brauchen wir einen anderen Weg. Und wir glauben, dass die Industrie insgesamt und sicherlich auch die Arbeit, die wir in den letzten Jahrzehnten geleistet haben, der Weg in die Zukunft ist. Beschleunigtes Computing ist der Weg in die Zukunft«, so Hensen.

Für Nvidia sieht die Zukunft damit glänzend aus, das spiegeln auch die Zahlen der GTC 2023 wider: 250.000 Teilnehmer und über 650 Vorträge, »früher waren es 8000«, so Huang. Auch seine Hinweise zum Ökosystem des Unternehmens bestätigen, dass Nvidia die richtigen Ansätze verfolgt: Ein Unternehmen mit 28.000 Mitarbeitern, Huang bezeichnet sein Unternehmen als klein, kann nicht alles selbst machen, also benötigt es Partner und ein entsprechendes Ökosystem, und hier steht Nvidia hervorragend da: »Wir haben mittlerweile rund 4 Mio. Entwickler, 40.000 Unternehmen und 14.000 Startups in unserem Inception-Programm«, sagt Huang. Und er nutzt die GTC, um weitere wichtige Partnerschaften anzukündigen: »Google, Microsoft, Oracle und eine Reihe anderer führender Unternehmen bieten neue KI-, Simulations- und Kollaborationsmöglichkeiten für jede Branche«, erklärt Huang.

Jobangebote+ passend zum Thema

Neue Partnerschaften und Produkte

Die Technologien von Nvidia sind für KI von entscheidender Bedeutung. Das macht Huang an folgender Entwicklung deutlich: Am Anfang der »generativen KI-Revolution« (2016) übergab das Unternehmen den ersten Nvidia-DGX-KI-Supercomputer an OpenAI (Entwickler von ChatGPT). »Mittlerweile laufen die Nvidia-DGX-Supercomputer, die ursprünglich als KI-Forschungsinstrument eingesetzt wurden, rund um die Uhr in Unternehmen auf der ganzen Welt, um Daten zu verbessern und KI zu verarbeiten. Die Hälfte aller Fortune-100-Unternehmen haben DGX-KI-Supercomputer installiert«, so Huang.

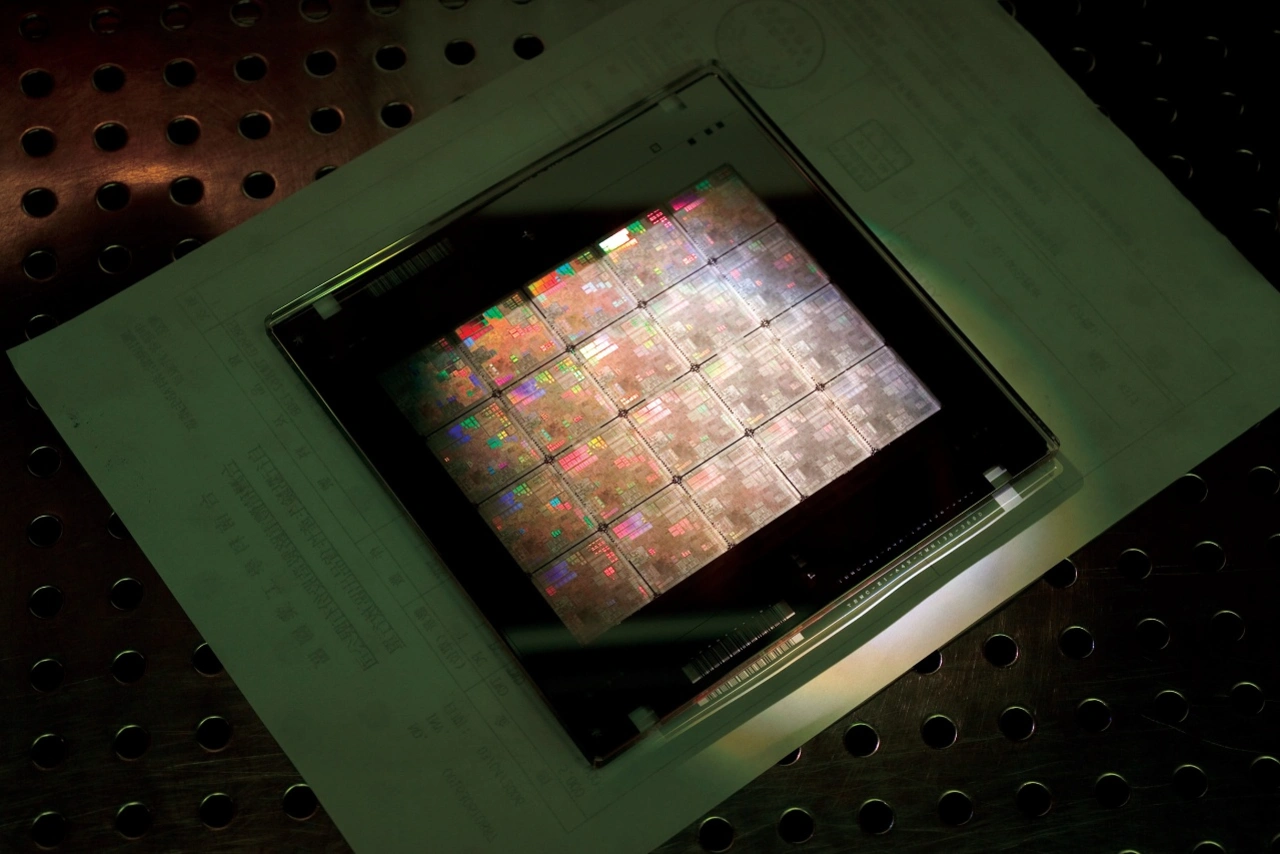

Huang kündigt auch eine neue GPU für das Inferenzieren von großen Sprachmodellen an: die H100 NVL mit Dual-GPU NVLink. Sie basiert auf der Hopper-Architektur von Nvidia und verfügt über eine Transformer-Engine, die für die Verarbeitung von Modellen wie dem GPT-Modell (Basis von ChatGPT) entwickelt wurde. Im Vergleich zu HGX A100 für die Verarbeitung von GPT-3-Netzen ist ein Standardserver mit vier H100-Paaren bis zu zehnmal schneller.

Huang erklärt weiter, dass die neueste Version von DGX über acht Nvidia-H100-GPUs verfügt, die miteinander verbunden sind und wie eine einzige riesige GPU arbeiten. Die sogenannten Nvidia DGX H100 sind bereits in Produktion, sodass Huang auch einige Erfolgsmeldungen diesbezüglich vermelden kann. So kündigt Oracle Cloud Infrastructure die begrenzte Verfügbarkeit neuer OCI-Compute-Bare-Metal-GPU-Instanzen an, die mit H100-GPUs ausgestattet sind. Aber auch Amazon Web Services kündigt seine kommenden EC2-UltraClusters von P5-Instanzen an, deren Größe auf bis zu 20.000 miteinander verbundene H100-GPUs skaliert werden kann.

Dazu kommt noch die kürzliche Meldung von Microsoft Azure. Da hieß es: »Die Nachfrage nach einer fortschrittlichen KI wächst immer weiter. Die Antwort darauf heute sind eine Supercomputing-Infrastruktur, entsprechende Services und Expertise, um der exponentiell zunehmenden Größe und Komplexität der neuesten KI-Modelle gerecht zu werden. Aus diesem Grund führt Microsoft jetzt seine bisher leistungsstärkste und massiv skalierbare VM-Serie für KI-Anwendungen auf Azure ein: die ND H100 v5 VM ermöglicht On Demand in Größen von acht bis zu Tausenden von Nvidia-H100-GPUs, die durch Nvidia-Quantum-2-InfiniBand-Netzwerke miteinander verbunden sind.« Laut Huang setzt auch Meta auf Nvidia; das Unternehmen will seinen H100-betriebenen KI-Supercomputer »Grand Teton« intern für seine KI-Produktions- und Forschungsteams nutzen. Huang weiter: »OpenAI will H100 auf seinem Azure-Supercomputer einsetzen, um seine fortlaufende KI-Forschung zu betreiben.«

- »Beschleunigtes Computing« ist der Weg vorwärts«

- DGX Cloud - KI in jedes Unternehmen