Dank sicherer Zen-Mikroarchitektur

Mehr Support für Serverprozessoren

Beim Annähern von IT und OT sind kundenspezifische Serverapplikationen gefragt – das Entwickeln hängt jedoch stark am Support der Hardware. AMD bietet diesen für einige seiner Epyc-Prozessorserien an – und deckt somit viele Edge-Applikationen skalierbar, zukunftssicher sowie langzeitverfügbar ab.

Unternehmen verlagern zunehmend das Verarbeiten von Daten an den Ort ihres Entstehens – besser bekannt als Edge Computing. Mit Edge Computing reduziert sich die Netzwerklatenz, lassen sich Überlastungen vermeiden und eine bessere Leistung auf die Straße bringen. Allerdings stellen Unternehmen an Edge-Server in der Betriebstechnik (Operation Technology, OT) je nach Anwendungsfall und Gerätestandort individuelle und hohe Anforderungen. Höher als beispielsweise an die Hardware der Server-IT in einem Cloud-Rechenzentrum.

Jobangebote+ passend zum Thema

Planungssicher zum Design

Viele Systeme kommen in Fabriken an der Produktionslinie oder in nicht klimatisierten Außenbereichen zum Einsatz. Sie müssen resistent gegen Stöße und Vibrationen sowie in industriellen Temperaturbereichen einsetzbar sein. Kommen Edge-Server in der Medizin oder der Messtechnik zum Einsatz, kann wiederum das Einhalten von Richtlinien zur elektromagnetischen Verträglichkeit (EMV) eine Rolle spielen. In kritischen Infrastrukturen wie der Energie- und Wasserversorgung oder im Transport- und Verkehrssektor, sind hingegen weitere Zertifizierungen für die funktionale Sicherheit gefragt. Zudem spielen Ausfallsicherheit und Echtzeitfähigkeit eine tragende Rolle.

Für das Entwickeln und zukunftssichere Ausrollen solcher OT-Server sind Entwickler auf Serverprozessoren angewiesen. Sie sind als Embedded-Bauteile im Gegensatz zu IT-Standardkomponenten über einen deutlich größeren Zeitraum von mindestens fünf Jahre oder länger verfügbar. Einerseits weil das individuelle Auslegen der Systeme Zeit für das Entwickeln und Zertifizieren bedarf. Andererseits weil der Rollout oft einen längeren Zeitraum in Anspruch nimmt. Original Equipment Manufacturer (OEM) wollen innerhalb einer Produktgeneration die Systemkomponenten nicht austauschen. Denn sonst müssten sie alle Anforderungen an das Entwickeln und Zertifizieren von Neuem definieren. Zudem ist die Wartung komplexer, wenn unterschiedliche Systeme im Feld sind. Abgesehen von diesen Anforderungen unterscheiden sich OT-Server jedoch nicht deutlich von IT-Servern.

Anwendungsgerechte CPUs

In Edge-Rechenzentren kommen vornehmlich großzügig dimensionierte I/O-Schnittstellen zum Einsatz. Zum Beispiel zum Anbinden von GPGPUs für künstliche Intelligenz (KI) und maschinelles Lernen (ML) mittels neuronaler Netze, für schnellen Festspeicher via NVMe sowie für eine schnelle Netzwerkkonnektivität. Auch der Storage-Sektor folgt dem Trend: Mithilfe von Software Defined Storage können Anwender Storage Area Network (SAN)-Speichercluster und daran angebundene Network Attached Storage (NAS)-Systeme in die Randbereiche eines Netzwerks auslagern. So ist es möglich, kritische Applikationen und Daten vor Ort zusätzlich zu unterstützen und mögliche Ausfallzeiten zu minimieren. Sie laufen als virtuelle SAN auf virtuellen Maschinen (VM) und ermöglichen maßgeschneiderte Speicherapplikationen. Zudem gewährleisten sie auf mehreren physikalischen Standorten eine skalierbare Daten- und Anwendungssicherheit. Allerdings steigen hiermit ebenfalls die Sicherheitsanforderungen.

Auf die Sicherheit kommt es an

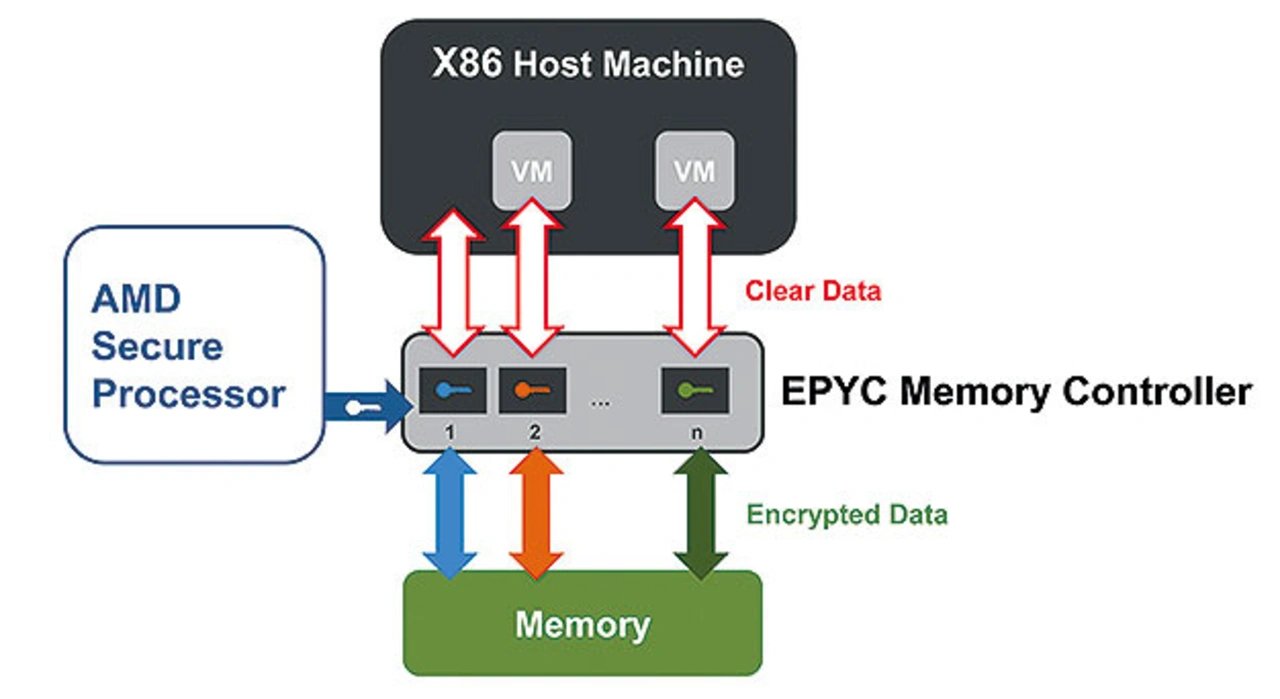

Nicht zuletzt deshalb verlangen leistungsfähige Applikationen und Serversysteme, die in den Randbereichen der Cloud zum Einsatz kommen, nach Hardware-integrierten Sicherheitsfunktionen. Immer mit der Möglichkeit, mehrere VM im Prozessor sowie den der jeweiligen VM zugewiesenen RAM-Speicher individuell zu verschlüsseln. Ebenso spielt die sichere Migration von virtuellen Maschinen und Containern zwischen lokal getrennten Systemen in modernen Netzwerk- und Storage-Infrastrukturen eine zunehmend wichtige Rolle. Beim Aufsetzen oder dem Erweitern eines Virtual Storage Area Network (vSAN)-Clusters ist es beispielsweise möglich, VMs sicher und ohne Unterbrechung der laufenden Dienste auf weitere physikalische Standorte zu migrieren.

Der Übergang zwischen dem Sichern von Daten und dem Ausfallschutz von Diensten, die die Daten verwalten und verarbeiten, ist somit fließend und entsprechend an die Bedürfnisse der Kunden anzupassen. Nicht zuletzt deshalb fordern Systemintegratoren CPU-Komponenten, die langzeitverfügbar und innerhalb der Prozessorserie möglichst Design-kompatibel ausgelegt sind. So erfüllt ein einziges Design die Anforderungen abgestufter Leistungs- und verschiedener Preisklassen.

Die »Zen«-Mikroarchitektur

AMD wird den Ansprüchen mit seinen »Epyc«-Embedded-Prozessorfamilien gerecht. Alle Epyc-Baureihen basieren auf der Zen-Mikroarchitektur, die AMD erstmals 2017 einführte. Sie nutzt die energieeffiziente »FinFET«-Transistortechnik, was zu mehr Leistung pro Watt und pro Fläche führt. Neu eingeführt hat das Unternehmen mit der Zen-Mikroarchitektur ebenso die sogenannte »Infinity Fabric«, die alle Einheiten auf einem System-on-Chip (SoC) mit geringer Latenz und hoher Bandbreite verbindet. Im Detail sind das die CPU-Cores, der Speichercontroller sowie I/O- und Systemhubs – beispielsweise für PCIe und Ethernet – sowie Grafik-Cores. Sie sind allerdings in den Epyc-Prozessoren nicht vorhanden – und nicht alleine auf einem Die, sondern sogar zwischen mehreren CPU-Dies. Infinity Fabric regelt außerdem die Verbindung zwischen den CPUs im Dual-Socket-Betrieb. Der bandbreitenstarke Verbindungsstrang ist zusammen mit der modularen CPU-Architektur verantwortlich für die hohe Skalierbarkeit aller Prozessoren mit Zen-Mikroarchitektur.

So nutzt die neue Architektur den sogenannten »Zen Core Complex« (CCX), der mehrere CPU-Cores zusammenfasst. Innerhalb eines CCX hat jeder Core mit derselben niedrigen Latenz Zugriff auf 512 KB L2-Cache pro Core und 8 MB gemeinsamen L3-Cache. Zudem sind mehrere CCX zu einem Core Complex Die (CCD), also einem Chiplet, zusammengefasst. Mehrere Chiplets ergeben verbunden über die Infinity Fabric den eigentlichen Prozessor, der als Multi Chip Module (MCM) designt ist (Bild 1).

»Epyc Embedded 3000« – robust und langzeitverfügbar

Die Modelle der Epyc-Embedded-3000-Prozessorserie fassen in dieser Struktur bis zu 16 CPU-Kerne für 32 Threads. Sie können über vier Speicherkanäle mit bis zu 1 TB DDR4-RAM mit 2.666 MHz versorgt werden. 64 PCIe-3.0-Lanes gewährleisten eine hohe I/O-Konnektivität. AMD bietet insgesamt sieben Modellvarianten, die sich unterscheiden:

➔ in der Anzahl der Kerne: 4, 8, 12 oder 16

➔ im CPU-Takt: 2,1 bis 3,0 GHz Boost-Takt

➔ in der Leistungsaufnahme, Thermal Design Power, TDP: 30 bis 100 W

Sie integrieren zudem achtfach 10-Gigabit-Ethernet (GbE) und 16 SATA-Ports. Alle Varianten sind dabei 100 Prozent pinkompatibel und über den Ball Grid Array (BGA)-Sockel auf die Boards gelötet – das macht die Designs besonders robust. Hierdurch sind sie insbesondere für den Einsatz in rauem Umfeld prädestiniert. Zudem können sie im erweiterten Temperaturbereich von -40 bis +85 °C zum Einsatz kommen. Die Tatsache, dass AMD sie mit einer erweiterten Verfügbarkeit von bis zu zehn Jahren anbietet, macht sie zu einer idealen Plattform für kompakte und robuste Telefonkonferenz- und Industrieserver am Edge. So sind sie konsequenterweise ebenfalls auf einer Vielzahl von Boards in unterschiedlichen Formaten wie µ-ITX, Mini-ITX Single Board Computer (SBC) sowie COM-Express Typ 7 Server-on-Modules verfügbar.

Mit den Epyc-Embedded-3000-CPUs führte AMD außerdem erstmals die Secure Encryption Virtualization (SEV) ein. Sie ermöglicht es, virtuelle Maschinen auf Hardwareebene zu verschlüsseln und vom Hypervisor zu isolieren. Ein separater Security-Prozessor stattet die zu sichernde VM mit einem individuellen AES-128-Bit-Schlüssel aus, der alle Nutzdaten der VM ebenfalls im Arbeitsspeicher verschlüsselt (SME, Secure Memory Encryption). So lassen sie sich auf Seite der Software nicht über den Hypervisor auslesen (Bild 2).

- Mehr Support für Serverprozessoren

- »Epyc-7002«-Familie mit »Zen 2«