Zeiss Meditec | Vom Sammeln zum Testen

Die Daten-DNA erfolgreicher Medizin-KI

Zwischen Datenhunger und Bias-Risiken: Medizin-KI-Entwickler brauchen qualitative, nachvollziehbare Daten ohne Verzerrung oder Fehler. Carl Zeiss Meditec zeigt beispielhaft, wie ein systematisches Rahmenwerk für Datenakquise, -aufbereitung und -aufteilung den Erfolg medizinischer KI-Systeme sichert.

Die Erfüllung von Datenanforderungen ist ein wesentlicher Aspekt bei der Entwicklung von KI/ML-basierten medizinischer Software. Welche spezifischen Datenanforderungen braucht es für eine erfolgreiche Implementierung und Validierung dieser Technologien?

Vorab ist es wichtig zu betonen, dass die Datenanforderungen nur ein Teil eines umfassenden Puzzles sind. Cybersicherheit, Datenspeicherung, klinische Bewertung, Risikomanagement und die Überwachung nach der Markteinführung spielen ebenfalls eine entscheidende Rolle in der Entwicklung und dem Einsatz von KI-Technologien im Gesundheitswesen. Diese Themen sind neben den Daten von großer Bedeutung, um die Sicherheit, Effektivität und Integrität von KI-Anwendungen zu gewährleisten.

Daten sind KI-Grundlage

Im Gegensatz zu herkömmlicher medizinischer Software, die oft auf festen Regeln und vordefinierten Algorithmen basiert, sind KI-Algorithmen auf große Mengen an qualitativ hochwertigen Daten angewiesen, um Muster zu erkennen und fundierte Entscheidungen zu treffen. Daher sind Datenanforderungen bedeutend für die Entwicklung von KI-basierten medizinischen Softwarelösungen, da sie direkt die Leistung und Genauigkeit der KI-Algorithmen beeinflussen.

Training, Validierung, Test

Die für die Entwicklung eines KI/ML-basierten Algorithmus erforderlichen Datensätze können grundsätzlich in Trainings-, Validierungs-, und Testdaten unterteilt werden, die unterschiedlichen regulatorischen Anforderungen unterliegen.

- Trainingsdaten sind der Grundpfeiler jeder KI-Entwicklung. Diese Daten werden verwendet, um das Modell zu trainieren, d. h. um die Parameter des Modells so anzupassen, dass es Muster und Zusammenhänge in den Daten erkennen kann.

- Validierungsdaten sind die Daten, die verwendet werden, um die Leistung des KI-Modells während des Trainings zu überwachen – manchmal werden sie als »Tuning-Daten« bezeichnet. Sie helfen dabei, Überanpassung (Overfitting) zu vermeiden, indem sie es ermöglichen, die Hyperparameter des Modells zu optimieren.

- Testdaten sind ein weiterer wichtiger Datensatz, der verwendet wird, um die endgültige Leistung des Modells zu bewerten. Für eine realistische Einschätzung der Modellleistung sollten diese Daten vollständig unabhängig von den Trainings- und Validierungsdaten sein.

Für die Entwicklung eines KI-Algorithmus wird ein strukturiertes und klar definiertes Rahmenwerk für die verschiedenen Schritte im Datenmanagement (Datensammlung, -aufbereitung und -aufteilung) benötigt, es ist entscheidend für

- die Sicherstellung der Datenqualität,

- die Einhaltung von Datenschutz- und Sicherheitsanforderungen

- und die Förderung von Transparenz und Nachvollziehbarkeit in der KI-Entwicklung.

Die nachfolgenden Informationen beschreiben ein solches Rahmenwerk, das auf globalen Anforderungen an die Qualitäts- und Quantitätsstandards von Daten basiert. Dieser Artikel kann aber nicht alle Anforderungen abdecken, sondern behandelt einige grundlegende Aspekte.

Datenakquise

Bevor mit der Datensammlung für die Entwicklung von KI-Algorithmen begonnen wird, ist es entscheidend, die spezifischen Eingabedatenanforderungen zu definieren.

Die folgenden Punkte sind notwendig zu berücksichtigen, um die Eingabedatenanforderungen abzuleiten, und müssen, falls zutreffend, vor Beginn der Datensammlung definiert werden: Klinischer Zweck / Claims, Vorgesehene Patientengruppe, Akzeptanzkriterien, Leistungskennzahlen, Ausgabe des Modells, und Qualitätskontrollanforderungen.

Im Folgenden werden die wesentlichen Eingabedatenanforderungen beschrieben:

- Die gesammelten Daten sollten direkt auf die spezifische Anwendung des KI-Modells abgestimmt sein.

- Die gesammelten Daten müssen genau, vollständig und aktuell sein. Fehlerhafte oder unvollständige Daten können die Leistung des Modells erheblich beeinträchtigen.

- Vor der Datensammlung müssen die geltenden Datenschutzbestimmungen berücksichtigt werden. Dies umfasst die Einholung der Einwilligung der betroffenen Personen und die Sicherstellung, dass die Daten anonymisiert oder pseudonymisiert werden, wenn dies erforderlich ist.

- Die gesammelten Daten sollten eine breite Vielfalt an Merkmalen abdecken, um die Generalisierbarkeit des Modells zu gewährleisten und Bias zu vermeiden. Dies kann unterschiedliche Altersgruppen, Geschlechter, ethnische Hintergründe und Krankheitsstadien umfassen.

- Die Daten sollten eine repräsentative Stichprobe der Zielpopulation darstellen, um sicherzustellen, dass das Modell in der realen Welt effektiv funktioniert.

Qualitätssicherung

Die Auswahl geeigneter Datenquellen ist entscheidend für die Entwicklung von KI-Algorithmen. Idealerweise sollten die Daten aus lokalen Quellen stammen, da diese spezifischen Informationen über die jeweilige Population und deren Gesundheitszustand bieten. Zudem sollten die Daten aus zuverlässigen und vertrauenswürdigen Quellen stammen, um die Qualität und Integrität der gesammelten Informationen sicherzustellen.

Verschiedene Hardware-Plattformen können die Qualität der Daten beeinflussen. Technische Anforderungen an das Akquisitionsgerät sollten einbezogen werden, wie z. B. Hersteller, Modelle, Spezifikationen und Leistungsindikatoren.

Die Qualitätskontrolle des Sammlungsprozesses soll Spezifikationen für die Datenaufnahmeoperationen festlegen und die Anforderungen an das Sammlungspersonal sowie den Sammlungsprozess klären.

Darüber hinaus muss eine Risikoanalyse hinsichtlich der Datensammlung durchgeführt werden. Faktoren, die die Datenqualität beeinflussen, müssen identifiziert und Kontrollen definiert werden. Ein solcher Faktor ist der sogenannte Datenbias.

Datenbias

Verzerrungen innerhalb der Daten etwa, weil diese nur aus einer bestimmten Bevölkerungsgruppe stammen, sind ein großer Stolperstein in der KI-Entwicklung. Die Vermeidung solcher Datenbias ist von zentraler Bedeutung für die Entwicklung fairer und zuverlässiger KI-Algorithmen. Ein Bias innerhalb der Daten kann die Leistung und die Entscheidungsfindung des Modells negativ beeinflussen und möglicherweise diskriminierende Ergebnisse erzeugen. Möglicherweise reicht eine Diskussion um die reine Existenz eines Bias nicht aus: Eventuell müssen daraufhin zusätzliche Design- und andere Überlegungen getroffen werden, um ein vorhandenes Bias zu mindern.

Die folgenden Aspekte sollten bei der Diskussion über Bias berücksichtigt werden: Erstens ist die Identifikation von potenziellen Quellen des Bias entscheidend. Dies kann durch die Analyse der Datenquellen und der Erhebungsmethoden erfolgen, um sicherzustellen, dass keine systematischen Verzerrungen eingeführt werden.

Zweitens müssen die demografischen Merkmale der gesammelten Daten überprüft werden, um sicherzustellen, dass alle relevanten Gruppen angemessen vertreten sind. Drittens ist die Implementierung von Techniken zur Bias-Erkennung und -Korrektur notwendig. Dies kann durch statistische Methoden und Algorithmen erfolgen, die darauf abzielen, Verzerrungen in den Daten zu identifizieren und zu korrigieren.

Schließlich sollten regelmäßige Audits und Überprüfungen durchgeführt werden, um die kontinuierliche Überwachung und Bewertung der Datenqualität und -integrität sicherzustellen. Durch die Berücksichtigung dieser Aspekte kann das Risiko von Bias minimiert und die Fairness und Zuverlässigkeit der KI-Algorithmen gewährleistet werden.

|

Gegen Grauen Star: Der Zeiss AI IOL Calculator |

|---|

|

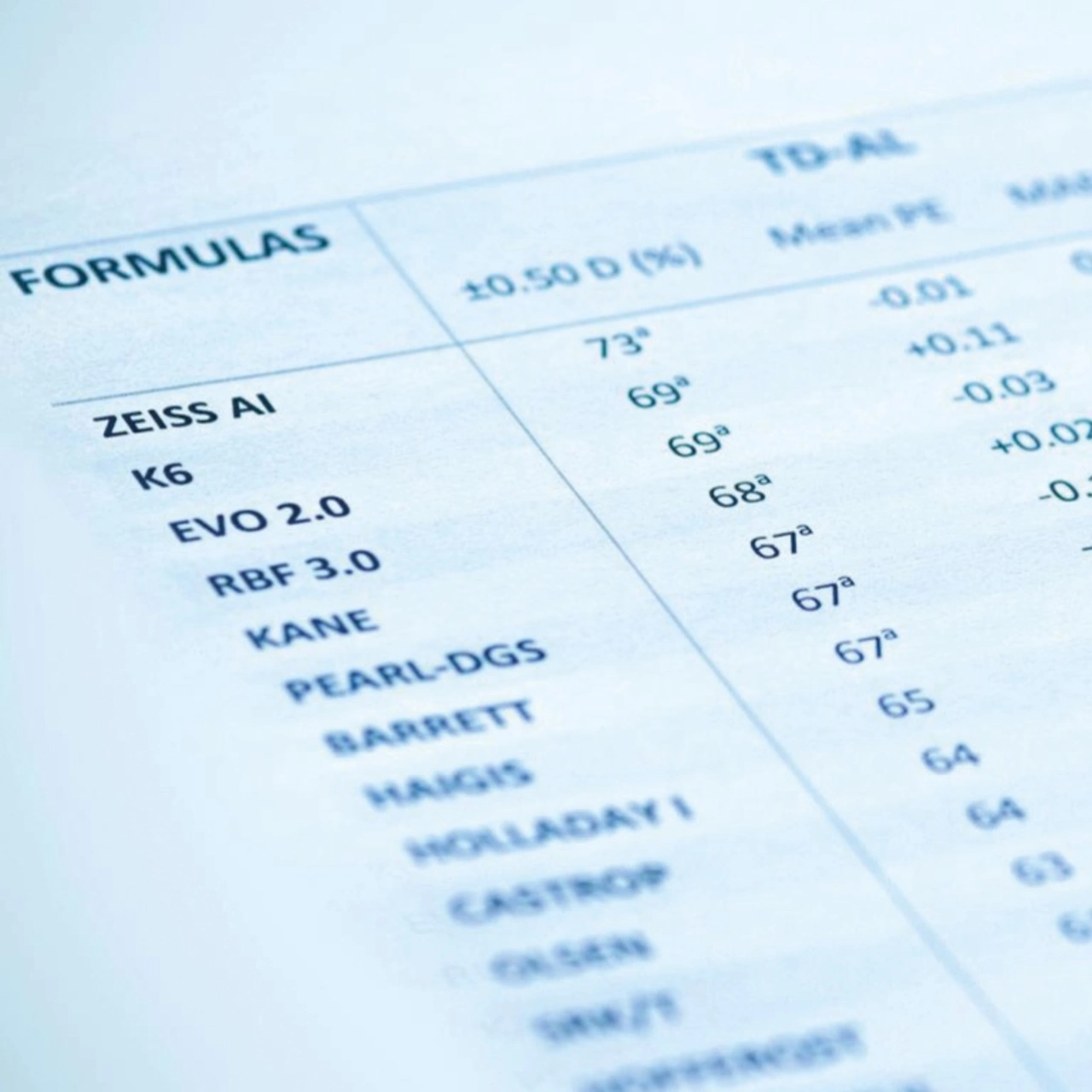

Zeiss Meditec hat fünf Säulen in der KI-Entwicklung etabliert: interdisziplinäre Zusammenarbeit, hochwertige und vielfältige Daten, die Einhaltung internationaler Standards, fortschrittliche Methodologien und eine robuste globale Infrastruktur zur Unterstützung von KI-Systemen. Die Einhaltung dieser Säulen kam bei der Entwicklung des Zeiss AI IOL Calculators zum Tragen, der kürzlich die CE-Zulassung erhielt. Die KI-gestützte Software unterstützt Augenchirurgen bei der Operation von Grauem Star und berechnet die notwendige refraktive Stärke von Intraokularlinsen (IOL) für die Kataraktchirurgie. Der datenbasierte Algorithmus arbeitet zur präzisen Berechnung der IOL-Stärke mit fortschrittlicher künstlicher Intelligenz (KI) und paraxialem Ray-Tracing. Dank einer spezifischen, stetig wachsenden Sammlung klinischer Daten, können die komplexen Wechselwirkungen zwischen dem menschlichen Auge und den künstlichen Linsen erfasst werden: A-Konstanten als Parameter bei der Berechnung der Brechkraft werden überflüssig. Aktuell kann der Zeiss AI IOL Calculator über 16.000 Parameter in seine Vorhersagen für eine präzise Linsenstärke einbeziehen, die dann für die Zeiss CT Lucia 621 – eine monofokale, asphärische Linse mit hydrophobem C-Loop-Design, die in den Kapselsack des Auges implantiert wird – und derzeit 12 weitere IOLs zur Verfügung steht. (Kastentext: Ute Häußler) |

Datenaufbereitung

In dieser Phase werden die gesammelten Rohdaten in ein Format gebracht, das für das Training und die Validierung des Modells geeignet ist.

Ein wesentlicher Aspekt der Datenaufbereitung ist die Datenbereinigung. Hierbei werden fehlerhafte Einträge korrigiert, Duplikate entfernt und fehlende Werte behandelt. Diese Schritte sind notwendig, um die Konsistenz und Genauigkeit der Daten sicherzustellen, da unbereinigte Daten die Leistung des Modells erheblich beeinträchtigen können.

Ein weiterer wichtiger Schritt ist die Datenanreicherung, bei der zusätzliche Informationen oder Kontextdaten hinzugefügt werden, um die Daten für das Modell aussagekräftiger zu machen. Dies kann durch die Integration von Metadaten oder durch die Anwendung von Techniken wie Datenaugmentation erfolgen, bei denen die Daten durch Transformationen erweitert werden.

Schließlich sollte die Dokumentation der Datenaufbereitungsprozesse nicht vernachlässigt werden. Eine umfassende Dokumentation ermöglicht die Nachverfolgbarkeit und Transparenz der Datenverarbeitung und ist entscheidend für die Einhaltung von regulatorischen Anforderungen und für die spätere Analyse und Validierung der Modellleistung.

Datenannotation

Die Datenannotation beschriebt das Kennzeichnen, Markieren oder Beschriften von Rohdaten wie Bildern, Texten, Videos oder Audiodateien mit spezifischen Informationen oder Labels. Dieser Prozess ist ein weiterer entscheidender Schritt bei der Vorbereitung von Daten für die Entwicklung von KI-Modellen, insbesondere im Bereich des maschinellen Lernens. Zunächst ist es wichtig, dass die Annotation präzise und konsistent erfolgt. Dies bedeutet, dass die annotierenden Personen klare Richtlinien und Standards erhalten sollten, um sicherzustellen, dass die Annotationen einheitlich und nachvollziehbar sind. Eine klare Definition der Labels, die verwendet werden sollen, ist unerlässlich, um Missverständnisse und Inkonsistenzen zu vermeiden.

Ein weiterer wichtiger Aspekt ist die Schulung der Annotatoren. Die Personen, die für die Annotation verantwortlich sind, sollten über das notwendige Fachwissen und die erforderlichen Fähigkeiten verfügen, um die Daten korrekt zu kennzeichnen. Dies kann durch Schulungsprogramme und regelmäßige Überprüfungen der Annotationsergebnisse unterstützt werden.

Das Ergebnis dieses Schrittes ist die Annotierungsrichtlinie und die annotierte Datenbank.

Datenaufteilung

In dieser letzten Phase werden die gesammelten und vorbereiteten Daten in drei Hauptkategorien unterteilt: Trainingsdaten, Validierungsdaten und Testdaten. Es wird spezifiziert, wie die Daten aufgeteilt werden. Die Dokumentation muss eine Begründung für die folgenden Punkte enthalten:

- Aufteilungsmethoden

- Aufteilungsbasis

- Datenverteilung und Datenverteilungsverhältnis: Es muss sichergestellt werden, dass die Verteilung ausgewogen ist.

- Grad der Unabhängigkeit der Datensätze

Testdaten sind ein Datensatz, der von Trainings- und Validierungsdaten ausgeschlossen ist. Die Testdaten werden genutzt, um die endgültige Leistung des Modells zu bewerten, nachdem es trainiert wurde. Diese Daten sollten vollständig unabhängig von den Trainings- und Validierungsdaten sein, um eine realistische Einschätzung der Modellgenauigkeit zu gewährleisten. Das Ergebnis dieses letzten Schrittes sind drei Datenbanken (Training, Validierung und Test) sowie die Dokumentation.

KI-Daten: Komplex, aber unerlässlich

Die Erfüllung der Datenanforderungen für KI-Entwicklungen ist ein komplexer, aber entscheidender Prozess. Durch die sorgfältige Auswahl und Verarbeitung von Trainings-, Validierungs- und Testdaten kann die Leistung von KI-Modellen erheblich verbessert werden. Eine systematische Herangehensweise an die Datensammlung, -aufbereitung, und -aufteilung ist unerlässlich, um robuste und effektive KI-Lösungen zu entwickeln.