Dev-Tool gegen KI-Halluzinationen

Medizin-KI? Aber sicher!

Künstliche Intelligenz kann das Gesundheitswesen deutlich entlasten. Doch KI-Systeme sind inhärent mit Unsicherheiten verbunden. Der »Uncertainty Wrapper« des Fraunhofer IESE hilft, diese zu quantifizieren und zu minimieren und ermöglicht damit eine zuverlässige Nutzung von KI in der Medizin.

Mehr als die Hälfte der angestellten Ärzte in Deutschland fühlt sich derzeit überlastet. Zu diesem Ergebnis kommt eine aktuelle Studie des Marburger Bundes. Es brauche entsprechend dringend Ansätze, die Arbeit im Gesundheitswesen wieder aufzuwerten. Abhilfe können KI-Systeme schaffen. Schon heute werden Prävention, Diagnose und Therapie vereinzelt durch die Technologie unterstützt. Gleichzeitig erfordert ein sicherheitskritischer Sektor wie das Gesundheitswesen einen verantwortungsvollen Umgang mit KI-Systemen. Je breiter diese eingesetzt werden und je autonomer sie arbeiten sollen, desto wichtiger ist es, ihr Risiko zu beherrschen und Fehlverhalten seitens der KI zu vermeiden. Denn ein schlechtes Unsicherheitsmanagement kann im schlimmsten Fall fatale Folgen haben.

KI ist immer mit Unsicherheiten verbunden

Datengetriebene KI-Modelle basieren nicht auf Spezifikationen und Code eines Entwicklers, sondern werden auf Basis von Datensätzen trainiert. Die KI versucht anhand dieses Ausschnitt aus der Realität, Muster zu erlernen und diese Muster dann auf neue Eingaben anzuwenden. Damit bringen KI-Modelle immer ein gewisses Maß an Unsicherheit mit sich. Stellt eine KI zum Beispiel auf Grundlage von MRT-Bildern erste Vorschläge für Diagnosen, sind diese Ausgaben je nach Qualität der Bilder und Güte des zugrundeliegenden Modells unterschiedlich verlässlich. Die Quantifizierung von Unsicherheit ist in einem solchen Kontext also gewöhnlich die begründbare Abschätzung der Wahrscheinlichkeit, dass sich das Modell irrt.

Im Zusammenhang mit KI unterscheidet man drei Arten von Unsicherheit:

Die modellgütebezogene Unsicherheit beschreibt die inhärente Unsicherheit in den Ausgaben durch Modellierung und Approximation.

- Die eingabequalitätsbezogene Unsicherheit ergibt sich aus qualitativen Defiziten in den aktuellen Eingabedaten, die die Unsicherheit in der Ausgabe erhöhen.

- Die anwendungskonformitätsbezogene Unsicherheit beschreibt, ob das Modell innerhalb des Geltungsbereichs angewendet wird, für den es trainiert und validiert wurde.

- Mit effektivem Unsicherheitsmanagement ist es möglich, die genannten Unsicherheiten in KI-Modellen und -Ergebnissen systematisch zu identifizieren, quantifizieren und reduzieren.

Ansätze zur Quantifizierung von Unsicherheit

Doch die Unsicherheit einer Modellausgabe tatsächlich zu quantifizieren, ist nicht trivial. Ein Ansatz von Blackbox-Modellen, zu denen tiefe neuronale Netze wie auch generative KI-Modelle zählen, ist es, zusätzlich zur eigentlichen Ausgabe eine Unsicherheitsschätzung mitzuliefern. Stammt diese jedoch aus dem Blackbox-Modell selbst, ist sie nicht nachvollziehbar. Zudem unterschätzt ein solcher Ansatz die Unsicherheit in der praktischen Anwendung häufig systematisch, da die Unsicherheitsschätzungen ausschließlich auf der Erfahrung des Modells mit den Trainingsdaten beruhen.

Die vom Modell selbst ausgegebenen Wahrscheinlichkeiten sind entsprechend im Regelfall nicht empirisch belegt. Eine verlässliche Unsicherheitsaussage bedarf jedoch einer statistischen Begründung, für die insbesondere bei kritischen Anwendungen ein Konfidenzniveau festzulegen ist. Ein entsprechendes Konfidenzniveau reduziert hierbei die Wahrscheinlichkeit, dass die inhärente Zufälligkeit in der Datengrundlage zu einer Unterschätzung der Unsicherheit führt.

Das Uncertainty Wrapper Framework

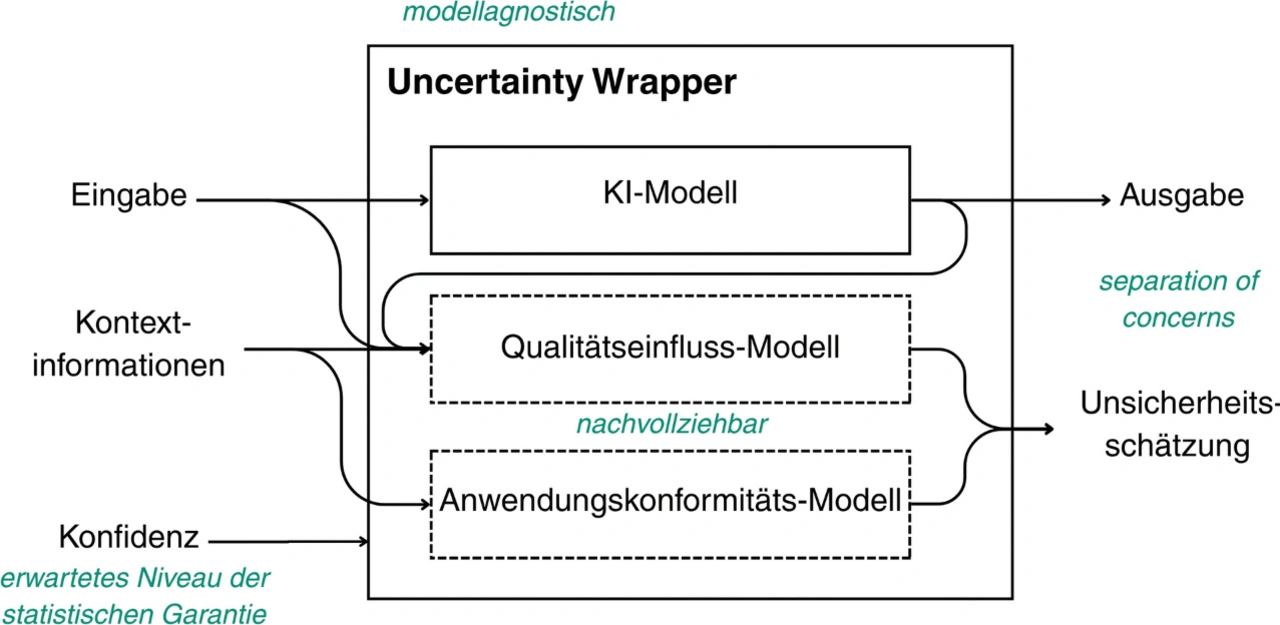

Das Fraunhofer-Institut für Experimentelles Software Engineering IESE hat mit dem Uncertainty Wrapper (Bild 1) eine Lösung entwickelt, die für ein gegebenes KI-Modell modellagnostisch Unsicherheitsschätzungen liefert. Der Uncertainty Wrapper erfordert also keinen direkten Einblick in das Modell und lässt sich so in unterschiedlichsten KI-Systemen anwenden. Er wird über ein Python-Framework implementiert, das für die konkrete Anwendung instanziiert wird.

Ein weiterer Vorteil des modellagnostischen Ansatzes ist, dass die Unsicherheitsschätzungen, die ein solcher Uncertainty Wrapper abgibt, unabhängig davon sind, wie das Modell zu seiner Ausgabe kommt. Damit erfüllt er eine sogenannte »separation of concerns«: Das KI-Modell ist dafür zuständig, möglichst gute Ausgaben zu liefern, während der Uncertainty Wrapper möglichst verlässliche Unsicherheitsschätzungen für diese Ausgaben berechnet. Dafür stützt sich der Uncertainty Wrapper nicht nur auf die Eingaben, die das Modell nutzt, sondern bezieht weitere Informationen ein. Diese Kontextinformationen werden je nach Anwendung und Modell bei der Instanziierung individuell aufgesetzt und können beispielsweise Auflösungsparameter, Rauminformationen oder erweiterte Patientendaten enthalten.

Eingabequalität und Anwendungskonformität

Zusätzlich lassen sich die Berechnungen des Uncertainty Wrappers – im Gegensatz zu den Ausgaben der KI – menschlich nachvollziehen. Im Qualitätseinfluss-Modell wird dargestellt, warum die Unsicherheit der Ausgabe in welcher Höhe angegeben wird. Faktoren und Entscheidungsgrenzen, die in die Unsicherheitsbewertung einfließen, werden für den Nutzer möglichst verständlich aufbereitet und typischerweise in Pfaden entlang eines Entscheidungsbaums dargestellt. Die zuvor empirisch erhobene Qualität der Modellausgaben und die geforderte Konfidenz bestimmen dann nachvollziehbar die Höhe der aufgrund der Eingabequalität adjustierten Unsicherheit.

Getrennt davon erfasst der Uncertainty Wrapper die Unsicherheit bezüglich der Anwendungskonformität. Diese zweite Komponente des Frameworks berechnet die Wahrscheinlichkeit, mit der das Modell außerhalb seines intendierten Anwendungskontextes eingesetzt wird. Wenn das KI-Modell und der Uncertainty Wrapper etwa ausschließlich auf Patientendaten aus China trainiert und kalibriert wurden, bei der Anwendung aber erkannt wird, dass das Modell aktuell für Patienten in Deutschland genutzt wird, fließt dies in die Unsicherheitsbewertung ein. Die Berechnungen zur anwendungskonformitätsbezogenen und zur eingabequalitätsbezogenen Unsicherheit führt der Uncertainty Wrapper zuletzt zur individuellen Unsicherheitsausgabe zusammen.

Unsicherheit vermeiden und managen

Der Uncertainty Wrapper kann grundsätzlich zu zwei Zeitpunkten eingesetzt werden. Wird er bereits im Entwicklungsprozess einer KI eingebunden, kann er helfen, die Schwächen eines Modells zu identifizieren. Diese lassen sich dann durch Maßnahmen gezielt adressieren. Konstellationen, in denen besonders viele Unsicherheiten auftreten, können mit zusätzlichen Trainingsdaten gestärkt oder aus der Anwendung des Modells explizit ausgeschlossen werden. Letzteres kann wiederum in die Software integriert werden, etwa durch die Programmierung eines entsprechenden Warnhinweises.

Wird der Uncertainty Wrapper in der späteren Anwendung des KI-Systems eingesetzt, ermöglicht er eine Abschätzung der Unsicherheit der einzelnen Modellausgaben. Diese Einschätzungen können beispielsweise von einem Sicherheitscontainer verwendet werden, um die KI zu übersteuern und das System in einen risikoärmeren Zustand zu überführen oder um zusätzliche Informationen anzufordern. Alternativ kann die Unsicherheitsbewertung dem Nutzer auch als prozentuale Angabe oder visuelle Markierung in einer Grafik bereitgestellt werden, um eine fundierte Entscheidungsfindung durch den Nutzer zu unterstützen.

| Kurz erklärt: DIN SPEC 92005 |

|---|

| Als Vorstufe einer Norm legt die DIN SPEC 92005 seit März 2024 die Terminologie von Unsicherheit im Machine Learning fest, klassifiziert Unsicherheitsquellen und stellt Anforderungen an die Unsicherheitsquantifizierung auf. Zurzeit wird die Standardisierung der Unsicherheitsquantifizierung von KI-Modellen auf internationaler Ebene mit der ISO/IEC AWI TS 25223 weiterverfolgt. |

Verlässliche KI im Gesundheitswesen

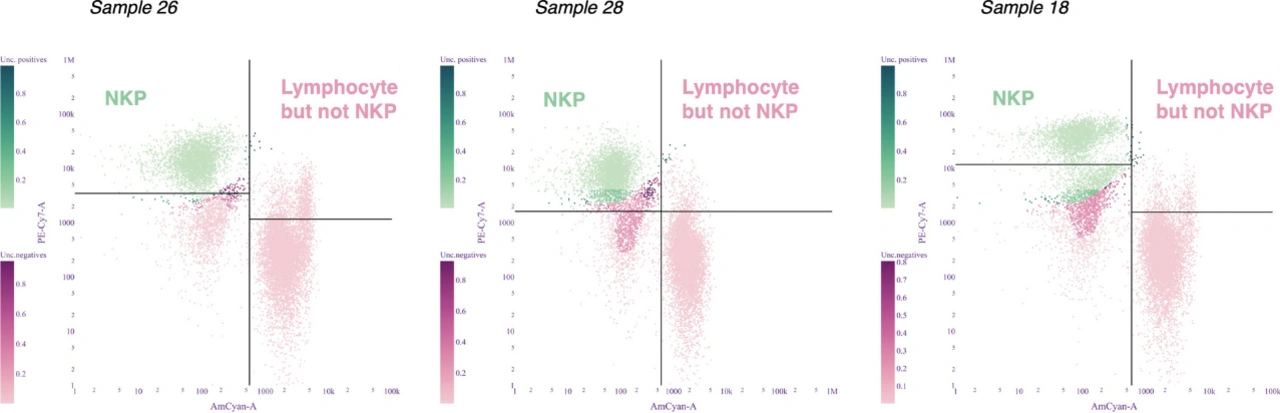

Mit einer Unsicherheitsquantifizierung bekommt medizinisches Fachpersonal belastbare Indikatoren angezeigt, inwieweit es sich auf die Ausgabe einer KI verlassen kann. Ein Beispiel zum Einsatz des Uncertainty Wrappers bei der KI-basierten Auswertung von Durchflusszytometrien: Bei diesen werden Partikel mit Antigen-basierten Farbstoffen gefärbt, mit entsprechenden Lichtstrahlen beschossen und deren Reflektion vermessen. Die Ergebnisse werden Clustern und in der Folge unterschiedlichen Zelltypen zugeordnet. Somit ist beispielsweise ein Rückschluss auf die Anzahl der Leukozyten in einer Probe und dem Anteil natürlicher Killerzellen (NK) an diesen möglich.

Erfolgt die Analyse mithilfe einer KI, werden die Ergebnisse der Vermessung in einem Diagramm ausgegeben. Die durch das Modell prognostizierten Zelltypen werden mittels unterschiedlicher Farben differenziert. Der Uncertainty Wrapper markiert hierbei durch die Farbintensität, welche Ausgabepunkte mit größerer Unsicherheit behaftet sind (Bild 2). Je dunkler die Ausgabepunkte erscheinen, desto höher ist deren Unsicherheit. Zur besseren Verständlichkeit wurden in der Grafik mittels schwarzer Linien zusätzlich die vom Fachpersonal normalerweise händisch gesetzten Grenzen eingezeichnet.

In den Diagrammen weisen insbesondere unklare oder vom Modell falsch zugeordnete Bereiche eine erhöhte Unsicherheit auf. Damit kann dem Anwender eine schnell zu erfassende Entscheidungshilfe bereitgestellt werden, wann eine durch KI geclusterte Laboruntersuchung wiederholt oder händisch interpretiert werden sollte. Der Ansatz kann somit helfen, durch die Automatisierung Zeit einzusparen und gleichzeitig eine hinreichende Verlässlichkeit sicherzustellen.

Das Potenzial von Unsicherheitsschätzungen

Eine weitere Anwendung des Uncertainty Wrappers im Gesundheitswesen entsteht zurzeit im Rahmen des Forschungsprojekts »FHIR-Starter« des Fraunhofer IESE in Zusammenarbeit mit der Charité Berlin und Insiders Technologies. Ziel des Projekts ist die Entwicklung einer Software, die unstrukturierte Daten – beispielsweise aus Volltext-Arztbriefen – mithilfe einer auf großen Sprachmodellen beruhenden KI im FHIR-Standard strukturiert. Dies soll zum einen die Datenpflege in Arztpraxen und Krankenhäusern vereinfachen und zum anderen Daten für die medizinische Forschung zugänglich machen. Die Aufgabe des Uncertainty Wrappers hierbei ist insbesondere, mögliche Unsicherheiten bereits im Entwicklungsprozess aufzudecken und so die Verlässlichkeit der Software zu optimieren.

Auch in der KI-gestützten Auswertung von CT-Aufnahmen ließe sich der Uncertainty Wrapper einsetzen, um Ausgaben mit individuellen Unsicherheitsbewertungen zu versehen. Neben der automatisierten Bildauswertung sind ebenfalls komplexere Einsatzfelder für den Uncertainty Wrapper denkbar, beispielsweise in der roboterassistierten Chirurgie. Insbesondere auf diesem Gebiet gilt: Je kritischer die Anwendung, desto wichtiger ist ein verlässliches Unsicherheitsmanagement. Denn unabhängig davon, wie gut eine KI oder Machine-Learning-basierte Anwendung ist, Verlässlichkeit umfasst immer auch eine nachvollziehbare Unsicherheitsquantifizierung. Nur so können medizinisches Fachpersonal auf der einen und Patienten auf der anderen Seite KI-Anwendungen vertrauen – auf diese Weise kann auch das Potenzial, das künstliche Intelligenz im Gesundheitswesen bietet, verantwortungsvoll ausgeschöpft werden. (uh)