Edge-KI ausliefern, updaten, betreiben

»Wir bieten die Software-Umgebung für Edge-KI«

Embedded-KI verbreitet sich in der Industrie. Doch wie lassen sich KI-Modelle – ggf. mit Hilfe der Cloud – an die Edge ausliefern und dort aktuell halten und betreiben? Johannes M. Biermann, President & COO von aicas, erklärt, wie es funktioniert, und beschreibt die Lösung, die aicas dafür anbietet.

Elektronik: Wie lassen sich KI- und ML-Modelle trainieren und implementieren?

Johannes M. Biermann: Modellbasierte künstliche Intelligenz beruht auf der Erzeugung eines Systems komplexer Algorithmen, die automatisiert Muster erkennen, Vorhersagen machen oder sogar selbstständig Entscheidungen treffen sollen. Ein weit verbreiteter Ansatz ist dabei das überwachte (supervised) Training als Methode des Machine Learning (ML), angewendet auf ein künstliches neuronales Netz (ANN). Training und Anwendung eines solchen Modells haben dabei grundlegend unterschiedliche Anforderungen:

Für das Training, besonders das erste Training, ist es wichtig, viele und qualitativ hochwertige Daten aus dem vorgesehenen Anwendungsfall bereitzustellen. Je besser, das heißt umfassender und gründlicher, die Daten den Anwendungsfall in allen möglichen Umwelt- und Systemzuständen abbilden, desto besser und effizienter wird das Modell funktionieren.

Das Training erfolgt deshalb üblicherweise zentral in der Cloud oder im Rechenzentrum. Dort stehen die notwendigen Rechenressourcen und Tools zur Verfügung, um Modelle mit realitätsnahen, domänenspezifischen Datensätzen zu entwickeln. Nach Abschluss des Trainings werden die Modelle dann in ihre Zielgeräte an der Edge übertragen, wo sie zur Inferenz eingesetzt werden.

Bei der Anwendung, im sogenannten Inferenzschritt, bei dem das Modell auf Basis eines Eingangsdatenstroms eine Einschätzung oder Entscheidung treffen soll, ist es – je nach Applikation – wünschenswert bis kritisch, dass die Ausführung schnell oder zeitgerecht stattfindet.

aicas legt bei KI-Lösungen deswegen besonderes Augenmerk auf:

• die initiale Sammlung guter Trainingsdaten;

• die sichere Datenübertragung vom Zielgerät an der Edge zum Trainingssystem in der Cloud oder im kundenprivaten Rechenzentrum;

• die sichere Übertragung des Modells und der KI-Anwendung, die das Modell benutzt, aus der Entwicklung von der Cloud oder dem Rechenzentrum zum Zielgerät;

• die überwachte Steuerung und Ausführung der KI-Anwendung und des Modells im Zielgerät, und zwar besonders unter Echtzeit-Gesichtspunkten;

• die kontinuierliche Wartung, Verbesserung und Erweiterung des Systems durch operative Datensammlung und Software-Updates.

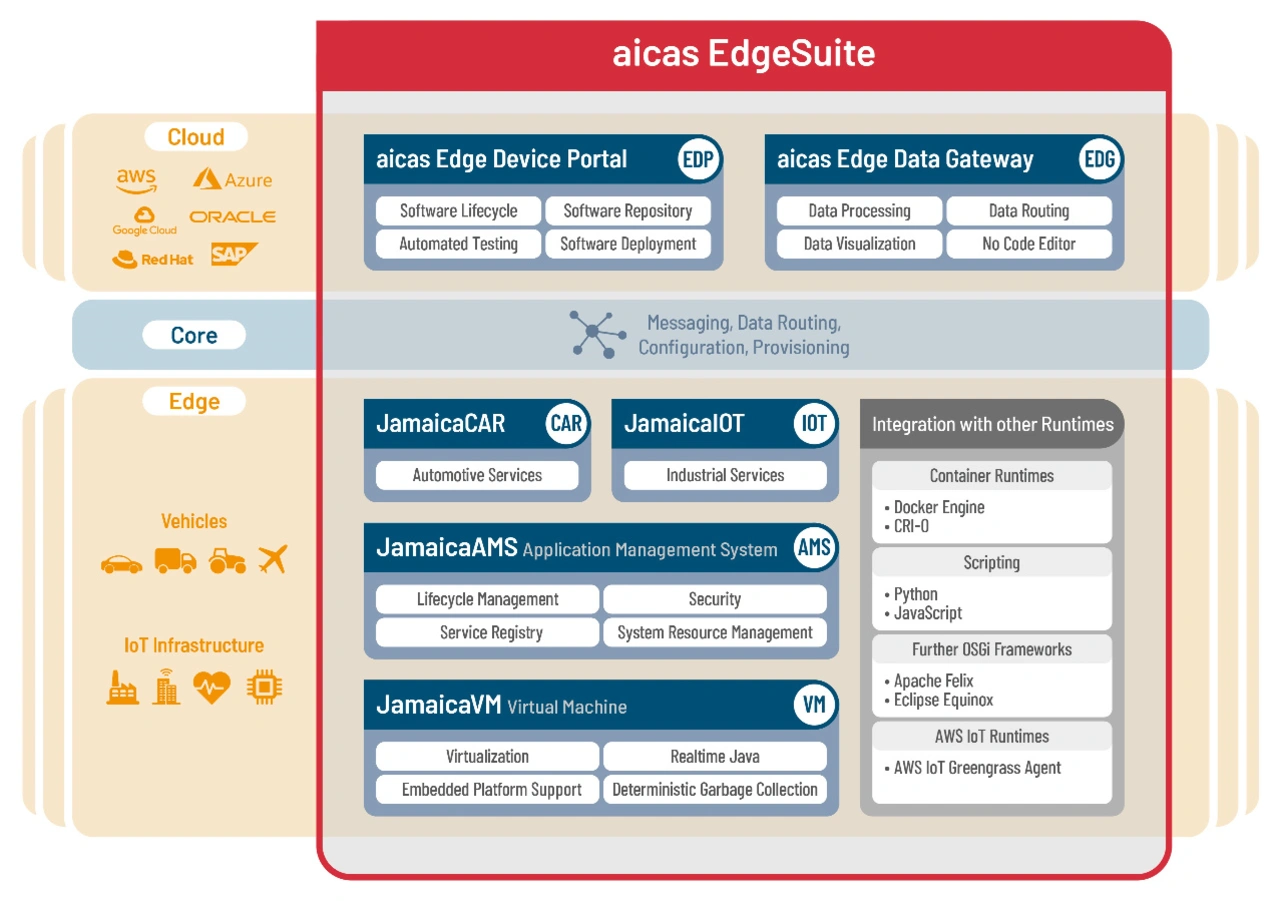

Bei aicas erfolgt dies mithilfe der modularen Plattform »EdgeSuite«. Die Runtime-Umgebung »JamaicaAMS«, ergänzt durch ein webbasiertes und nutzerfreundliches Interface zum Daten- und Software-Management, ermöglicht eine feingranulare Kontrolle und Isolierung von Komponenten. Modelle lassen sich einzeln ausliefern, aktualisieren oder zurücksetzen.

Mögliche Anwendungsfälle sind dabei modellbasierte Prädiktion für Fahrverhalten, Abnutzung, Temperatur oder Batteriezustand, um Fernwartung und vorsorgliche Instandhaltung (Predictive Maintenance) und datenzentrische Anwendungen über Geräte- und Fahrzeugflotten hinweg zu ermöglichen.

Welche Hard- und Software ist dafür erforderlich?

Wie oben beschrieben sind die Anforderungen für das Training einerseits und die Ausführung andererseits deutlich verschieden:

Für das Training von ML-Modellen werden regelrechte Hardware-Farmen eingesetzt. Cloud-Anbieter wie aicas‘ Partner AWS bieten Services zur Erzeugung eigener Modelle. Inzwischen gibt es jedoch zusätzlich auch ein Ecosystem vortrainierter Modelle, die bestimmte Aufgaben, etwa die Texterkennung zur Eingabe natürlicher Sprache, schon generell erfüllen und dann nur noch an den speziellen Anwendungsfall angepasst werden müssen als Services und als Open-Source-Komponenten. Zusammenfassend ist festzuhalten, dass das Training üblicherweise mehr Ressourcen erfordert, als in einem üblichen Entwicklersystem oder gar »an der Edge« zur Verfügung stehen.

Dort, an der Edge, wo das Modell zum automatischen Folgern genutzt wird, liegt der Schwerpunkt der heutigen Entwicklung auf spezialisierter Hardware:

Ein leistungsfähiger Chip, etwa der Vehicle Network Processor S32G3 von aicas‘ Partner NXP, wird mit Chips ergänzt, die auf die Ausführung neuronaler Netzwerke und die dabei notwendigen Matrizenmultiplikationen spezialisiert sind. Dies sind häufig Rechenkerne, wie sie auch in Grafikkarten zum Einsatz kommen.

Der Hauptprozessor übernimmt dabei die Aufgabe, den Eingangsdatenstrom zum Modell zu bringen, die Ausführung (Inferenz) zu überwachen, das Ergebnis der Inferenz abzuholen und die Anwendungslogik zur Ausführung zu bringen, so dass das System entsprechend dem erwünschten Verhalten reagiert.

Zusätzlich wird dort die generelle Funktion des Systems gesteuert und verwaltet, was hier besonders die Verwaltung und die Aktualisierung von Anwendungen, die Fernsteuerung und das Bereitstellen von Daten zur Kontrolle und Analyse für mögliche Verbesserungen umfasst.

Dafür ist eine Runtime-Umgebung wie JamaicaAMS entscheidend, die auf der Edge-Geräte-Ebene Modularität, Updatefähigkeit und Stabilität gewährleistet. Darüber hinaus bietet das cloudbasierte aicas Edge Device Portal (EDP) eine zentrale Instanz zur Verwaltung von Modellen, Updates und Gerätestatus – auch bei großen, heterogenen Flotten. Die Lösung integriert sich auf der Cloud-, Server- und Backend-Seite nahtlos in bestehende DevOps- und CI/CD-Pipelines und unterstützt eine kontinuierliche Wartung und Erweiterung des Zielsystems im laufenden Betrieb.

Jobangebote+ passend zum Thema

Inwieweit ist es sinnvoll, KI- und ML-Anwendungen auf Edge und Cloud zu verteilen?

Wie schon erläutert, haben Training und Inferenz grundlegend unterschiedliche Anforderungen; insofern ist eine Aufteilung dort in den allermeisten Fällen zu bevorzugen.

Zusätzlich zur zentralen Steuerung in der Cloud ergeben sich weitere Vorteile bei der Zusammenführung mehrerer Edge-Systeme zu einer übergreifenden Instanz: Daten mehrerer Zielsysteme, die in einem Kontext jedoch unter verschiedenen Umwelt- und Systemzuständen gesammelt wurden, lassen sich miteinander vergleichen und zum Training verwenden. Zudem gibt es interessante Ansätze föderativen Lernens, bei dem Daten sogar über Unternehmensgrenzen hinweg geteilt werden, um ein gemeinsames Ziel zu erreichen.

Interessanter und Gegenstand aktueller Forschung ist die Aufteilung des Systems, das die Schätzungen, Folgerungen (Inferenz) und Aktionen im laufenden Betrieb vornimmt, selbst: Gerade für ressourcenbeschränkte Geräte ist für manche Anwendungsfälle ein hybrider Ansatz interessant, bei dem ein kleines Edge-KI-System einen »ich-muss-jemand-anderes-fragen«-Zustand kennt und dann mit einem größeren KI-System kommuniziert, das in einem zentralen, leistungsstärkeren System oder in der Cloud läuft.

Grundsätzlich geht es darum, die in hochskalierbaren Cloud-Infrastrukturen durch Training erworbenen Erkenntnisse in Entscheidungen auf der Edge-Ebene, etwa von Aktuatoren oder Sensoren, optimiert umzusetzen. Umgekehrt – Edge-to-Cloud – sollten Erkenntnisse und Beobachtungen auf Edge-Geräte-Ebene schneller und umfassender in die Cloud transferiert werden können mit dem Ziel, diese Daten in fortlaufendes Training in den AI-Cloud-Data-Centern einzubringen.

Wie lässt sich eine solche Verteilung bewerkstelligen?

Mit der aicas EdgeSuite lassen sich Modelle als isolierte Komponenten verpacken, versionieren und gezielt verteilen. Über das Edge Device Portal werden Modelle und Anwendungen an definierte Zielsysteme ausgeliefert. Die Steuerung dessen erfolgt automatisiert oder zustandsbasiert – beispielsweise nur an Fahrzeuge mit bestimmten Eigenschaften: einer bestimmten Firmware oder ab einem bestimmten Softwarestand.

Der gesamte Updateprozess ist verschlüsselt, signiert und überwachbar. Kunden können aus übertragenen Feedbackdaten zur Modellleistung, etwa zur Genauigkeit oder zum Ressourcenverbrauch, Aktionen und Folgeversionen ableiten. Der Updateprozess ist darauf ausgelegt, ohne Betriebsunterbrechung eines operativen Systems und Prozesses abzulaufen und Integrität, Sicherheit und Rückverfolgbarkeit jederzeit sicherzustellen.

Welche Aspekte von KI- und ML-Anwendungen sollten eher an der Edge, welche eher in der Cloud laufen?

An der Edge sollten vor allem Inferenzprozesse stattfinden, die eine lokale, schnelle und zuverlässige Reaktion erfordern oder Daten aus Datenschutzgründen lokal halten sollen. Dazu gehören beispielsweise Echtzeiterkennung von Anomalien, Zustandserkennung an Maschinen oder Bildauswertung im Fahrzeug. Diese Aspekte treffen übrigens gleichermaßen zu in kommerziellen (z.B. Industrieanlagen) und öffentlichen (Stichwort: Smart City) bis hin zu militärischen Anwendungen (Beispiel: Drohnen) – Bereiche, in denen aicas überall bei Kunden tätig ist.

In der Cloud hingegen können Aufgaben wie Training, Datenvor- und -aufbereitung, auch als Datenaggregation über mehrere Geräte oder als Cross-Fleet-Analyse und Simulation laufen. Besonders nützlich ist die Cloud auch für weiter übergreifende Optimierungen. Etwa, wenn ein Flottenbetreiber das Verhalten von Modellen über verschiedene Standorte oder Nutzungsszenarien hinweg analysiert.

Wie könnten und sollten entsprechende Edge-Cloud-Architekturen aussehen?

Die Anforderungen an eine robuste Edge-to-Cloud-Architektur sind:

• einheitliche, standardisierte Datenmodelle, etwa die Vehicle Signal Specification VSS der COVESA;

• selbsterklärende, plattformübergreifende Datenlösungen - Beispiel: EDG mit JamaicaIOT;

• sichere Edge-Systeme - Stichworte: Hardware Security als Root und eine Chain of Trust, die in der Sicherheitsarchitektur des Nutzers verankert ist;

• sichere Kommunikationskanäle - in der Sicherheitsarchitektur des Nutzers verankert, etwa in Form einer Public-Key-Infrastruktur und damit Authentifizierung aller Hardware- und Software-Komponenten;

• robustes Lifecycle-Management für Anwendung und Modelle - Beispiel: EDP mit JamaicaAMS. Versionsverwaltung, authentifizierte Komponenten, rollenbasierte und einschränkende Zugriffsregeln;

• eine modulare Softwareplattform, mit handelsüblichen, standardisierten Schnittstellen, die heterogene Systeme überbrücken kann. Beispiel: JamaicaAMS und JamaicaVM mit den Java-, Realtime Java- und OSGi-APIs.

aicas bietet mit dem Zusammenspiel aus Edge Device Portal, JamaicaAMS und Edge Data Gateway eine komplette Struktur dafür an. Unsere Architektur ist bereits in gemeinsamen Projekten mit AWS und Swissbit zur Anwendung gebracht worden – unter anderem für Condition-Based OTA-Kampagnen in sicherheitskritischen Anwendungen.

Wie lassen sich auf Edge und Cloud verteilte KI- und ML-Anwendungen synchronisieren?

Bei aicas-Anwendungsfällen handelt es sich häufig um sich bewegende Zielsysteme mit unterbrechender Connectivity. Als Beispiel dienen kann ein Auto im Tunnel.

Für die Architektur und das Design solcher Lösungen ist es daher unabdingbar, dass das verwaltende Backend und das entfernte Edge-System mit auseinanderlaufenden Zuständen umgehen können. Dabei lassen sich viele Ansätze aus dem IoT anwenden, anpassen oder übertragen.

Wichtigstes Element ist ein autonomer Software-Agent, der operative Funktionen auch ohne Verbindung zum Backend ausführen kann und dafür sorgt, dass eine Synchronisation stattfindet, sobald die Verbindung wieder besteht. Der Agent trägt auch dazu bei, die Anforderungen umzusetzen, die an die Robustheit während des Software-Updates gestellt werden.

Ergänzt wird das bei aicas-Lösungen durch eine geschickte Paketierung, die die Authentifizierung, aber auch die Autorisierung zur Nutzung eines Pakets für bestimmte Anwender in einem bestimmten System ermöglicht, durch Versionsverwaltung und durch »Live-Bill-of-Material«-Auflistungen aller Komponenten des Systems.

Schließlich setzt aicas eine leichtgewichtige Virtualisierung im Zielsystem ein, die verhindert, dass Softwarekomponenten willentlich oder unwillentlich das System lahmlegen, und zugleich den Einsatz vielfältiger und mächtiger Debugging-Tools für die Entwickler des Systems ermöglicht, auch dies als Ferndiagnose »von remote«.

Welche Lösungen bietet aicas für Implementation und Anwendung von KI- und ML-Modellen an Edge und Cloud?

aicas bietet eine modulare Komplettlösung: Über das Edge Device Portal lassen sich (KI-)Modelle und Anwendungen verwalten, versionieren und sicher ausliefern. Die Runtime-Umgebung JamaicaAMS stellt sicher, dass die Anwendungen isoliert, flexibel und fehlertolerant in Embedded-Geräten laufen, also an der Edge. Das Edge Data Gateway unterstützt bei der intelligenten Datenauswahl, -Visualisierung und -Vorverarbeitung zum Machine Learning.

Ein Beispiel aus der Praxis ist unsere Zusammenarbeit mit Swissbit: Hier kommt die aicas EdgeSuite zum Einsatz, um vortrainierte KI-Modelle robust und sicher zu verteilen – inklusive verschlüsselter Updates, dem Root of Trust in einem physischen Speicherelement (Secure Element) und »Live«-Statusrückmeldungen. Das Projekt zeigt, wie sichere Verteilung in einem Anwendungsfall für verteilte KI in sicherheitskritischen Anwendungen zuverlässig umgesetzt werden kann.

Wie lassen sich KI- und ML-Modelle an der Edge aktualisieren?

Modelle werden wie Software-Komponenten über das Edge Device Portal verteilt. Das System überprüft Signatur, Zielgerät, Kompatibilität und Berechtigungen automatisch. Die Lösung ist so ausgelegt, dass Aktualisierungen ohne Betriebsunterbrechung erfolgen und gegen Manipulation sowie Fehlfunktionen abgesichert sind.

Welche Software-Tools sind dafür notwendig?

Benötigt werden JamaicaAMS im Zielsystem als modulare Ausführungsumgebung, Edge Device Portal als Software-Management- und -Verteilungsplattform und optional die Integration in MLOps-Pipelines mit CI/CD, etwa über Jenkins, GitLab Pipelines oder AWS CodePipeline.

Darüber hinaus unterstützt aicas den Einsatz etablierter ML-Tools wie Keras/TensorFlow, Python-basierter Frameworks und kundenspezifischer Mechanismen zur Überwachung der Ausführung und Modellqualität im Feld.

Was ist dabei in puncto Safety und Security zu beachten?

Generell, aber besonders in regulierten Branchen wie Automotive oder Medizintechnik, ist es essenziell, dass Modell- und Software-Updates robust, sicher, transparent und nachvollziehbar erfolgen. aicas setzt dabei auf standardisierte State-of-the-Art-Security-Mechanismen, unter anderem:

• Integration der aicas-Edge-Komponenten in eine Chain-of-Trust;

• TLS-verschlüsselte Kommunikation mit beidseitiger Authentifizierung in einer vom Kunden verwalteten Public-Key-Infrastruktur;

• Signaturprüfung zur Validierung, Authentifizierung und Autorisierung aller (Software-)Pakete;

• gezieltes und sicheres Logging und Reporting aller Updateprozesse;

• statische und dynamische Beschreibungen des Systems zum kontinuierlichen Abgleich und zur Missbrauchserkennung;

• kontinuierliches (CVE) Screening der aicas-Softwarekomponenten und ihrer Abhängigkeiten.

Unser Ansatz schützt nicht nur vor unautorisierten Zugriffen und Manipulationen, sondern stellt auch die Betriebsstabilität sicher. Der Schutz sensibler Modelldaten während Übertragung und Speicherung ist durchgängig gewährleistet.

Wie sieht die Lösung von aicas dafür aus?

aicas bietet ein geschlossenes System für das sichere, skalierbare und kontrollierte Ausliefern und Betreiben von KI-Modellen an der Edge. Durch den komponentenbasierten Ansatz lassen sich Updates sicher in isolierten Umgebungen ausführen. Kombinationen mit Hardware-Security-Modulen, wie im Swissbit-Use-Case, befähigen das System für besonders sicherheitskritische Anwendungen. Die Echtzeitfähigkeiten von aicas‘ JamaicaVM machen das System für zeitkritische Anwendungen einsetzbar.

Die Lösung stellt dabei nicht nur sicher, dass ein KI-System robust betrieben werden kann, sondern auch, dass es während seines Lebenszyklus kontinuierlich gepflegt, gesichert und aus realen Betriebsdaten verbessert werden kann. Unsere Lösung schützt sensible Informationen, integriert sich in bestehende Systeme, Software- und Entwicklungswerkzeuge und liefert operative Transparenz – von der Entwicklung von Code oder dem Training eines Modells bis zur Runtime im Gerät.

Die Fragen stellte Andreas Knoll.