Testen komplexer AD/ADAS-Fahrszenarien

Von der Straße ins Labor

Die Entwicklung sicherer und robuster automatisierter Fahrsysteme für zukünftige Fahrzeuge ist eine komplexe Aufgabe. Welche unmittelbaren Herausforderungen müssen Automobilhersteller beim AD/ADAS-Test bewältigen, um die Zukunft der autonomen Mobilität zu realisieren?

Autonome Fahrzeuge verfügen über Hunderte von Sensoren, die alle innerhalb des Fahrzeugs und mit anderen intelligenten Fahrzeugen in ihrer Umgebung zusammenarbeiten müssen. Die Softwarealgorithmen, die autonomes Fahren ermöglichen, müssen letztlich alle von diesen Sensoren gesammelten Informationen zusammenführen, um sicherzustellen, dass das Fahrzeug angemessen reagiert.

Die Vision vom vollständig autonomen Fahrzeug rückt immer näher, und neben der Verbesserung der Gesamteffizienz von Verkehrssystemen ist die Sicherheit von Fahrern und Passagieren der überzeugendste Vorteil selbstfahrender Fahrzeuge. Jüngsten Daten zufolge könnten selbstfahrende Autos die Zahl der Verkehrstoten um bis zu neunzig Prozent reduzieren (Bild 1) [1,2].

Mehr Autonomie für Fahrzeuge

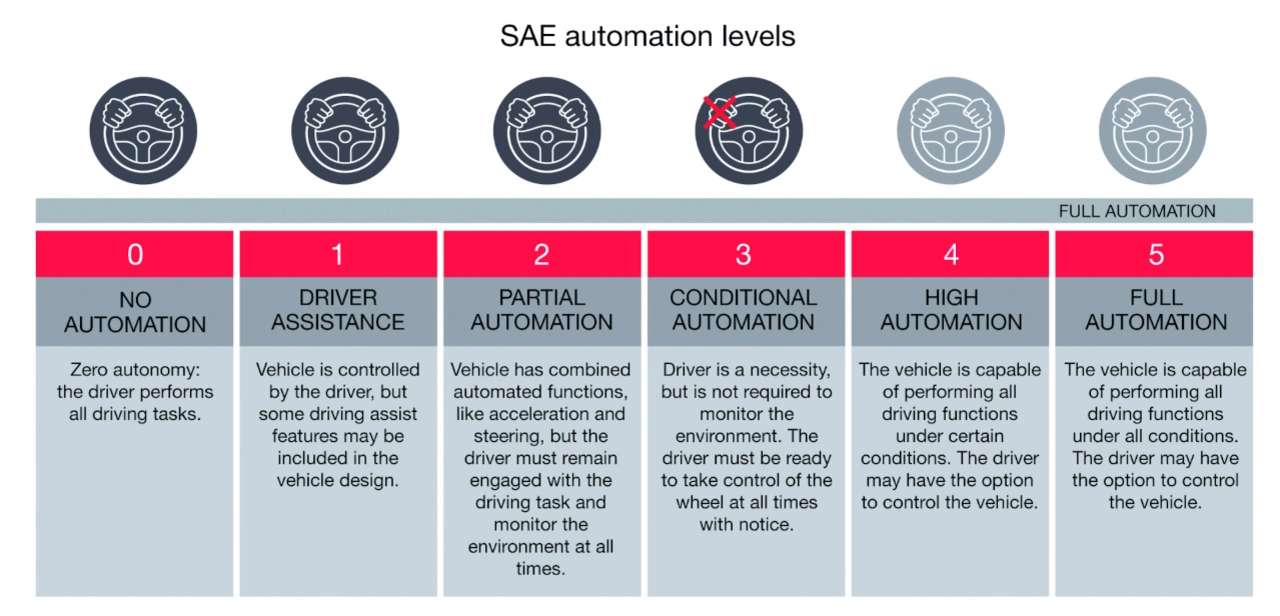

Fortschrittliche Fahrerassistenzsysteme in Serienfahrzeugen haben Level 2 und 3 erreicht, was in den meisten Verkehrssituationen die Steuerung des Fahrzeugs durch den Fahrer erfordert. Viele OEMs und Branchenexperten sind der Ansicht, dass die weitere Entwicklung hin zu den Autonomie-Levels 4 und 5 unsere Straßen sicherer machen wird – wobei Level 5 für Fahrzeuge steht, die keinerlei menschliche Interaktion benötigen (Bild 2).

Um den nächsten Level der Fahrzeugautonomie zu erreichen, sind noch viele Fortschritte erforderlich. Es muss massiv in Sensortechnologien wie Radar, Lidar und Kamera investiert werden, um die Umgebungserfassung weiter zu verbessern. Da jeder Sensortyp seine eigenen Vor- und Nachteile hat, müssen die unterschiedlichen Sensortypen einander ergänzen, um sicherzustellen, dass der Objekterkennungsprozess die erforderliche eingebaute Redundanz aufweist.

Außerdem sind enorme Investitionen in rechenstarke Softwarealgorithmen erforderlich, um die große Menge an hochauflösenden Sensordaten, einschließlich der Eingaben aus der Vehicle-to-Everything-Kommunikation (V2X), zu kombinieren und zu übertragen. Machine Learning ist die etablierte Methode für das Training selbst verbessernder Algorithmen und künstlicher Intelligenz. Diese Algorithmen treffen dann Entscheidungen, um die Sicherheit in komplexen Verkehrssituationen zu gewährleisten. Das Training dieser Algorithmen mit den realistischsten verfügbaren Stimuli in einer reproduzierbaren und kontrollierten Weise im Labor ist entscheidend für ihre Genauigkeit und ihren sicheren Einsatz.

Die Kluft zwischen Straße und Simulation

Heutzutage wird ein großer Teil der Testzeit auf Sensoren und ihre Steuermodule (ECUs) verwendet, indem Umgebungen in Software- oder Software-in-the-Loop-Tests (SIL) simuliert werden. Straßentests des vollständig integrierten Systems in einem Prototyp oder einem Fahrzeug mit Straßenzulassung ermöglichen es den OEMs, das Endprodukt zu validieren, bevor es auf den Markt kommt. Die Nachbildung einer virtuellen Welt im Labor mit einer genauen Wiedergabe der Szenen sowie echten Radarsensoren und -signalen schließt die Lücke zwischen Simulation und Straßentests.

Die Herausforderung besteht heute in der Emulation vollständiger Radarszenen, insbesondere wenn die Szenen komplex sind und viele Variablen enthalten. Ziel ist es, alle Fahrszenarien, auch die Sonderfälle, im Labor gründlich zu testen, bevor das Fahrzeug auf die Teststrecke oder die offene Straße gebracht wird.

Die Softwaresimulation wird in der frühen Entwicklungsphase eingesetzt. Dabei können die zugrunde liegenden Sensoren, die Fahrzeugdynamik und die Wetterbedingungen simuliert werden. Aber reicht das aus? Ist das gut genug, um zu bestätigen, dass das, was in der reinen Simulation getestet wurde, auch in der realen Welt eingesetzt werden kann? Die Software ist letztlich eine abstrakte Sichtweise und weist Unzulänglichkeiten auf.

Sich nur auf reale Straßentests zu verlassen, ist auch unrealistisch, weil es schier unglaubliche Streckenlängen benötigen würde, bis die Fahrzeuge zu 100 % sicher und zuverlässig auf städtischen und ländlichen Straßen navigieren. Denn um die AD/ADAS-Funktionalität wirklich zu testen, ist es notwendig, alle relevanten Parameter zu kontrollieren.

Damit sich die Kluft zwischen den Tests in der realen Welt und der Simulation überbrücken lässt, werden reale physische Sensoren im Testaufbau benötigt. Diese Komplexität muss dem Test hinzugefügt werden, um vorherzusagen, wie sich autonome Fahrzeuge auf der Straße verhalten werden.

Unter allen Umständen soll die Technologie den Menschen am Steuer vollständig ersetzen und auf diese Weise zuverlässige, genaue und sichere Entscheidungen im Straßenverkehr ermöglichen. Softwaresimulationen können das reale Sensorverhalten nicht vollständig testen, und Tests auf der Straße sind nicht reproduzierbar.

Heute gibt es insbesondere bei der Emulation von Radarzielen mehrere technologische Lücken:

Begrenzte Anzahl von Zielen und Sichtfeld

Ein gängiger Ansatz verbindet jedes simulierte Ziel mit einer Verzögerungsstrecke. Selbst wenn zusätzliche Ziele hinzugefügt werden, wird immer nur ein Radarecho auf einmal verarbeitet. Wenn ein Antennen-Array erstellt wird, ist es außerdem nicht möglich, gleichzeitig Ziele an den äußersten Enden des Sichtfeldes des Radarmoduls zu simulieren. Zudem führt jede Bewegung der Antennen zu einer Änderung des Ankunftswinkels (AoA) des Echos, was zu Fehlern und einem Verlust an Genauigkeit bei der Darstellung von Zielen führen kann, wenn keine Neuberechnung erfolgt.

Keine Möglichkeit, Objekte in der Nähe zu erzeugen

Viele Testfälle, wie die »Vulnerable Road User Protection – AEB Pedestrian« des New Car Assessment Program (NCAP), erfordern die Emulation von Objekten in unmittelbarer Nähe des Radarsystems. Die meisten der heute auf dem Markt befindlichen Zielsimulationslösungen wurden für große Entfernungen konzipiert.

Geringere Auflösung zwischen Objekten

Bisher konnten Zielsimulatoren nur ein Objekt als eine Radarsignatur verarbeiten, was zu Lücken in den Szenendetails führte. Auf einer belebten, mehrspurigen Straße zum Beispiel müssen die Testgeräte genau zwischen allen Verkehrsteilnehmern unterscheiden können. Mit nur einem Echo pro Objekt ist der Algorithmus möglicherweise nicht in der Lage, zwischen einem Fahrrad und einem Laternenpfahl zu unterscheiden.

Neue Technologie erforderlich

Die Emulation von vollständigen Szenen im Labor ist der Schlüssel zur Entwicklung von robusten Radarsensoren und Algorithmen, die für die Realisierung von ADAS-Funktionen auf dem Weg zu vollständig autonomen Fahrzeugen erforderlich sind.

Eine Methode besteht darin, von einem Ansatz, der sich auf die Objekterkennung mittels Zielsimulation konzentriert, zur Emulation von Verkehrsszenen überzugehen (Bild 3). So lassen sich komplexe Szenarien nachbilden, einschließlich nebeneinander existierender hochauflösender Objekte, mit einem großen Sichtfeld und einem geringen Mindestabstand zum Objekt.

Das gesamte FOV (Field of View) des Sensors muss abgedeckt werden, um eine hohe Testabdeckung zu erreichen und ausführliche Testszenarien durchzuführen. Um eine reproduzierbare und genaue AoA-Validierung zu ermöglichen, ist ein breites FOV erforderlich, idealerweise mit HF-Frontends, die im Raum statisch sind.

Realistische Verkehrsszenen erfordern die Nachbildung von Objekten in unmittelbarer Nähe des Radargeräts. An einer Ampel, bei der die Autos nicht mehr als zwei Meter voneinander entfernt sind, könnten beispielsweise Fahrräder auf die Fahrbahn kommen oder Fußgänger plötzlich die Straße überqueren. Das Bestehen dieses Tests ist entscheidend für die Sicherheitseigenschaften eines AD/ADAS-Systems.

Die Objekttrennung, das heißt die Fähigkeit, zwischen Hindernissen auf der Straße zu unterscheiden, ist ein weiterer Testbereich für einen reibungsloseren und schnelleren Übergang zu Fahrzeugen der Level 4 und 5. So muss ein Radarerkennungsalgorithmus beispielsweise zwischen einer Leitplanke und einem Fußgänger unterscheiden, während das Fahrzeug auf einer Autobahn fährt.

Größeres Vertrauen in ADAS-Funktionalität erreichen

Mehr Ziele, ein kürzerer Mindestabstand, eine höhere Auflösung und ein kontinuierliches Sichtfeld sind für realitätsnahe Tests unerlässlich. Im Labor ermöglicht dies eine höhere Testabdeckung, um nicht nur Zeit zu sparen, sondern auch Testszenarien sicher durchzuführen und zu wiederholen.

Ein herkömmlicher Radar-Zielsimulator (Radar Target Simulator, RTS) liefert eine einzige Reflexion unabhängig von der Entfernung, während ein Radarszenen-Emulator die Anzahl der Reflexionen erhöht, wenn sich das Fahrzeug nähert, was auch als dynamische Auflösung bezeichnet wird. Das bedeutet, dass die Anzahl der Objekte mit der Entfernung des Objekts variiert.

AD- und ADAS-Software-Entscheidungen müssen auf dem Gesamtbild beruhen, nicht nur auf dem, was die Testausrüstung erlaubt. Die kürzlich von Keysight vorgestellte neue Radar-Emulationstechnologie ist eine weitere Möglichkeit, das Testen von komplexen Fahrszenarien von der Straße ins Labor zu verlagern.ih

Literatur

[1] Road Traffic Injuries. World Health Organization, 21. Juni 2021. https://www.who.int/news-room/fact-sheets/detail/road-traffic-injuries

[2] Automated Vehicles for Safety. National Highway Traffic Safety Administration, n.d. https://www.nhtsa.gov/technology-innovation/automated-vehicles-safety

Der Autor

Silviu Tuca

ist der Product Line Manager für radarbasierte autonome Fahrzeuge bei Keysight Technologies. Nach seinem Master-Abschluss in HF-Elektronik und einem Doktortitel in Biophysik hat er sein ganzes Berufsleben mit Messgeräten verbracht, unter anderem mit der Entwicklung neuer Kalibriermethoden und der technischen Beratung. Tuca lebt in Stuttgart, in seiner Freizeit ist er gerne in der Natur, hört Hörbücher oder Podcasts und mag gute philosophische Diskussionen.