Messdatenmanagement mit Open-Source-Lösungen

Big-Data-Techniken für alle

Fortsetzung des Artikels von Teil 1

Endlich genügend Platz für Messergebnisse

Doch die Menge der Versuchsdaten in den Fachbereichen wächst laufend weiter und die Vielfalt der Daten hinsichtlich Art (z.B. strukturiert, nicht strukturiert, teilstrukturiert) und Format (proprietär, standardisiert, Video, Audio, Grafik, XML, Text, Office usw.) steigt ebenfalls. Um diese Daten kostengünstig für eventuelle spätere Auswertungen ablegen zu können, gibt es von Peak Solution den Vorschlag, diese auf Commodity Hardware zu speichern. Auch hier wird auf eine frei verfügbare Lösung gesetzt: Das von der Apache Software Foundation geleitete Open-Source-Projekt Hadoop ermöglicht das verteilte Speichern und Verarbeiten von großen Datenmengen in horizontal verteilten Umgebungen. Eine Kernkomponente von Hadoop ist HDFS (Hadoop Distributed File System). Hierbei handelt es sich um ein verteiltes Dateisystem, mit dem große Datenmengen sicher und fehlertolerant auf bis zu mehreren tausend Servern innerhalb eines Clusters verteilt werden können („scale out“).

Das Besondere dabei ist, dass hierfür nicht spezielle und teure Server erforderlich sind, sondern Allerwelts-Hardware genutzt werden kann. Hadoop Distributed File System ist dadurch pro Terabyte circa 20-mal günstiger als etwa Storage Area Networks oder analytische Datenbanken (wie z.B. Enterprise Data Warehouse). Es fallen keine Lizenzgebühren an und man muss sich nicht an einen Hardware-Hersteller binden. Das Management der Daten (d.h. die Aufspaltung, Verteilung und Replikation auf den Knoten des Clusters) übernimmt HDFS komplett automatisch. Für den Benutzer gestaltet sich der Zugriff auf HDFS wie der auf ein virtuelles Dateisystem.

Einheitliche Schnittstellen und Methoden

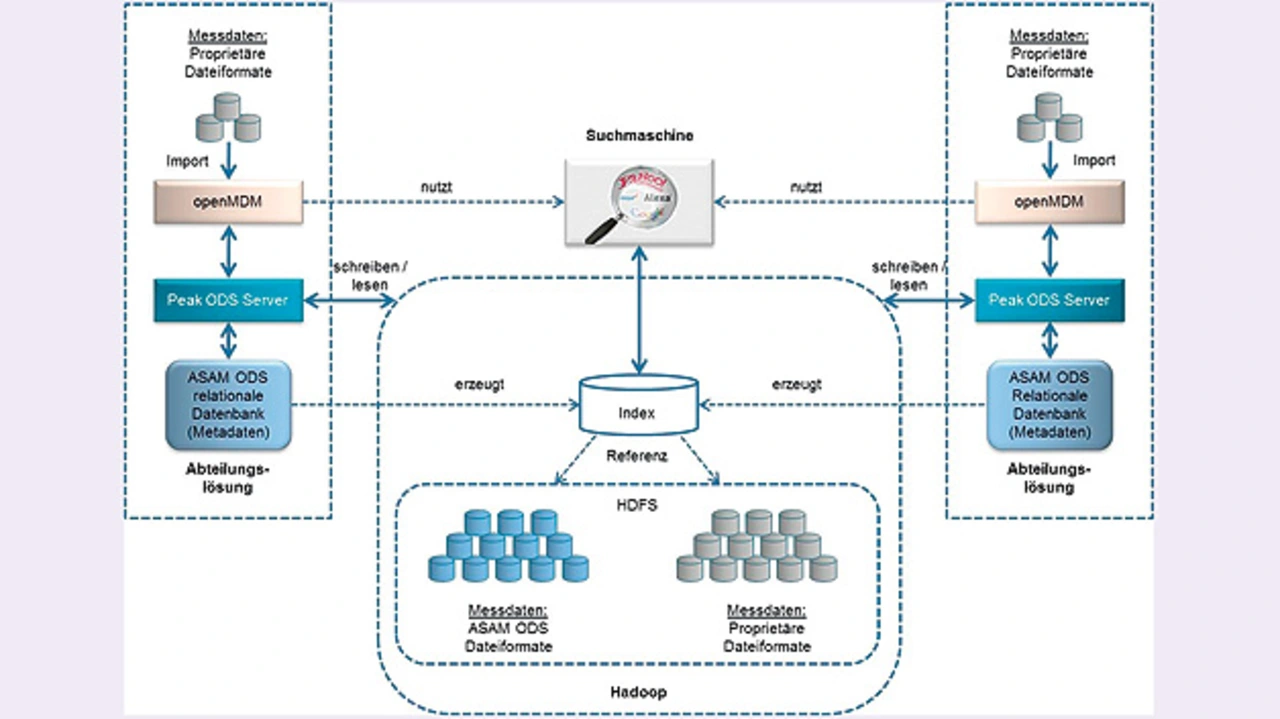

Die Kombination von openMDM und einem Hadoop-Cluster (Bild 3) funktioniert nun wie folgt: Beim Import in ein anwendungsspezifisches openMDM-System werden die Messdaten aus den unterschiedlichen Prüfsystemen in das standardisierte ODS-Dateiformat konvertiert und mit beschreibenden Informationen (Metadaten) verknüpft. Eine Zwischeninstanz, wie zum Beispiel der Peak ODS Server von Peak Solution, speichert sowohl die ODS-Dateien als auch die proprietären Ursprungsformate in HDFS. Der Server sorgt dafür, dass Daten, die von Prüfständen, Messeinrichtungen, Simulationssystemen, Analysewerkezeugen und Auswerteprogrammen unterschiedlicher Hersteller erstellt beziehungsweise benötigt werden, ODS-konform gespeichert beziehungsweise geladen werden. Bei den Daten kann es sich um Meta-Daten (z.B. Versuchs- und Simulationsaufträge, Versuchsbeschreibungen oder Kalibrierungsinformationen), Messdaten (z.B. Einzelmesswerte, Bild-, Video- und Audiodaten oder Ist-Daten der Versuchsdurchführung) sowie Ergebnisdaten (z.B. Auswertungs- und Berechnungsergebnisse) handeln.

Unabhängig von Herkunft und Format der Daten sorgt der Peak ODS Server dafür, dass unterschiedliche Anwendungen über einheitliche Schnittstellen und Methoden darauf zugreifen können. Durch die Kapselung der Schnittstellen spielt die Art der Datenablage im Detail für die jeweilige Client-Applikation keine Rolle mehr. Das heißt, alle ODS-fähigen Datenerfassungs-, Automatisierungs-, Simulations- oder Analysesysteme können mit Hilfe des Peak ODS Server Konfigurations- und Ergebnisdaten ODS-konform speichern und laden. Mit diesem Vorgehen bleiben auch die Daten erhalten, die vorher mangels Platz der Selektion zum Opfer fielen. Die Metadaten werden in der relationalen Datenbank der openMDM-Anwendung abgelegt. Hieraus wird mit der ebenfalls freien Software Apache Lucene fortlaufend ein Index gebildet. Dieser Index und die Suchmaschinentechnologie Lucene, die beispielsweise bei Wikipedia im Einsatz ist, ermöglichen nun das, was eingangs gefordert wurde: ein unternehmensweites Messdatenmanagement. Die Suchmaschine bietet über exploratives und iteratives Browsen sowie Text Mining die Möglichkeit, anwendungs- und abteilungsübergreifend im Gesamtdatenbestand Versuche mit speziellen Merkmalen zu finden. Sofern der Anwender die entsprechenden Zugriffberechtigungen besitzt, kann er die gefundenen Versuchsdaten – auch die aus anderen Testabteilungen – dann für Vergleiche und eigene Analysen heranziehen.

Vielfältige Analysemöglichkeiten

Neben einem kosteneffizienten Ablageplatz für Massendaten bietet der HDFS-Cluster nun auch die vielfältigen Möglichkeiten der Auswertung, die man gemeinhin unter dem Schlagwort Big Data Analytics anführt. Daten aus unterschiedlichen Anwendungen und Fachbereichen können miteinander in Beziehung gesetzt, neue Zusammenhänge abgeleitet werden. Wer beispielsweise Simulationen für SiL- und HiL-Tests von Bausteinen eines Fahrerassistenzsystems entwickelt, kann unter Umständen wertvolle Hinweise aus der Analyse von Daten aus Fahrtests gewinnen. Mit graphenbasierten Methoden können semantische Netze modelliert werden, um mehr als nur die offensichtlichen Beziehungen und Abhängigkeiten zwischen unterschiedlichen Datenobjekten aus dem Versuchsumfeld zu erkennen. Auf Basis dieser Informationen lassen sich dann moderne Hinweis- und Empfehlungssysteme sowie Wissensdatenbanken für Versuchsingenieure errichten. Aus dem Fachwissen einzelner Abteilungen wird ein Wissen um das gesamte Prüfwesen im Unternehmen und darüber hinaus.

Der Big-Data-Ansatz erlaubt es, globale Zusammenhänge zu untersuchen. Zum Beispiel kann bei Fahrversuchen, die weltweit unter verschiedensten Bedingungen stattfinden, die Kommunikation auf dem Datenbus der unterschiedlichen Versuchsfahrzeuge aufgezeichnet werden. Parallel dazu lassen sich über Sensoren zahlreiche Informationen über einzelne Fahrzeugkomponenten (z.B. Motor, Getriebe, Bremsen) und durch den Einsatz von Videomesstechnik Straßen- und Umgebungsinformationen sammeln. Mit diesen Informationen können dann umfassende Analysen über das Verhalten bestimmter Fahrzeugtypen in definierten Situationen durchgeführt werden. Diese geben gegebenenfalls Hinweise auf Optimierungspotenzial für das Zusammenspiel einzelner Fahrzeugkomponenten. Im weiteren Sinn sind Messdaten auch Wissen zur Weiterentwicklung der Produkte. Der Big-Data-Gedanke ist im Bereich des Messdatenmanagements gerade erst angekommen. Welche Fragen man an die Datenmassen stellen kann und welche Analysemöglichkeiten sich anbieten, ist noch gar nicht abzusehen. Dank des Zusammenspiels von openMDM mit Hadoop und Lucene wird unternehmensweites Messdatenmanagement unter Nutzung großer Datenbestände aber möglich, und zwar auf Basis spezifischer openMDM-Installationen in den unterschiedlichen Fachbereichen vom Motorenbau und Fahrwerk bis Fahrerassistenz und Entertainment. Dies ist insofern ein wichtiger Aspekt, als die Zuarbeit externer Entwicklungspartner und unternehmensübergreifende Plattformentwicklungen eher noch zunehmen werden. Durch die großzügige Datensammlung im HDFS-Cluster werden im Entstehungszusammenhang marginale Daten, die bisher gelöscht wurden, auswertbar. Und das, auch wenn sie beim Dienstleister entstanden sind. OEMs, die diesen Big-Data-Weg beschreiten, haben so wieder ein Stück umfangreicheres Wissen um den Life Cycle ihrer Produkte und Subsysteme – weit über einen einzelnen finalen Prüfbericht hinaus.

Der Autor

| Dr. Hans-Jörg Kremer |

|---|

| ist Geschäftsführer von Peak Solution. Einer seiner Tätigkeitsschwerpunkte ist die prozessorientierte Konzeption und Umsetzung von wirtschaftlichen Gesamtlösungen für Versuchs-und Messdatenmanagement. Dr. Kremer ist seit 2014 Mitglied im Technical Steering Committe des ASAM e.V. sowie Vertreter der Service Provider im Steering Committe der openMDM Eclipse Working Group |

- Big-Data-Techniken für alle

- Endlich genügend Platz für Messergebnisse