KI-Algorithmen

Mit der Cloud? Muss nicht sein, MCUs/MPUs gehen auch

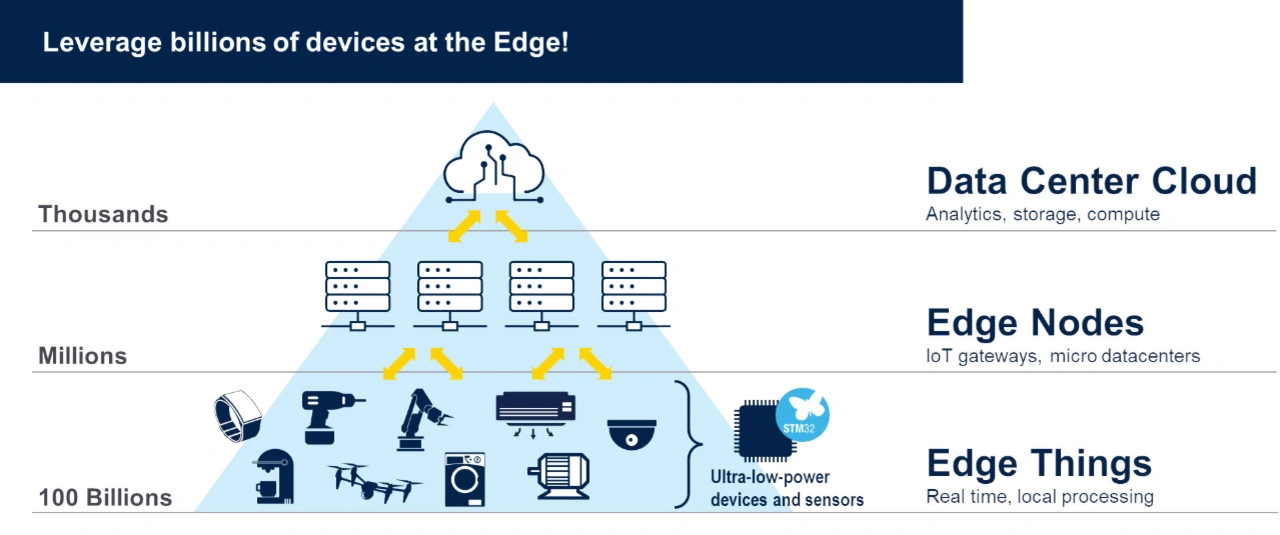

Künstliche Intelligenz wird in vielen Bereichen direkt mit der Cloud verbunden. Allerdings bringt die Beschränkung auf die Cloud entscheidende Nachteile mit sich, denn mittlerweile gibt es auch Hardware, die KI-Algorithmen im Edge sinnvoll verarbeiten kann.

Heute basieren die vielversprechendsten KI-Technologien wie DALL-E 2 oder GauGAN 2 auf Cloud-Ansätzen. Die Cloud-Anbieter behaupten auch gerne, dass dies der richtige Weg sei. Doch nicht immer scheint der Cloud-Ansatz die beste Lösung zu sein. Denn es gibt durchaus bekannte Gründe, die dagegensprechen. Dazu zählen z. B. die hohen Kosten, die Millionen von weltweit verteilten Sensoren verursachen, wenn sie Terabytes an Daten in die Cloud senden. Dazu kommt noch, dass in vielen Fällen eine Verbindung mit der Cloud gar nicht möglich ist, und sollte sie doch möglich sein, ist dieser Ansatz in manchen Fällen dennoch völlig unnötig.

Denn viele Industrie- oder IoT-Anwendungen enthalten bereits eine MCU oder MPU, auf der ein KI-Algorithmus unmittelbar ausgeführt werden kann, gerne als »AI at the edge« betitelt. In den meisten Fällen ist außerdem immer eine gewisse Menge an Flashspeicher und RAM verfügbar, der oft für die Ausführung eines winzigen oder Nano-KI-Algorithmus genutzt werden könnte. Warum sollte man also nicht davon profitieren? Oder sogar eine Hybridlösung in Betracht ziehen?

Jobangebote+ passend zum Thema

Enorme Vorteile

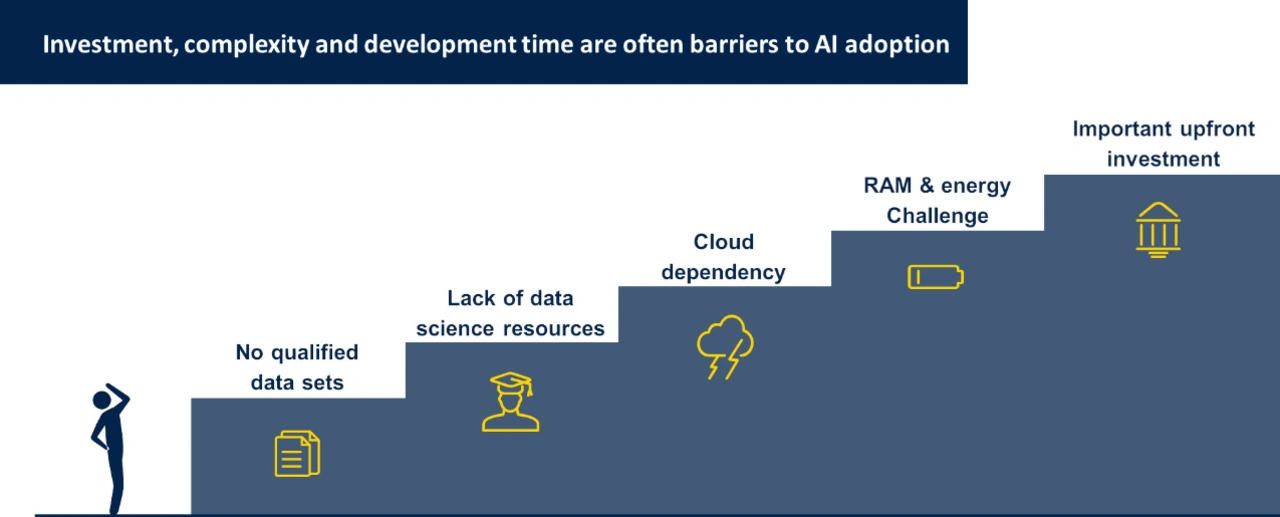

Der Ansatz, die vom Sensor stammenden Daten direkt zu analysieren und nicht von der Cloud abhängig zu sein, hat noch weitere Vorteile wie die Reaktionszeit, Datenschutz, keine Netzwerkprobleme usw. und ist für die meisten Anwendungen der richtige Weg. Warum hat sich dieser Ansatz bisher noch nicht als Standardlösung durchgesetzt? Dafür gibt es viele Gründe. Unserer Erfahrung nach hat die Halbleiterknappheit einen großen Einfluss auf die Innovation neuer Projekte in der Branche. Glücklicherweise wird sich diese Situation in naher Zukunft ändern. Außerdem sind sich die meisten Menschen der Leistungsfähigkeit von Nano-KI-Algorithmen nicht bewusst, da es viel Zeit und Fachwissen erfordert, einen geeigneten Algorithmus zu entwickeln und ihn zu trainieren. Darüber hinaus wurde er mit anderen Lösungen verglichen, die bereits gut funktionieren, wie z. B. einem PID-Regler oder einer FFT mit Schwellenwerten. In den Fällen konnte keine wesentliche Verbesserung festgestellt werden. Und es ist auf den ersten Blick nicht offensichtlich, dass eine KI für eine bestimmte Anwendung nützlich sein könnte. Dennoch ist es in aller Munde, dass die KI selbst bei kleinen Geräten zukünftig eine Schlüsselrolle spielen wird. Dieser Trend ist eindeutig erkennbar, aber in Europa scheinen wir, was das angeht, im Vergleich zu anderen Regionen der Welt ziemlich im Rückstand zu sein.

Auch ohne Spezialistenwissen zur funktionsfähigen KI

Selbst wenn wir heute mit KI at the Edge beginnen würden, gäbe es viele Herausforderungen zu meistern. Zum Beispiel mangelt es an Spezialisten wie Datenwissenschaftler, die verstehen, wie die eingebettete Software funktioniert, und umgekehrt. Andererseits ist ein großer Vorteil, dass die meisten KI-Frameworks, wie Tensorflow Lite oder Keras, kostenlos sind. Aus diesem Grund und um die Möglichkeiten unseres Ökosystems zu erweitern, hat ST x-CUBE-AI entwickelt, um das neuronale Netzwerk in die STM32-MCUs zu übertragen und es zu optimieren. Darüber hinaus haben wir x-Linux-AI für unsere MPU innerhalb unserer ST-Linux-Distribution entwickelt, was die KI-Entwicklung in einem Embedded-Linux vereinfacht.

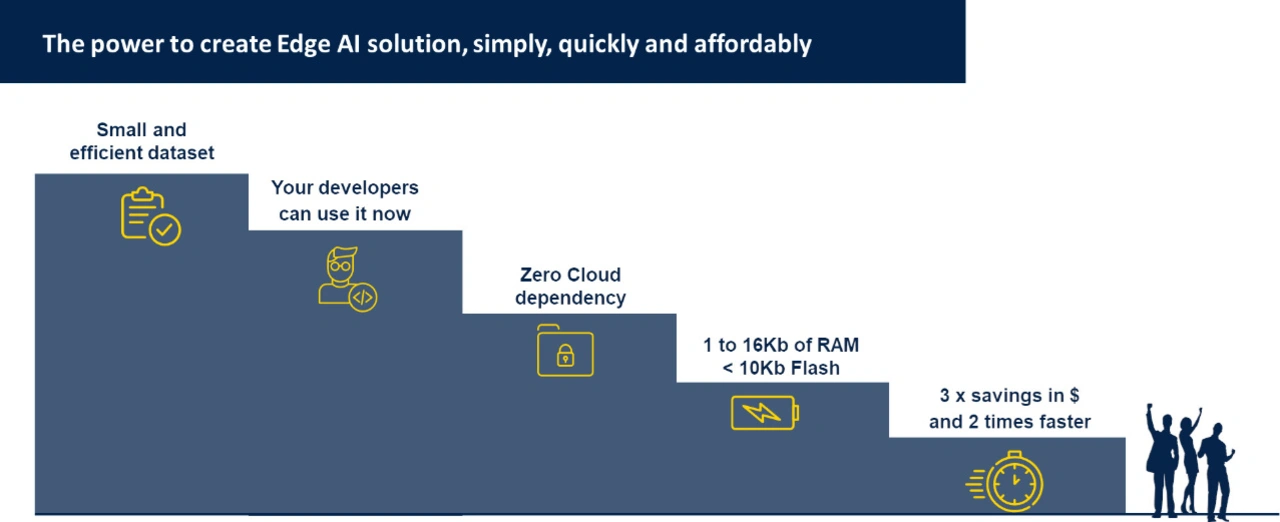

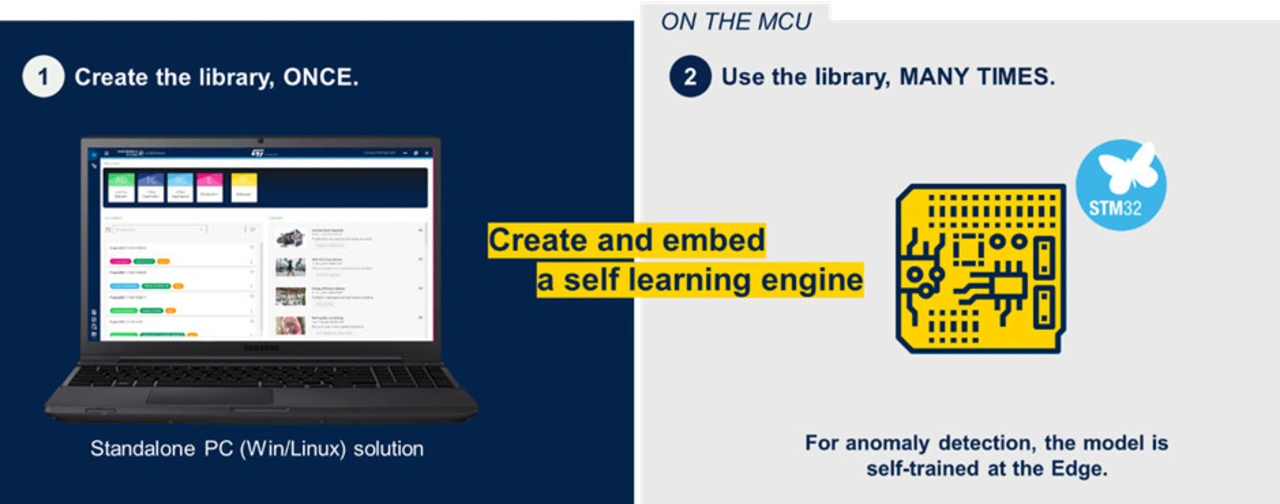

Doch selbst mit x-CUBE-AI und x-LINUX-AI fällt es vielen schwer, KI zu entwickeln. Für die, die die Ressourcen haben, ein KI-Entwicklungsteam einzustellen, ist dieser Ansatz zwar passend, aber nicht jedes Unternehmen kann sich das leisten. Aus diesem Grund hat ST in der Vergangenheit das Startup Cartesiam übernommen. Das Unternehmen hat viel Erfahrung mit Nano-KI-Algorithmen und hat eine leistungsstarke Software namens Nano Edge AI Studio (NEAI) entwickelt, die dieses Problem lösen kann. NEAI ist eine Suchmaschine, die auf Grundlage des Eingabedatensatzes nach der am besten geeigneten KI-Lösung für eine bestimmte Anwendung sucht. Die gefundene Lösung muss nicht immer auf neuronalen Netzen beruhen. Zudem verfügt die Software über eine Reihe von Optimierungen, die die Menge der benötigten Speicherressourcen und die der Trainings reduzieren, die für den Algorithmus erforderlich sind. All dies bedeutet, dass es mit NEAI möglich ist, in wenigen Stunden eine Nano-AI-Lösung zu entwickeln - im Gegensatz dazu steht ein traditioneller Ansatz, bei dem es Monate oder über ein Jahr dauern kann, sie selbst zu entwickeln.

Selbst wenn eine KI-Anwendung auf einer winzigen MCU ausgeführt werden kann, besteht immer noch eine große Herausforderung, wenn es um das Lernen at the Edge geht. Denn wird das KI-Modell auf dem Host entwickelt und dann auf das Zielsystem übertragen, ist dieses Modell ist typischerweise »statisch«, also nicht lernfähig. Es muss erneut mit dem Host verbunden werden oder ein Firmware-Update erhalten, um die Parameter des KI-Algorithmus zu ändern. Mit NEAI ist das anders, denn mit NEAI können »dynamische« Modelle erstellt werden. Sobald das Modell vom Host auf das Zielsystem übertragen wurde, kann das Zielsystem (wie zuvor beschrieben) lernen. Das Zielsystem ist also in der Lage, die Parameter des KI-Algorithmus »on the fly« zu lernen oder zu ändern. Diese Funktion, »learning at the edge«, ist einzigartig bei NEAI und kann kostenlos in unserem Nucleo oder an unseren Demo-Boards getestet werden. Es können auch Erfolgsgeschichten und verschiedene Anwendungen angesehen werden, die die Vorteile von NEAI zeigen.

Nachdem die NEAI-Anwendungen betrachtet worden sind, besteht die größte Herausforderung immer noch darin, ein Brainstorming durchzuführen und ein gutes Beispiel zu finden, mit dem man beginnen kann. Eines, für das es noch keine Lösung gibt, oder eines, das verbessert werden könnte. Wir empfehlen mit einem Anwendungsfall zu beginnen, bei dem es um »abnormality detection« geht oder bei dem KI zur Mustererkennung oder zur Sortierung eingesetzt wird. Dann kann mit unserem Demo-Board und NEAI ein Proof of Concept durchgeführt werden. Es ist auch wichtig, einige praktische Aspekte zu berücksichtigen, z. B. welcher Sensor verwendet wird, ob eine gute Kopplung zwischen dem zu messenden Phänomen und dem Sensor besteht, sowie welche Abtastrate verwendet werden.

NEAI kann getestet werden, es steht zum Download bereit. Darüber hinaus gibt es noch weitere hilfreiche Ressourcen, die den Einstieg in die KI-Welt erleichtern.

NEAI kann getestet werden, es steht zum Download bereit. Darüber hinaus gibt es noch weitere hilfreiche Ressourcen, die den Einstieg in die KI-Welt erleichtern. Dazu gehören NanoEdge AI (NEAI) documentation, NEAI Youtube playlist (presentations, demos), MOOC: Datalogging for NEAI, Article: NEAI Datalogging guidelines und Tutorial: Dual-tone classifier.