Interview mit Christian Eder

»Frühzeitig auf COM-HPC wechseln«

Fortsetzung des Artikels von Teil 1

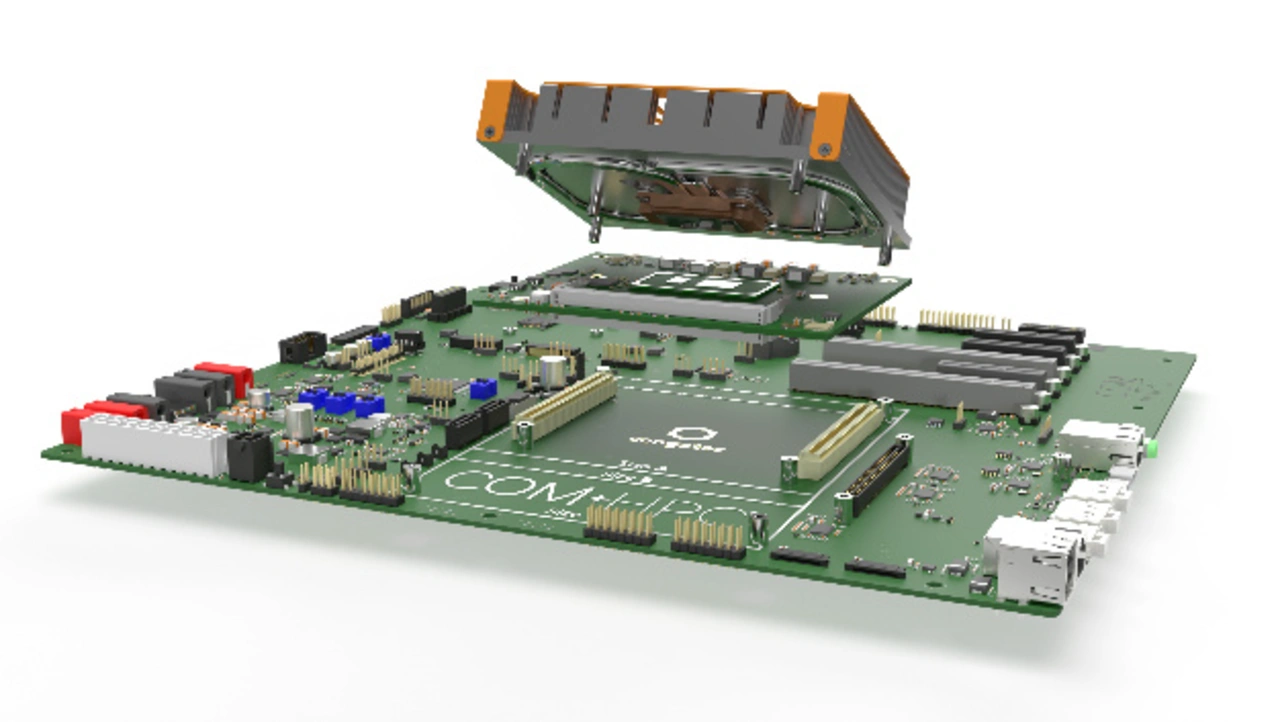

System- und Board-Auslegung

Welche Eigenschaften sehen Sie bei der System- und Board-Auslegung derzeit am wichtigsten an?

Heutige Designs sind auf Leistung und hohen Durchsatz getrimmt. Aus dem Grund zählen Echtzeit-Performance und -Konnektivität über TSN sowie Zuverlässigkeit zu den zentralen Anforderungen von Boards und Systemen. Hinzu kommt der Bedarf, Bild- und Spracherkennung zu integrieren und mittels KI interaktiver zu gestalten. Entsprechend wichtig sind abgestimmte Embedded-Vision-Kits. Sie geben Entwicklern die Möglichkeit, sofort loszulegen. Speziell bei KI werden wir in den nächsten Jahren deutliche Performancesteigerungen sehen. Weiter wichtig sind Remote-Management-Funktionen, wie man sie mit Intel Active Management Technology (AMT) umsetzt. Außerdem die neue Platform Management Interface (PMI)-Spezifikation von COM-HPC, die IPMI und Redfish implementiert.

Aufgrund der vielen High-Speed-Schnittstellen ist ein qualitativ hochwertiges Boardlayout zunehmend wichtig. Selbst kleine Fehler und ein hierdurch gestörtes Übertragen der Daten können in der finalen Anwendung zu Fehlern führen. Ebenso essenziell ist das richtige Thermaldesign: So liefern die Systeme eine kontinuierliche Leistung und die Prozessoren und Komponenten überhitzen nicht. Das wirkt sich auf die Leistung sowie die Zuverlässigkeit aus. Es gilt die Faustformel, dass eine Temperaturerhöhung um 5 bis 10 °C die Lebensdauer der Chips halbieren kann.

Jobangebote+ passend zum Thema

Können Sie in dem Zusammenhang die drei wichtigsten Herausforderungen nennen, mit denen Entwickler derzeit konfrontiert sind?

Neue Herausforderungen gehen mit immer schnelleren I/Os wie PCIe Gen 4 oder 10 GbE einher – beginnend mit dem Routing auf Carrierboards. Hier unterstützen wir mit umfassenden Workshops, Best-Practice Designs sowie umfangreichen Design Guides. Knackpunkt Nummer 2 ist die Echtzeitvernetzung, beispielsweise in intelligenten Fabriken. Hierzu haben wir eine TSN-Initiative gestartet, um die Echtzeit-Ethernet-Kommunikation auf Basis offener Standards zu ermöglichen. Weil TSN sogar Single Pair Ethernet (SPE) unterstützt, kann es sowohl proprietäre industrielle Ethernet-Protokolle als auch Feldbusse ersetzen. Die dritte Challenge liegt im Bereich der Systemkonsolidierung. Hier brauchen OEMs einen einfachen Weg, ihre auf Multicores basierten Designs einfach zu partitionieren. Sprich, die einzelnen Ressourcen den jeweiligen virtuellen Maschinen zuzuweisen ohne dabei die Latenz zu erhöhen, also Echtzeitfähigkeit einzubüßen. Hierfür bieten wir validierte Packages und vermitteln unseren Kunden unsere Expertise mit dem Echtzeit-Hypervisor von Real-Time Systems.

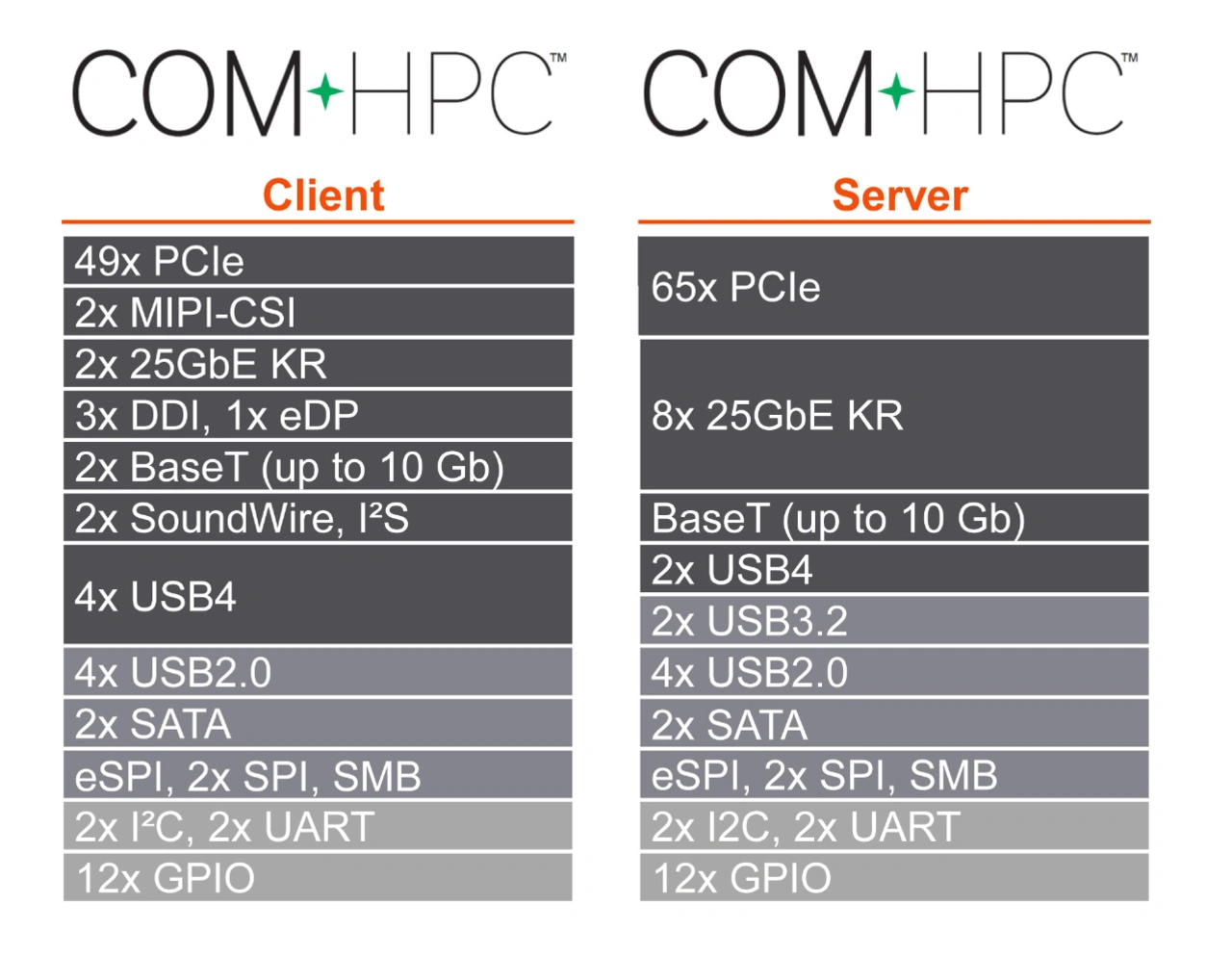

Ein großer Vorteil von PCIe ist die Abwärtskompatibilität zu den vorherigen Generationen. Prozessoren auf Basis von PCIe Gen 4 sind somit problemlos in Standards wie COM-Express weiter nutzbar. Warum sollten Entwickler auf den neuen Standard wechseln?

Ganz klar: COM-HPC ist oberhalb der Leistungsklasse von COM-Express angesiedelt. Entwickler, denen CPU-Performance oder Bandbreite der PCIe-Interfaces von COM-Express nicht ausreichen, oder die wissen, dass sie in Zukunft mehr benötigen als COM-Express liefert, sollten besser früher als spät auf COM-HPC wechseln. All diejenigen, deren Applikationen mit COM-Express ausreichend »motorisiert« sind, sollten bei COM-Express bleiben.

Der Support der PCIe-Gen-4- und der kommenden PCIe-Gen-5-Spezifikation dürfte aktuell für die meisten Embedded-OEMs kein zwingender Wechselgrund sein, da das aktuelle Angebot an passender Peripherie noch recht klein ausfällt. Hinsichtlich des Supports kann man beide Standards als gleichwertig ansehen, da die PICMG beide hostet und sich die größten COM-Express-Anbieter ebenfalls in der COM-HPC Workgroup engagieren. Von daher ist also eine hohe Kontinuität gewahrt, so dass es COM-Express-OEMs leichtfällt, auf COM-HPC zu migrieren. Neueinsteiger in die Welt der CoMs werden bei beiden Standards bestens unterstützt.

Stichwort Arm: Wie sehen Sie einer möglichen Übernahme durch Nvidia entgegen? Hat das Folgen für Ihr Geschäft?

Nvidia klassifizieren wir bei dem potenziellen Deal als Prozessorlieferanten, der für uns als Boardhersteller vorerst lediglich eine weitere Option darstellt. Schließlich sind wir als Hersteller von Embedded-Computing-Modulen von Haus aus prozessoragnostisch und helfen unseren Kunden zwischen CPU-Herstellern zu switchen. Aktuell passen Nvidia GPUs als KI-Engine sehr gut zu Intel-CPUs. Jedoch ist Nvidias Arm-basierte Grace-CPU aktuell keine Option für Modulstandards, da Grace vier dedizierte »NVLinks« nutzt, um mit GPUs zu kommunizieren. Insofern hat der Deal – zumindest in naher Zukunft – keinen Einfluss auf unser Geschäft.

Welche Herausforderungen kommen im Jahr 2022 auf Congatec zu und wie wollen Sie ihnen begegnen?

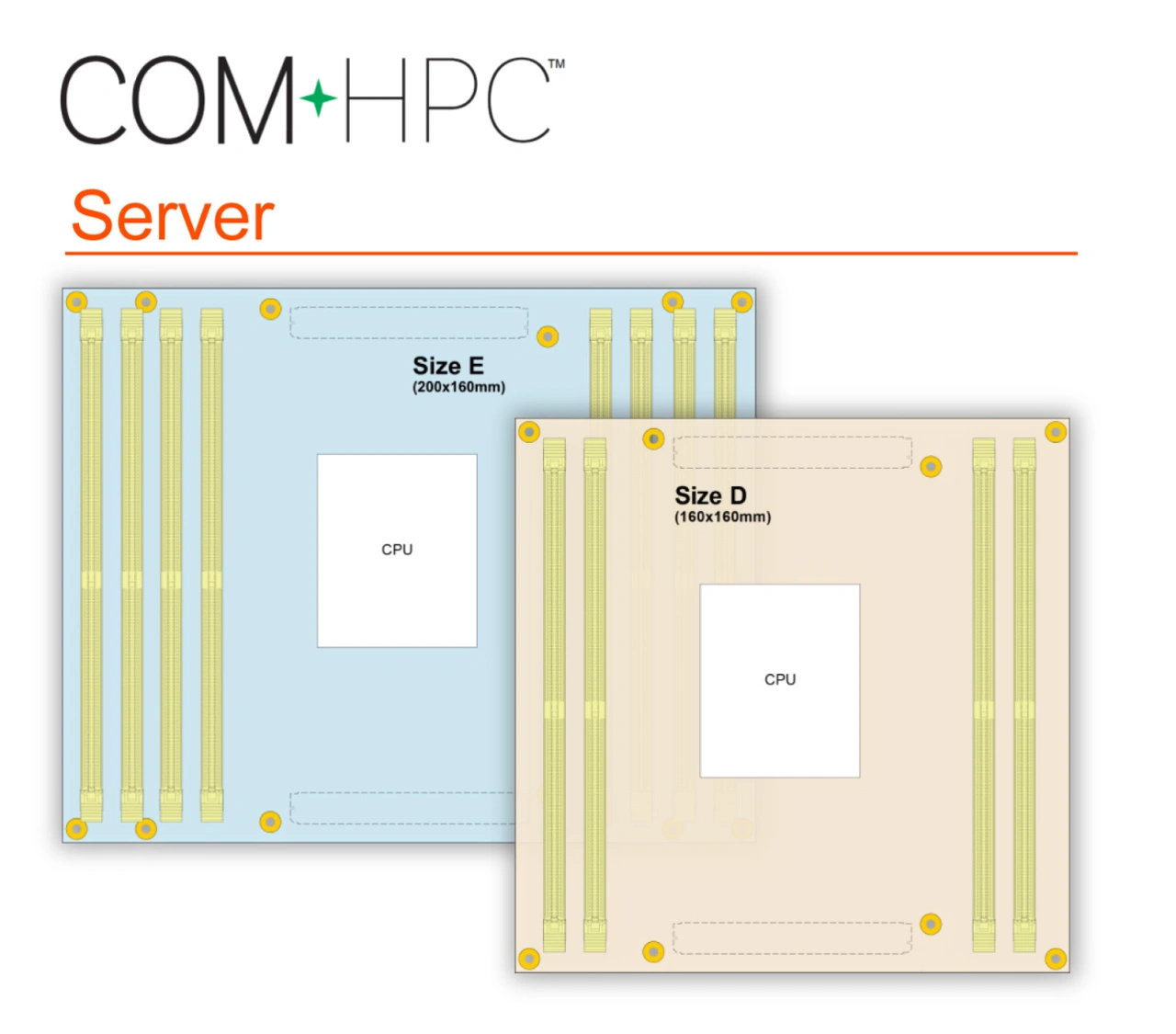

Eine große Aufgabe ist die Markteinführung der neuen COM-HPC-Server-Module. Das Feld der modularen Edge- und Fog-Server jenseits der Leistung von COM Express Typ 7 Server-on-Modules formt sich gerade erst mit dem neuen Formfaktor. Industrienahe Mikro-Server sind hierbei noch ein einfach zu erschließendes Kundenklientel. Auf Edge-Datencenter-Niveau sind die Hersteller noch stark auf eigene Entwicklungen fokussiert – hier ist viel Überzeugungsarbeit nötig.

Der As-a-Service-Trend und der Bedarf, die Leistung pro Rack schnell und zunehmend nachhaltig steigern zu können, spielt uns als Modul-Lieferant jedoch gut in die Karten. Insofern eröffnet sich uns neben dem klassischen Embedded-Markt ein neuer Markt, der sehr anspruchsvoll und vielversprechend ist. In 5G-Netze liefern zu können ist mit attraktiven Stückzahlen verbunden. Gleiches gilt im Grunde für den Automotive- und den Mobile-Vehikel-Markt.

Vielen Dank für das Gespräch Herr Eder.

- »Frühzeitig auf COM-HPC wechseln«

- System- und Board-Auslegung