Intelligente Dialoge per Sprachassistent

»Hallo Auto?«

Digitale Sprachassistenten wie Siri & Co. schüren Erwartungen, das Auto per Stimme zu steuern. Auch Fahrzeughersteller setzen für Komfort und Sicherheit darauf. Informationsbasierte Sprach-Broker helfen, die speziellen Herausforderungen der Integration sprachbasierter Dialogsysteme zu meistern.

Sollte es nicht vergleichsweise einfach sein, am Markt erhältliche Sprachsteuerungen ins Auto zu adaptieren? Bei weitem nicht. In Fahrzeugen ist es überproportional wichtiger als im Wohnzimmer, eindeutig, schnell und sicher zu kommunizieren – der Fahrer soll nicht abgelenkt werden. Die Tools gängiger Sprachassistenten bieten vergleichsweise wenig Flexibilität, wenn es um die Entwicklung komfortabler und komplexer Sprachinteraktionen im Auto geht. Zusätzliche Programmierarbeit ist quasi immer notwendig und kann sehr zeitaufwendig sein. Die gängigen Design-Tools selbst folgen einem eher vereinfachten Ansatz der Dialoggestaltung. Vielfach lassen sie natürliche Dialogphänomene außer Acht, die es erlauben würden, eine fließende und zielorientierte Interaktion zu gestalten. Beispiele hierfür sind implizite Bestätigung, Korrektur oder Einordnung von Mehrdeutigkeit im Kontext (Disambiguierung). Die Implementierung eines solch nutzerorientierten Dialogverhaltens muss daher per »Hand« erfolgen. Des Weiteren haben externe Assistenten nur beschränkten Zugriff auf Daten, welche Sprachdialoge zielgerichteter und einfacher gestalten könnten. Informationen finden sich überall im Fahrzeug, im verbundenen Smartphone oder in der Cloud, müssen aber mittels aufwendiger Programmierung einzeln in den Sprachdialog eingebunden werden.

Mankos von Sprachassistenten

Es ist frustrierend, wenn Sprachassistenten gar nichts oder »nur Bahnhof« verstehen. Auch wenn die Spracherkennung oft schon verblüffend gute Ergebnisse liefert: Für wirkliches Vertrauen reicht es meist einfach noch nicht. Das führt zu einer weniger intensiven Nutzung – die Sprachsteuerung wird nur für einfache Befehle genutzt, von denen Nutzer sicher wissen, dass sie auf Anhieb funktionieren: »Volker anrufen« oder »Nach Erlangen fahren«.

Sprachsteuerung geht schief, wenn die akustische Erkennung nicht funktioniert oder der Dialogablauf zu unnatürlich ist. Oft fehlen dem Assistenten auch einfach Informationen, die zur korrekten Ausführung des Befehls nötig wären: Wo in Erlangen möchte der Nutzer genau hin, etwa zur Arbeitsstelle? Ist der Tank noch genügend gefüllt oder welche Tankstelle kann auf dem Weg nach Erlangen angefahren werden? Dem Sprachassistenten fehlen oftmals der Kontext und spezifische Informationen über das Auto, den Fahrer, die Umgebung und oft sogar über die eigene Dialogvergangenheit, etwa worüber gerade gesprochen wurde. Die heutigen Sprachassistenten sind zumeist für spezifische Aufgaben programmiert, die wenigsten Assistenten haben Zugang zu weiterführenden Informationen. Dass eine Adresse aus Stadt, Straße und Hausnummer besteht, ist bekannt, aber dass eine Tankstelle Benzin und Snacks sowie Getränke verkauft, oft nicht. Sagt der Fahrer »Ich habe Durst« muss er dementsprechend eventuell einen Umweg zu einem Supermarkt in Kauf nehmen, statt ohne großen Zeitverlust an der nächsten Tankstelle auf dem Weg zu halten.

Der folgende Beispieldialog zeigt eine Interaktion mit verschiedenen Alexa-Skills beim Smartphone. Mithilfe dieser Skills kann zwar auf den Standort zugegriffen werden, aber nicht auf Fahrzeugdaten wie den Benzinstand oder die benötigte Treibstoffsorte.

Benutzer: Fahre mich zur Tankstelle.

System: Möchten Sie die Adresse zur Aral-Tankstelle?

Benutzer: Ja.

System: Okay, Wegbeschreibung wird abgerufen.

[Es startet die Navigations-App]

Benutzer: Frage Benzinpreise, was kostet es?

System: Leider habe ich nicht verstanden, was Sie tanken möchten.

Benutzer: Frage Benzinpreise, was kostet E10?

System: Super E10 kostet 1,239 EUR bei JET-Tankstelle Düsseldorfer Straße 285 und 1,239 EUR bei Supol.

Obwohl Alexa in diesem Moment mit der Navigation zur Aral-Tankstelle standortbezogene Informationen zur Verfügung hat‚ »vergisst« das System diese Information schon bei der nächsten, eigentlich darauf aufbauenden Frage.

Individualisierung von Sprachassistenten

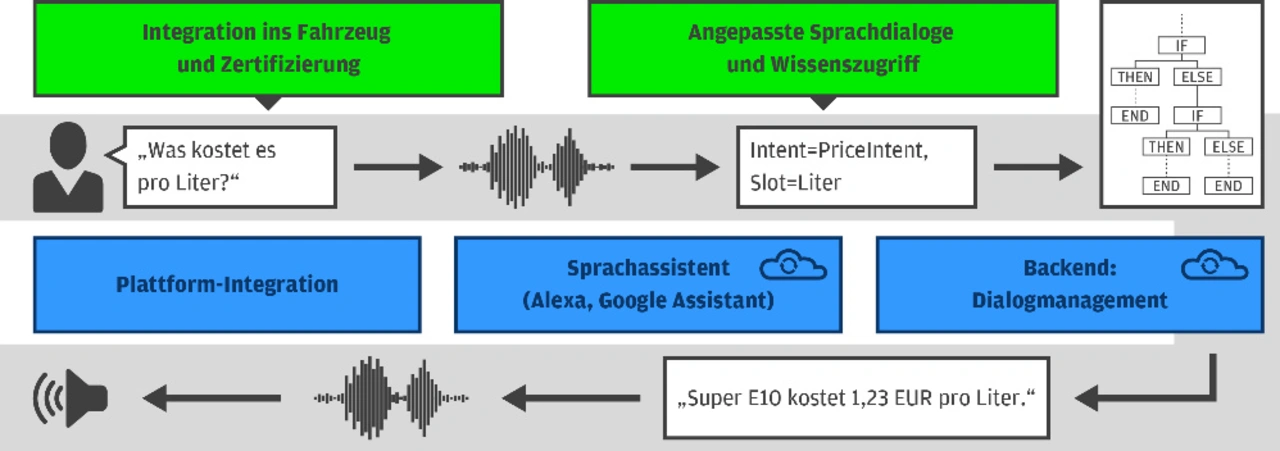

Die Fähigkeiten der Sprachassistenten können mit serverbasierten Dialogsystemen erweitert werden (Bild 1). Wie bereits erwähnt, ist eine qualitativ hochwertige Integration eines Sprachassistenten für natürliche Kommunikationsabläufe jedoch aufwendig. Zunächst muss der Assistent in die jeweilige Plattform integriert und mit dem Infotainment-System verbunden werden. Durch eine Abstraktionsschicht, sogenannte Broker für Sprachassistenten, können verschiedene Sprachassistenten relativ unkompliziert integriert oder im Laufe der Fahrzeuglebensdauer ausgetauscht und aktualisiert werden. Unterschiedliche Assistenten, die gleichzeitig integriert, aber nicht notwendigerweise gleichzeitig aktiv sind, sind zum Beispiel für verschiedene Regionen der Welt sinnvoll. Ihre Funktionen können sich aber auch überschneiden, zum Beispiel um dem Fahrer seine aus dem Wohnzimmer vertraute Umgebung auch im Fahrzeug anzubieten.

In einem zweiten Schritt lassen sich die Funktionen der Sprachassistenten erweitern. Zusätzliche Fähigkeiten für eine bestimmte Aufgabe, etwa die Einbindung der Klimaanlage und deren Steuerung, heißen bei Alexa »Skills« oder »Actions« beim Google Assistant. Sind die vorhandenen Dialogfähigkeiten für die gewünschte neue Funktion nicht ausreichend, kann in einem dritten Schritt ein beliebiges, eigenes Dialogmanagement im Back-End implementiert werden. Dieses baut auf der erkannten Benutzerintention (Intent) und seinen Parametern (Slots) auf und initiiert Rückfragen oder Antworten. An dieser Stelle ist es möglich, Daten aus dem Auto oder aus der Cloud einzubeziehen und diese Informationen auch über Skills und Actions hinweg zu behalten. Der im Folgenden skizzierte generische Ansatz für solch ein Back-End erlaubt es, basierend auf der Beschreibung von Wissen und der Verknüpfung von Fahrzeugdaten, verblüffend intelligente Antworten zu generieren.

Arten und Kombination von Wissen

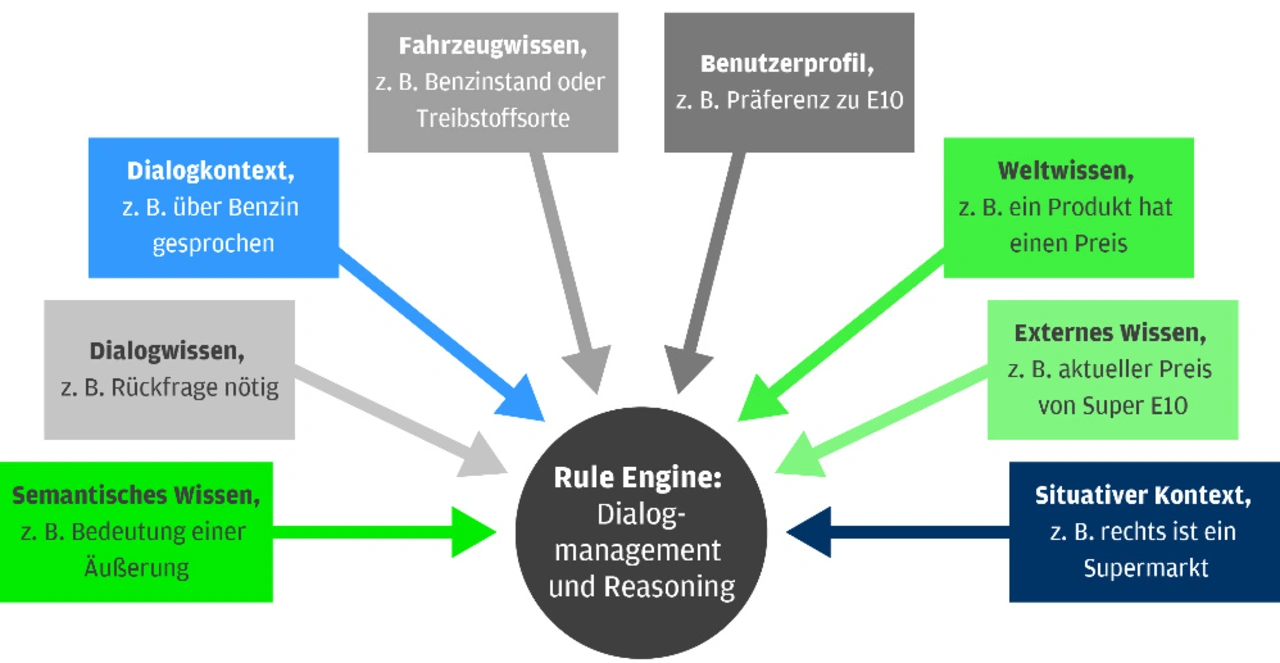

Wissen ist einer der wichtigsten Schlüssel für natürliche, aufgabenorientierte und situative Dialoge. Umfassende Informationen helfen dem Sprachassistenten komplexe Sachverhalte zu analysieren und intelligente Schlussfolgerungen zu ziehen. Ein Beispiel ist die Beantwortung der Frage »Was kostet es?«, die dem System im zuvor dargestellten Dialog gestellt wurde. Ein generischer Ansatz zur Beantwortung benötigt folgende Arten von Wissen:

Semantisches Wissen

Das System muss wissen, welche Bedeutung eine sprachliche Äußerung hat, und einschätzen können, welchen Sinn diese hat. Typischerweise geschieht das statistisch und basierend auf einer Sammlung von Beispielsätzen. »Was kostet es?« bezieht sich auf den Preis eines Produktes.

Dialogwissen

Das System muss berechnen können, welcher Dialogschritt als nächstes

ausgeführt wird. »Was kostet es?« erfordert im Kontext Benzin keine weitere

Nachfrage, sondern verlangt die direkte Antwort mit dem korrekten Preis.

Dialogkontext

In natürlichen Dialogen bezieht sich der Sprecher oft auf die Dialoghistorie. »Was kostet es?« beinhaltet die Anapher »es«, die in einem bestimmten Kontext zum Beispiel zu »Benzin« aufgelöst werden kann.

Fahrzeugwissen

Der Zugriff auf die Fahrzeugdaten ist sehr hilfreich. Neben dem Benzinstand könnte beispielsweise so auch die benötigte Treibstoffsorte bekannt sein.

Benutzerprofil

Das System kann sich Vorlieben des Benutzers merken, zum Beispiel eine Präferenz zu E5 oder E10.

Weltwissen

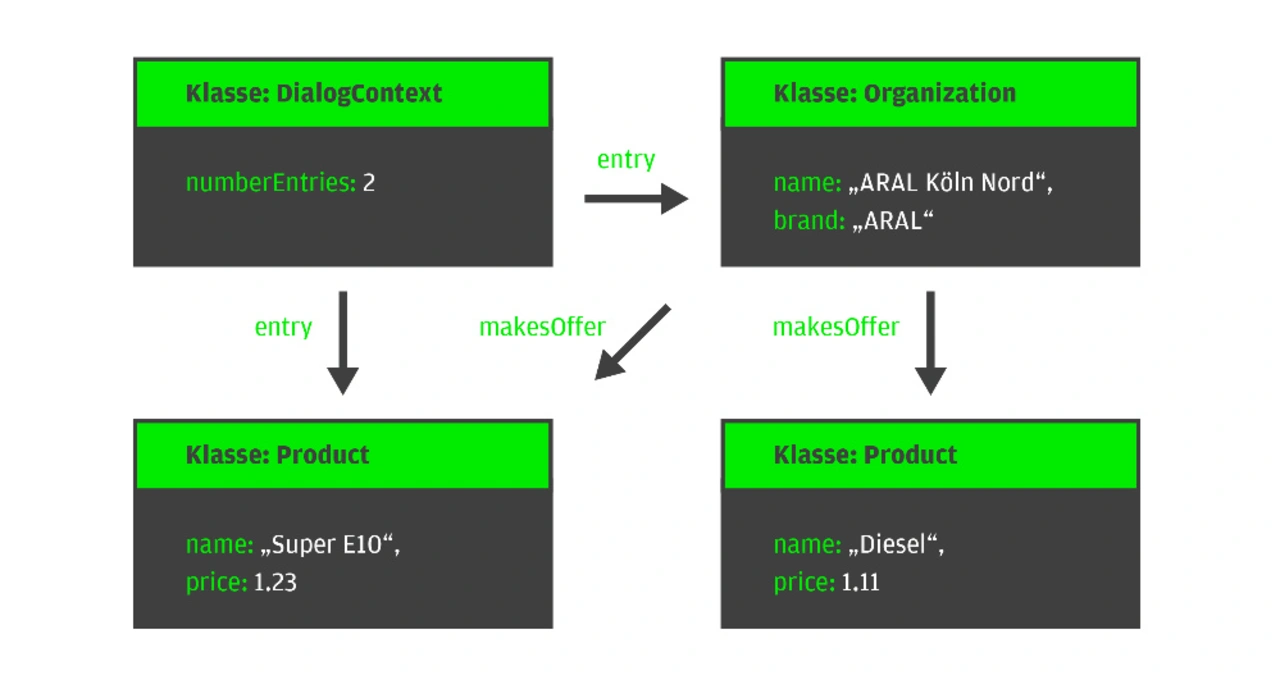

Der Assistent benötigt eine Beschreibung aller sprachrelevanten Dinge, genannt Klassen, und deren Eigenschaften. Zusätzlich muss er die Beziehungen zwischen den Klasseninstanzen kennen. In diesem Fall: Eine Tankstelle ist eine Organisation; eine Organisation verkauft Produkte; jedes Produkt hat einen Preis (Bild 2).

Externes Wissen

Dynamische Eigenschaften von Klassen können über eine REST API eingebunden werden, etwa der aktuelle Preis des Produktes Benzin E10 an einer Tankstelle. Externes Wissen wird auch für Anfragen wie »Ist der Supermarkt noch offen?« oder »Was bedeutet die gelbe Warnleuchte?« benötigt.

Situativer Kontext

Wissen über die nähere Umgebung kann über die Position des Autos bezogen werden oder systemintern, indem alles grafisch Sichtbare zugänglich gemacht wird. So kennt das System die Supermärkte innerhalb eines bestimmten Radius oder einen im Display angezeigten Defekt. Selbst wenn das geforderte Wissen umfassend verfügbar ist, kann es nur dann automatisch verarbeitet werden, wenn es in einer einheitlichen Form dargestellt wird. Die einheitliche Darstellung von Klassen wie einer Organisation, einzelnen Instanzen (z. B. Esso-Tankstelle Köln Nord vom Typ Organisation) und Relationen (z. B. »makesOffer«, um die Tankstelle in Relation zu bestimmten Produkten zu setzen) erfolgt in Form einer Ontologie. Mithilfe dieser einheitlichen Beschreibung ist es möglich, automatische Schlussfolgerungen zu ziehen (»Reasoning«) und hilfreiche Antworten zu generieren (Bild 3). Dialoge, die den Kontext richtig berücksichtigen, können multimodal und ergebnisorientiert sein und natürlich ablaufen. Nutzer können sich ganz auf die Fahrt konzentrieren.

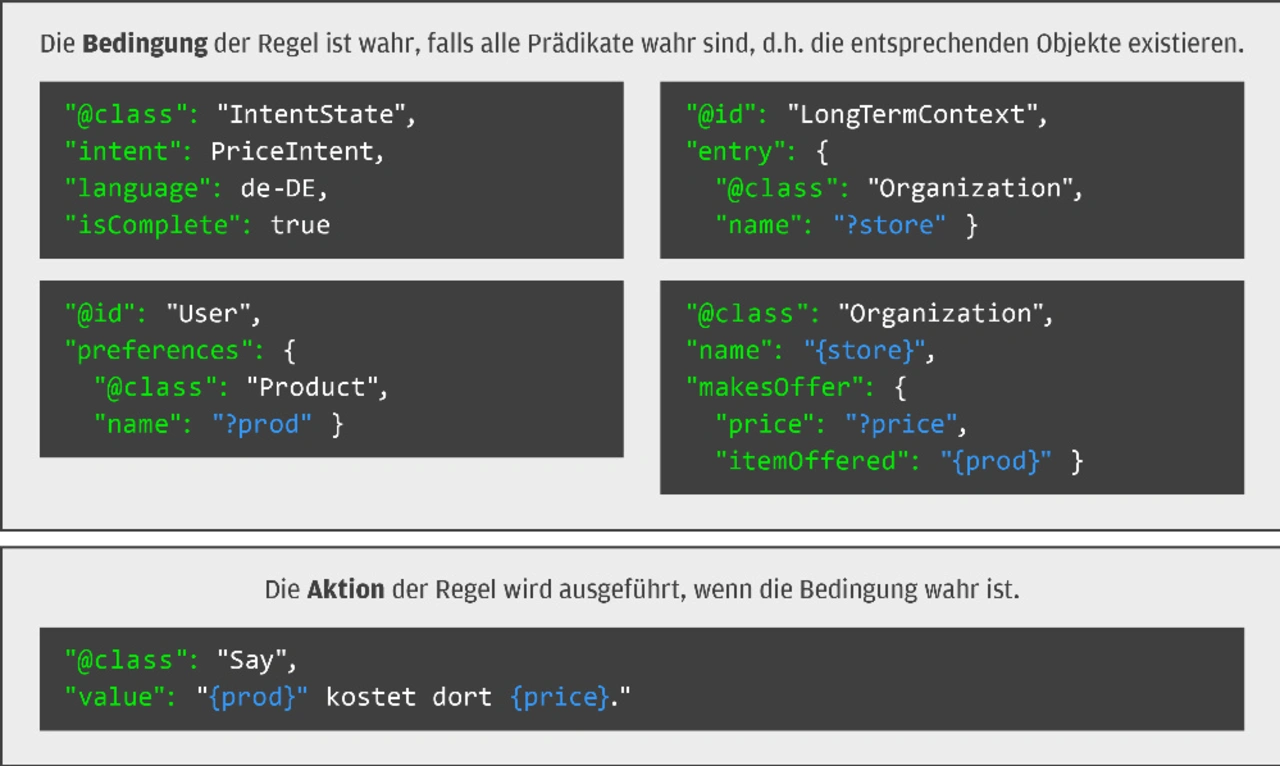

Die Hauptmerkmale dieses Ansatzes sind das Beschreibungsformat, die Wissensabstraktion zum bedarfsorientieren Herunterladen von externem Wissen, die Integration neuer Wissensquellen sowie eine Rule-Engine im Back-End. Diese initiiert und beantwortet Dialoge oder stellt Rückfragen unter Zuhilfenahme der Ontologie, den darin beschriebenen Regeln und der Wissensdatenbank (Bild 4). Diese Aspekte sind unabhängig vom eingebundenen Sprachassistenten; die Dialoge lassen sich ohne Aufwand auf einen oder mehrere andere Assistenten übertragen.

Dieser informationsbasierte Ansatz erlaubt es, rein deklarativ und ohne Programmierung die Sprachassistenten zu erweitern und individuelle Funktionalitäten sowie Dialogverhalten für verschiedene Fahrzeugmarken zu entwickeln. Mit einem entsprechenden Tooling sind automatisierte Dialogtests auch ohne jeglichen Sprachassistenten möglich.

Praxisbeispiel »Was kostet es?«

Anhand des folgenden proaktiven Dialoges lassen sich der regelbasierte Ansatz und die Einbindung von Wissen kurz skizzieren.

System: Sie müssen demnächst tanken. Nach Köln sind es noch 50 km, das Benzin reicht aber nur für 30 km.

Fahrer: Danke. Wo kann ich tanken?

System: Die billigste Tankstelle auf dem Weg ist eine Aral in 20 km.

Fahrer: Was kostet es?

System: Super E10 kostet dort 1,23 EUR.

Fahrer: Okay, fahre mich dorthin.

System: Alles klar, ich habe die Tankstelle als Zwischenziel hinzugefügt. Wir sind um 18:40 Uhr dort.

»Es« und »dorthin« sind zwei Anaphern. »Was kostet es?« kann mit dem informationsbasierten Ansatz folgend vom System generisch aufgelöst werden,

sodass nicht nur im Tankstellenkontext die richtige Antwort berechnet wird: Nach der semantischen Klassifikation wird das Dialog-Back-End (Bild 1) gestartet. Die Rule Engine prüft verschiedene Regeln. Jede Regel besteht dabei aus Bedingungen und Aktionen. Nur wenige Regeln bedingen die erkannte Benutzerintention: Der »PriceIntent« wird im ersten Teil der Bedingung abgeprüft (Bild 3). Das entsprechende Objekt wurde nach der Erkennung in die Wissensdatenbank geschrieben. Eine weitere zu prüfende Bedingung ist die Existenz einer bestimmten Organisation in der Datenbank. Die Organisation (Variable »{store}« für den Namen) soll ein bestimmtes Produkt (Variable »{prod}«) anbieten. Name der Organisation (Aral) und Name des Produktes (E10) werden mittels paralleler Bedingungen aus der Wissensdatenbank bezogen. Dabei wird geprüft, welche Objekte der Klasse Organisation bzw. Produkt in einem früheren Dialogschritt (LongTermContext) oder mit dem Objekt (User) verknüpft worden sind. Die Syntax »?store und ?prod« bedeutet, dass den Variablen entsprechende Werte zugewiesen werden. Der Preis des Produktes (?price) wird schließlich während der Existenzprüfung der Organisation im Hintergrund durch eine Plug-in-Komponente aufgelöst, welche Preise für Produkte der Klasse Benzin bezieht. Weitere Services wie Preise anderer Produkte werden durch zusätzliche Plug-ins verborgen hinter der Wissensabstraktionsschicht des Sprachbrokers abgedeckt. Letztendlich können alle Bedingungen geprüft werden, da die Objekte in der Wissensdatenbank existieren und die Variablen ?prod, ?store und ?price gelesen werden. Die der Regel folgende Aktion wird ausgeführt (Objekt der Klasse »Say«) und die Antwort »Super E10 kostet dort 1,23 EUR« generiert.

Sprache ist die Zukunft

Auch wenn der Aufbau heutiger Sprachassistenten nicht unbedingt die Anforderungen an natürliche Dialoge erfüllt, ist eine Sprachsteuerung des Autos für viele Konsumenten wünschenswert. Die Funktionalität externer, am Markt verfügbarer Sprachassistenten lässt sich durch serverbasierte Dialogsysteme erweitern und verbessern, um den spezifischen Anforderungen im Fahrzeug gerecht zu werden. Komfortable Nutzung, Intelligenz und eine natürliche Funktionalität der Sprachassistenten sind wichtige Unterscheidungsmerkmale. Fahrzeughersteller können von der sich rasant entwickelnden Technologie und Qualität der Sprachsteuerung stark profitieren und sich auf diese Art und Weise profilieren. Nach der serienmäßigen Integration von hochwertigen Sprachassistenten in den ersten Luxusklassemodellen, ist von einer starken Weiterentwicklung und Verbreitung von Sprachsteuerungen im Auto auszugehen. UH

Die Autoren