Hochgeschwindigkeit für Medizingeräte

Oszilloskop-Zauber für die Signalintegrität

Höhere Datenraten, höher aufgelöste Bilder und mehr Edge Computing: Die Herausforderungen für die Signalintegrität bei medizinischen Systemen nehmen zu. Mit Oszilloskopen können Medizintechnikentwickler das Risiko für Patienten klein halten und wirksame sowie sichere Produkte auf den Markt bringen.

Digitale Hochgeschwindigkeitstechnologie treibt das Wachstum und die Entwicklung komplexer medizinischer Systeme voran und ermöglicht eine verbesserte Leistung, Präzision und Effizienz in vielen Bereichen der Gesundheitsversorgung. Medizinische Bildgebungssysteme spielen eine entscheidende Rolle bei der Früherkennung und Diagnose in verschiedenen Bereichen des Gesundheitswesens wie Orthopädie, Geburtshilfe, Neurologie, Kardiologie und anderen.

Chirurgische Roboter, Krankenhausroboter und Telemedizinsysteme helfen Ärzten bei der Erkennung und Diagnose von Krankheiten, verbessern die Versorgung und verlängern das Leben. All diese Funktionen werden durch digitale Hochgeschwindigkeitssignale ermöglicht, und so wird die Signalintegrität in diesen Medizinsystemen wichtiger als je zuvor.

Software hilft, birgt aber auch Risiken

Ein Großteil des Wertes der innovativen, komplexen medizinischen Systeme ergibt sich aus intelligenten Softwarefunktionen. Die Software in medizinischen Geräten verarbeitet und entfernt Rauschen aus Bildern, erzeugt 3D-Bilder und trainiert und nutzt neuronale Netzwerke, die Bilder segmentieren und klassifizieren. Bei MRTs beispielsweise können Softwarealgorithmen Anomalien wie Tumore oder Frakturen erkennen und hervorheben und so den Radiologen bei der Diagnose unterstützen. Der verstärkte Einsatz von Software ermöglicht es, diese komplexen medizinischen Systeme in immer anspruchsvolleren Anwendungen einzusetzen, bei denen Zuverlässigkeit, Geschwindigkeit und geringe Latenzzeiten für die Sicherheit der Patienten entscheidend sind.

Das bedeutet, dass die digitale Hardware der Geräte für eine schnellere Datenerkennung, -erfassung und -verarbeitung mehr und schnellere numerische Prozessoren und Bild-Shading-Prozessoren, schnellere Speicher, höhere Taktraten, höhere Bildwiederholraten, schnellere Verbindungen sowie fortschrittliche digitale Logiktechnologien und mehrstufige Signalisierungsschemata einschließlich PAM4, PAM8, PAM16 und NRZ-Logik (Non-Return-to-Zero) enthalten muss. Darüber hinaus sorgen die zunehmende Cybersecurity-Bedrohung und die behördlichen Anforderungen an den Schutz von Patientendaten für eine zunehmende Verwendung von digitaler Hardware zur Datenverschleierung, Verschlüsselung und Gültigkeitsprüfung.

Neue Herausforderungen beim Test

Der zunehmende Einsatz von digitaler Hochgeschwindigkeits-Hardware führt aus mehreren Gründen zu komplexen Testherausforderungen. Die Identifizierung von geringen Bitfehlerraten ist aufgrund der potenziellen Auswirkungen auf die Patientensicherheit und die Zuverlässigkeit von medizinischen Geräten besonders wichtig. Steigende Datenmengen bedeuten, dass selbst kleine Bitfehlerraten zu mehr Fehlern führen, da sie sich im Laufe der Zeit schnell ansammeln können. Die medizinische Diagnostik hängt in hohem Maße von der Genauigkeit der digitalen Daten ab, die zwischen den verschiedenen Komponenten des Systems übertragen werden. So können beispielsweise bei bildgebenden Diagnosesystemen wie MRT- oder CT-Scannern Fehler bei der Datenübertragung oder -verarbeitung die aus umfangreichen digitalen Daten erzeugten Bilder verzerren, was zu Fehlinterpretationen oder Fehldiagnosen führen kann.

Die erhöhte Komponentendichte auf Leiterplatten in digitaler Hochgeschwindigkeits-Hardware bedeutet, dass die Leiterplatten weniger Platz für Leiterbahnen haben, was zu mehr Schichten auf der Leiterplatte und mehr Testherausforderungen führt. Die engere Bestückung der Komponenten kann zu höheren Leistungsdichten und lokaler Erwärmung auf der Leiterplatte führen. Bei medizinischen Geräten, bei denen eine präzise Temperaturkontrolle für die Funktionalität des Geräts und die Sicherheit der Patienten unerlässlich ist, kann ein unzureichendes Wärmemanagement zu Überhitzung, Komponentenausfällen oder thermisch bedingten Leistungseinbußen führen.

Bei digitaler Hochgeschwindigkeits-Hardware ergeben sich mehrere zusätzliche Testherausforderungen. Höhere Taktfrequenzen und Datenraten verringern die Toleranz der Augendiagramme gegenüber Signalrauschen und Jitter. Mehrlagige Leiterplatten mit mehr Durchkontaktierungen erfordern komplizierte Fertigungsprozesse zur Verbesserung der Signalintegrität. Außerdem erfordert die höhere Komponentendichte schmalere Leiterbahnen, was die Wahrscheinlichkeit unvorhergesehener Unterbrechungen im Vergleich zu breiteren Leiterbahnen erhöht. Der geringere Abstand zwischen den Leiterbahnen erhöht auch die Anfälligkeit für Übersprechen, entweder durch magnetische Felder, die Spannungen auf den Leiterbahnen induzieren, oder durch elektrische Felder, die parasitäre Kapazitäten verursachen.

Simulation vor der Fertigung

Um die Herausforderungen beim Testen von digitaler Hochgeschwindigkeits-Hardware zu meistern und die Risiken bei medizinischen Systemen zu verringern, ist es von entscheidender Bedeutung, den Betrieb der Leiterplatte zu simulieren, bevor das Design an die Fertigung übergeben wird. Simulationen können zwar nicht alle potenziellen Probleme aufdecken, aber sie tragen entscheidend dazu bei, so viele wie möglich zu identifizieren. Die Simulation vor der Fertigung bietet mehrere Vorteile. Sie hilft dabei, die tatsächliche Leistung der Leiterplatte zu verbessern und die Anzahl der erforderlichen Iterationen des Hardware-Prototyps zu reduzieren, was Zeit und Geld spart.

Die Simulation beschleunigt auch die Durchlaufzeit für Prototypen und minimiert den Bedarf an ungeplanten Änderungen an der Leiterplatte, die vorgenommen, getestet und dokumentiert werden müssen. Sie ermöglicht es, Firmware- und Softwaretests mit weniger fehlerhaften Signalen durchzuführen, die fälschlicherweise für Bugs gehalten werden könnten. Darüber hinaus wird die Bedeutung der Lösung dieser Probleme bei fortgeschrittenen digitalen Logikprotokollen wie PAM4, PAM8, PAM16 und NRZ, die weniger tolerant gegenüber Schwankungen der Signalqualität sind, noch verstärkt.

Mithilfe von Simulationssoftware lässt sich die Signalintegrität von komplexen Hochgeschwindigkeits-Leiterplatten (PCBs) analysieren.

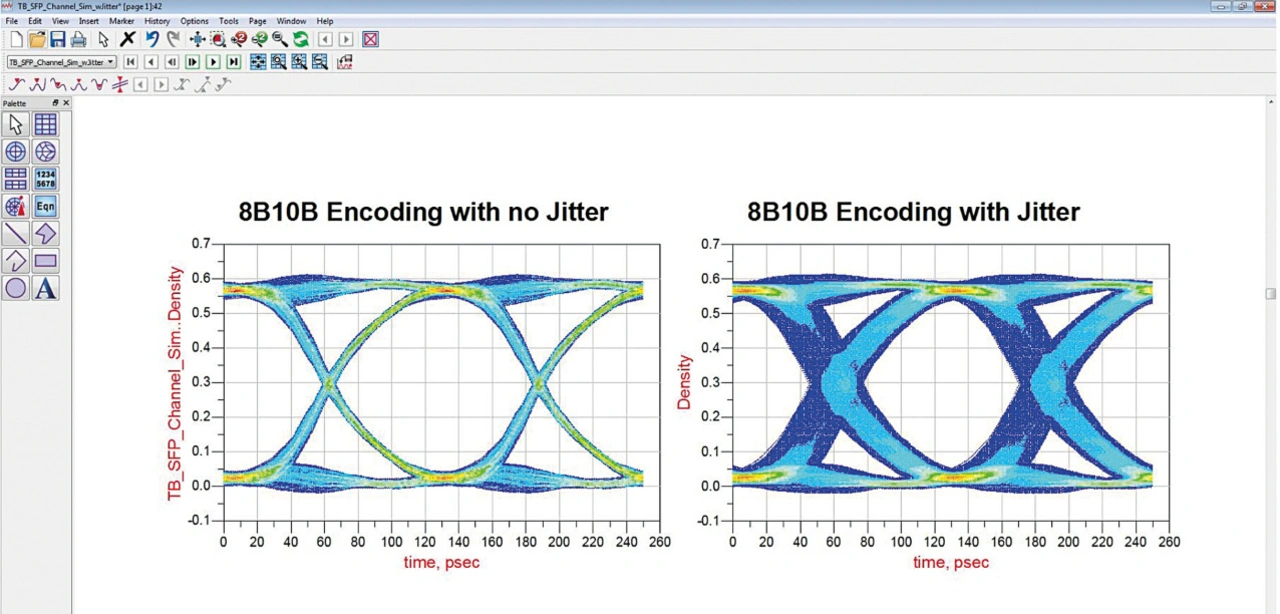

In Bild 1 ist ein Beispiel für eine Simulationssoftware zu sehen, die die Auswirkungen von Jitter auf ein Augendiagramm analysiert. Gleichzeitig können die Verluste und Kopplungen von Signal- und Leistungsnetzen charakterisiert werden. Die Simulationssoftware hilft auch bei der Extraktion und nahtlosen Übertragung eines genauen elektromagnetischen (EM-)Modells für die Verwendung in den ADS-Simulatoren für transiente Vorgänge und Kanäle. Außerdem sparen schnelle Prüfungen der Leiterbahnimpedanz Zeit, bevor eine EM-Extraktion durchgeführt wird. So verringert sich das Risiko von Fehlern in den Daten oder Bildern der Patienten.

Test der Signalintegrität nach der Fertigung

Auch wenn eine Simulationssoftware für die Signalherstellung eingesetzt und die Leiterplatte mit großer Sorgfalt entworfen und hergestellt wird, sollte die Signalintegrität der Leiterplatte nach der Herstellung aus verschiedenen Gründen mit einem Oszilloskop gemessen werden. Trotz Einhaltung der Spezifikationen gibt es immer wieder Abweichungen innerhalb der Bauteile, die von der Signalintegritätssoftware nicht vollständig berücksichtigt werden können. Darüber hinaus besitzen die Bauteile oft inhärente analoge parasitäre Eigenschaften wie z. B. Impedanz, Kapazität und Induktivität, die nicht spezifiziert sind.

Der SMT-Bestückungsprozess ist anfällig für Schwankungen, was dazu führen kann, dass die Bauteile nicht auf den Pads zentriert sind. Auch der Lötschablonenprozess kann nicht durchgängig perfekte »Bricks« aus Lot erzeugen, wobei die Größe der Lotablagerungen bei wiederholter Verwendung abnimmt. Die chemische Zusammensetzung und die Eigenschaften des Lots können sich im Laufe der Zeit geringfügig ändern, was sich auf die Verbindung von Lötstellen zwischen Kupferpads und SMT-Komponenten auswirkt. Außerdem können normale Schwankungen im Reflow-Ofen das Reflow-Verhalten des Lots beeinflussen. Auch wenn die Lötstellen eine elektrische Verbindung herstellen, sind sie möglicherweise nicht ausreichend gelötet, wie dies bei Gull-Wing-Bauteilen ohne Verrundung, passiven SMT-Widerständen mit Billboarding oder Head-in-Pillow-Ball-Grid-Array-Verbindungen (BGA) der Fall ist. Der Einsatz eines Oszilloskops nach der Fertigung ist unerlässlich, um potenzielle Probleme mit der Signalintegrität, die sich aus diesen Faktoren ergeben, umfassend zu bewerten und zu lösen.

Oszilloskope als Diagnose-Tool

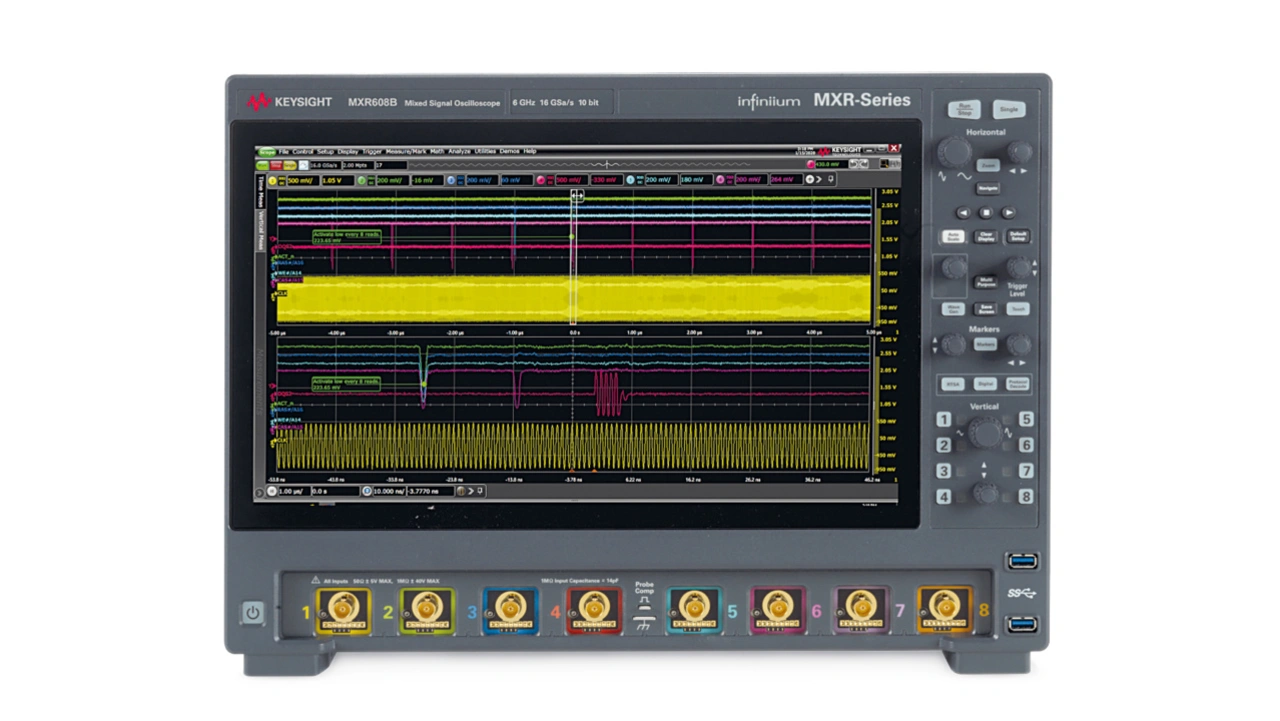

Oszilloskope sind das Tor zu den komplizierten Wechselwirkungen komplexer Designs. Ein Oszilloskop, mit dem sich bis zu acht Kanäle gleichzeitig messen lassen, hilft bei der schnellen Suche nach Signalintegritätsproblemen in der gefertigten Leiterplatte, wie in Bild 2 dargestellt. Mit einem Oszilloskop können Logikanalysen, Echtzeit-Spektralanalysen (RTSA), Analysen serieller Protokolle, die Erzeugung von Signalen sowie Frequenzgang- und Phasenrauschtests durchgeführt werden. Da der Bedarf an höheren Datenübertragungsgeschwindigkeiten in medizinischen Systemen zu höheren Datenraten und eng beieinander liegenden parallelen Datenleitungen geführt hat, nimmt die elektromagnetische Kopplung, das sogenannte Übersprechen, zu.

Darüber hinaus können Stromversorgungen auf den von ihnen angesteuerten Datenleitungen Störungen in Form von Rauschen und Jitter verursachen und sind anfällig für datenabhängiges Rauschen wie z. B. simultanes Schaltrauschen (SSN), das zu Ground Bounce führt. Oszilloskope erkennen und quantifizieren das Vorhandensein von Übersprechen, bestimmen, welche Aggressoren hauptsächlich verantwortlich sind, und erkennen und diagnostizieren Jitter, vertikales Rauschen und Phasenrauschen. (uh)