Brainchip: 2. KI-Plattform

KI für »jedermann«

Fortsetzung des Artikels von Teil 2

Benchmark-Ergebnisse

Zunächst verweist Nayampally auf Beispiele im Bereich Objekterkennung in Videos, und zwar mit zwei verschiedenen Ansätzen: Event-based Vision und Frame-based Vision. Geht es um Event-based Vision, so kommt Akida TENN im Vergleich zu Gray.Retinanet laut Nayampally auf eine 30 Prozent bessere Genauigkeit, und das bei deutlich weniger Berechnungen (30-mal weniger) und Parametern (50-mal weniger). Bei Frame-Based Vision auf Basis des KITTI-2D-Datensatzes schneidet Akida Tenn ebenfalls hervorragend ab. Laut seiner Aussage kommt Brainchip auf dieselbe Genauigkeit wie Sim CLR (Resnet50), braucht aber ebenfalls deutlich weniger Parameter (50-mal weniger) und Berechnungen (fünfmal weniger). Nayampally weiter: »Wir sind aber deutlich effizienter, die Leistungsaufnahme liegt bei 30 fps unter 75 mW, wenn das IP mithilfe eines 16-nm-Prozesses implementiert wird.«

Jobangebote+ passend zum Thema

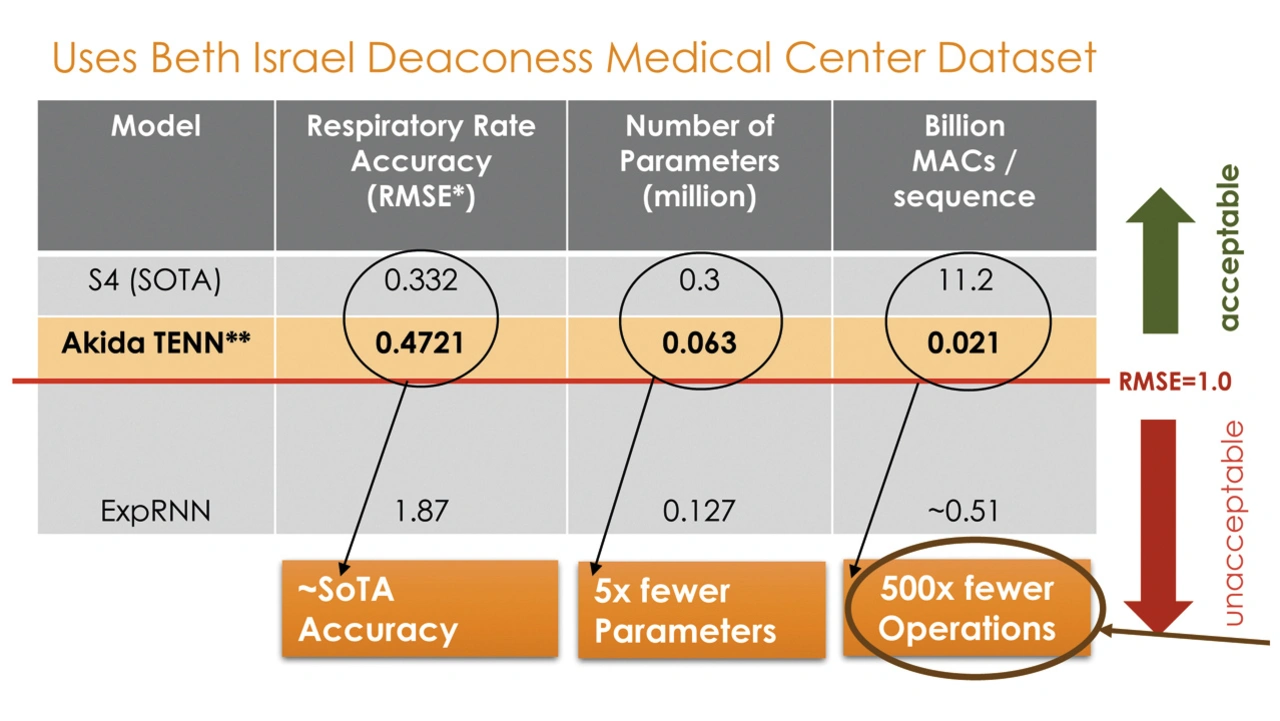

Auch wenn es um das Gesundheitswesen geht, schneidet das Brainchip-IP sehr gut ab. »Wearables oder tragbare Geräte können Vitalsignale wie Herzfrequenz, Atemfrequenz oder Sauerstoffsättigung nur schwer vorhersagen. Und für diese Signalarten funktionieren Vorverarbeitungstechniken wie beispielsweise MFCC nicht sonderlich gut, weshalb typischerweise neuronale Netze genutzt werden, die direkt mit den Rohdaten arbeiten und auf Basis derer Vorhersagen machen können. Darüber hinaus muss in solchen Anwendungen eine hohe Genauigkeit erreicht werden«, erklärt Nayampally. Weil es in diesem Bereich gar nicht so einfach ist, Vergleiche zu ziehen, hat sich Brainchip für einen Datensatz vom Beth Israel Deaconess Medical Center entschieden und die Ergebnisse eines S4-Algorithmus als Vergleich genutzt. Laut Nayampally kommt Brainchip mit TENN bei der Atemfrequenz von der Genauigkeit fast an die Werte mit S4 heran, im Vergleich zu LSTM-basierten Modellen (LSTM: Long-Short-Term-Memory) schneidet Brainchip aber deutlich besser ab. »Wir benötigen aber im Vergleich zu S4 weniger Parameter und deutlich weniger Berechnungen, sodass wir viel effizienter sind«, so Nayampally weiter. Und ähnlich sieht es bei der Herzfrequenz aus, auch hier kommt TENN auf eine ähnliche Genauigkeit wie S4, und das mit deutlich weniger Parametern (Faktor 5) und Berechnungen (Faktor 500). »Also auch in diesem Fall lassen sich mit unserem IP durchaus konkurrenzfähige Mobile/Portable Edge-Geräte realisieren«, so die Überzeugung von Nayampally.

Zustimmung von der Industrie

Nicht nur Nayampally ist überzeugt, dass Brainchip mit seiner Akida-Plattform der zweiten Generation ein wirklicher Durchbruch gelungen ist. So erklärt Richard Wawrzyniak, Principal Analyst bei Semico Research, beispielsweise: »Fortschritte in der KI erfordern parallele Fortschritte bei den Lernfähigkeiten auf dem Baustein, während gleichzeitig die Herausforderungen der Effizienz, Skalierbarkeit und Latenz überwunden werden müssen. Brainchip hat mit Akida bewiesen, dass es in der Lage ist, ein wirklich intelligentes Edge zu schaffen, und setzt damit einen weiteren Meilenstein in der Entwicklung und dem Einsatz von Edge-KI-Lösungen. Die Vorteile von On-Chip-KI aus einer Leistungs- und Kostenperspektive sind schwer zu leugnen.«

Hardware ist das eine, Software das andere. Aber auch hier kann Brainchip liefern. Das Unternehmen stellt die Software und das entsprechende Tooling bereit, inklusive

- einer effizienten Runtim-Engine, die Modellbeschleunigungen autonom und für den Entwickler völlig transparent steuert, und

- MetaTF-Software – diese Software können Entwickler mit ihrem bevorzugten Framework, z. B. TensorFlow/Keras, oder ihrer Entwicklungsplattform, z. B. Edge Impulse, kombinieren, um KI-Lösungen einfach zu entwickeln, zu tunen und einzusetzen.

Akida unterstützt alle Arten von Convolutional Neural Networks (CNN), Deep Learning Networks (DNN), Vision Transformer Networks (ViT) sowie Spiking Neural Networks (SNNs).

Darüber hinaus ist Akida auch mit einem Modell-Zoo und einem wachsenden Ökosystem von Software-, Tool- und Modellanbietern sowie von IP-, SoC-, Foundry- und Systemintegrator-Partnern ausgestattet. Derzeit arbeitet BrainChip mit Early Adopters an der IP-Plattform der zweiten Generation. Die allgemeine Verfügbarkeit wird im 3. Quartal 2023 erfolgen.

- KI für »jedermann«

- Eine Plattform – skalierbar für viele Anwendungen

- Benchmark-Ergebnisse