Energieeffizienter Prozessor AM62A

Entwicklung smarter Edge-KI-Kameras

Der AM62A ist ein energieeffizienter KI-Prozessor mit integriertem ISP und Deep-Learning-Beschleuniger. Er eignet sich ideal für smarte Kamerasysteme mit bis zu zwei Kameras – etwa in Industrie und Automotive – und ermöglicht leistungsstarke Edge-KI bei nur 2 W Leistungsaufnahme.

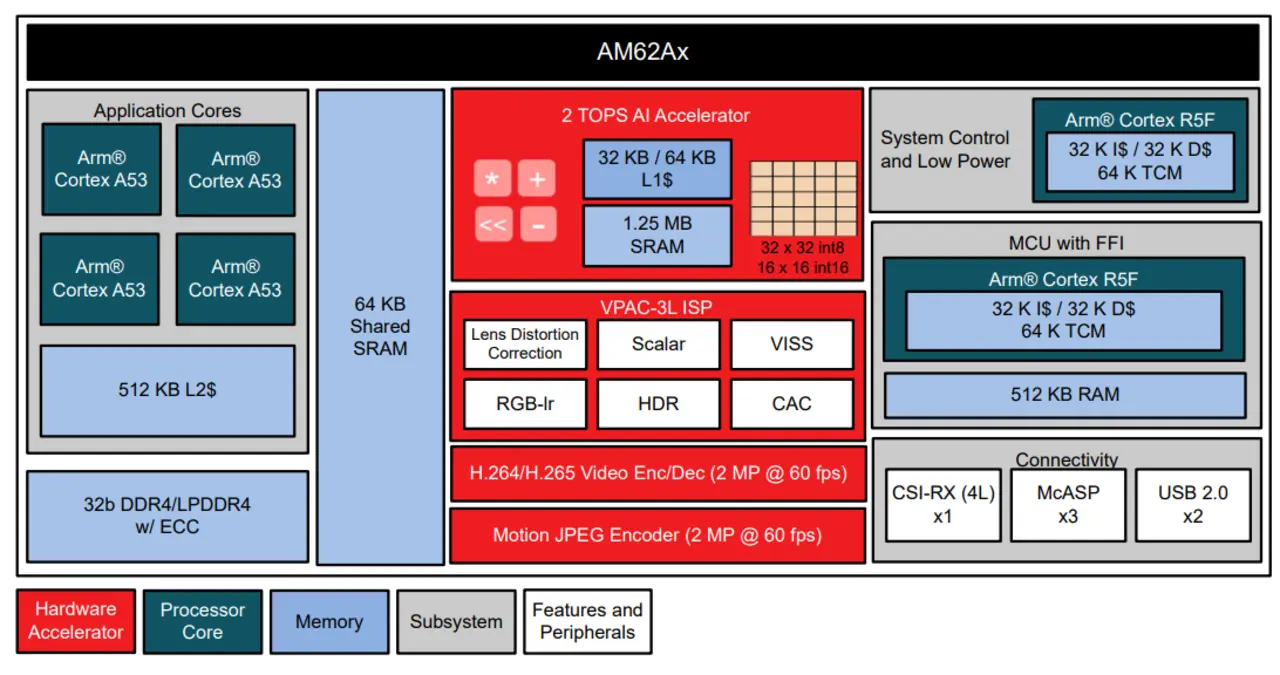

Der Prozessor AM62A von Texas Instruments ist für Bildverarbeitungs-Anwendungen der unteren bis mittleren Kategorie mit einer oder zwei Kameras vorgesehen. Er ist mit einem KI-Beschleuniger, einem H264/H265-Encoder/Decoder sowie einem Image Sensor Processor (ISP) mit RGB-Ir-Unterstützung ausgestattet und für Anwendungen im Industrie- und Automotive-Bereich (z. B. Überwachungskameras, Sportkameras, Machine-Vision-Systeme, Scanner für den Einzelhandel und Kameras in Kraftfahrzeugen) geeignet.

Intelligentere Kameras im Edge

Die Verwendung künstlicher Intelligenz (KI) in eingebetteten Systemen im Edge hat stark steigende Tendenz, da das Verarbeiten und Analysieren komplexer Daten immer wichtiger wird, um Städte, Fabriken, Automobile und Gebäude intelligenter und effizienter zu machen. Mit Computer Vision (CV) und Machine Learning (ML) lassen sich beispielsweise aus Bildern umfangreiche Informationen extrahieren.

Bildauswertung und ML-Inferenz erfolgten in den letzten Jahren vorwiegend in der Cloud, da Embedded-Geräte nicht mit der nötigen Verarbeitungsleistung aufwarten konnten, um das von Kameras generierte hohe Datenaufkommen zu bewältigen. Die Popularität von SoCs, die sich für Deep-Learning-Applikationen und andere komplexe Analysen eignen, nimmt zu, jedoch geht es hier nicht ohne eine sorgfältige Abwägung zwischen Stromverbrauch und Leistungsfähigkeit.

Der AM62A mit seinen vier Cortex-A53-Kernen ist im unteren Segment des AM6xA-Portfolios einzuordnen. Er erreicht eine KI-Verarbeitungsleistung von 2 TOPS bei einer Leistungsaufnahme von typisch 2 W und voller Auslastung und ist sich für Anwendungen mit knappem Kosten- und Energiebudget geeignet.

Jobangebote+ passend zum Thema

Anwendungsgebiete für smarte Kameras

Entscheidend für die Entwicklung eines robusten und smarten Kamerasystems ist die Wahl des richtigen Bildsensors. Während für eine private Überwachungskamera möglicherweise ein 5-MP-Sensor mit 30 fps und Rolling-Shutter-Technik ausreichend ist, kann beispielsweise für die Kennzeichenerfassung an einer Mautstelle ein 2-MP-Sensor mit 60 fps und Global-Shutter-Technik die bessere Wahl sein, da hier die Kennzeichen schnell vorbeifahrender Fahrzeuge erfasst werden müssen. Für die industrielle Defekterkennung wiederum empfiehlt sich möglicherweise eher ein 2-MP-Grauskalensensor mit 90 fps und ebenfalls mit Global Shutter. Enthält der Bildsensor aus Kostengründen keinen eigenen ISP (Image Sensor Processor), kann ein Prozessor aus der AM6xA-Familie mit integriertem ISP dazu beitragen, das Leiterplattendesign zu vereinfachen, den Bauteileaufwand zu verringern und vor allem auch die End-to-End-Latenz und die DDR-Auslastung zu reduzieren.

Die Verarbeitungsanforderungen variieren von einer Applikation zur anderen. ML-Aufgaben wie die Bildklassifizierung benötigen weniger Ressourcen als das Erkennen von Personen oder Fahrzeugen samt ihren jeweiligen Positionen. Noch komplexer wird es, wenn für einzelne Pixel bestimmt werden muss, ob sie zu einem Objekt (z. B. einer Fahrbahnmarkierung) gehören oder nicht. Selbstverständlich führt auch ein Anheben der Auflösung zu einem deutlichen Anstieg der Verarbeitungsanforderungen. Die Deep-Learning-Beschleunigungshardware der AM6xA-Prozessoren kann all diese rechenintensiven Aufgaben übernehmen.

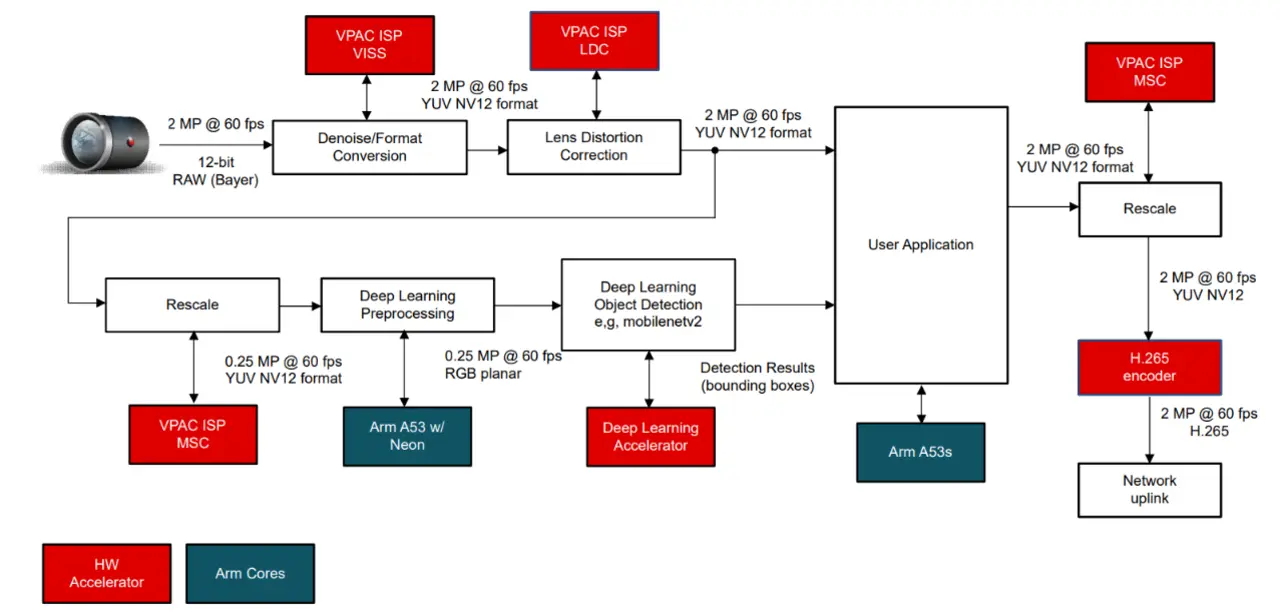

Gut illustrieren lassen sich die Fähigkeiten des AM62A an einer Überwachungskamera-Applikation. Die Videoframes werden hier über den MIPI CSI-2-Port von der Kamera entgegengenommen, und über dieselbe Schnittstelle sendet der Prozessor Konfigurationsparameter beispielsweise für den Weißabgleich an die Kamera zurück. Nach Aufbereitung durch den im AM62A enthaltenen ISP des Typs VPAC-3L stehen nutzbare RGB-Bilder zur Verfügung. Weitwinkelbedingte Bildverzerrungen lassen sich mit der LDC-Funktion (Lens Distortion Correction) des ISP beseitigen, und zusätzlich kann der ISP die weitere Aufbereitung des Bilds beispielsweise für ein ML-Modell zur Erkennung von Menschen, Fahrzeugen oder Tieren übernehmen. Das ML-Modell läuft auf der Deep-Learning-Beschleunigerhardware des Prozessors und kann bei Bedarf einen Alarm auslösen oder einen H.265-codierten Clip des relevanten Ereignisses über das Netzwerk versenden. Bild 2 zeigt ein Blockschaltbild mit exemplarischen Werten für Auflösung, Framerate und Pixelformat.

Deep Learning mit dem AM62A

Deep Learning ist zwar nicht mit Edge-KI gleichzusetzen, hat aber viel damit zu tun. Moderne neuronale Netze sind besser als Menschen in der Lage, präzise Klassifizierungs-, Objekterkennungs- und semantische Segmentierungsaufgaben wahrzunehmen, und um diese an der Edge zu implementieren, muss die passende Hard- und Software zur DL-Beschleunigung vorhanden sein. Nur so kann ein zuverlässiges und effizientes System entstehen.

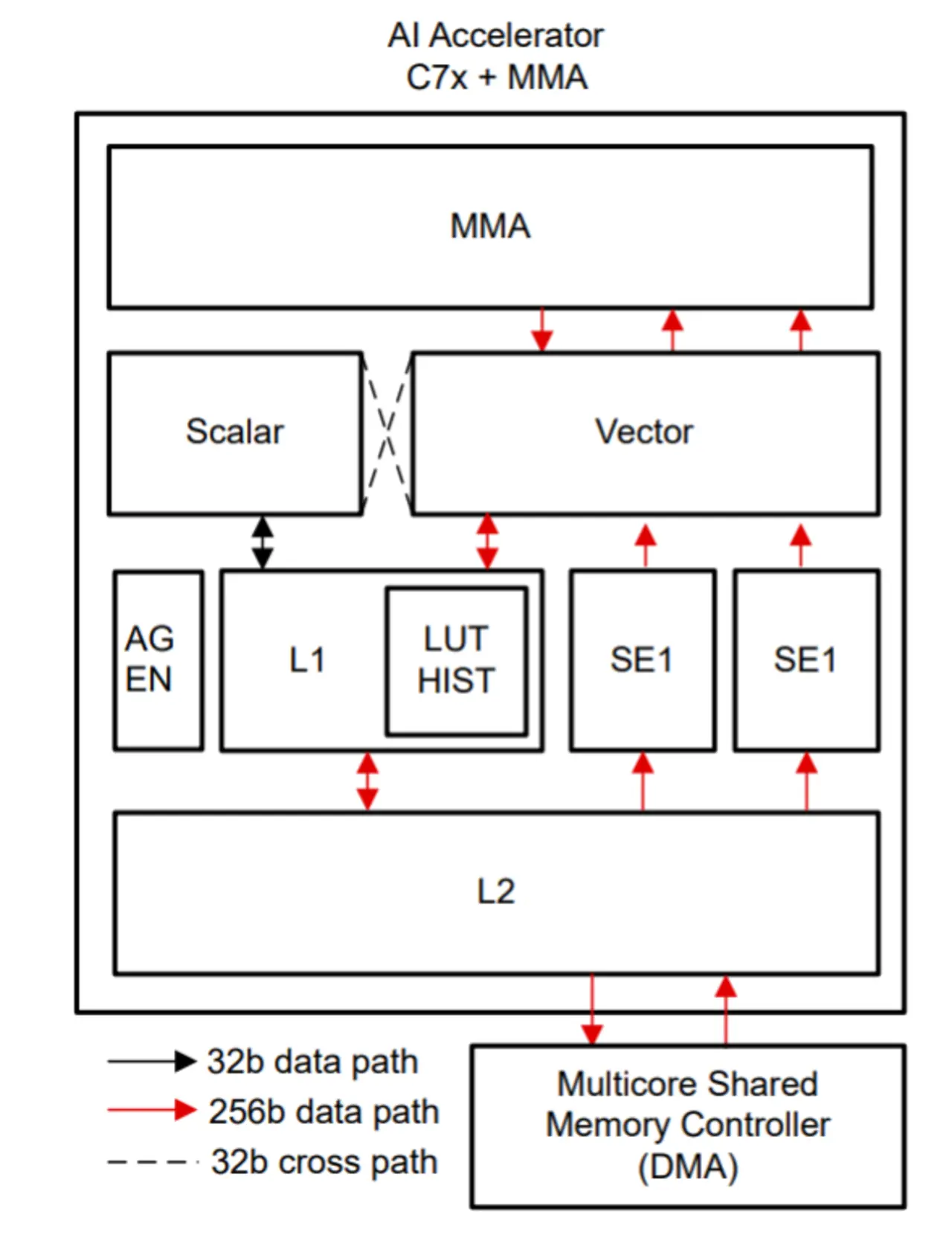

Der Deep-Learning-Beschleuniger des AM62A besteht aus einem 256bit-DSP vom Typ C7x und einem MMA (Matrix-Multiply Accelerator), der in einem einzigen Taktzyklus Multiplikationen von 32x32-Matrizen mit 8bit-Integerwerten ausführen kann, was bei der maximalen Taktfrequenz von 1 GHz eine Rechenleistung von 2 TOPS ergibt. Obwohl der TOPS-Wert eine gängige Größe zur Quantifizierung der ML-Performance von Beschleunigern ist, kann eine bestimmte Architektur überlegen sein, obwohl ihre theoretische Rechenleistung geringer ist. Die von TI gewählte Architektur (Bild 3) nutzt mit der MMA eine größere Recheneinheit anstatt mehrerer kleinerer, die mehr Speichertransfers erfordern und dadurch den Stromverbrauch erhöhen würden. Spezielle Data-Streaming-Einheiten sorgen dafür, dass die 256bit-Puffer im Beschleuniger stets mit den notwendigen Daten befüllt werden, und optimierte Applikationen nutzen ein Modell, das den MMA auf jeder Ebene vollständig ausfüllt.

Edge-KI-Software

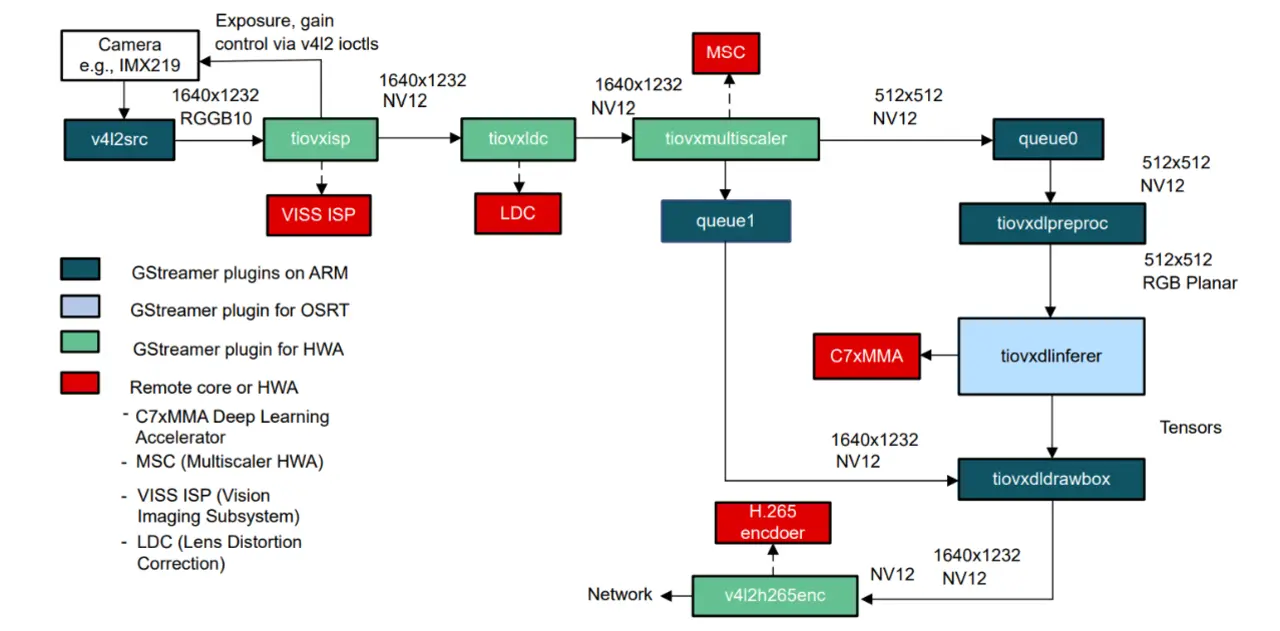

TI hat große Anstrengungen unternommen, um die Entwicklung und Evaluierung von Edge-KI-Anwendungen auf Prozessoren mit eingebauten Hardwarebeschleunigern einfacher zu machen. Tools helfen bei der Auswahl, beim Training und bei der Verfeinerung eines Modells, bei seiner Evaluierung und schließlich beim Deployment auf dem Prozessor. Linux ist das dominierende Betriebssystem für Edge-KI-Anwendungen, und die Edge AI Out-of-Box Demos von TI beschleunigen die Entwicklung von C++- und Python-Anwendungen. Die Demos wurden mithilfe von Gstreamer entwickelt, und neben Open-Source-Runtimes (TFLite, ONNX, TVM) steht auch OpenCV auf den Linux-Builds von TI für jene Bildverarbeitungs-Operationen zur Verfügung, die von Hardwarebeschleunigern nicht direkt unterstützt werden. Bild 4 verdeutlicht das hier angewandte Konzept.

VPAC – eine Kombination aus Bildverarbeitungs-Beschleuniger und ISP

Mit dem VPAC-3L steht die siebte ISP-Generation (Image Sensor Processor) zur Verfügung. Zur Unterstützung von Bildsensoren mit Raw-Ausgang führt der Hardwarebeschleuniger Bildverarbeitungs-Funktionen aus. Das Vision Imaging Sub-System (VISS) des Bausteins ist ein traditioneller ISP, der unter anderem das Entrauschen, die Korrektur chromatischer Aberrationen und das HDR-Encoding (High Dynamic Range) übernimmt. Die De-Mosaicing-Funktion unterstützt RGB-Ir zur Aufnahme hochauflösender Infrarotbilder. Ebenfalls im VPAC-3L enthalten ist ein Subsystem zur Korrektur von Bildverzerrungen, die insbesondere bei Kameras mit Fischaugen-Objektiv auftreten.

Die Multiscalar-Engine (MSC) des VPAC-3L ermöglicht mit ihren zwei Eingängen und zehn Ausgängen das unabhängige Kopieren und Skalieren von Bildern. Zum Beispiel lässt sich ein Bild einerseits für Machine-Learning-Zwecke herabskalieren, während andererseits die ursprüngliche Version in voller Größe erhalten bleibt, um das ML-Resultat in das Frame mit voller Auflösung einblenden zu können. Die MSC-Einheit erlaubt eine Größenreduzierung bis um den Faktor 4 entlang jeder Achse und interpoliert bei Bedarf.

TI unterstützt eine ganze Reihe von Bildsensoren und Modulen und arbeitet mit externen Unternehmen zusammen, um neue Kamerasensoren durch Treiberunterstützung und Feinabstimmung des ISP zu unterstützen. Mithilfe der ISP Tuning Tools können erfahrene Anwender die Feinabstimmung auch selbst übernehmen.

Low-Power-Eigenschaften

Der AM62A ist so konzipiert, dass er die hohen Verarbeitungsanforderungen von Deep-Learning-Algorithmen erfüllt und sich gleichzeitig durch hohe Energieeffizienz auszeichnet. Dank seiner besonders geringen Core-Betriebsspannung von 0,75 V erreicht der Prozessor ein hohes Maß an Effizienz, weshalb er für batteriebetriebene Anwendungen ebenso in Frage kommt wie für thermisch sensible Applikationen.

Der AM62A kann die Deep-Learning-Verarbeitung von Bildern aus einer Kamera mit 5 MP und 60 fps mit einer Leistungsaufnahme von 2 W (unter typischen Betriebsbedingungen) ausführen. Er eignet sich damit ideal für batteriebetriebene Edge Devices, die eine Echtzeit-Bildverarbeitung und Objekterkennung erfordern. Mit den Low-Power-Betriebsarten des Prozessors kann die Leistungsaufnahme noch weiter abgesenkt werden, um den Stromverbrauch zu verringern und die Batterielebensdauer zu verlängern oder die Anforderungen an die Entwärmung zu lockern. Ein von TI angebotenes Power Estimation Tool bietet zusätzlich die Möglichkeit, die Leistungsaufnahme des AM62A in einer bestimmten Anwendung unter Einbeziehung der jeweiligen Rahmenbedingungen (z. B. Betriebsspannung, Frequenz und Sperrschichttemperatur) abzuschätzen.

Zusammenfassung

Der AM62A kann umgehend für die Entwicklung von Smart-Camera-Anwendungen verwendet werden und bringt mit seiner Deep-Learning- und Bildverarbeitungs-Beschleunigung die nötige Leistung für Systeme mit einer oder zwei Kameras mit. Die für diesen Baustein entwickelte Software lässt sich zudem auf Prozessoren mit mehr Leistung und zusätzlichen Interface-Optionen skalieren. Als Hilfestellung beim Design werden ein AM62A Starter Kit EVM und ein Processor SDK angeboten.

Autor:

Reese Grimsley ist Software Applications Engineer bei Texas Instruments