Advertorial

Mit Kria-SOMs Edge-Innovationen beschleunigen

Fortsetzung des Artikels von Teil 1

Adaptive System-on-Modules – kurz SoMs

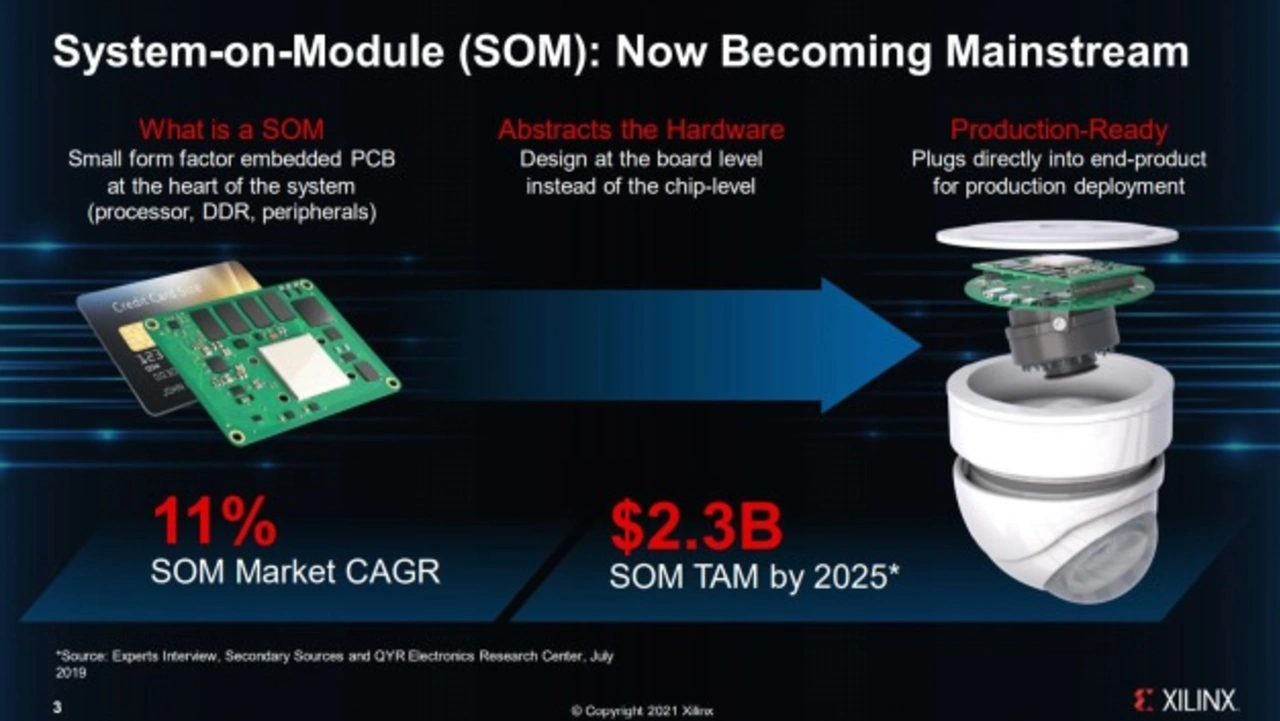

Bei System-on-Modules (SoMs) handelt es sich um vollständige, produktionsreife Computing-Plattformen, die im Vergleich zu einer Chip-Down-Entwicklung viel Entwicklungszeit und -kosten reduzieren. SoMs können in eine größere Edge-Anwendung integriert werden und bieten sowohl die Flexibilität einer kundenspezifischen Implementierung als auch die Benutzerfreundlichkeit und kürzere Markteinführungszeit einer Standardlösung. Diese Vorteile machen SoMs zu einer idealen Plattform für Edge-Anwendungen mit KI. Um jedoch die Rechenleistung zu erreichen, die moderne KI-Anwendungen benötigen, ist eine Beschleunigung erforderlich.

Manche Anwendungen benötigen benutzerdefinierte Hardware-Komponenten für die Schnittstelle zu einem adaptiven SoC. Das heißt aber, dass ein Chip-Down-Design erforderlich ist. Gleichzeitig zeigt sich, dass immer mehr KI-Anwendungen im Edge ähnliche Hardware und Schnittstellen benötigen, selbst wenn es sich um sehr unterschiedliche Endanwendungen handelt. Da sich die Industrie auf standardisierte Schnittstellen- und Kommunikationsprotokolle geeinigt hat, sind dieselben Komponenten für eine Vielzahl von Anwendungen geeignet, auch wenn sie sehr unterschiedliche Anforderungen an die Verarbeitungsleistung erfüllen müssen.

Ein adaptives SoM für KI-Anwendungen im Edge beinhaltet ein adaptives SoC mit Standard-Schnittstellen und -Komponenten. Mit diesen SoMs können auch Entwickler mit begrenzter oder gar keiner Hardware-Erfahrung von der adaptiven Computing-Technologie profitieren. Auf einem adaptiven SoC kann sowohl die KI- als auch die Nicht-KI-Verarbeitung und damit die gesamte Anwendung implementiert werden.

Darüber hinaus lässt sich mit einem SoM mit adaptivem SoC ein System in einem hohen Maß kundenspezifisch anpassen. Das SoM ist darauf ausgelegt, in größere Systeme integriert zu werden und steht dementsprechend in einem vordefinierten Formfaktor zur Verfügung. Adaptive SOMs ermöglichen es, die Vorteile des adaptiven Computing voll auszuschöpfen, ohne ein Chip-Down-Design durchführen zu müssen. Ein adaptives SoM ist allerdings nur ein Teil der Lösung, die Software ist ebenfalls entscheidend.

Unternehmen, die adaptive SoMs einsetzen, profitieren von der einzigartigen Kombination aus Leistung, Flexibilität und schneller Entwicklungszeit. Sie können die Vorteile des adaptiven Computing nutzen, ohne eigene Leiterplatten bauen zu müssen - und genau das ist erst seit kurzem mit der Einführung des Kria-Portfolios adaptiver SoMs von Xilinx im Edge-Bereich möglich.

Kria K26 SoM

Das Kria K26 SoM basiert auf der Zynq UltraScale+ MPSoC-Architektur, die einen Quad-Core Cortex-A53-Prozessor, mehr als 250.000 Logikzellen und einen H.264/265 Video-Codec enthält. Das SoM ist außerdem mit 4 GB DDR4-Speicher und 69 3,3V-I/Os und 116 1,8V-I/Os ausgestattet, so dass es praktisch zu jedem Sensor oder jeder Schnittstelle passt. Mit 1,4 TOPS KI-Rechenleistung können Entwickler mit dem Kria K26 SoM Vision-Anwendungen mit KI-Algorithmen realisieren, die im Vergleich zu GPU-basierten SoMs eine mehr als dreifach höhere Leistung bei niedrigeren Latenzzeiten und geringerem Stromverbrauch bieten – alles Parameter, die für Smart-Vision-Anwendungen wie Sicherheits-, Verkehrs- und Stadtkameras, Einzelhandelsanalysen, Machine-Vision und bildverarbeitungsgesteuerte Robotik entscheidend sind. Durch die Standardisierung der Kernbestandteile des Systems haben die Entwickler mehr Zeit, sich auf den Einbau von Funktionen zu konzentrieren, die ihre Technologie von der Konkurrenz abheben.

Im Gegensatz dazu erlauben andere KI-Systeme für das Edge zwar Software-Updates, aber sie sind aufgrund ihrer festverdrahteten Beschleuniger begrenzt. Die Kria SoMs hingegen zeichnen sich in zwei Richtungen durch Flexibilität aus - Software und Hardware können im Laufe der Zeit an neue Anforderungen angepasst werden. Anwender können die I/O-Schnittstellen, die Bildverarbeitung und die KI-Beschleuniger anpassen, um einige oder alle der folgenden Punkte zu unterstützen: MIPI-, LVDS- und SLVS-EC-Schnittstellen; höherwertige, spezialisierte Bildverarbeitungsalgorithmen mit hohem Dynamikbereich für Tag oder Nacht; 8-Bit Deep-Learning-Verarbeitungseinheiten oder in Zukunft auch 4-Bit- oder sogar binäre neuronale Netzwerkansätze. Die Realisierung von multimodaler Sensorfusion mit Echtzeit-KI-Methoden ist jetzt einfach möglich, und zwar mit dem Xilinx KV260 Vision AI Starter Kit und dem Produktionsstart mit dem Kria K26 SoM.

Jobangebote+ passend zum Thema

- Mit Kria-SOMs Edge-Innovationen beschleunigen

- Adaptive System-on-Modules – kurz SoMs

- Kria KV260 Vision AI Starter Kit