Merck setzt auf Zukunftstechnik

Neue Materialien für und durch Quantencomputer

Quantencomputer könnten die Entwicklung neuer Materialien enorm beschleunigen – deshalb setzt Merck Electronics über vielfältige Kooperationen auf die vielversprechende Technik.

Was blüht uns in zehn Jahren?«, fragt Dr. Kai Beckmann, Mitglied der Geschäftsleitung von Merck und CEO Electronics. Um auf diese Frage Antworten zu geben, hat Merck ein eigenes „Innovation-Radar“ entworfen, das die für die Entwicklung von neuen Materialien entscheidenden Trends langfristig aufspüren will. Ganz oben auf der Liste stehen: neuromorphes Computing und Quantencomputer. Von ihnen versprechen sich viele wahre Wunderdinge, und für Ralph Dammel, Technology Expert Performance Materials von Merck Electronics, stehen sie sogar in einem engen Zusammenhang. Doch dazu später.

Zunächst zu den Quantencomputern, über die heute so viel diskutiert wird. Um es gleich vorab zu sagen: Selbst wenn sich sämtliche hohen Erwartungen in die Quantencomputer erfüllen sollten, so werden sie laut Dammel die traditionellen Controller und Prozessoren keinesfalls ablösen. »Quantencomputer sind bei Weitem nicht auf allen Feldern der traditionellen Technik besser, aber wo sie es sind, sind sie den traditionellen Systemen um mehrere Größenordnungen, also haushoch überlegen«, sagt Ralph Dammel. Auf dem Gebiet der Kryptografie springt das besonders drastisch ins Auge. Würde es einen Supercomputer auf Basis heutiger Prozessoren Millionen, wenn nicht gar Milliarden Jahre Rechenzeit kosten, eine konventionelle starke Verschlüsselung zu knacken, so könnte ein Quantencomputer dieses Problem innerhalb von Sekunden lösen.

Ein starkes Werkzeug für Entwicklung von neuen Materialien

Doch warum interessiert sich ein Unternehmen wie Merck so stark für Quantencomputer? Sie eignen sich vor allem dazu, Optimierungsaufgaben zu lösen. Etwa um den optimalen Weg für Fahrzeuge in einem großen Lager zu finden. Genauso eignen sie sich dazu, komplexe Molekülstrukturen schnell zu berechnen, wozu heutige Systeme viel zu lange brauchen. Das wiederum lässt Ralph Dammel hoffen: »Wir tragen mit unseren Materialien nicht nur dazu bei, Quantencomputer realisieren zu können, wir können die Quantencomputer auch umgekehrt dazu einsetzen, leistungsfähigere Materialien und Materialien mit völlig neuen Eigenschaften zu entwickeln.« Sowohl für den Einsatz in der Elektronik als auch, um wirksame Medikamente und pharmazeutische Produkte schneller auf den Markt zu bringen, was dann wiederum für Merck als Gesamtunternehmen interessant ist.

Aber ist das im Moment eine realistische Einschätzung? Oder anders gefragt: Gibt es derzeit Quantencomputer, die Verschlüsselungen knacken oder komplexe Moleküle für die Pharmazie berechnen können?

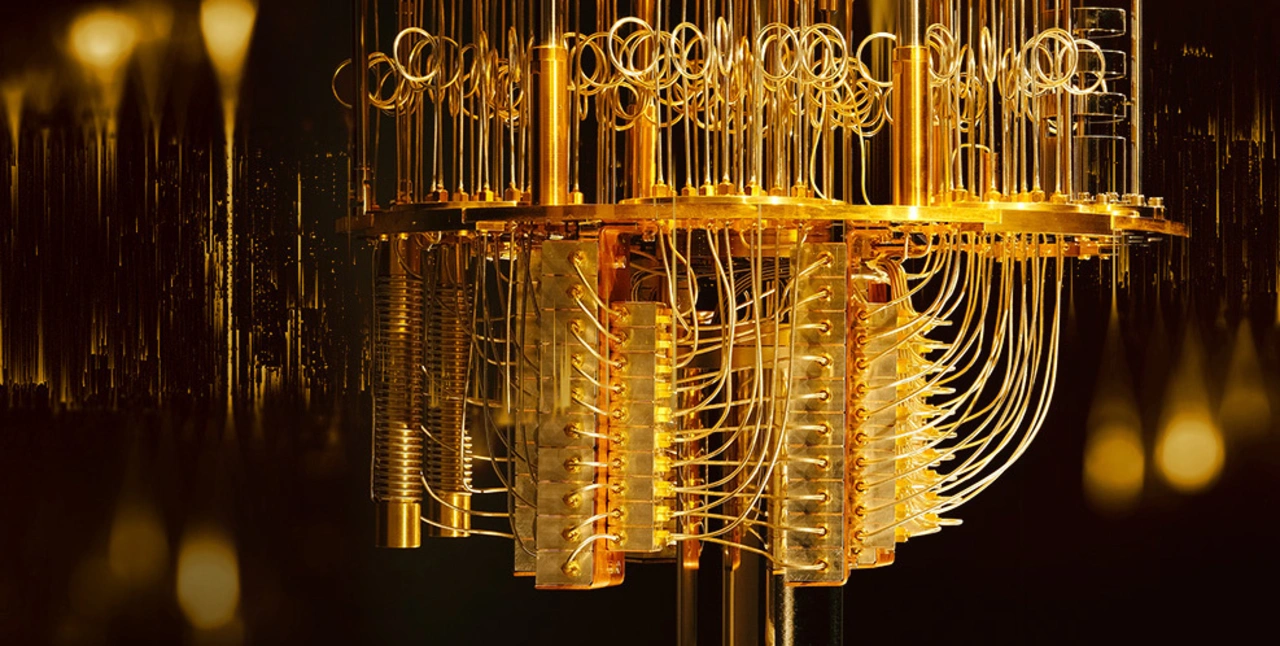

Die einfache Antwort ist nein. Denn allein für die Anwendung in der Kryptografie wären laut Dammel mindestens 1.000 Qubits erforderlich: »Heute sind wir bei 60 Qubits angelangt, die über einen genügend langen Zeitraum stabil gehalten werden können, um ein paar Sekunden mit ihnen zu rechnen.« Diese Kohärenzzeit – der Zeitraum, über den sich die Qubits in einem verschränkten Zustand befinden – ist eines der wichtigsten Kriterien für einen Quantencomputer. Denn zerfällt der Kohärenzzustand, dann sind die vielen Informationen, die in diesem Zustand verschränkt vorhanden waren und hätten ausgelesen werden können, für alle Zeiten verloren. Leider genügen allerkleinste Störungen von außen – minimale Temperaturschwankungen, mechanische Erschütterungen, Störstrahlungen –, um den fragilen Zustand der Kohärenz zu zerstören. Deshalb werden die Quanten-Arrays fast auf den absoluten Nullpunkt (20 mK) abgekühlt, um Störungen durch die Temperaturbewegungen der Atome zu minimieren. Außerdem muss die Apparatur von der Außenwelt gut abgeschirmt werden. Dadurch kann die Kohärenzzeit verlängert werden. Das ist mit wenigen Qubits einfacher als mit vielen und das ist ein Grund dafür, warum heutige Quantencomputer über 60 Qubits nicht hinauskommen. Derzeit liegen die Kohärenzzeiten bestenfalls bei einigen tausendstel Sekunden.

Jobangebote+ passend zum Thema

Quantensimulatoren sind schon relativ weit

Es gibt aber noch eine weitere Methode, um dennoch zu Rechenergebnissen zu kommen: Verlieren nur wenige Qubits den Zustand der Verschränktheit, so lässt sich über Fehlerkorrekturalgorithmen der Schaden begrenzen. Dann liefern Quantencomputer immer noch Ergebnisse, die mit hoher Wahrscheinlichkeit richtig, also in der Praxis brauchbar sind. Nebenbei: Wer sich an der Wahrscheinlichkeit stört, muss lernen, sich daran gewöhnen, denn eines ist den Quantenrechnern inhärent: Sie liefern keine exakten Ergebnisse, sondern Wahrscheinlichkeiten. Die Wahrscheinlichkeit kann so hoch sein, dass sie einem exakten Ergebnis sehr nahekommt.

Allerdings: Es sind leider viel mehr Qubits für die Fehlerkorrektur erforderlich als für die eigentliche Rechnung, sodass bei vielen Qubits der Aufwand enorm steigt. Laut Dr. Michael Marthaler, CEO und Mitgründer von HQS Quantum Simulations in Karlsruhe, sind zwischen 500.000 und 50.000.000 Qubits erforderlich, um mit 100 logischen Qubits rechnen zu können. In der Praxis versucht man also, die Kohärenzzeit und die Fehlerkorrekturalgorithmen sowie die Anzahl der Qubits in ein Verhältnis zu bringen, das der zu bewältigenden Aufgabe angemessen ist.

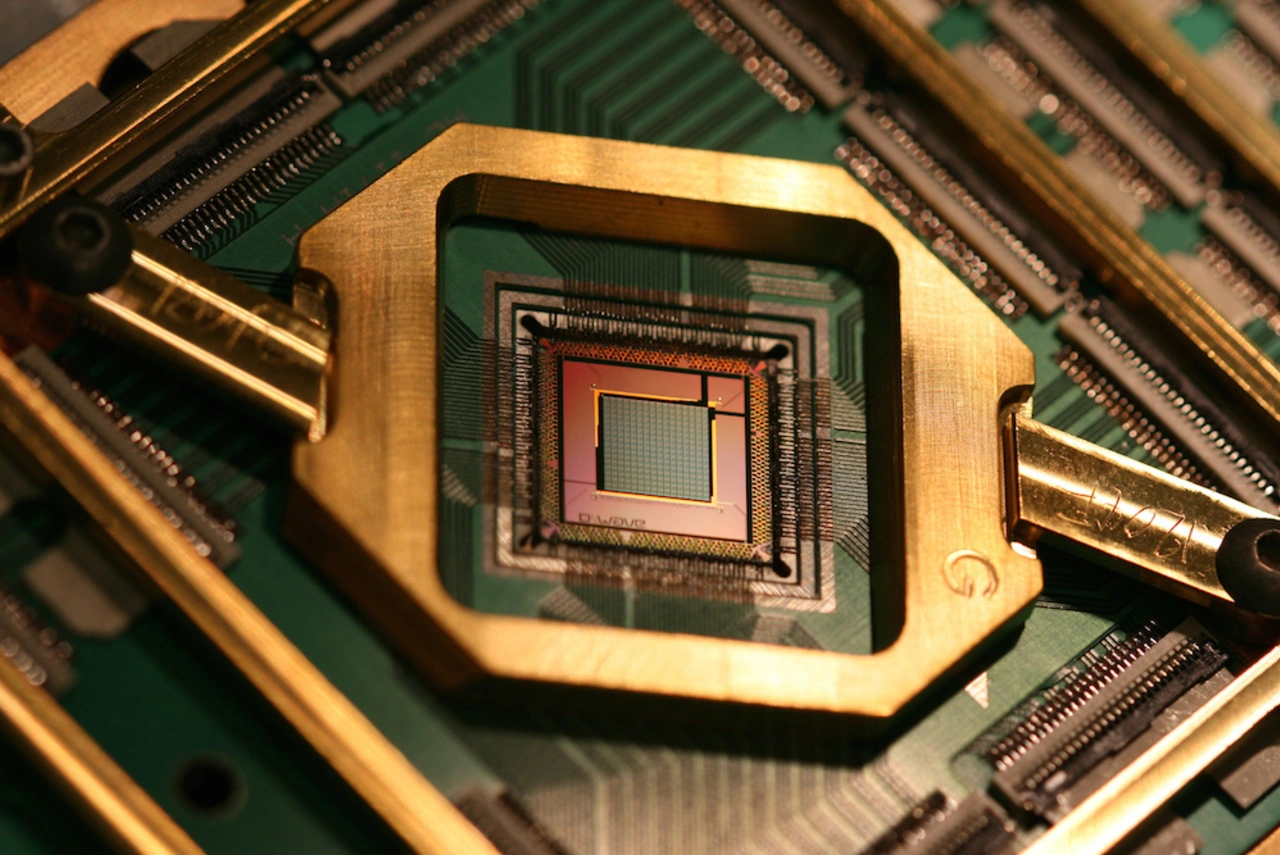

Und was gibt es bereits? Die amerikanische Firma D-Wave war eine der ersten, die einen Quantencomputer auf den Markt gebracht hat. Er erzeugt die Qubits auf Basis von supraleitenden Josephson-Kontakten. Für den Aufbau von Josephson-Kontakten sind übrigens Materialien wie Fotolacke und Spezialchemikalien erforderlich, die Merck Electronics liefert.

Bei den Systemen von D-Wave handelt es sich allerdings um sehr spezielle Quantencomputer, um sogenannte Quantensimulatoren. Sie kommen einer Idee von Richard Feynman nahe: »Use a Quantum System to study quantum effects!« (Simulating Physics with Computers, 1981).

In solchen Systemen wird also ein reales Quantensystem untersucht, indem die Forscher es aus wenigen Quantenteilchen in der Maschine abbilden, um bestimmte Eigenschaften des realen Systems daraus ableiten zu können. Ein Quantensimulator muss also immer auf die Aufgabe, die er lösen soll, zugeschnitten sein. So kann er die quantenmechanischen Effekte nutzen, um die realen Systeme zu simulieren. Dadurch lassen sich Rückschlüsse auf die realen Systeme ziehen und vielleicht sogar ihr Reaktionsverhalten vorhersagen.

Das Verfahren, das sie nutzen, ähnelt dem Ausglühen (englisch: Annealing) von Metallen. Werden sie erhitzt und dann sehr langsam abgekühlt, können Fehlstellen in ihrem Metallgitter beseitigt werden. Denn während der Abkühlphase finden die Atome genügend Zeit, um sich korrekt anzuordnen, anstatt durch schnelle Kühlung in einem fehlerhaften Zustand „eingefroren“ zu werden. So ähnlich wie das Kristall seine optimale Konfiguration kann der Quantensimulator die optimale Konfiguration seiner Qubits finden. Das System findet die Energieminima in einer Energielandschaft schnell, indem es durch die Berge tunnelt – das ist der Quanteneffekt –, um in die tiefsten Täler über diese Abkürzungen vorzudringen. Deshalb sprechen die Wissenschaftler in diesem Fall von Quanten-Annealing. Ralph Dammel formuliert dies so: »Es wird versucht, die Superposition kontrolliert zerfallen zu lassen; auf diese Weise können Optimierungsprobleme relativ schnell gelöst werden, viel schneller als auf einem konventionellen Prozessor.« Beispielsweise wie der optimale Weg eines Fahrzeugs durch ein Lager aussieht.

Weil Quantensimulatoren also direkt auf der Ebene der quantenmechanischen Vorgänge simulieren, entfällt die Notwendigkeit, die komplexen Gleichungen der Quantenmechanik über Näherungsverfahren zu lösen. Das ist eine elegante Abkürzung. Ähnlich wie analoge Rechner können sie bestimmte Aufgaben schneller und energiesparender erledigen als ihre digitalen Brüder.

»Dabei spielen „echte“ Qubits allerdings keine Rolle«, sagt Dammel. Es stimme zwar, dass die Maschine von D-Wave über 1.000 Qubits benutzt, aber sie bleiben nicht bis zum Ende der Rechnung verschränkt, hier wird nur die Superpositionseigenschaft der Quantenmechanik genutzt. Die Fachleute sprechen in diesem Fall von Pseudo-Qubits. Deshalb rechnen die Quantensimulatoren auch nicht auf Basis von Quantengattern wie die „echten“ Quantencomputer.

Das bedeutet aber nicht, dass die Quantensimulatoren schlechte Vorläuferversionen der „richtigen“ Quantencomputer sind, es handelt sich einfach um einen anderen Typ von Quantencomputern, der den Vorzug hat, bereits Schritte in reale Anwendungen getan zu haben und der sich dazu eignet, um auf Fragen der Materialwissenschaftler losgelassen zu werden.

Simulationen auf Quanteneebene sparen Geld und Zeit

Genau daran sind Dammel und Merck als Gesamtunternehmen besonders interessiert. Denn den Quantensimulatoren wird zugetraut, Molekülstrukturen aufzuklären und sogar das physikalische und chemische Verhalten neuer Materialien und Wirkstoffe vorherzusagen, wozu heute langwierige und teure Laboruntersuchungen und Tests erforderlich sind, die sich wegen ihrer Komplexität der Berechnung durch Supercomputer weitgehend entziehen. Simulationen auf Quantenebene würden also viel Laborarbeit und Zeit für viele Test, also auch sehr viel Geld sparen.

Digitale Quantensimulatoren

Dabei müssen die Quantenrechnungen nicht wie in den Computern von D-Wave tatsächlich auf Quantenebene ablaufen; die in den Maschinen von D-Wave real vorhandenen Quantenschaltkreise lassen sich auch auf herkömmlichen CMOS-Prozessoren simulieren. Die Experten sprechen diesem Fall von „digitalem Annealing“.

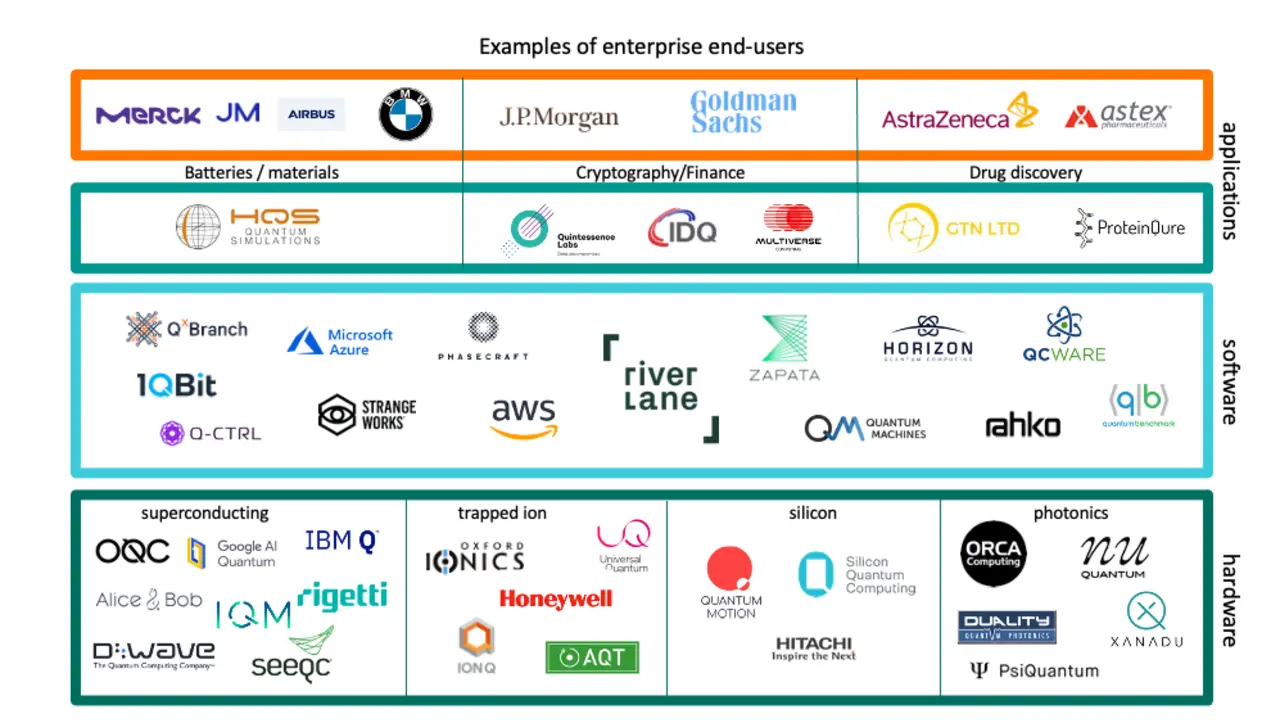

Auf solche Systeme setzten beispielsweise Fujitsu und die in Karlsruhe beheimatete HQS Quantum Simulations, mit der Merck zusammenarbeitet. HQS will Quantensimulationsmethoden entwickeln, um so neue Materialien mit völlig neuen Eigenschaften zu synthetisieren, die ohne diese Methoden nicht hätten entwickelt werden können. Schon in wenigen Jahren solle dies auf Basis von Qubits in Quantencomputern geschehen. HQS verspricht, dass ihre Software in der Lage ist, die Möglichkeiten der Quantencomputer schon jetzt, also in ihrem frühen Stadium zu nutzen, um Quantensimulationen sehr viel schneller ablaufen zu lassen, als es auf bisherigen Computern möglich wäre.

Außerdem hat Merck über M Ventures in SeeQC investiert, die sich vorgenommen hat, Quanten-Computing und klassisches High-Performance Computing zu kombinieren, um die Vorteile aus beiden Welten zusammenzuführen. Das Ziel besteht darin, einen hybriden „Quantum-Classical Computer“ zu bauen. Dazu hat SeeQCc den sogenannten Digital Quantum Management Chip (DQM) entwickelt. Dieses System-on-a-Chip bildet die Brücke zwischen einem Qubit Array (basierend auf supraleitenden Josephson-Kontakten) und einem klassischen Koprozessor. Die drei Chips sind in einem einzigen Gehäuse integriert, das gekühlt wird. Der DQM übernimmt die Steuerung der Qubits und liest sie aus. Außerdem laufen hier die Fehlerkorrekturalgorithmen ab. Weil sie in unmittelbarer Nähe zu den tiefgekühlten Qubit Chips positioniert sind, reduziert sich die Komplexität der I/O-Schnittstellen drastisch, aufwändige Verkabelungen zwischen dem tiefgekühlten und den übrigen Elementen, wie sie im herkömmlichen Aufbau erforderlich sind, können entfallen. SeeQC ist 2019 aus Hypres hervorgegangen, einem Spezialisten für die Entwicklung und Fertigung von supraleitenden Elektronikkomponenten wie auf Josephson-Kontakten bestehenden SQIDs. Deshalb hat SeeQC Zugriff auf die Fab von Hypres, wo die Chips gefertigt werden.

Außerdem bestehen Partnerschaften mit Riverlane, die ein Betriebssystem (Deltaflow) für Quantencomputer (für den Typ von IonQ) entwickelt hat, und Rahko, die Machine Learning auf Basis von Quantencomputern entwickelt.

Weil die Quantensimulatoren mit den Qubits nicht über Quantengitter rechnen, können sie viele Aufgaben, für die Quantencomputer berühmt sind, nicht durchführen. Verschlüsselungen knacken können nur die Maschinen, die mit echten Qubits arbeiten. Damit Quantencomputer auf Basis von Quantengattern rechnen können, müssen sie verschränkt sein und diesen Zustand so lange aufrecht erhalten, dass genügend Gatteroperationen durchgeführt werden können, um ein sinnvolles Ergebnis zu erhalten. Weil das so schwierig ist, hinkt die Zahl der echten Qubits denen der Quantensimulatoren deutlich hinterher.

Doch auch solche Maschinen existieren bereits. Google und IBM verkaufen sogar schon Rechenzeit auf ihnen über das Internet. So können sich Interessierte mit der Art und Weise vertraut machen, wie sie mit Quantencomputern umgehen können und vor allem wie sie zu programmieren sind. »Doch für viele Aufgaben fehlen noch die entsprechenden Algorithmen«, sagt Dammel.

Derzeit spielt sich also alles noch auf Forschungsebene ab. Wirklich sinnvolle Aufgaben können diese Quantencomputer nicht lösen. »Doch schon ab 2030 wird es robuste Quantencomputer geben, durch sie wird die heutige Kryptografie obsolet«, ist sich Dammel sicher.

So richtig interessant wird es seiner Meinung nach, sobald sich die Quantencomputer zum Aufbau neuronaler Netze nutzen ließen, was dann ebenfalls in Reichweite läge. Das ist der oben bereits erwähnte Zusammenhang zwischen neuromorphem Computing und Quantencomputern.

Die Jahre bis dahin sollten laut Dammel genutzt werden, um die erforderlichen Algorithmen zu entwickeln. Die ersten entstanden in den 1990er-Jahren; heute gibt es zwei einigermaßen ausgereifte Algorithmen, nach ihren Erfindern Shor und Grover genannt. Der Shor-Algorithmus eignet sich dafür, große Zahlen schnell in ihre Primfaktoren zu zerlegen, womit sich RSA-Verschlüsselungen knacken lassen; der Grover-Algorithmus eignet sich, um große Datenbanken schnell zu durchsuchen. »Erst wenn viel mehr Algorithmen existieren und komplexere Programme entwickelt werden können, werden sich die Quantencomputer in sinnvolle Rechenmaschinen verwandeln«, sagt Dammel.

Und wie wird die Hardware der Quantencomputer aussehen? Auch das ist noch nicht klar. Qubits lassen sich auf vielfältige Weise herstellen. Die ältesten und stabilsten Verfahren sind Ionenfallen (Honeywell, IonQ, Universal Quantum, Oxford Ionics) und die schon erwähnten supraleitenden Josephson-Kontakte (IQM, Google, Rigetti, Oxford Quantum Circuits, D-Wave, SeeQC, IBM Q, Alice & Bob, Intel). Doch die Forscher arbeiten an vielen weiteren Methoden, um Qubits zu erzeugen. Dazu gehören photonische Quantencomputer (Xanadu, Psi_Quantum, Orca Computing), Fehlstellen in einem Diamantgitter (Quantum Diamond Technologies), Silicon Spin Qubits (Silicon Quantum Computing, Intel, HRL) und Quantenpunkte. Topologische Qubits sind bisher nur eine interessante Idee; ob sie sich realisieren lassen, ist noch ungeklärt. Ob sich ein Typ durchsetzen wird oder ob sich bestimmte Typen für jeweils bestimmte Aufgaben besonders eignen werden, steht heute noch in den Sternen.

Doch auch wenn Quantencomputer tatsächlich einmal stabil genug arbeiten werden, um die üblichen RSA-Verschlüsselungen brechen zu können, wäre das keine Katastrophe; Hackern würde sich damit keinesfalls Tür und Tor öffnen. Denn es gibt Verschlüsselungsmethoden, an denen schon mit Hochdruck gearbeitet wird, die Quantencomputer prinzipiell nicht brechen können. Das zeigt, wie limitiert sie im Grunde sind. Andererseits lassen sich auf ihrer Basis Kommunikationssysteme aufbauen, die prinzipiell nicht abgehört werden können. Auf diesem Gebiet dürfte sich ihnen ein großer Markt öffnen. Genauso wie auf dem Gebiet der Materialforschung, wie Ralph Dammel überzeugt ist: »Unsere Chemiker freuen sich schon darauf, was sie mithilfe von derartigen Quantencomputern an Neuem entdecken können«, so Dammel.

Merck Electronics

Neue Strategie- neuer Name

2017 hatte Dr. Kai Beckmann den Posten des CEO der damaligen Merck Performance Materials übernommen und seitdem die Strategie verfolgt, verstärkt auf Materialien für die Elektronik zu setzen. Dazu wurden 2019 gleich zwei Firmen in den USA übernommen: für 6,5 Mrd. Dollar Versum Materials, Hersteller von Chemikalien und Gasen für die Halbleiterfertigung, sowie für 60 Mio. Dollar Intermolecular, die Techniken entwickelt hat, die es erlauben, neue Materialien für Halbleiter unter realistischen Bedingungen in einer vollständigen Produktionsumgebung zu erforschen, sie in den jeweiligen Ziel-ICs zu verarbeiten und zu testen. »Wir sind jetzt der einzige Materialzulieferer weltweit, der alle Schritte der Halbleiterfertigung abdeckt«, freut sich Beckmann.

Das hat das Unternehmen kürzlich auch mit einem Namenswechsel nach außen sichtbar gemacht: Aus Merck Performance Materials wurde Merck Electronics. Den größten Sektor dieser Einheit bilden Semiconductor Solutions mit einem Umsatzanteil von 56 Prozent in 2020. Displays und OLEDs tragen 33 Prozent bei, Surface Solutions 11 Prozent. Dabei kommt Merck Electronics der Nachfrageschub nach ICs entgegen: Marktforscher sagen dem 5G-Sektor ein Wachstum von durchschnittlich 122 Prozent pro Jahr voraus (CAGR), im KI-Sektor sollen es 30 Prozent sein, IoT-Sensoren 24 Prozent, automatisiertes Fahren 18 Prozent und Datenzentren 13 Prozent. »Die Strategie ist aufgegangen, der Turnaround gelungen«, so Beckmann.