Nvidia auf der Computex

Systeme, Software, Dienste – alles neu

Jensen Huang, Gründer, President und CEO von Nvidia, nutzt die Computex, um wichtige Ankündigungen zu machen, einschließlich neuer Systeme, die auf Grace Hopper basieren, der mittlerweile in voller Produktion ist.

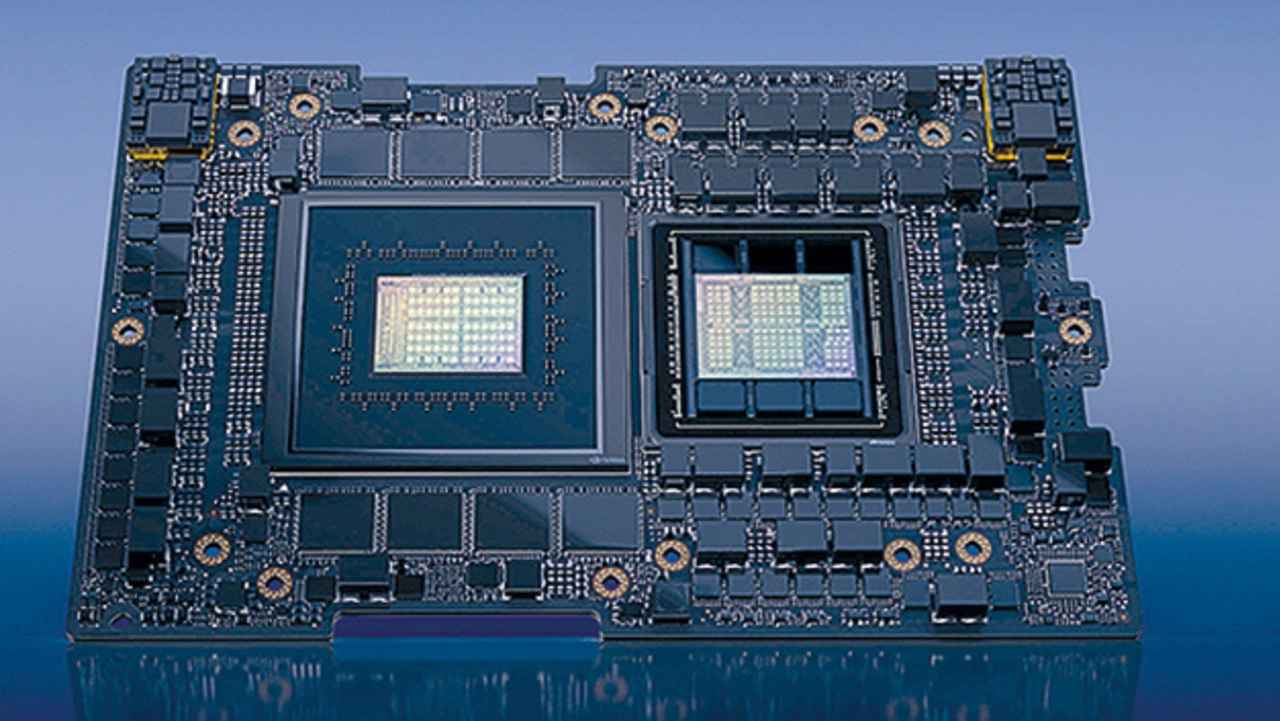

Im Grace-Hopper-Superchip (GH200) hat Nvidia seine Grace-CPU und seine Hopper-GPU-Architekturen kombiniert und beide Seiten mithilfe seiner eigenen NVLink-C2C-Technologie zu einem einzigen Chip verbunden. Die Grace-CPU war die erste CPU von Nvidia für Rechenzentren, die das Unternehmen von Grund auf für die Entwicklung von HPC- und KI-Superchips optimiert hat. In der Grace-CPU sitzen 72 Neoverse-V2-CPU-Kerne und bis zu 512 GB LPDDR5X-Speicher, mit einer Speicherbandbreite von bis zu 546 GB/s pro CPU. Hopper wiederum ist die neunte Generation von Grafikprozessoren von Nvidia. Für die Verbindung der Prozessoren kommt die Chip-to-Chip-Verbindungs-technologie »NVLink C2C« zum Einsatz. Sie erreicht eine Gesamtbandbreite von 900 GB/s und liegt damit um den Faktor 7 höher als die Bandbreite von PCIe Gen5 in traditionellen Systemen. Ian Buck, Vice President für Accelerated Computing von Nvidia: »Generative KI verändert das Business in rasantem Tempo, erschließt neue Möglichkeiten und beschleunigt Entdeckungen im Gesundheitswesen, im Finanzwesen, bei Unternehmensdienstleistungen und in vielen weiteren Branchen. Mit den Grace-Hopper-Superchips in voller Produktion werden Hersteller weltweit bald die beschleunigte Infrastruktur bereitstellen, die Unternehmen benötigen, um generative KI-Anwendungen zu entwickeln und einzusetzen, die ihre einzigartigen proprietären Daten nutzen.«

Laut Nvidia gehören globale Hyperscaler und Supercomputing-Zentren in Europa und den USA zu den Kunden, die Zugang zu GH200-betriebenen Systemen haben werden.

Jobangebote+ passend zum Thema

KI-Supercomputer DGX GH200

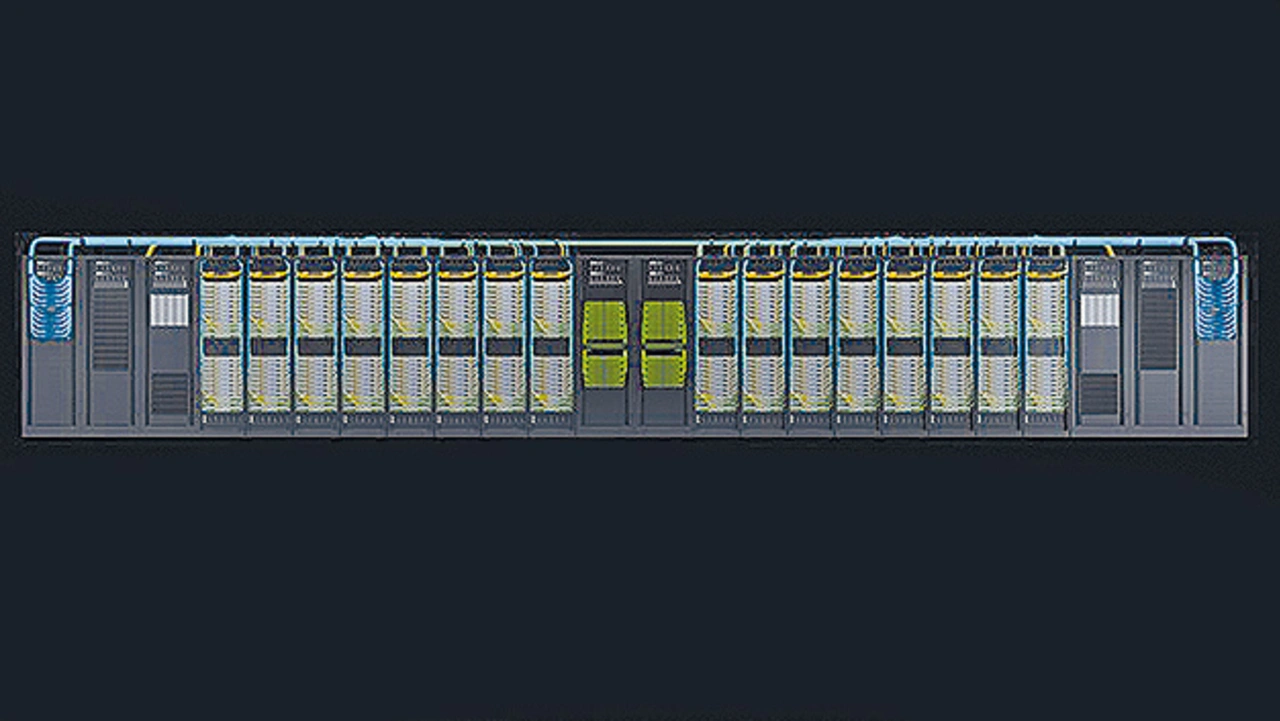

Huang kündigt außerdem die KI-Supercomputer DGX GH200 an. Dabei handelt es sich laut Nvidia um eine neue Klasse von Supercomputern für speicherintensive KI-Anwendungen. Der DGX-Supercomputer basiert auf GH200-Grace-Hopper-Superchips und dem NVLink-Switch-System und soll die Entwicklung von riesigen Modellen der nächsten Generation für generative KI-Sprachanwendungen, Empfehlungssysteme und Datenanalyse-Workloads ermöglichen.

Der riesige, gemeinsam genutzte Speicherbereich des Nvidia DGX GH200 nutzt die NVLink-Interconnect-Technologie mit dem NVLink-Switch-System, um 256 der GH200-Superchips miteinander zu verbinden, sodass sie wie eine einzige GPU arbeiten können. Damit stehen eine Rechenleistung von 1 Exa-FLOP und 144 Terabyte gemeinsamer Speicher zur Verfügung – das ist eine um einen Faktor von fast 500 erhöhte Speicherkapazität als in einem einzelnen DGX-A100-System von Nvidia. Huang: »Generative KI, große Sprachmodelle und Empfehlungssysteme sind die digitalen Motoren der modernen Wirtschaft. Die DGX-GH200-KI-Supercomputer integrieren unsere fortschrittlichsten Accelerated-Computing- und Netzwerktechnologien, um die Grenzen der KI zu erweitern.«

Die Nutzung von NVLink-C2C erhöht im Vergleich zur neuesten PCIe-Technologie nicht nur die Bandbreite zwischen Grafikprozessor und CPU (um das Siebenfache), sondern senkt auch die Leistungsaufnahme des Interconnect um mehr als das Fünffache und ermöglicht einen 600-GB-GPU-Building- Block für die DGX-GH200-Supercomputer.

Der DGX GH200 ist der erste Supercomputer, der Grace-Hopper-Superchips mit dem NVLink-Switch-System kombiniert, einem neuen Interconnect, der es allen GPUs in einem DGX-GH200-System ermöglicht, als eine Einheit zusammenzuarbeiten. Bei der vorherigen Systemgeneration konnten nur acht GPUs mit NVLink als eine GPU kombiniert werden, ohne dass die Leistung darunter litt.

Die DGX-GH200-Architektur bietet eine zehnfach höhere Bandbreite als die Vorgängergeneration und liefert die Leistung eines riesigen KI-Supercomputers mit der Einfachheit der Programmierung eines einzelnen Grafikprozessors.

Google Cloud, Meta und Microsoft gehören zu den ersten, die voraussichtlich Zugang zum DGX GH200 erhalten werden, um dessen Fähigkeiten für generative KI-Workloads zu erforschen. Nvidia beabsichtigt außerdem, das DGX-GH200-Design als Blaupause für Cloud-Service-Provider und andere Hyperscaler zur Verfügung zu stellen, damit diese es für ihre Infrastruktur weiter anpassen können.

»Der Aufbau fortschrittlicher generativer Modelle erfordert innovative Ansätze für die KI-Infrastruktur«, sagt Mark Lohmeyer, Vice President of Compute bei Google Cloud. »Die neue NVLink-Skalierung und der gemeinsam genutzte Speicher der Grace-Hopper-Superchips adressieren wichtige Engpässe bei groß angelegter KI.«

»Da KI-Modelle immer größer werden, benötigen sie eine leistungsfähige Infra- struktur, die den steigenden Anforderungen gerecht wird«, sagt Alexis Björlin, Vice President of Infrastructure, AI Systems and Accelerated Platforms bei Meta. »Nvidias Grace-Hopper-Design soll Forschern die Möglichkeit geben, neue Ansätze zur Lösung ihrer größten Herausforderungen zu erforschen.«

Supercomputer Helios

Nvidia baut auch seinen eigenen DGX-GH200-basierten KI-Supercomputer, um die Arbeit seiner Forscher und Entwicklungsteams zu unterstützen. Der Supercomputer trägt den Namen »Nvidia Helios« und wird mit vier DGX-GH200-Systemen ausgestattet sein.

Jedes System des Helios-Supercomputers wird mit einem Nvidia-Quantum-2-InfiniBand-Netzwerk mit einer Bandbreite von bis zu 400 Gbit/s verbunden sein, um den Datendurchsatz beim Training großer KI-Modelle zu erhöhen. Helios wird 1.024 Grace-Hopper-Superchips enthalten und soll bis Ende des Jahres in Betrieb genommen werden. Die DGX-GH200-Supercomputer kommen mit der dazugehörigen Software von Nvidia, sodass schlüsselfertige Komplettlösungen für die größten KI- und Datenanalyse-Workloads verfügbar sind. Dazu gehört die Base-Command-Software für KI-Workflow-Management, Cluster-Management, Bibliotheken zur Beschleunigung der Rechen-, Speicher- und Netzwerkinfrastruktur sowie Systemsoftware, die für die Ausführung von KI-Workloads optimiert ist. Ebenfalls enthalten ist AI Enterprise, ein Software-Layer der KI-Plattform von Nvidia. Sie bietet über 100 Frameworks, vortrainierte Modelle und Entwicklungstools, um die Entwicklung und den Einsatz von KI zu vereinfachen, einschließlich generativer KI, Computer-Vision, Sprach-KI etc.

- Systeme, Software, Dienste – alles neu

- MGX – für Datenzentren jedweder Größe