Nvidia auf der Computex

Systeme, Software, Dienste – alles neu

Fortsetzung des Artikels von Teil 1

MGX – für Datenzentren jedweder Größe

Nvidia hat außerdem MGX vorgestellt. Dabei handelt es sich um eine modulare Referenzarchitektur, mit der sich schnell und kosteneffizient mehr als 100 verschiedene Servervarianten realisieren lassen, die sich für eine Vielzahl von KI-, High-Performance-Computing- und Omniverse-Anwendungen eignen. »Unternehmen suchen nach mehr Optionen für beschleunigtes Computing bei der Architektur von Rechenzentren, die ihren spezifischen Geschäfts- und Anwendungsanforderungen entsprechen«, sagt Kaustubh Sanghani, Vice President of GPU Products bei Nvidia. »Wir haben MGX entwickelt, um Unternehmen bei der Einführung von KI zu unterstützen und ihnen dabei viel Zeit und Geld zu sparen.«

Mit MGX können die Hersteller mit einer Basic-Systemarchitektur, die für beschleunigtes Computing für ihr Servergehäuse optimiert ist, anfangen und dann ihre GPU, DPU und CPU auswählen. Mithilfe von Design-Variationen können einzigartige Arbeitslasten adressiert werden, wie HPC, Data Science, große Sprachmodelle, Edge Computing, Grafik und Video, Enterprise AI sowie Design und Simulation. Mehrere Aufgaben wie KI-Training und 5G können auf einer einzigen Maschine erledigt werden, während Upgrades auf zukünftige Hardware-Generationen reibungslos möglich sein sollen. MGX lässt sich laut Nvidia auch problemlos in Cloud- und Unternehmensrechenzentren integrieren.

Die ersten, die auf diesen Zug aufspringen, stehen auch schon fest: ASRock Rack, Asus, Gigabyte, Pegatron wollen MGX nutzen, sodass die Entwicklungskosten laut Nvidia um bis zu drei Viertel sinken und die Entwicklungszeit um zwei Drittel auf nur sechs Monate reduziert werden kann.

Wobei QCT und Supermicro die ersten sein werden, deren MGX-Designs bereits im August auf den Markt kommen sollen. Denn Supermicro hat sein ARS-221GL-NR-System mit Grace-CPU-Superchips ebenfalls auf der Computex angekündigt, und dasselbe gilt für QCT. Das Unternehmen hat sein S74G-2U-System vorgestellt, das auf den GH200-Grace-Hopper-Superchips basieren soll.

Darüber hinaus plant SoftBank den Aufbau mehrerer Hyperscale-Rechenzentren in ganz Japan, und dafür will das Unternehmen ebenfalls MGX nutzen, um GPU-Ressourcen dynamisch zwischen generativen KI- und 5G-Anwendungen zuzuweisen. »Da sich generative KI im Geschäfts- und Privatleben durchsetzt, ist der Aufbau der richtigen Infrastruktur zu den richtigen Kosten eine der größten Herausforderungen für Netzbetreiber«, erklärt Junichi Miyakawa, Präsident und CEO von SoftBank. »Wir gehen davon aus, dass Nvidia MGX solche Herausforderungen bewältigen kann und eine Mehrfachnutzung von KI, 5G und mehr je nach Echtzeit-Workload-Anforderungen ermöglicht.«

Jobangebote+ passend zum Thema

Unterschiedliche Designs für unterschiedliche Anforderungen

Rechenzentren müssen einerseits die Rechenkapazitäten steigern, andererseits ihren CO2-Footprint reduzieren. Das modulare Design von MGX gibt Systemherstellern die Möglichkeit, die individuellen Budget-, Stromversorgungs-, Wärmedesign- und mechanischen Anforderungen eines jeden Kunden noch besser zu erfüllen.

MGX arbeitet mit verschiedenen Formfaktoren und ist mit aktuellen und zukünftigen Generationen von Nvidia-Hardware kompatibel:

Gehäuse: 1U, 2U, 4U (luft- oder flüssigkeitsgekühlt)

➔ GPUs: das komplette GPU-Portfolio von Nvidia, einschließlich der neuesten H100, L40, L4

➔ CPUs: Grace-CPU-Superchip, GH200-Grace-Hopper-Superchip, x86-CPUs

➔ Netzwerktechnik: BlueField-3-DPU, ConnectX-7-Netzwerkadapter

MGX unterscheidet sich von HGX von Nvidia dadurch, dass es flexible, generationsübergreifende Kompatibilität mit den Nvidia-Produkten bietet, um sicherzustellen, dass Systementwickler bestehende Designs wiederverwenden und Produkte der nächsten Generation ohne kostspielige Neuentwicklungen problemlos übernehmen können. Im Gegensatz dazu basiert HGX auf einem NVLink-verbundenen Multi-GPU-Baseboard, das auf die Skalierung für die Erstellung ultimativer KI- und HPC-Systeme zugeschnitten ist.

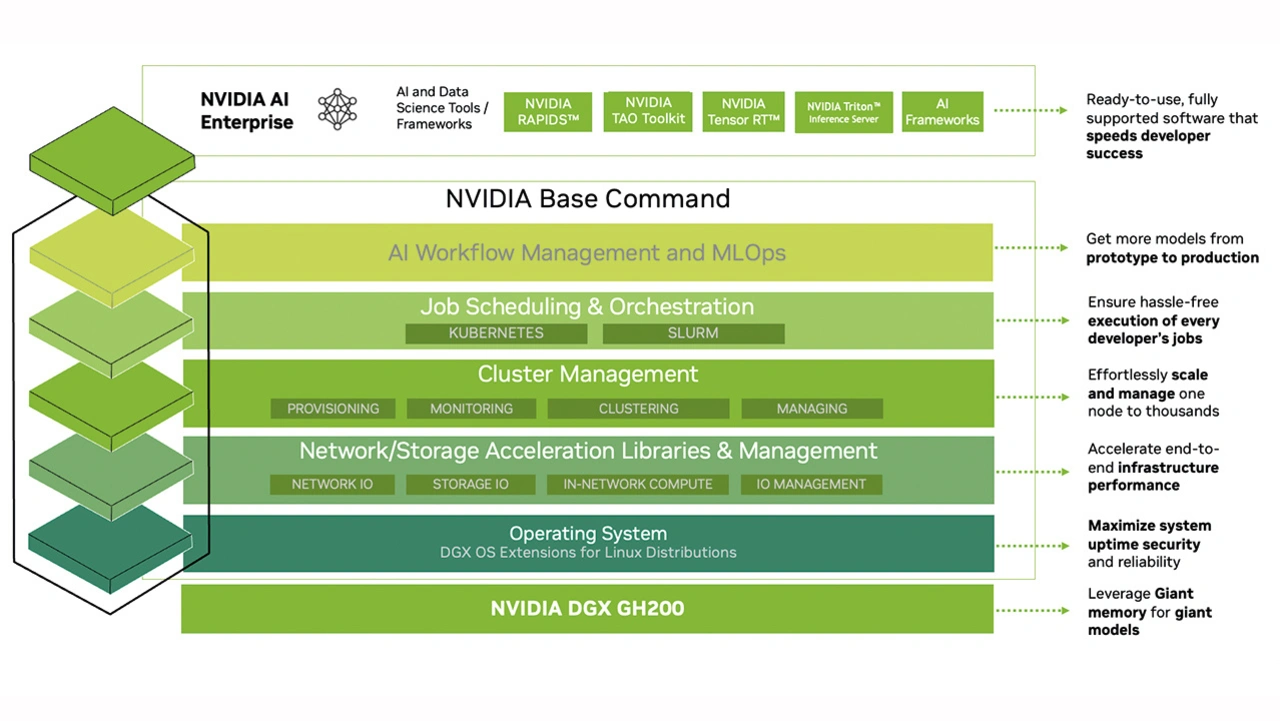

Zusätzlich zur Hardware wird MGX durch den kompletten Software-Stack (zum Beispiel AI Enterprise) von Nvidia unterstützt, der es Entwicklern und Unternehmen ermöglicht, KI-, HPC- und andere Anwendungen zu erstellen und zu beschleunigen. MGX ist mit dem Open Compute Project und den Server-Racks der Electronic Industries Alliance kompatibel, um eine schnelle Integration in Unternehmens- und Cloud-Rechenzentren zu ermöglichen.

Beschleunigte Ethernet-Plattform »Spectrum-X«

Darüber hinaus hat Nvidia seine »Spectrum-X-Netzwerkplattform« vorgestellt. Dabei handelt es sich um eine beschleunigte Ethernet-Plattform, mit der die Leistung und Effizienz von Ethernet-basierten KI-Clouds verbessert werden soll. Spectrum-X koppelt Spectrum-4-Ethernet-Switches mit BlueField-3-DPUs, um eine 1,7-fach bessere Gesamt-KI-Leistung und Energieeffizienz zu ermöglichen.

Spectrum-X wird durch Nvidias Beschleunigungssoftware und Software-Development-Kits (SDKs) unterstützt, die es Entwicklern ermöglichen, softwaredefinierte, Cloud-native KI-Anwendungen zu erstellen. Laut Nvidia setzen Hyperscaler bereits Spectrum-X ein, darunter auch branchenführende Cloud-Innovatoren.

Als Blaupause und Testumgebung für Spectrum-X-Referenzdesigns baut Nvidia »Israel-1«. Das ist ein generativer Hyperscale-KI-Supercomputer, der in Nvidias israelischem Rechenzentrum auf Dell-PowerEdge-XE9680-Servern auf Basis von acht Nvidia-GPUs HGX H100, BlueField-3-DPUs und Spectrum-4-Switches eingesetzt wird. »Transformative Technologien wie generative KI zwingen jedes Unternehmen dazu, die Grenzen der Rechenzentrumsleistung zu erweitern, um Wettbewerbsvorteile zu erzielen«, sagt Gilad Shainer, Senior Vice President of Networking bei Nvidia, und erklärt weiter: »Nvidia Spectrum-X ist eine neue Klasse von Ethernet-Netzwerken, die Barrieren für KI-Workloads der nächsten Generation beseitigt, die das Potenzial haben, ganze Branchen zu verändern.«

Die Nvidia-Spectrum-X-Netzwerkplattform ist aus der Sicht von Nvidia äußerst vielseitig und kann in verschiedenen KI-Anwendungen eingesetzt werden. Sie nutzt standardmäßiges Ethernet und ist mit Ethernet-basierten Stacks interoperabel.

Die Plattform beginnt mit Spectrum-4, dem weltweit ersten Ethernet-Switch mit 51 Tbit/s, der speziell für KI-Netzwerke entwickelt wurde. RoCE-Erweiterungen arbeiten mit den Spectrum-4-Switches, BlueField-3-DPUs und LinkX-Optik zusammen, um ein für KI-Clouds optimiertes 400GbE-End-to-End-Netzwerk zu schaffen.

Die Beschleunigungssoftware für Spectrum-X umfasst Nvidia-SDKs wie Cumulus Linux, pure SONiC und NetQ. Dazu gehört auch das Software-Framework Nvidia DOCA, das das Herzstück der BlueField-DPUs ist.

|

Digitalisierungs-Workflow für die Industrie |

|---|

|

Nvidia erklärt, dass weltweit immer mehr Elektronikhersteller ihre Digitalisierungsbemühungen mit einem neuen, umfassenden Referenz-Workflow vorantreiben. Dieser Workflow kombiniert Nvidia-Technologien für generative KI, 3D-Kollaboration, Simulation und autonome Maschinen. Unterstützt durch ein umfangreiches Partnernetzwerk hilft der Workflow Herstellern, ihre Fabriken mit einer Reihe von Nvidia-Technologien zu planen, zu bauen, zu betreiben und zu optimieren. Dazu gehört Omniverse, Isaac Sim und das Nvidia Metropolis Vision AI Framework, das jetzt auch für die automatische optische Inspektion eingesetzt werden kann. In seiner Keynote präsentierte Huang eine Demo einer vollständig digitalisierten Smart Factory und erklärte: »Die größten Industrien der Welt stellen physische Dinge her. Sie zuerst digital zu bauen kann enorme Kosten sparen. Nvidia macht es Elektronikherstellern leicht, virtuelle Fabriken zu bauen und zu betreiben, ihre Fertigungs- und Prüfabläufe zu digitalisieren und die Qualität und Sicherheit erheblich zu verbessern, während kostspielige Überraschungen und Verzögerungen in letzter Minute reduziert werden.« |

|

Positive Reaktionen seitens der Industrie Der neue Referenz-Workflow wird von Foxconn Industrial Internet, Innodisk, Pegatron, Quanta und Wistron eingesetzt, um ihre Arbeitszellen und Montagelinien zu optimieren und gleichzeitig die Produktionskosten zu senken. So arbeitet Foxconn Industrial Internet beispielsweise mit Ökosystempartnern von Nvidia Metropolis zusammen, um wesentliche Teile der Qualitätsprüfung von Leiterplatten zu automatisieren. »Nvidias Stärke im Bereich KI und sein starkes Ökosystem von Anwendungspartnern bieten Foxconn Industrial Internet einen Weg zu erheblichen betrieblichen Effizienzsteigerungen«, sagt Tai-Yu Chou, CTO bei Foxconn Industrial Internet. »Die Kombination von Nvidia Metropolis für Fabriken und Isaac Sim für die Robotik hilft uns, unsere Ziele im Bereich der industriellen Automatisierung schneller als je zuvor zu erreichen.« Innodisk wiederum setzt Nvidia Metropolis ein, um optische Inspektionsprozesse in seinen Produktionslinien zu automatisieren, Kosten zu sparen und die Produktionseffizienz zu verbessern. Pegatron wiederum nutzt den Referenz-Workflow, um seine Leiterplattenfabriken mit Simulation, Robotik und automatisierter Produktionskontrolle zu digitalisieren. »Nvidia Omniverse, Isaac Sim und Metropolis geben uns die Möglichkeit, KI-Training durchzuführen, Fabrik-Workflows zu verbessern und zahlreiche Simulationen in der virtuellen Welt auszuführen, bevor wir eine Idee in der physischen Welt umsetzen«, sagt Andrew Hsiao, Associate Vice President der Software R&D Division bei Pegatron. »Die Digitalisierung unserer gesamten Fabrik ermöglicht es uns, die Robotik- und Automatisierungspipeline von Anfang bis Ende zu simulieren und Dinge in einer simulierten Umgebung auszuprobieren, was Zeit spart und die Kosten erheblich reduziert.« Diese Aussagen sind nur ein Teil der positiven Resonanz der Industrie. Einheitlicher Workflow Nvidia arbeitet mit mehreren führenden Anbietern von Fertigungstools und Dienstleistungen zusammen, um eine umfassende, einheitliche Architektur auf allen Workflow-Ebenen zu schaffen. Auf Systemebene bietet IGX Orin von Nvidia eine All-in-One-Edge-KI-Plattform, die industrietaugliche Hardware mit Software und Support auf Unternehmensniveau kombiniert. IGX erfüllt die Anforderungen an Langlebigkeit und geringen Stromverbrauch von Edge-Computing und bietet gleichzeitig die hohe Leistung, die für die Entwicklung und Ausführung von KI-Anwendungen erforderlich ist. Die Herstellerpartner ADLink, Advantech, Aetina, Dedicated Computing, Onyx, Prodrive Technologies und Yuan entwickeln IGX-basierte Systeme für den industriellen und medizinischen Markt. Auf der Plattformebene verbindet Omniverse die weltweit führenden Anbieter von 3D, Simulation und generativer KI. Die offene Entwicklungsplattform ermöglicht es Teams beispielsweise, die Interoperabilität zwischen ihren bevorzugten Anwendungen – beispielsweise denen von Adobe, Autodesk und Siemens – herzustellen. In einer Demo während der Keynote wurde Omniverse in Verbindung mit verschiedenen KI-Assistenten wie ChatGPT und Blender GPT gezeigt, um 3D-Workflows und die Entwicklung von Python-Anwendungen zu vereinfachen. Und auf der Anwendungsebene ermöglicht Isaac Sim Unternehmen die Entwicklung und den optimalen Einsatz von KI-basierten Robotern. Hersteller können mit dem Industrieautomatisierungsunternehmen Ready Robotics zusammenarbeiten, um ihre Roboteraufgaben in der Simulation zu programmieren, bevor sie in der realen Welt eingesetzt werden. Simulations- technologiepartner wie SoftServe und FS Studio verkürzen die Entwicklungszeiten für Kunden, indem sie auf digitalen Zwillingen basierende Simulationen erstellen. Auf der Anwendungsebene umfasst Nvidia Metropolis eine Reihe von KI-Workflows für die Fabrikautomatisierung, mit denen Anbieter von Industrielösungen und Hersteller maßgeschneiderte Lösungen für die Qualitätskontrolle entwickeln, einsetzen und verwalten können, die Kosten sparen und den Produktionsdurchsatz verbessern. Ein großes Partner- Ökosystem – darunter ADLink, Aetina, Deloitte, Quantiphi und Siemens – hilft dabei, diese Lösungen auf den Markt zu bringen |

- Systeme, Software, Dienste – alles neu

- MGX – für Datenzentren jedweder Größe