»AI Everywhere«-Event

Emerald Rapids und Intel Core Ultra sind da

Auf der Intel Innovation 2023 hatte Pat Gelsinger, CEO von Intel, angekündigt, dass Mitte Dezember zwei neue Prozessoren für den Server- und den Client-Bereich auf den Markt kommen werden. Und Intel hat geliefert: auf seinem »AI Everywhere«-Event wurde die Verfügbarkeit bekanntgegeben.

Beim »AI Everywhere«-Event betont Gelsinger abermals, dass die Halbleiterindustrie goldene Zeiten vor sich hat. Seiner Meinung nach wird die digitale Wirtschaft ihren Anteil am Bruttoinlandsprodukt von derzeit 15 auf 25 Prozent im Jahr 2030 steigern, und KI wiederum soll dabei ein Drittel der Innovationen vorantreiben. Wobei Gelsinger hinzufügt, dass KI erst einmal eine neutrale Technologie ist, was damit gemacht werde, liege in den Händen der Unternehmen, Regierungen und Nutzern, alle zusammen müssten sicherstellen, dass KI-Technologie verantwortungsvoll vorangetrieben werde. Werde sie jedoch sinnvoll genutzt, könne sie globale Probleme lösen. Dazu sei aber mehr Rechenleistung, schnellerer Speicher und das Ganze in einer nachhaltigen Art und Weise notwendig. Gelsinger ist außerdem überzeugt, dass es notwendig ist, KI auf allen Plattformen zu unterstützen, also nicht nur in Rechenzentren, der Cloud, sondern auch im Edge und den PCs. Dementsprechend erweitert Intel sein Prozessorspektrum im Client- und im Data-Center-Bereich um zwei neue Generationen: mit Intel Core Ultra und mit Xeon in der 5. Generation, die zweite Produkterweiterung im Xeon-Bereich innerhalb von weniger als einem Jahr.

Jobangebote+ passend zum Thema

Intel Ultra Core

PCs mit KI-Fähigkeiten haben laut Michelle Johnston Holthaus, General Manager der Client Computing Group bei Intel, große Wachstumschancen. Sie geht davon aus, dass »AI PCs« bereits 2028 einen Anteil von 80 Prozent des gesamten PC-Marktes ausmachen werden. »Leistungsfähige KI-Tools in den Händen von Millionen Menschen, KI ist definitiv ein Wachstumstreiber für den PC-Markt«, so Holthaus weiter. Und daran will Intel kräftig partizipieren, laut ihrer Aussage habe sich Intel dazu verpflichtet, in den nächsten zwei Jahren über 100 Mio. Client-Prozessoren mit dedizierter KI auszuliefern, »das ist bis zu 5-mal mehr als alle unsere Konkurrenten zusammen«, so Holthaus weiter. Und um AI-PCs Realität werden zu lassen, bringt Intel seine neuen Core-Ultra-Prozessoren auf den Markt. »Sie sind die schnellsten Prozessoren für Ultra-Thin-Notebooks«, so Holthaus.

Intel Core Ultra ist der erste Prozessor, der auf der »Intel 4«-Prozesstechnologie basiert und stellt die größte architektonische Veränderung des Unternehmens seit 40 Jahren dar. Intel nutzt für die Prozessoren seine Foveros-Technologie, mit der ein 3D-Aufbau möglich ist. Die Prozessoren sind mit bis zu 16 Prozessorkernen ausgestattet. Konkret handelt es sich um sechs P-Cores (P steht für Performance), acht E-Cores (E steht für Efficient) und zwei LP E-Cores (Low Power Efficient), dank derer sich nicht nur der IPC-Wert (Anweisung pro Zyklus) erhöhen ließ, sondern eine Multi-Threading-Leistung erreichen lässt, die laut Intel um bis zu elf Prozent höher als bei konkurrierenden Prozessoren für ultradünne PCs liegt. Manche der neuen Intel Core-Ultra-Prozessoren sind mit der Arc-GPU – mit bis zu acht Xe-Kernen, AI-basiertem Xe Super Sampling und DX12 Ultimate-Unterstützung – von Intel ausgestattet und erhöhen die Grafikleistung im Vergleich zum Vorgänger bis um den Faktor 2. Die GPU unterstützt Hardware-seitig Grafikfunktionen wie Raytracing, Mesh-Shading, AV1-Codierung und -Decodierung etc. Die ebenfalls integrierte NPU wurde speziell für die Abarbeitung länger laufender KI-Workloads bei geringem Stromverbrauch entwickelt. Dank der NPU konnte die Energieeffizienz im Vergleich zur vorherigen Generation um einen Faktor von maximal 2,5 erhöht werden.

AI PC Acceleration Program

Laut eigener Aussage hat Intel seinen Prozessor mit 20 KI-Modellen und Arbeitslasten getestet, »Ultra Core ist der einzige Prozessor, der alle verschiedenen KI-Arbeitslasten erfolgreich abarbeiten kann«, so Holthaus. Eine gute Hardware ist entscheidend, aber auch die Software ist wichtig. Dementsprechend hat Intel vor Kurzem sein globales »AI PC Acceleration Program« gestartet. Holthaus erklärt weiter, dass im Rahmen des Intel AI PC Acceleration Program mehr als 100 ISVs (Independent Software Vendors) und mehr als 300 KI-beschleunigte Funktionen für Intel Core-Ultra-Prozessoren optimiert werden – das sind laut ihrer Aussage dreimal mehr KI-Anwendungen und Frameworks als bei jedem konkurrierenden Halbleiterunternehmen – und das in weniger als einem Jahr. Holthaus: »Ich denke, durch die Tatsache, dass wir KI auf den PC bringen, wird KI am schnellsten wachsen. Andere erzählen gerne, was kommen wird, wir bringen entsprechende Produkte heute auf den Markt. Es gibt eine ganze Palette von Intel Core-Ultra-Prozessoren und es wird mehr als 230 Designs von unseren OEMs, einschließlich Acer, Asus, Dell, HP, Lenovo, LG, MSI, Samsung etc. geben.«

Xeon 5. Generation

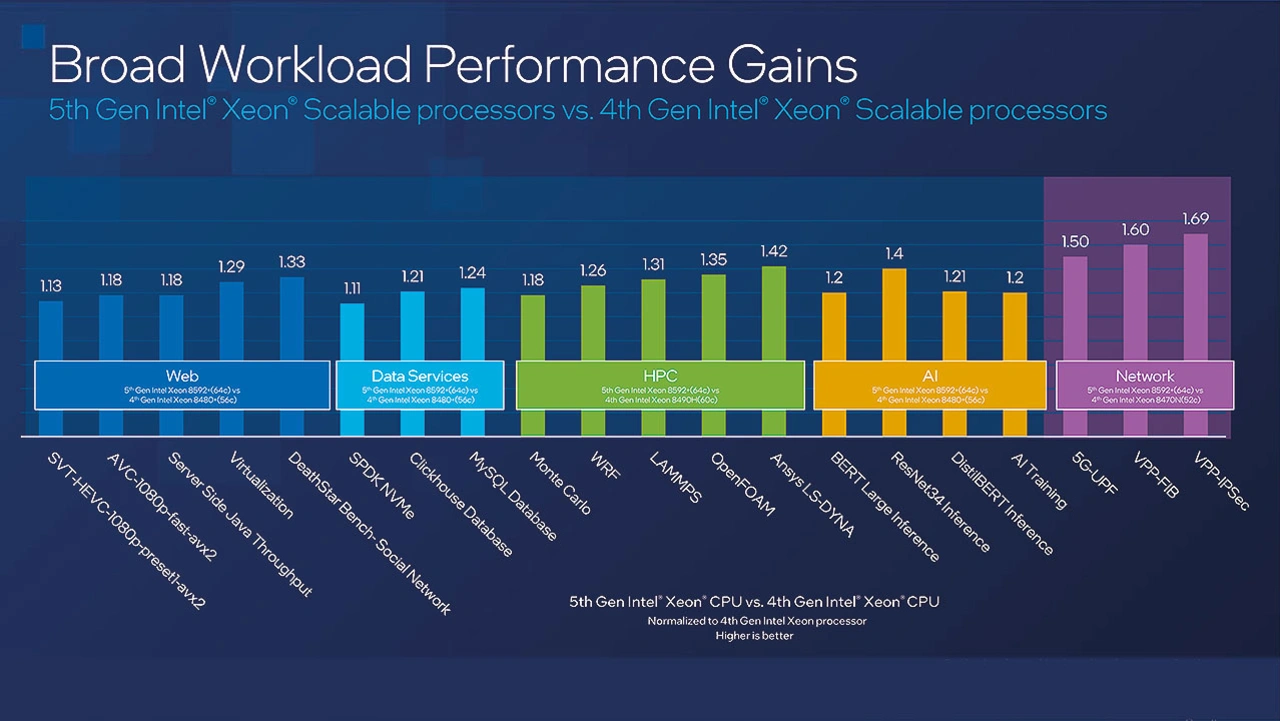

Sandra Rivera, General Manager der Data Center and AI Group von Intel, wiederum erklärt, dass die Xeon-Prozessoren der 5. Generation die leistungseffizientesten, leistungsstärksten und sichersten Xeon-Prozessoren sind, die Intel jemals ausgeliefert hat. Im Durchschnitt kommen die neuen Prozessoren laut ihrer Aussage auf eine um 21 Prozent erhöhte Rechenleistung gegenüber der 4. Generation der Xeon-Prozessoren, geht es um Inferenzieren, sieht der Leistungszugewinn sogar noch besser aus: Rivera spricht hier von bis zu 42 Prozent. In Hinblick auf die Effizienzsteigerung heißt es wiederum, dass die neuen Xeon-Prozessoren gegenüber den Vorgängervarianten im Durchschnitt eine um 36 Prozent höhere Leistung pro Watt erreichen. Kunden, die typischerweise alle fünf Jahre auf die neuste Xeon-Generation wechseln, könnten mit den neuen Xeon-Prozessoren ihre TCOs (Total Costs of Ownership) um bis zu 77 Prozent senken.

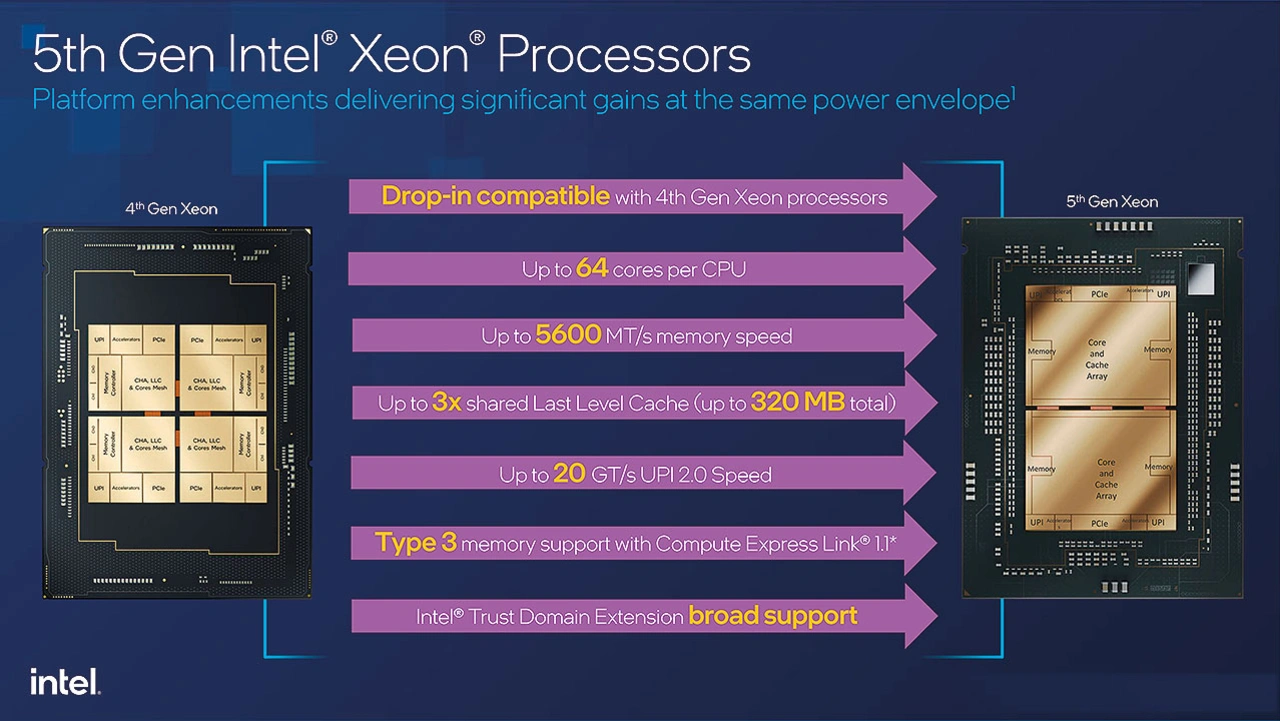

Die neuen Xeon-Prozessoren sind natürlich auch auf KI-Arbeitsleistung ausgelegt, dementsprechend ist jeder integrierte Prozessorkern – bei der 5. Generation immerhin bis zu 64 Kerne – mit KI-Fähigkeiten ausgestattet. Darüber hinaus hat Intel den Last-Level-Cache im Vergleich zur Generation Xeon 4 um den Faktor 3 erhöht, sodass bis zu 320 MB zur Verfügung stehen. Die Prozessoren verfügen über bis zu acht DDR5-Kanäle pro CPU (bis zu 5600 MT/s) und erhöhen die Bandbreite zwischen den Sockeln mit Intel UPI 2.0 (bis zu 20 GT/s). OEMs wie Cisco, Dell, HPE, IEIT Systems, Lenovo, Super Micro Computer etc. werden laut Intel ab dem ersten Quartal 2024 eine breite Auswahl an Single- und Dual-Socket-Systemen anbieten. CSPs (Cloud Service Provider) wiederum wollen laut Intel im Laufe des Jahres Instanzen mit 5. Generation Xeon-Prozessoren anbieten.

Die Xeon-Prozessoren der 5. Generation sind außerdem mit Intel-TDX ausgestattet (Trust Domain Extensions). Bei TDX handelt es sich um Architekturelemente, die die Realisierung von Hardware-mäßig isolierten VMs (Virtuelle Maschinen) erleichtern. TDX wurde bereits mit der 4. Generation eingeführt und war bei einigen CSPs verfügbar, mit der 5. Generation will Intel eine allgemeine Verfügbarkeit bei allen OEMs und CSPs ermöglichen und somit die Sicherheit erhöhen.

Rivera weiter: »Die 5. Generation ist die beste CPU für KI in Datenzentren. Wir haben in jeden der 64 Prozessorkerne KI-Fähigkeiten integriert. Für Training und die Nutzung von großen Generative-AI-Modellen haben wir unseren Gaudi2-Beschleuniger. Wir haben bereits demonstriert, dass Gaudi2 führend in Hinblick auf das Preisleistungsverhältnis im Vergleich zu den populärsten GPUs ist. Basierend auf den neusten MLPerf-Training-Benchmarks und einem geschätzten Bereich von Server-Preisen, liefert Gaudi 2 zwischen 40 und 50 Prozent bessere Preis-Leistungswerte als Nvidias H100 für das Training des GPT-3-Modells mit 175 Mrd. Parametern. Mit Gaudi2 und Xeon ermöglichen wir die leistungsstärksten KI-Supercomputer.«

One size fits all – geht nicht!

Intel ist überzeugt, dass ein Plattformansatz notwendig ist, um KI überall zu ermöglichen. Und genau das verfolgt Intel mit seinen verschiedenen Prozessoren. Rund um diese Plattformen steht ein gemeinsamer Software-Stack zur Verfügung, der auf offenen Standards basiert. Rivera abschließend: »Das ermöglicht eine größere Programmierbarkeit, die Portierbarkeit von Modellen und die Adaption von Ökosystemen. Wir haben unsere KI-Plattformen auf jeder einzelnen Ebene optimiert, vom Silizium, über alle Ebenen des Software-Stacks, bis hoch zur Applikationsebene. Mit den Software-Tools und der zugrundeliegenden Hardware können Entwickler einen einzigen Code entwickeln, der auf verschiedenen Plattformen läuft, sprich CPUs, GPUs und KI-Beschleuniger, und sie können ihre KI-Modelle skalieren, von der Cloud zum Netzwerk bis hin zum intelligenten Edge.