Starterset für Embedded-Vision

KI-Systeme einfach entwickeln

Das Integrieren von Vision-Anwendungen entscheidet über den Erfolg von KI-basierten Systemen – zum Beispiel beim autonomen Fahren. Um als Entwickler schnell zum gewünschten Ergebnis zu gelangen, bieten sich vorkonfigurierte Baukästen an. Congatec bietet zusammen mit Basler eine solche Plattform an.

Das Auge ist eine Meisterleistung der Natur. Angefangen von der lichtempfindlichen Netzhaut über den informationsführenden Sehnerv bis hin zum analysierenden Gehirn – das natürliche Sehen ist ein hochkomplexes Verarbeiten von Daten. Über eine neuronale Vernetzung arbeitet es mit geringem Energiebedarf. Die intelligente Abstraktion des Gesehenen macht es Menschen und Tieren möglich, in Sekundenbruchteilen zu entscheiden, welche Relevanz das vom Auge eingefangene sichtbare Licht für das eigene Leben hat. Eine Meisterleistung der natürlichen Intelligenz, deren Entwicklung Jahrmillionen dauerte. So lange können sich Entwickler von Embedded-Systemen auf Basis von künstlicher Intelligenz (KI) nicht Zeit lassen.

Aus dem Grund setzen Entwickler auf kompakte und vorkonfigurierte Embedded-Vision-Baukästen, die bewährte Hardware und Software der KI energieeffizient kombinieren. Aktuell sind Applikationen gefragt, die vor allem auf das Edge Computing abgestimmt sind. Für KI-basierte Systeme liegt hier der neuralgische Punkt, um in Echtzeit auf Basis der großen Menge an Bildinformationen fundiert zu entscheiden. Hingegen ist der Umweg über eine cloudbasierte Analyse nicht nur zeitaufwendiger, sondern darüber hinaus von einer kontinuierlichen Verfügbarkeit des Netzes abhängig. Am Edge ist man jedoch immer am Ort des Geschehens und kann in Sekundenbruchteilen autark visuelle Bilddaten erfassen und auswerten.

Jobangebote+ passend zum Thema

Herzstück eines Embedded-Vision-Systems

Um am Edge jedoch eine Leistung zu ermöglichen, die für Deep Learning (DL) und maschinelles Lernen (ML) ausreicht, ist ein neuromorpher Prozessor – oder Neural Processing Unit (NPU) – unabdingbar. Eine NPU eignet sich insbesondere für die Analyse von Bildern und Mustern und stellt somit die zentrale Recheneinheit für ein KI-basiertes Embedded-Vision-System dar. Inspiriert von der Architektur eines neuronalen Netzes im Gehirn können neuromorphe Prozessoren ereignisgesteuert arbeiten und benötigen lediglich gelegentlich Energie. Somit benötigen NPUs selbst bei hoher Rechen- und Grafikleistung nur wenige Watt an Leistung. Gleichwohl können solche Low-Power-NPUs mehrere TOPS (Tera Operations per Second) leisten. Somit genügen sie den Anforderungen, die Entwickler beim Edge-Computing an ihre Embedded-Systeme stellen.

Edge Computing im Fokus

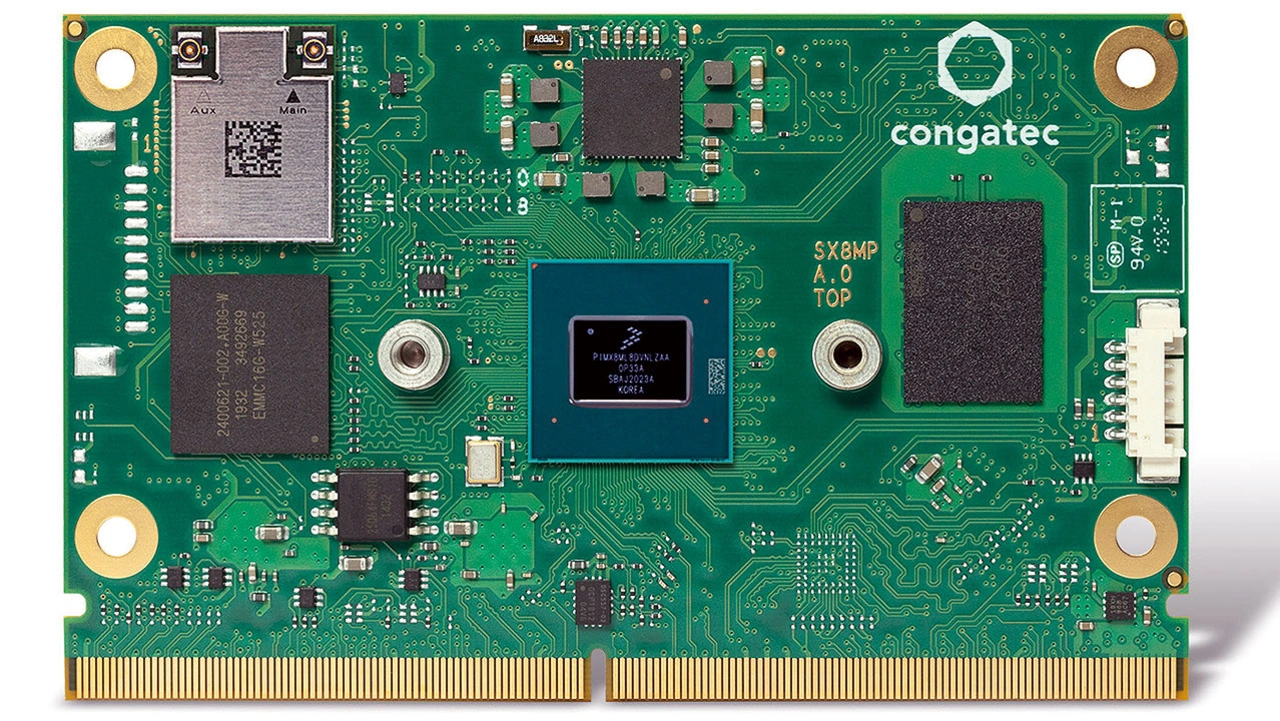

Der Halbleiterhersteller NXP hat seinen i.MX-8M-Plus-Prozessor mit einer solchen NPU ausgestattet, um ihn fit für das maschinelle Lernen zu machen. Kombiniert mit vier Arm-Cortex-A53-Kernen und einem Arm Cortex-M7-Controller erzielt die Einheit bis zu 2,3 TOPS. Zudem besitzt der i.MX 8M Plus einen Image-Signal-Prozessor (ISP) für das parallele Verarbeiten von hochaufgelösten Bildern und Videos in Echtzeit. Er erlaubt bereits beim Erfassen ein Vorverarbeiten der Bilder. So kann die NPU im Nachgang noch eindeutigere Ergebnisse liefern – das ist sowohl für das Verarbeiten von Bildern mit hoher Leistung in der Industrie interessant als auch überall dort, wo Entwickler mithilfe von Bildbearbeitungsalgorithmen bessere visuelle Ergebnisse erzeugen möchten. Um mehr und mehr Edge-Applikationen mit dem NXP-Prozessor auszustatten, hat Congatec ein Starterset konzipiert und auf den Markt gebracht (Bild 1).

Herzstück des Embedded-Vision-Baukastens ist ein kreditkartengroßes SMARC 2.1 Computer-on-Module (CoM) mit dem i.MX-8M-Plus-Prozessor (Bild 2). Das Modul kann bis zu drei unabhängige Displays ansteuern und verfügt über ein hardwarebeschleunigtes Codieren und Decodieren von Videodaten. Zudem gewährleistet der Videokomprimierungsstandard H.265, dass sich von der NPU vorselektierte Streamingsequenzen der Kamera direkt über das Netzwerk an zentrale Leitstellen übertragen lassen. An Datenspeicher finden Entwickler auf dem CoM bis zu 128 GB eMMC vor. Außerdem bietet das mit mehreren Peripherieschnittstellen ausgestattete Modul Zugriff auf ein umfangreiches Ökosystem für KI-basierte Embedded-Systeme. Je nach Ausstattung ist es für den Einsatz im Temperaturbereich von -40 bis +85 °C geeignet. Für den Betrieb benötigt das passiv gekühlte SMARC-Modul eine Leistung von 2 bis 6 W.

- KI-Systeme einfach entwickeln

- Hardware muss robust und verlässlich sein