Den Flaschenhals weiten

Mit kombinierten Systemen Fahrzeugsensoren schneller validieren

Bevor ADAS- und AD-Systeme in Serie gehen können, sind kosten- und zeitintensive Tests erforderlich. Eine Sisyphusarbeit, für die es neue Entwicklungen und Lösungen gibt – zum Beispiel cloudbasierte holistische Systeme.

Fahrerassistenzfunktionen bis hin zum teilautonomen Fahren werden für die Kunden immer wichtiger und sind von einer imageträchtigen Luxusspielerei zum relevanten Kaufkriterium geworden. Unternehmen wie Tesla befeuern den Trend. Und es gibt zusätzlich Druck für die Entwicklungsabteilungen der Fahrzeughersteller durch neue Regulatorien (EU Vehicle General Safety Regulation, Vision Zero) oder angepasste Crashtest-Anforderungen.

Im Ergebnis wetteifern aktuell gleich mehrere OEMs um Level-3-Zulassungen, also Zulassungen für hochautomatisiertes Fahren, bei dem der Fahrer zumindest vorübergehend in bestimmten Situationen Fahraufgabe und Verkehr der Technik überlassen darf. Die technischen Voraussetzungen sind gegeben, der Flaschenhals bei der Entwicklung von leistungsfähigen ADAS- und AD-Systemen ist allerdings nach wie vor der Test bzw. die Validierung der für die neuen Assistenzfunktionen benötigten hochkomplexen Sensorik.

300 Stunden Labeling pro Teststunde

Denn erst durch die Validierung mithilfe von Referenzdaten kann überprüft werden, wie gut das System funktioniert. Zum Beispiel der Totwinkelassistent: Nur durch den Abgleich der durch das System gedeuteten Daten mit der Realität kann ausgesagt werden, dass das System auch wirklich Fahrzeuge mit einer hohen Sicherheit von bis zu 95 Prozent erkennt.

Andersherum wäre es keine große Hilfe, wenn dies eben nur zu 50 Prozent funktioniert. Schließlich geht es um Sicherheit. Bei diesem System wären es also andere Fahrzeuge, die verlässlich erkannt werden müssen, beim Fußgänger-Notbremsassistent sind es Passanten oder beim Fahrspurassistent Spurmarkierungen.

_____________________________________________________________________

Die ibeo.Reference-Toolchain

Mit der »ibeo.Reference-Toolchain« erhält der Nutzer alle notwendigen Bausteine zur Sensorvalidierung aus einer Hand:

➔ Das Recording-System, bestehend aus Hard- und Software, zum Einfahren der Referenzdaten, das auch ausgewählte LiDAR-Sensoren von Drittanbietern unterstützt.

➔ ibeo Auto Annotation als skalierbare, Cloud-kompatible Software zur automatisierten Erstellung von gelabelten Referenzdaten.

➔ Editoren zur Weiterverarbeitung der Referenzdaten zu Ground-Truth-Daten

_____________________________________________________________________

Damit dies alles zuverlässig funktioniert, sind zur Validierung der neu entwickelten Systeme Vergleichsdaten, sogenannte Referenzdaten, notwendig, mit denen das zu testende System verglichen wird. Das bedeutet: Es muss überprüft werden, ob das System die verschiedenen Objekte auf und neben der Straße auch tatsächlich als das erkennt, was sie sind. Dabei ist die konkrete Technik der Fahrzeugsensorik erst einmal zweitrangig: Kamerasysteme, radarbasierte oder LiDAR-Sensoren – für jedes System werden Referenzdaten benötigt, die dann mit den in Tausenden Stunden Testprozess eingefahrenen Daten abgeglichen werden müssen.

Je nach Komplexität des Systems fallen nach der Testphase noch einmal viele tausend Stunden Arbeit für das manuelle Abgleichen der eingefahrenen Daten an – das sogenannte Labeling, mit dem sichergestellt wird, dass die Vergleichsdaten tatsächlich die Realität abbilden. Pro Teststunde rechnet man hier bis zu 300 Stunden, in denen konventionell jedes Bild und jeder gefahrene Meter von Menschen an Monitoren abgeglichen und ausgewertet werden muss. Wurde die Fahrspur als solche erkannt? Ist der kleine Baum am Straßenrand vielleicht doch ein Mensch? Wurden zwei nebeneinander fahrende Motorräder vom System versehentlich als ein PKW gewertet?

Menschen machen Fehler

Um diesem enormen Aufwand des Labeling-Prozesses überhaupt zeitlich gerecht werden zu können, greifen Hersteller und Zulieferer bislang weitgehend auf externe Dienstleister zurück. Dort – meist in Ländern mit einem sehr niedrigen Stundenlohn – werten dann Hunderte von Mitarbeiter die Daten händisch aus, labeln Frame für Frame, Objekt für Objekt. Danach werden diese Daten nochmals geprüft – denn immer dort wo Menschen detailintensiv, aber eben auch sehr monoton an einer Aufgabe arbeiten, können je nach Tagesform auch Fehler passieren.

Ein weiterer Nachteil, der die Prozesse verzögert: Die Rohdaten müssen für die Labeling-Prozesse langwierig übertragen werden. Es handelt sich dabei oft um mehrere Terrabytes Datenmaterial, das dazu noch kompatibel zu den von den Labeling-Providern genutzten Systemen sein und auf diese abgestimmt werden muss.

Abhängigkeiten entstehen

Um schneller zu werden und gleichzeitig die Qualität zu steigern, lassen erste Dienstleister einen Teil der Daten bereits von Algorithmen oder mithilfe von künstlicher Intelligenz labeln, um ihre Mitarbeiter zu entlasten und den Prozess zu beschleunigen. Gleichzeitig werden die manuell validierten Daten dazu verwendet, um die Algorithmen zu trainieren und das sogenannte Vorlabeln zu verbessern. Das System lernt also selbstständig und wird so aus sich selbst heraus optimiert.

Dies ist nicht nur mit enormen Kosten verbunden, sondern mit einem weiteren ganz erheblichen Nachteil für die Hersteller der zu referenzierenden Systeme: Der Besitz der Daten und das Know-how um die Datenverwertung wird aus der eigenen Hand an unabhängige Unternehmen weitergegeben.

Dabei sind gerade automatisierte Fahrfunktionen ein immer wichtigerer Wettbewerbsvorteil von Fahrzeugherstellern. Das Wissen darum, wie diese entwickelt und so validiert werden, dass sie sicher funktionieren, ist längst zu einer Kernkompetenz geworden. Da das Erstellen von Referenzdaten so aufwendig ist, haben die Daten also bereits als solche schon einen großen Wert, da sie nicht »mal eben so« zu beschaffen sind, sondern erst aufwendig eingefahren und ausgewertet werden müssen.

Jene Hersteller, die dieses Know-how auslagern, laufen Gefahr, in eine große Abhängigkeit von externen Dienstleistern zu geraten – mit unkalkulierbaren Auswirkungen auf eine mögliche Weitergabe von Technologien an Mitbewerber oder zukünftige Verhandlungspositionen zum Beispiel in der Preisgestaltung. Die Abhängigkeit führt neben dem Risiko von Technologiespionage mittelfristig zu hohen Kosten und limitierter Flexibilität auf Herstellerseite.

Angesichts der Erkenntnis, dass Daten und das Wissen, wie und wo man diese einsetzt, zukünftig weiter an Relevanz gewinnen werden, erscheint die Lösung des externen Labelings also langfristig als Sackgasse.

Cloudbasierte holistische Lösung

Ziel der Hersteller kann es nur sein, die gesamte Prozesskette zur Erstellung von Referenzdaten wieder in die eigene Organisation zu integrieren, um das Know-how zu sichern, aber auch um Wege zu verkürzen und bei Bedarf schnell und unkompliziert auf die Prozesse zugreifen und diese an wechselnde Use Cases anpassen zu können.

In dieser Prozesskette gilt es nun, alle Einzelaufgaben so miteinander zu verknüpfen, dass diese miteinander harmonieren und auf den künftigen Bedarf skalierbar sind. Aus OEM/Tier1-Sicht muss also nicht ein einzelnes Werkzeug gefunden werden, sondern ein Gesamtsystem, das das Aufnehmen der Referenzdaten, das automatische Labeln, Editieren, Visualisieren und Auswerten holistisch abbildet.

Dabei müssen folgende Herausforderungen beachtet werden:

- Es muss das Zusammenspiel der Einzelteile innerhalb der Prozesskette sichergestellt werden. Der Output der jeweils vorangegangenen Komponente muss als Input für die Folgekomponente funktionieren. Einige Bausteine sollten dabei miteinander harmonieren: Das Recording-System, bestehend aus Hard- und Software, zum Einfahren der Referenzdaten. Aus wirtschaftlichen Gründen sollte dieses System eine Vielzahl von Sensoren unterstützen und nicht nur die Sensoren einzelner Hersteller. Dazu kommen eine skalierbare, cloudkompatible Software zur automatisierten Erstellung von gelabelten Referenzdaten sowie die Editoren zur Weiterverarbeitung der Referenzdaten zu Ground-Truth-Daten.

- Beim Einfahren der Testszenarien fallen viele Terrabytes Datenmaterial an, die sich nur dann effektiv auswerten lassen, wenn das System diese Menge stückweise und skaliert verarbeiten kann. Hierbei bieten cloudbasierte Zwischenspeicher eine gleichsam sichere und wirtschaftlich vernünftige Lösung. Allerdings muss das Gesamtsystem mit allen Komponenten eine solche Speicherung in der Cloud auch technisch unterstützen.

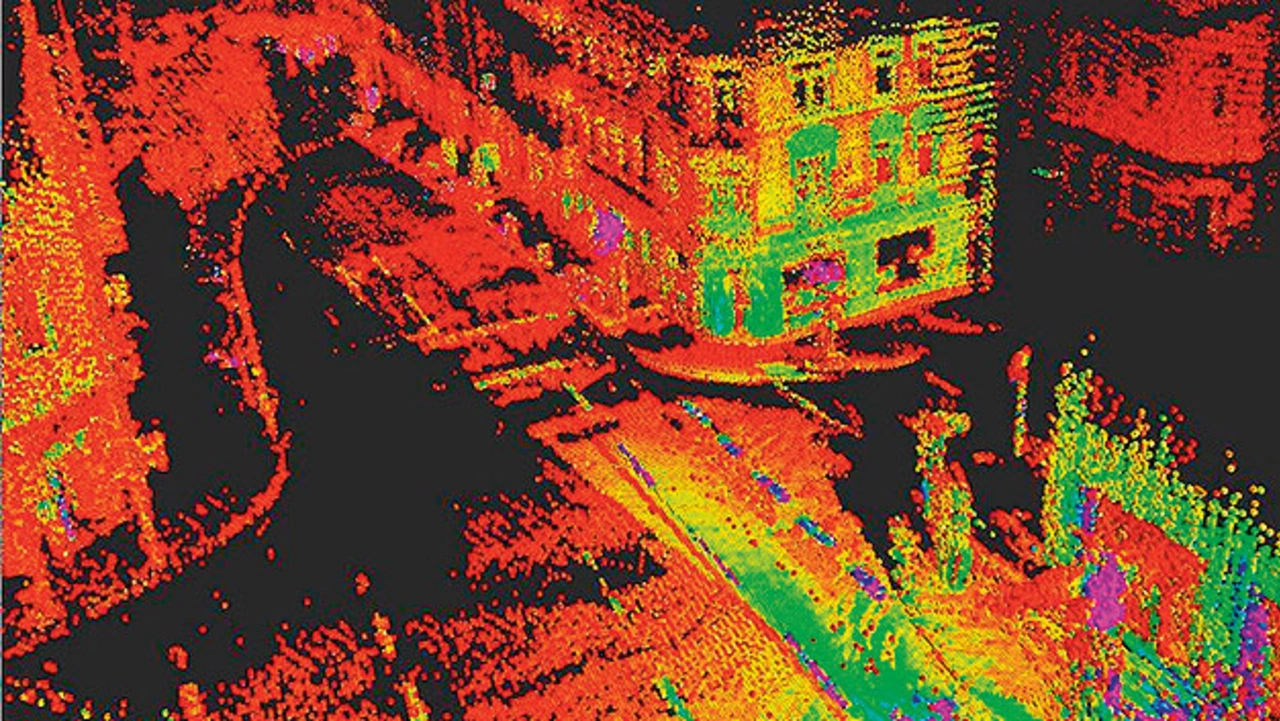

- Die Sensoren des Referenzsystems müssen präziser sein als die zu referenzierenden Sensoren. LiDAR hat dabei den Vorteil der im Vergleich zum Radar sehr hohen Winkel- sowie Distanzauflösung. Das bedeutet, dass ein Radar sehr grob in bestimmte Richtungen »schauen« kann, LiDAR-Systeme aber Objekte viel feiner abtasten können (0,25° horizontale Winkelauflösung und 10 cm Entfernungsauflösung beim Ibeo-LUX-Sensor). Allerdings können LiDAR-Sensoren nur eingeschränkt durch Nebel hindurchsehen. Radare hingegen erkennen Fahrzeuge auch bei schwierigen Sicht- und Witterungsverhältnissen. Kameras eignen sich ihrerseits sehr gut, um Verkehrsschilder und Ampeln zu erkennen. Das können weder LiDAR noch Radar leisten. Jedoch sind Kameras auf ausreichend Licht angewiesen.

- Gleichzeitig muss das Referenzsystem – unabhängig ob das nun auf LiDAR,Kamera oder Radar basiert – flexibel an die zu testenden Sensoren anpassbar sein. In den meisten Fällen verfügen Fahrzeuge ja über mehrere verschiedene Assistenzsysteme, die alle ihre eigenen Spezialisierungen haben und dementsprechend auch auf einer jeweils unterschiedlichen Sensortechnologie beruhen. So sind die zu prüfenden Szenarien eines Spurhalteassistenten ganz anders als die von einem Totwinkelassistenten. Das System muss also in der Lage sein, sich an die verschiedenen Use Cases anpassen und in jedem Bereich optimale Referenzwerte liefern zu können. Dies ist nur gegeben, wenn zum einen verschiedene Sensortypen, zum anderen verschiedene Einbauorte im Auto unterstützt werden.

- Last, but not least sollte das Referenzsystem regelmäßig für die technischenWeiterentwicklungen erweiterbar bzw. daran anpassbar sein. Denn die Technologie verändert sich rasant.

Zusammengefasst ist es also wichtig, bei der Referenzierung von Sensoren auf ein skalierbares Komplettsystem zu setzen, das in der Kombinierbarkeit der LiDAR-Komponenten nahezu alle Herausforderungen abdeckt, und das technisch regelmäßig erweitert wird. Aktuelle Systeme wie etwa ibeo.Reference bieten solche flexiblen Möglichkeiten bereits heute und harmonieren auch mit LiDAR-Sensoren anderer Hersteller. Derart ausgerüstet, können Hersteller schneller, präziser und kostengünstiger entwickeln und damit der Gesamtvision von voll automatisierter Mobilität ein großes Stück näher kommen.

Dre Autor

Dr.-Ing. Rico Mendrzik

ist als Produktleiter beim LiDAR-Experten Ibeo unter anderem zuständig für die Entwicklung- und Vermarktung von LiDAR-basierten Referenzsystemen wie ibeo.Reference. Bereits während seiner Promotion 2019 über Nachrichtentechnik an der Technischen Universität Hamburg Harburg hat Mendrzik verschiedene gastwissenschaftliche Stationen zum Beispiel an der University of California Los Angeles (UCLA), dem Massachusetts Institute of Technology (MIT) und dem NATO Center for Maritime Research absolviert.