Von-Neumann-Architektur-Limits knacken

Neuromorphe Systeme

Weltweit versuchen Ingenieure, »neuromorphe Systeme« zu entwickeln, die die Informationsverarbeitung des menschlichen Gehirns imitieren.

Die Von-Neumann-Architektur - im einfachsten Fall mit den drei Komponenten CPU (Steuer- und Rechenwerk), Hauptspeicher für Daten und Programm und Bus – ist der bislang am häufigsten in Computer-Systemen zum Einsatz kommende Ansatz. Der derzeit schnellste Supercomputer, der Tianhe-2 aus China, kommt mit diesem Ansatz auf 33,86 PetaFLOPs (Billiarden Rechenschritte/s).

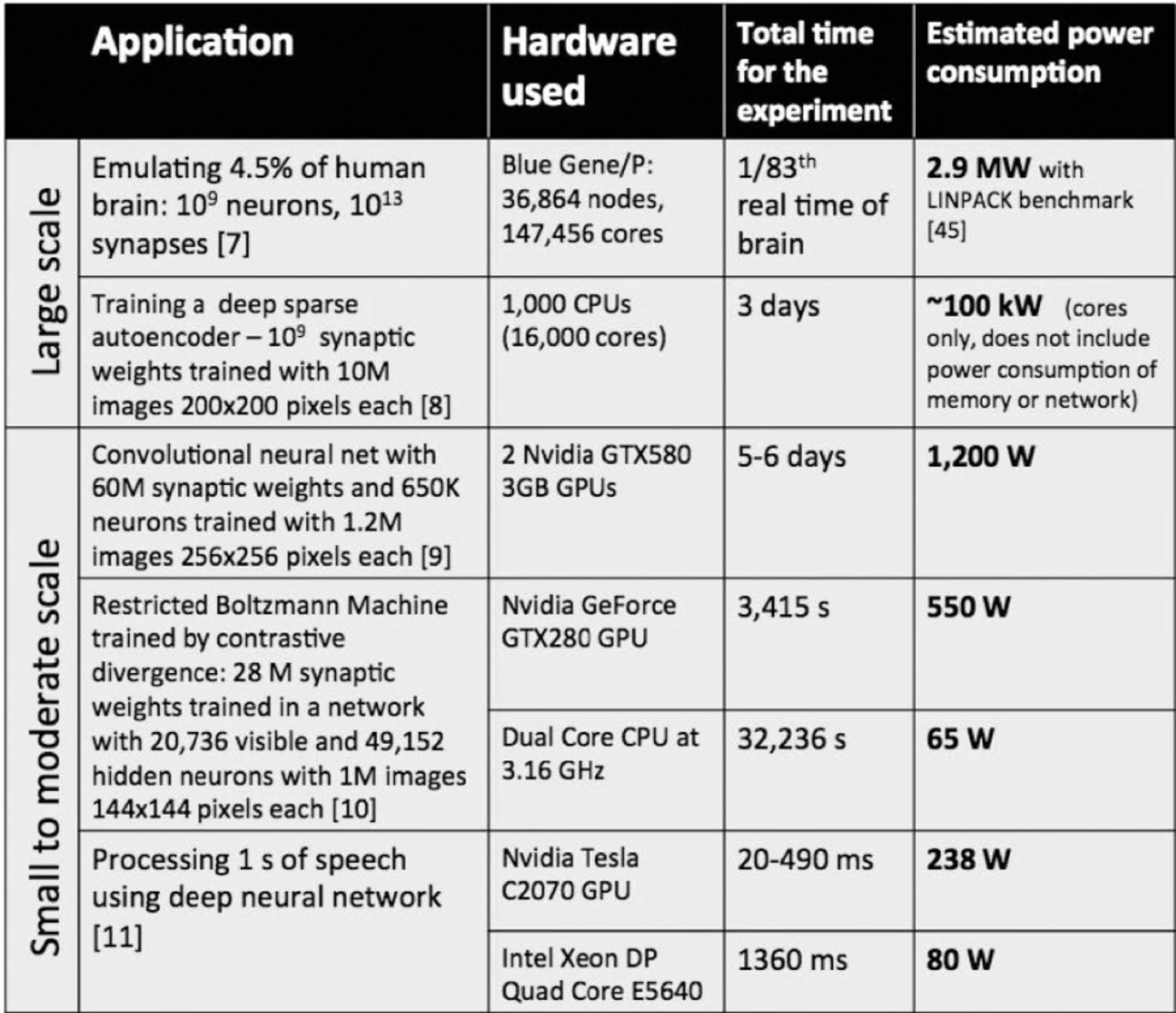

Geht es aber um Applikationen wie Bild- oder Spracherkennung, ist die Von-Neumann-Architektur ineffizient. Das menschliche Gehirn hingegen hat mit der Bild- und Spracherkennung keine Probleme. Für Menschen ist es einfach, komplexe Szenen, aber auch einzelne Objekte in kürzester Zeit zu erfassen und zu analysieren. Also liegt es nahe, das menschliche Gehirn als Vorbild zu nehmen, um auch in Bereichen wie Objekterkennung auf gute Ergebnisse zu kommen, wobei neuromorphe Ansätze weitere Vorteile gegenüber dem Von-Neumann-Ansatz haben: Der Energieverbrauch ist sehr niedrig, sie gelten als fehlertolerant, und sie sind lernfähig.

Jobangebote+ passend zum Thema

In neuromorpher Hardware werden die zwei Grundbausteine – Neuronen und Synapsen – nachgebildet, die auch im menschlichen Gehirn zu finden sind. Schätzungen über das menschliche Gehirn sprechen von über 1 Billion Nervenzellen, jede Nervenzelle hat Kontakt mit vielen anderen – hier liegen die Schätzungen bei bis zu 15.000 Kontakten. Solche Dimensionen sind derzeit mit Silizium bei weitem nicht realisierbar, aber es gibt schon einige Implementierungen von neuromorpher Hardware. Zu den bekanntesten zählt TrueNorth von IBM, der im August 2014 vorgestellt wurde. Der Chip (2. Generation) mit 5,4 Mrd. Transistoren verfügt über 1 Mio. Neuronen und 256 Mio. programmierbare Synapsen und ein On-Chip-Netz mit 4096 neurosynaptischen Cores. Die Leistungsaufnahme beträgt 70 mW im Echtzeitbetrieb.

Auf der letzten IEDM erklärte S. Burc Eryilmaz vom Electrical Engineering Department der Stanford University, dass TrueNorth (ein rein digitales Design) dank der lokalen Nähe zwischen Synapsen (SRAM) und Neuronen zwar sehr energieeffizient ist, aber: »Die SRAM-Synapse ist volatil, verbraucht viel Platz und weist Grenzen in der Skalierung auf.« Dabei sind seiner Meinung nach gerade die Synapsen ein wichtiger Punkt, denn sie sind im Vergleich zu den Neuronen deutlich in der Überzahl. Deshalb müsste man bei der Implementierung der Synapsen genau überlegen, welche Technologie genutzt wird, und die auswählen, die in Hinblick auf Leistungsaufnahme, Geschwindigkeit, Größe/Dichte und Verdrahtung günstiger ist. Deshalb hält er neue nichtflüchtige Speicherelemente wie RRAM, Phasenwechselspeicher (PCM), CBRAM (Conductive Bridge Memory) und FeRAM (ferroelektrische Speicher) für die bessere Variante, weil sie genau die Charakteristiken aufweisen, die für elektronische Synapsen wünschenswert sind. Dass er mit der Meinung nicht alleine steht, zeigen zahlreiche Implementierungen, die auf neue NVM-Technik setzen und auf denen eine Vielzahl von Algorithmen zum Einsatz kommen, einschließlich diverser STDP-Regeln (Spike Timing Dependent Plasticity).

Eryilmaz bemängelt, dass die bisherigen Simulationen mit RRAM-basierenden Synapsen zwar vielversprechende Ergebnisse (überwachtes Lernen) zeigten, aber bei diesen Studien seien viele nicht ideale Faktoren unberücksichtigt geblieben. Variationen zwischen den Einheiten, nicht-lineares Verhalten, Cycle-to-Cycle-Variationen, all das beeinflusse die Ergebnisse. Hier könnten Redundanzen, verlängerte Latenzzeite, mehr Iterationsschritte etc. Abhilfe schaffen. In der Summe hält er aber dennoch die neuen NVM-Techniken für eine gute Alternative, um die Synapsen-Funktion zu emulieren. Es müsste beim Design allerdings auf die Materialeigenschaften und die Array-Architektur geachtet werden, damit sie in die Netztopologie und zu den Algorithmen passt.

IBM hat auf der letzten IEDM auch ein neuromorphes System für SNNs (Spiking Neural Networks) vorgestellt, das mit einer 64-K-PCM-Zelle (Phase Change Material) als Synapsen-Array ausgestattet war. Die implementierten 256 LIF-Neuronenschaltungen (LIF: leaky integrate and fire, vereinfachtes Neuronenmodell) sind konfigurierbar und können eine Gewichtung der Synapsenstärke nach der STDP-Methode (spike-timing dependent plasticity) durchführen. Die 2T-1R-PCM-Zelle trennt die LIF- und STDP-Pfade und minimiert die Schaltungsgröße. Die Implementierung des STDP-Lernalgorithmus zusammen mit der 2T-1R-Struktur ermöglicht, dass LIF und STDP asynchron und gleichzeitig innerhalb des Arrays arbeiten können. Dadurch kann auf ein aufwendiges Timing verzichtet werden, was Fläche und Energie spart. IBM hat den Core bereits mit einem 90-nm-Prozesses gefertigt und die Lernfähigkeit des Systems erfolgreich getestet. Darüber hinaus wird auch mit anderen Speichertechniken wie VRRAM (Vertical RRAM), RRAM oder Memristive-Bauteilen für die Synapsen experimentiert. Welcher dieser Ansätze das Rennen machen wird, steht bislang noch in den Sternen.

- Neuromorphe Systeme

- Vorzeigeprojekt der EU: Human Brain Project