Ecosystem für Embedded Vision

»MIPI ist viel mehr als eine Schnittstelle«

Vor rund fünf Jahren präsentierte Vision Components (VC) die ersten MIPI-Kameras für industrielle Anwendungen. Was gibt es hier Neues, wie können Unternehmen künftig noch besser von der Technologie profitieren, und welchen Einfluss hat KI auf Embedded Vision?

Jan-Erik Schmitt, Vice President of Sales von Vision Components, gibt Antworten.

Markt&Technik: MIPI-CSI definiert die Verbindung zwischen Kamera und Prozessorboard. Was ist das Besondere daran?

Jan-Erik Schmitt: Das stimmt. Als die MIPI-Alliance den Standard entwickelte, waren MIPI-CSI-1 und das heute verbreitete MIPI-CSI-2 lediglich Definitionen für die Kamera-Prozessor-Schnittstelle. Zielanwendungen waren Smartphones, Tablets und andere mobile Geräte in diesem Umfeld. Das besonders kompakte Design der Kameras und Konnektoren – eben angepasst an die Zielanwendungen – war aber von Anfang an interessant für alle Arten von Embedded Vision, auch in der Industrie. Unser Ziel waren ja schon immer kleinstmögliche Komponenten, die sich leicht integrieren lassen. Hinzu kommt der geringe Energiebedarf, ebenfalls angepasst an mobile, autarke oder batteriebetriebene Anwendungen. Dazu hat MIPI perfekt gepasst.

Waren die MIPI-Kameras damit auch eine Konkurrenz für VC?

Das Aufkommen von MIPI war eine spannende Entwicklung – bemerkenswert war vor allem, wie stark sich das Interface durchgesetzt hat. Heutzutage gehören über 300 Mitglieder zur MIPI-Alliance, darunter Prozessorhersteller wie AMD/Xilinx, NXP, Nvidia und Qualcomm. Die MIPI-Schnittstelle wird heute von fast allen gängigen Prozessorboards unterstützt; deren Entwicklung ist ja ebenfalls vom Consumer-Markt getrieben.

Während es viele der Prozessoren und CPU-Boards auch in industrietauglicher Qualität gibt, fehlten aber entsprechende Kameras mit der notwendigen Langlebigkeit, Qualität und Langzeitverfügbarkeit für industrielle und kommerzielle Serienanwendungen. Wir haben erkannt, dass es dafür einen Bedarf und großes Potenzial in der Industrie gibt. Das war die Geburtsstunde der VC-MIPI-Kameramodule, die wir seitdem in Deutschland entwickeln und fertigen, speziell für den Einsatz in professionellen Anwendungen.

Entwickelt sich Vision Components damit vom Embedded-Vision-Anbieter zum Kamerahersteller?

Nein, das trifft nicht zu. Embedded Vision heißt für uns, dass alle Komponenten exakt aufeinander und auf ihre Zielanwendung abgestimmt sind, im kleinstmöglichen Format und ohne überschüssige Rechenleistung oder nicht notwendige Bauteile. Vor dem Siegeszug von MIPI haben wir das erreicht, indem wir Bildsensoren und Prozessorboard als Einheit entwickelt haben. So sind die VC-Platinenkameras entstanden, die auch heute noch in vielen Projekten erfolgreich zum Einsatz kommen. Gleichzeitig können unsere Kunden heute dank der breiten Unterstützung der MIPI-Schnittstelle solche exakt angepassten Embedded-Vision-Systeme einfach und mit viel größerer Flexibilität realisieren, indem sie ihr favorisiertes Prozessorboard mit einem VC-MIPI-Modul mit ihrem Wunschsensor verbinden.

MIPI ist dabei viel mehr als eine Schnittstelle: Es ist ein Ecosystem von der Bilderfassung über die Weitergabe und Verarbeitung der Daten bis hin zur Endapplikation der Kunden. Dabei entwickelt und fertigt VC Kameramodule, Anschlusskabel für die verschiedenen CPU-Boards und mit Triggereingang und Blitzausgang, Zubehör wie Objektivhalter, LED-Beleuchtung und Adapterboards sowie Bausteine wie unseren FPGA-Beschleuniger VC Power SoM, der sich in das Design eines Prozessorboards integrieren lässt und dort die komplexe Vorverarbeitung von Bilddaten übernimmt. Hinzu kommen ja auch noch Treiber für unsere Kameramodule. Und gerade haben wir entschieden, dass ab sofort alle Kunden kostenlosen Zugang zur »VC Lib« bekommen, unserer umfassenden Bibliothek für die Bildverarbeitung in Embedded-Systemen auf ARM-Basis. Damit unterstützen wir Kunden bei allen Prozessschritten vom Kameramodul bis zur Endapplikation. Auch in Zukunft werden wir also kein reiner Kameraanbieter sein.

Was genau enthält die VC Lib, und was können Anwender damit machen?

Die VC Lib umfasst eine Vielzahl von Grundfunktionen für gängige Bildverarbeitungsaufgaben sowie komplexere Funktionalitäten wie Mustererkennung oder das Lesen von 2D- und 1D-Barcodes. Diese sind über die Jahre optimiert worden für Prozessorplattformen auf ARM-Basis. Entwickler können damit schnell eigene Applikationen erstellen oder die Funktionalität in ihre eigenen Anwendungen integrieren. Bisher haben wir die VC Lib mit unseren Platinenkameras der Z-Familie ausgeliefert, jetzt aber entschieden, sie allen VC-Kunden zur Verfügung zu stellen. Das ist ein weiterer Baustein, um Embedded-Vision-Integrationen schneller, einfacher und kostengünstiger umsetzen zu können.

Plant VC, noch weitere Softwareprodukte anzubieten?

Hardware und Software gehören für uns eng zusammen – nur so ist eine exakte Integration erreichbar. Gleichzeitig ist das Know-how unserer Kunden meist die Entwicklung der Endapplikation oder Gesamtlösung. Unser Ziel ist es, dafür das nötige Fundament bereitzustellen. Wenn wir nochmals auf unseren FPGA-Beschleuniger VC Power SoM zurückkommen: der empfängt ja Daten von einem oder mehreren Kameramodulen und ermöglicht die parallelisierte Verarbeitung der Daten. Hierbei ist ein FPGA extrem leistungsfähig – und für diese Prozesse muss keine Rechenleistung in der Haupt-CPU der Anwendung vorgesehen werden. Wenn Kunden den Baustein in ihr Design integrieren, wollen wir ihnen für die Vorverarbeitung ebenfalls entsprechende IP-Cores anbieten, sodass typische Anwendungen wie Farbkorrekturen, Sensorfusion oder das Auffinden von Regions-of-Interest vorbereitet sind. Entsprechende Demoapplikationen gibt es dafür bereits. Wir planen aber auch die Umsetzung kompletter, einsatzfertiger FPGA-Designs. Die Software hat aber auch künftig immer einen engen Bezug zu unserer Hardware.

MIPI-Kameras von VC gibt es nun seit fünf Jahren. Was ist hier das Ziel? Gibt es die Kameramodule mit allen gängigen Bildsensoren?

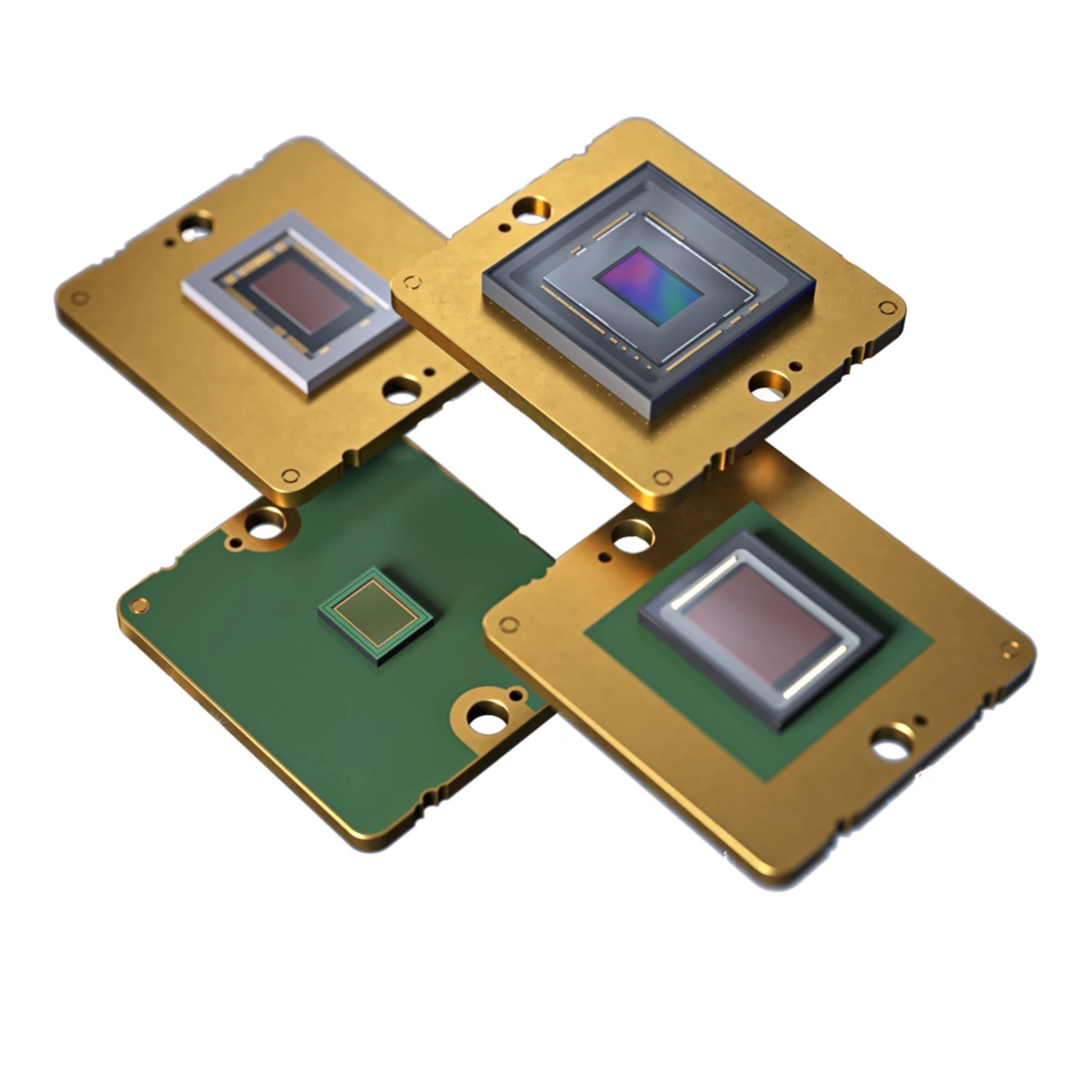

Generell ist unser Ziel, für Industrie- und Serienprodukte relevante Bildsensoren zu identifizieren und als MIPI-Kameras umzusetzen. Das sind häufig Sensoren aus den Pregius- und Starvis-Serien von Sony, weil sie unsere Ansprüche an Langzeitverfügbarkeit und industrietaugliche Qualität erfüllen. Daneben setzen wir auch Integrationswünsche unserer Partner und Kunden um. Schon heute haben wir damit das breiteste Sortiment von MIPI-Kameras für industrielle Anwendungen – mit 0,3 MPixel bis über 20 MPixel Auflösung, mit Global Shutter, Rolling Shutter und Global Reset Shutter und auch für Spezialanwendungen wie Medizintechnik oder Raumfahrt.

Generell integrieren wir alle Bildsensoren in entsprechende Module, wenn es Kundenprojekte gibt. Es lohnt sich also immer, anzufragen, ob wir einen bestimmten Bildsensor auf der Roadmap haben oder aufnehmen wollen. Das gilt übrigens auch für Sensoren, die von sich aus kein MIPI-Interface unterstützen. Dafür haben wir eigens eine Adapterplatine entwickelt, die zusammen mit der Sensorplatine das MIPI-Modul bildet. Das ist über den verwendeten Board-to-Board-Stecker extrem robust und ändert nichts am kompakten Design der Module.

Wie sieht die MIPI-Roadmap von VC denn aktuell aus – was wird es Neues geben?

Wir werden auch künftig immer wieder neue Bildsensoren in unsere MIPI-Kameras integrieren. Neben klassischen Sensoren planen wir auch die Entwicklung von MIPI-Kameramodulen für spezielle Anwendungen, etwa mit SWIR, 3D/Time-of-Flight oder mit Event-based Vision-Sensoren, die Helligkeitsunterschiede schnell erkennen und so die Erfassung und Analyse von Bewegungen in hoher Geschwindigkeit und Präzision ermitteln. Daneben gibt es noch einige Sonderprojekte, die eine Vielzahl von Bildsensoren auf einem Modul kombinieren, über die zu sprechen aber noch zu früh ist.

Sprechen wir zum Abschluss noch über künstliche Intelligenz. Die Technologie ist ja aktuell omnipräsent – wie ist das bei Vision Components?

Unsere Embedded-Vision-Systeme entwickeln wir aktuell noch selbst (lacht). Aber es stimmt schon: eine Vielzahl von Anwendungen aus der Bildverarbeitung können mit entsprechendem Training heute von KI übernommen werden, komplett unabhängig oder in Verbindung mit klassischen Algorithmen. Das schafft großes Potential und wird zahlreiche smarte Geräte und Anwendungen hervorbringen, die unser Leben hoffentlich in vielen Bereichen einfacher und besser machen. Eine Vielzahl dieser KI-Anwendungen beruhen auf Bilddaten – entsprechend werden auch künftig möglichst kleine, leistungsstarke und energiesparsame Kameras und Embedded-Vision-Systeme benötigt. Eine Herausforderung ist es außerdem, die KI-Algorithmen so zu optimieren, dass sie auch in Embedded Devices mit wenig Rechenleistung performant laufen. Dabei kann VC Unternehmen ebenfalls unterstützen. Kurzum: KI kann kommen. Wir schauen mit Freude in die Zukunft.