Neue SerDes-Baustein-Generationen

Sensordaten optimal verarbeiten

Die wachsende Zahl der Kameras, Radar- und Lidar-Baugruppen sorgt für viele spezielle Herausforderungen, was das Bündeln und Synchronisieren der Daten angeht. Mit neuen Konzepten lassen sich bei Fahrerassistenzsystemen Management und Timing von Video- und anderen Sensordaten in den Griff bekommen.

Noch vor wenigen Jahren waren die meisten Autos höchstens mit einer einzigen Kamera ausgestattet – zum Beispiel mit einer Rückfahr- oder Frontkamera. Heutzutage enthalten moderne Kraftfahrzeuge bis zu ein Dutzend Kameras, so zum Beispiel für Rundumsicht-Systeme (Surround View) oder zur Fahrerüberwachung. Schon bald dürften Kameras außerdem die gewohnten Rückspiegel ersetzen. Das Zusammenführen all dieser Sensordaten (Sensor-Datenfusion) ist eine Kunst für sich.

Die Zukunft der Sensor-Datenfusion

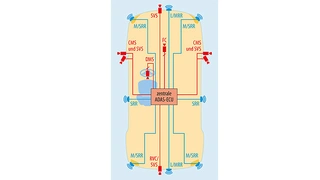

Das Auto der nahen Zukunft wird eine Vielzahl von Sensoren für Fahrerassistenzsysteme und schließlich auch für autonome Fahrsysteme enthalten. Bild 1 zeigt exemplarisch die Integration mehrerer Kameras und Radarsensoren. Hinzu kommen häufig Sensoren beispielsweise für Lidar und Ultraschall.

Synchronizität der Sensoren Bild 1 bis 3

In vielen Fällen wird die Verarbeitung all dieser Sensordaten auf mehrere separate elektronische Steuergeräte (Electronic Control Units, ECUs) für Frontkamera, Surround View und Radar aufgeteilt. Im Zuge des Überganges von Fahrerassistenz-Applikationen zum intelligenteren autonomen Fahren bringt jedoch die Zusammenführung der Sensorinformationen – und damit deren zentralisierte Verarbeitung – immer mehr Vorteile.

Synchronizität der Sensoren

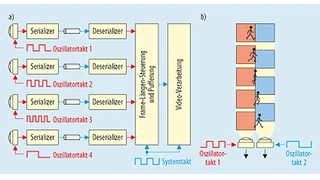

Eine wichtige Herausforderung bei der Datenfusion besteht in der Synchronisation und Bündelung der Daten von mehreren Sensoren. In einem typischen Surround-View-System etwa (Bild 2) enthält jeder einzelne Kamerasensor seinen eigenen, zur Taktung dienenden Oszillator. Da die vielen separaten Oszillatoren nicht alle mit exakt derselben Frequenz arbeiten, kommt es dazu, dass die entsprechenden Video-Streams mit der Zeit auseinanderlaufen. Um sie wieder aufeinander auszurichten, muss der Prozessor in der ECU das Timing der ankommenden Videosignale überwachen und die schnelleren Kameras verlangsamen. Dies aber nimmt Ressourcen des Prozessors in Anspruch und kann allenfalls eine provisorische Lösung für das grundlegende Problem der Synchronisation sein.

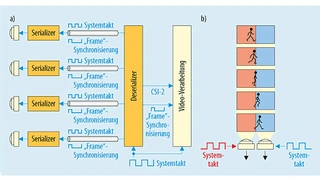

Ein neues Konzept ist in Bild 3 zu sehen. Hier überträgt ein zentraler Deserializer über den Rückkanal des Serializer einen einheitlichen Referenztakt an alle Kameras, sodass der absolut synchrone Betrieb aller Kamerasensoren gewährleistet ist. Diese deutlich elegantere Technik stellt durch den Betrieb aller Sensoren mit einem gemeinsamen Takt prinzipbedingt die Synchronisation aller Sensoren sicher, ohne dass hierfür zusätzliche Ressourcen benötigt werden. Der Deserializer gibt dann die gebündelten Sensordaten auf der Basis dieses gemeinsamen Takts aus, was die Videoverarbeitung vereinfacht.

Sind die Bildaufnehmer erst einmal zu dem zentralen, hochfrequenten ECU-Takt synchronisiert, wird ein niederfrequenteres Frame-Sync-Signal, das häufig abgekürzt als FSIN, TRIGGER oder XMASTER bezeichnet wird, zum gleichzeitigen Auslösen von Aufnahmen in den abgesetzten Kameras genutzt. Traditionell wird das Frame-Sync-Signal über einen GPIO-Pin (General Purpose Input-Output) und den Rückkanal des SerDes-Paars (Serializer/Deserializer) bereitgestellt. SerDes-Lösungen von Texas Instruments besitzen beispielsweise einen Rückkanal mit sehr geringer Latenz, der sich sehr gut für diesen Zweck eignet.

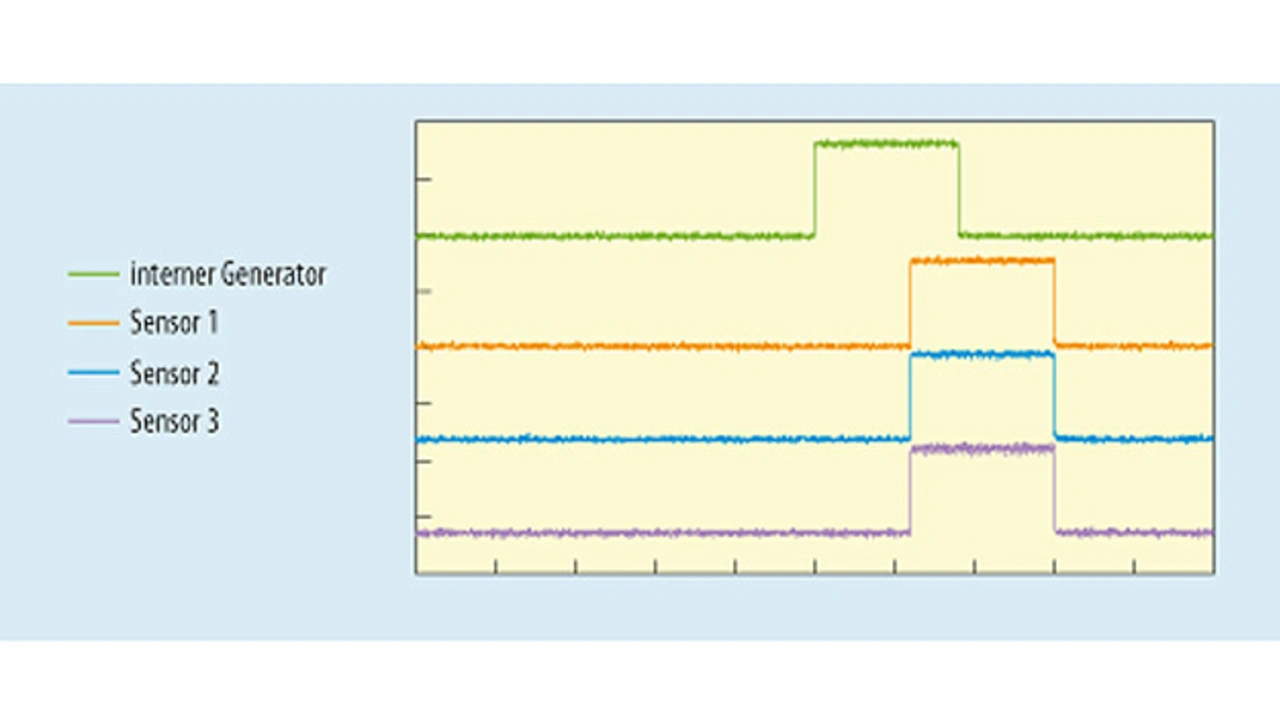

Trotz der geringen Latenz, die sich mit dieser GPIO-Technik erreichen lässt, kommt es wegen der unabhängigen SerDes-Verbindungen nach wie vor zu einem gewissen Versatz zwischen den Frame-Sync-Signalen der einzelnen Kameras. Um diesen Versatz weiter zu reduzieren, kombiniert ein weiteres neues Konzept einen integrierten, präzisen Frame-Sync-Impulsgenerator mit dem zentralisierten Taktungsschema aus Bild 3. So werden die zeitlichen Schwankungen zwischen den Frame-Sync-Signalen verringert. Nach diesem Konzept werden die Takt- und FSIN-Impulse über synchronisierte SerDes-Rückkanäle von einer einzigen Quelle bereitgestellt, was für einen extrem geringen Versatz der Frame-Sync-Signale zwischen den einzelnen Sensoren sorgt (Bild 4). Mit dieser Kombination aus zentraler Taktung und Frame-Sync-Generierung werden der ECU simultan abgetastete Video- oder andere Sensordaten zur Verfügung gestellt, ohne dass es mit der Zeit zu einer Drift (wie in Bild 2b und 3b) kommt. Dieses Verfahren steigert dadurch die Leistungsfähigkeit der Sensorfusion und macht gleichzeitig das Systemdesign einfacher.

- Sensordaten optimal verarbeiten

- Identifikation der Daten

- Design der nächsten Kamerageneration