IMEC und Globalfoundries

Äußerst genügsamer analoger KI-Chip

Um aufwendige Datentransfers im Rahmen des »Internets der Dinge« in die »Cloud« zu vermeiden, versucht man künstliche Intelligenz möglichst im »IoT-Edge« zu implementieren. Der analoge KI-Chip »AnIA« mit einer Rechenleistung von 2.900 TOPS/W rückt dieses Ziel in greifbare Nähe.

Das flämische Forschungsinstitut Imec in Leuven und der Halbleiterfertigungsdienstleister Globalfoundries (GF) mit Sitz in Santa Clara, Kalifornien, haben gemeinsam einen Durchbruch bei KI-Chips erzielt, der tiefe neuronale Netze (Deep Neural Networks) in IoT-Edge-Geräten realisierbar macht.

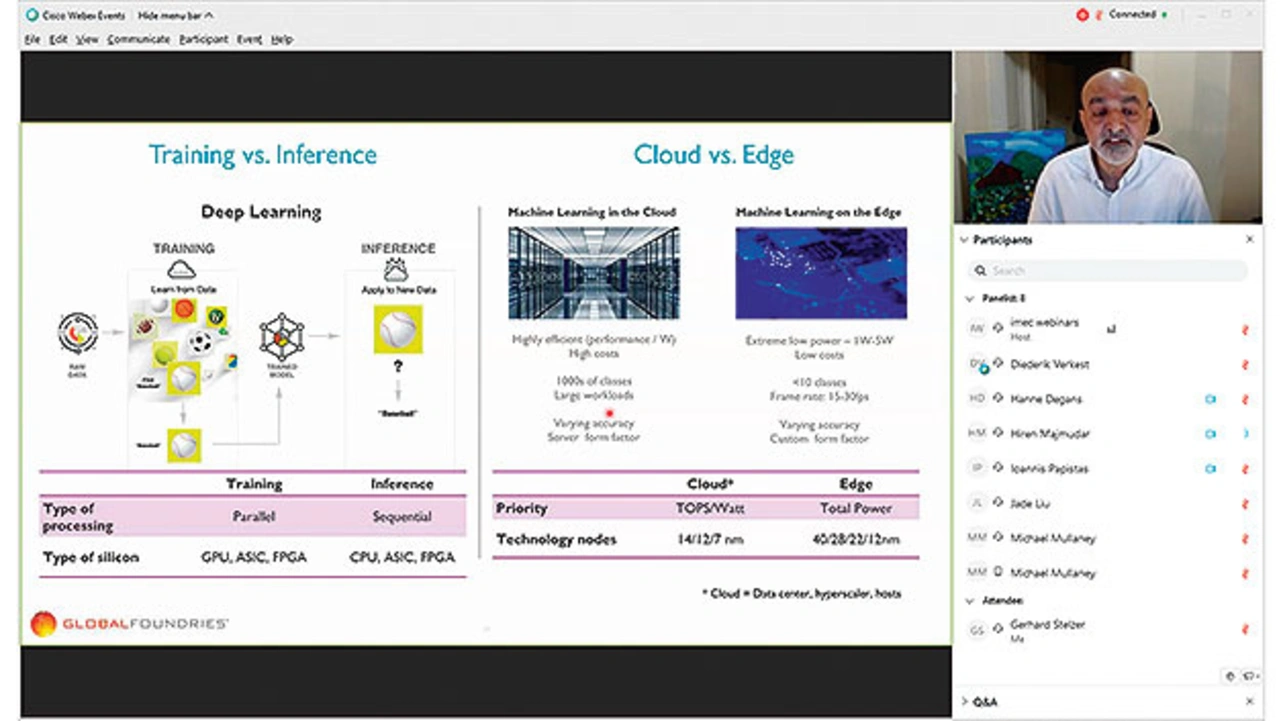

Beide Partner haben dazu einen Hardwaredemonstrator-Chip mit künstlicher Intelligenz vorgestellt. Der neue Chip basiert auf der »Analog in Memory Computing Architektur« (AiMC) von Imec und nutzt den Halbleiterfertigungsprozess 22FDX von GF. Der neue Chip ist optimiert, um tiefe neuronale Netze auf In-Memory-Computing-Hardware im analogen Bereich abzubilden. Mit einer rekordverdächtig hohen Energieeffizienz von bis zu 2.900 TOPS/W (Tera-Operationen pro Sekunde/Watt) ist der KI-Beschleuniger eine wichtige Voraussetzung für Inferenz-Berechnungen in Edge-Geräten, die auf eine geringe Leistungsaufnahme angewiesen sind. Die Vorteile dieser neuen Technologie in Bezug auf Datenschutz, Sicherheit und Latenzzeit werden sich auf KI-Anwendungen in einer breiten Palette von Endgeräten auswirken, von intelligenten Lautsprechern bis hin zu selbstfahrenden Fahrzeugen.

Seit den frühen Tagen des digitalen Computerzeitalters ist der Prozessor vom Speicher getrennt. Operationen, die mit einer großen Datenmenge durchgeführt werden, erfordern eine ähnlich große Anzahl von Datenelementen, die aus dem Speicher abgerufen werden müssen. Diese als Von-Neumann-Engpass bezeichnete Einschränkung kann die tatsächliche Rechenzeit in die Länge ziehen, insbesondere in neuronalen Netzen, die von großen Vektor-Matrix-Multiplikationen abhängen. Diese Berechnungen werden mit der Genauigkeit eines digital arbeitenden Rechners durchgeführt und erfordern eine beträchtliche Menge an Energie. Neuronale Netze können jedoch auch vergleichbar genaue Ergebnisse erzielen, wenn die Vektor-Matrix-Multiplikationen mit analoger Technik und einer geringeren Präzision berechnet werden.

Jobangebote+ passend zum Thema

Analoge KI-Berechnung mit 2900 TOPS/W

Während die für KI-Aufgaben typischen großen Vektor-Matrix-Multiplikationen in der digitalen Domäne Bit für Bit berechnet werden, funktioniert das in der analogen Domäne nach den Kirchhoffschen Regeln und es finden automatische Stromsummierungen unter Berücksichtigung der gespeicherten Gewichte statt, erläutert Maciej Wiatr, Prozessexperte bei GF das Funktionsprinzip.

Um sich dieser Herausforderung zu stellen, haben Imec und seine Industriepartner, darunter GF, in Imec‘s Industrial Affiliation Machine Learning Program eine neue Architektur entwickelt, die den Von-Neumann-Engpass eliminiert, indem analoge Berechnungen in SRAM-Zellen durchgeführt werden. Der daraus resultierende »Analog Inference Accelerator« (AnIA), der auf der Halbleiterplattform 22FDX von GF aufbaut, zeichnet sich durch eine außergewöhnliche Energieeffizienz aus. Charakterisierungstests zeigen einen Wirkungsgrad, dessen Spitzenwert bei 2.900 Tera-Operationen pro Sekunde pro Watt (TOPS/W) liegt. So lassen sich Mustererkennungsanwendungen in winzigen Sensoren und Low-Power- Edge-Bausteinen implementieren, die typischerweise bislang per maschinellem Lernen (ML) in Rechenzentren stattfinden. Diese Aufgaben kann nun lokal ein energieeffizienter Beschleuniger erledigen. Allerdings handelt es sich bei dieser analogen Implementierung nicht um ein »Spiking Neural Network«, bei dem künstliche Neuronen Pulse feuern.

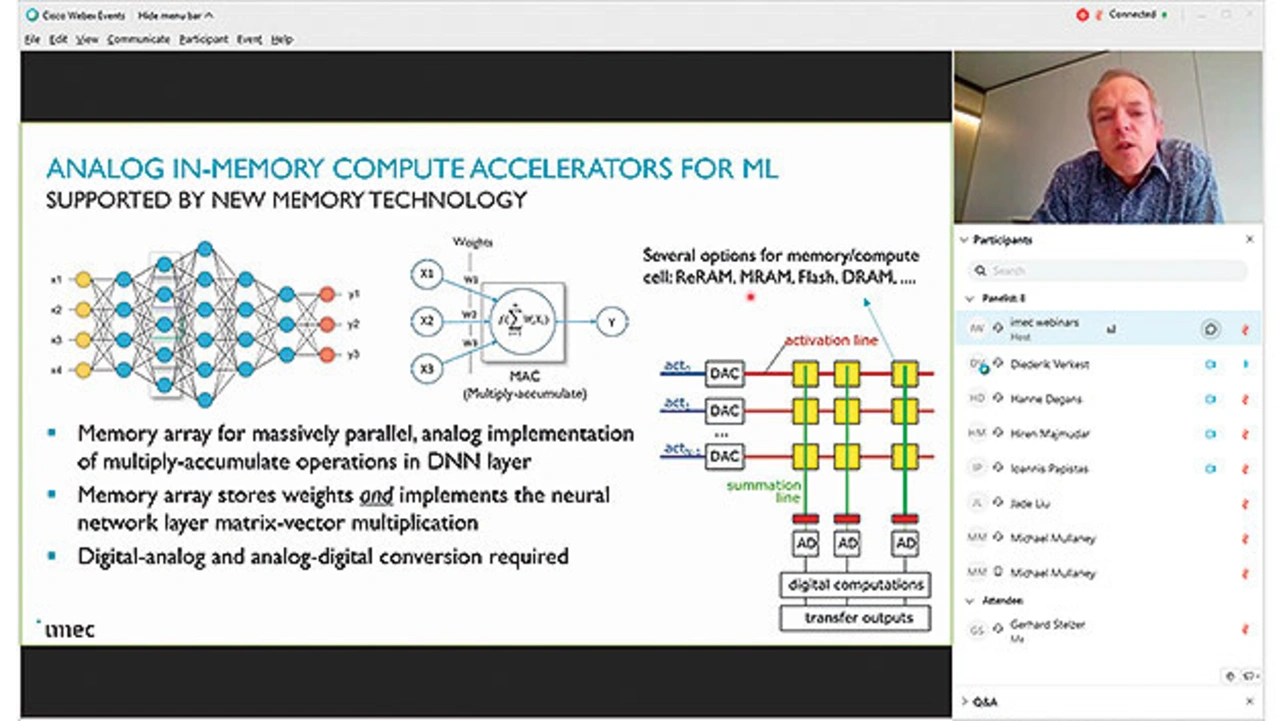

Analog-In-Memory-Beschleuniger für ML bestehen aus einem Speicher-Array für die massiv parallele analoge Implementierung von MAC-Operationen in den einzelnen DNN-Schichten. Neben den im Testchip verwendeten SRAM-Zellen könnten auch Resistive RAM (ReRAM), Magnetische RAM (MRAM), Flash-Speicherzellen oder DRAM zum Einsatz kommen. Das Speicher-Array enthält die Gewichte und implementiert die Vektor-Matix-Multiplikation der jeweiligen NN-Schicht. Da die Daten vor und nach der Verarbeitung in digitaler Form vorliegen, sind AD- und DA-Umsetzer erforderlich. Der realisierte Testchip verfügt im Kern über 512 K Rechenzellen, 1024 DA-Umsetzer und 512 AD-Umsetzer. Einschließlich der digitalen Infrastruktur misst der in einem 22-nm-FD-SOI-Prozess realisierte Chip insgesamt 4 mm2.

Energieeffizienz um den Faktor 10 bis 100 besser

»Das erfolgreiche Tape-out von AnIA markiert einen wichtigen Schritt in Richtung Validierung von Analog in Memory Computing (AiMC)«, erläutert Diederik Verkest, Programmdirektor für maschinelles Lernen bei Imec (Bild 1). »Die Referenzimplementierung zeigt nicht nur, dass analoge In-Memory-Berechnungen in der Praxis möglich sind, sondern auch, dass sie eine zehn- bis hundertmal bessere Energieeffizienz erreichen als digitale Beschleuniger. In Imecs Programm für maschinelles Lernen stimmen wir bestehende und neu entstehende Speichertypen ab, um sie für analoge In-Memory-Berechnungen zu optimieren. Diese vielversprechenden Ergebnisse ermutigen uns, diese Technologie weiter zu entwickeln, mit dem Ziel, auf 10.000 TOPS/W hinzuarbeiten«.

»GlobalFoundries hat bei der Implementierung des neuen AnIA-Chips eng mit Imec zusammengearbeitet und dabei unsere energiesparende und leistungsstarke 22FDX-Plattform verwendet«, erklärt Hiren Majmudar, Vice President of Product Management for Computing and Wired Infrastructure bei GF. »Dieser Testchip ist ein entscheidender Schritt vorwärts, um der Industrie zu demonstrieren, wie 22FDX die Leistungsaufnahme energieintensiver KI- und Machine-Learning-Anwendungen deutlich senken kann.«

Mit Blick in die Zukunft wird GF AiMC als eine Funktion aufnehmen, die im Rahmen der 22FDX-Plattform implementiert werden kann. Der Halbleiterprozess 22FDX von GF nutzt 22-nm FD-SOI (Fully Depleted Silicon-on-Insulator), um eine herausragende Rechenleistung bei extrem niedriger Leistungsaufnahme zu erzielen. Der 22FDX kann mit 0,5 V (ULP, Ultra Low Power) und mit 1 pA (Pikoampere pro Micron) betrieben werden, um einen extrem niedrigen Stand-by-Leckstrom zu erzielen. Der 22FDX-Prozess mit der neuen AiMC-Funktion befindet sich derzeit in der Entwicklung (Bild 2) für die 300-mm-Produktionslinie von GF in der Fabrik 1 in Dresden. Majmudar erwartet, dass es bis spätestens 2022 kommerzielle Produkte auf AiMC-Basis geben wird.