Tools für Embedded-Systeme

KI-Anwendungen erfolgreich entwickeln

KI in einem Produkt für den Massenmarkt zu implementieren ist nicht immer leicht. Oft scheitern Entwickler bereits an der Auswahl der richten Tools. Eine Hilfe, welche Tools für welche Anwendung optimal sind, gibt der Beitrag von Future Electronics.

Der Begriff »künstliche Intelligenz« (KI) bezeichnet die Anwendung von Rechentechniken mit dem Ziel, einer Maschine das Ausführen einer Aufgabe beizubringen. Aus Sicht einer Maschine ist die Aufgabe so komplex, dass es nicht realistisch wäre, sie mit konventionellen logischen Befehlen zu programmieren. Aufgaben, für die sich der KI-Einsatz anbietet, können in einigen Fällen ebenso Menschen ausführen. Zum Beispiel das Detektieren und Erkennen von Objekten oder das Erkennen gesprochener Schlüsselwörter. Andere KI-Anwendungen dagegen übersteigen die menschlichen Fähigkeiten – sei es das Erstellen langfristiger Wettervorhersagen oder das frühzeitige Erkennen für einen bevorstehenden Ausfall einer Maschine oder eines Motors.

Machine Learning als Basis

Beide Kategorien von KI-Funktionen besitzen ein enormes Potenzial für Embedded-Systeme. Zwei Ziele sind hierbei denkbar.

- Der Ersatz menschlicher Tätigkeiten durch Maschinen. Sei es, um die Effizienz und den Durchsatz zu steigern, um Menschen weniger Sicherheitsrisiken auszusetzen oder um menschliche Fehler beim Ausführen sich ständig wiederholender, eintöniger Aufgaben auszuschließen.

- Einführen neuer Fähigkeiten wie Predictive Maintenance von Maschinen: Das führt zu weniger ungeplanten Stillstandszeiten, höherer Zuverlässigkeit und geringeren Kosten für die Reparatur oder den Austausch ausgefallener Maschinen.

Jobangebote+ passend zum Thema

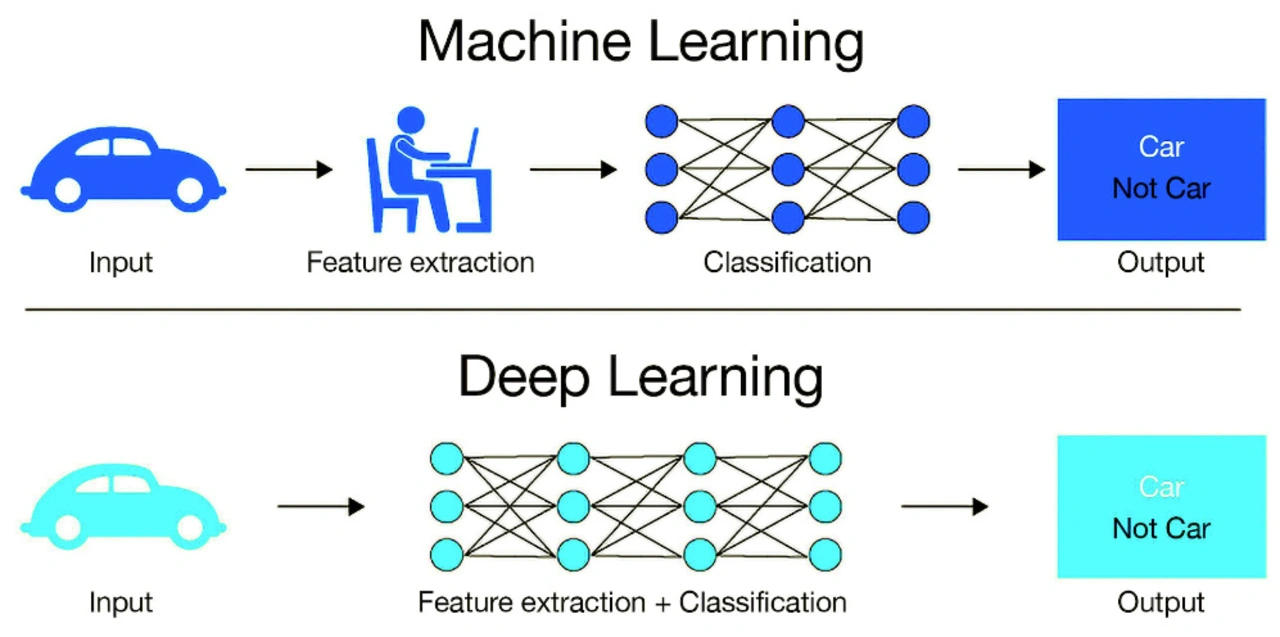

Machen Entwickler von Embedded-Systemen heute von KI Gebrauch, tun sie es meist mit einem Teilgebiet der KI, dem sogenannten Machine Learning – maschinellem Lernen (ML). Hierbei identifiziert eine Maschine statistisch signifikante Muster in großen Datenmengen. Ein neuronales Netz oder ein Algorithmus anderer Art verarbeitet die zum Einlernen bereitgestellten Datensätze, um die Muster zu identifizieren. Als Resultat dieser Einlern- beziehungsweise Trainingsphase kann das Modell mit hinreichender Genauigkeit Vorhersagen machen (Bild 1). Kompiliert wird das fertig trainierte Modell für die Ziel-Hardware – zum Beispiel ein FPGA –, die anschließend als Inference Engine dient. Beim sogenannten Deep Learning handelt es sich um eine weiterentwickelte Form des Machine Learnings. Hierbei werden nützliche Merkmale der Beispieldaten automatisch extrahiert, um hochgenaue Vorhersagen zu ermöglichen. Hier müssen also die Systementwickler nicht den zum Einlernen verwendeten Datensatz mit relevanten Informationen versehen.

Entwickler sondieren derzeit aktiv das Potenzial zum Umsetzen von Machine Learning. Hardware-Plattformen wie FPGAs, Mikrocontroller oder Prozessoren haben in den letzten Jahren ein hohes Maß an Verarbeitungsleistung erreicht. Inzwischen ist die Technik sowohl verfügbar als auch erschwinglich. Als Reaktion hierauf haben die Hersteller der Hardware intensiv am Entwickeln von Tools, Referenzdesigns und anderen Plattformen gearbeitet. Sie sollen Anwender dabei unterstützen, Herausforderungen beim Implementieren von Machine-Learning-Systemen zu überwinden.

Trotz des großen Interesses an ML ist die Zahl der Produkte noch recht überschaubar. Nach Erfahrungen von Future Electronics liegt das hauptsächlich an folgendem Punkt: Einerseits liefern die Experimente, die OEMs mit ML unternehmen, wertvolle Lernergebnisse für die beteiligten Entwicklerteams. Sie sind jedoch nicht in der Lage, Systeme mit einem hinreichenden Maß an Funktion, Nutzen und Leistung für den Anwender in einem marktfähigen Produkt umzusetzen. Will ein OEM nicht bloß herumexperimentieren, sondern ein KI-gestütztes Produkt entwickeln, das auf dem Markt eine Chance hat, stellt sich die Frage: Welche Vorgehensweise ist die richtige?

Alle Wege führen zu Edge Computing

Die erste entscheidende Restriktion, die es zu berücksichtigen gilt, ist die begrenzte Rechenleistung einer Machine-Learning-Inferenz. Ein trainiertes neuronales Netzwerk läuft in der Praxis entweder in der Cloud oder am Edge. Bei Embedded-Systemen stehen vor allem die Forderungen nach geringer Latenz, niedriger Leistungsaufnahme, geringen Systemkosten und garantierter Funktionsfähigkeit – unabhängig von der verfügbaren Netzwerkbandbreite – im Fokus. Aufgrund der Requirements muss die Inferenzmaschine lokal und nicht in der Cloud angesiedelt sein.

Nach den Erkenntnissen von Future Electronics eignen sich einige Anwendungen besonders gut für ML auf heute verfügbaren Edge-Computing-Plattformen. Für andere trifft das nicht zu. Hierfür gibt es zahlreiche Gründe. Zum einen sind umfangreiche Trainings-Datensätze lediglich für bestimmte Anwendungen verfügbar, zum anderen eignen sich die standardmäßigen ML-Algorithmen lediglich für bestimmte Anwendungen. Die besten Chancen zum Entwickeln eines marktfähigen ML-Produkts haben die auf dem Embedded-Sektor tätigen OEMs. Hierfür sollten sie eine der folgenden Arten von Anwendungen implementieren:

- Zugangskontrolle und Identifikation unter Verwenden von Gesichts-, Hand-, Stimmen-, Schlüsselwort- oder Gestenerkennung

- Vorausschauende Instandhaltung: beispielsweise durch Detektieren von Veränderungen an Vibrationsmustern, auch als zustandsbasierte Überwachung (Condition-based Monitoring, CbM) bezeichnet. Sie eignet sich für verschiedene Maschinen, von Industriemotoren über weiße Ware bis hin zu Flugzeugmotoren.

Varianten von Fahrerassistenzsystemen (Advanced Driver Assistance Systems, ADAS) nutzen ML außerdem für Funktionen wie das Detektieren und Wiedererkennen von Objekten. Konnten Anwender Produkte im Bereich der Zugangskontrolle und der vorausschauenden Instandhaltung Ende 2020 mit einem Universal-Mikrocontroller oder -FPGA implementien, verlangt die lokale Inferenzmaschine einer ADAS-Anwendung nach einer leistungsstärkeren Graphics Processing Unit (GPU) oder einem anderen Spezialprozessor. In Zukunft könnte jedoch eine neue Generation leistungsfähigerer FPGAs potenziell genügend Leistung für ADAS-Anwendungen mitbringen.

- KI-Anwendungen erfolgreich entwickeln

- Existierende Tools und Ressourcen nutzen