Machine Learning und Embedded Analytics

Sensorfusion auf Mikrocontroller

Maschinelles Lernen ist die Basis für zahlreiche automatisierte Anwendungen. Dabei müssen Echtzeit und der Schutz der IP in der Industrie gewährleistet werden. Edge- und Cloud-Analyse scheiden damit aus. Es geht aber auch mit einem ARM-Mikrocontroller, wenn man das System intelligent optimiert.

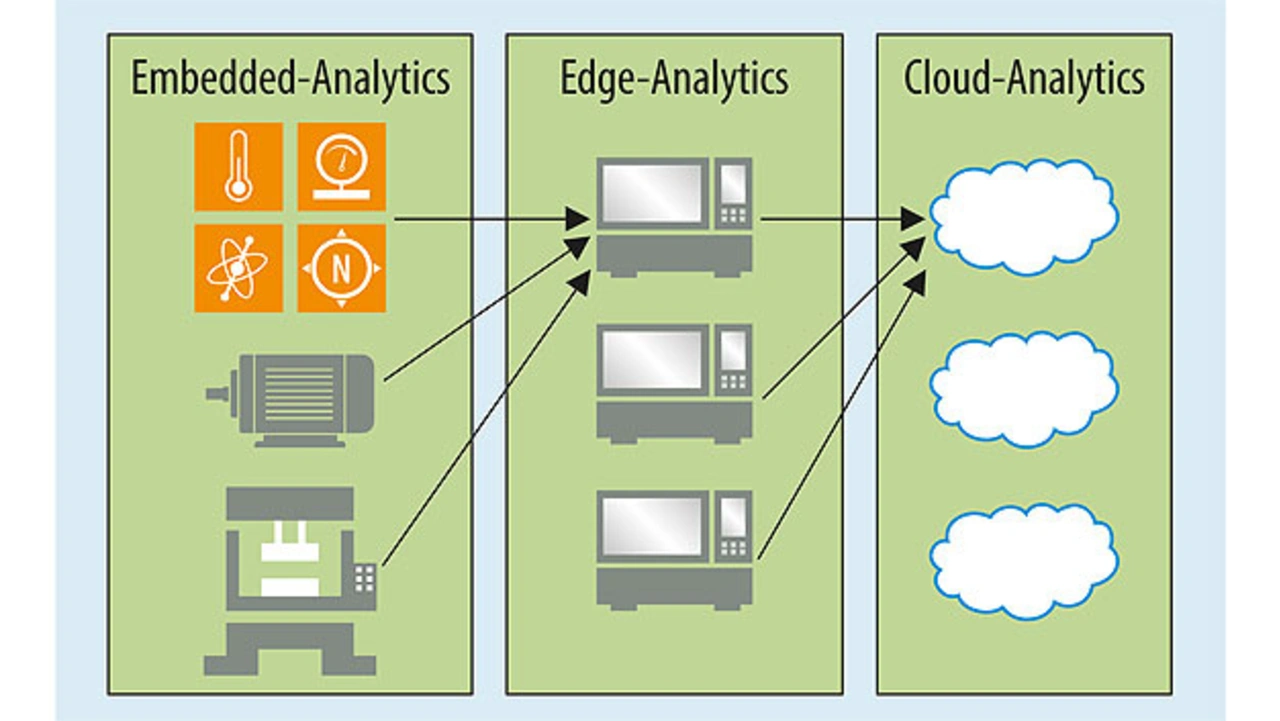

Große Datenmengen machen maschinelles Lernen erst möglich. Big Data und umfangreiche Algorithmen erfordern sehr leistungsfähige Systeme. Deshalb findet die Datenauswertung in der Regel bei einem Dienstleister (Cloud Analytics) oder auf einem dezentralen Industrie-PC (Edge Analytics) statt. Für viele Industrieanwendungen kommt beides jedoch nicht in Frage. Denn sowohl Cloud- als auch Edge-Analytics erfordern umfangreiche Maßnahmen, um den Schutz der unternehmenskritischen und vertraulichen Rohdaten sowie der genutzten Algorithmen zu gewährleisten. Zudem ist die Echtzeitfähigkeit oft nicht realisierbar.

Die Alternative ist ein eingebettetes Mikrocontroller-System (Bild 1). Es ermöglicht Echtzeitfähigkeit und gewährleistet auch die Datensicherheit, wenn für Hardware-Verschlüsselung gesorgt wird.

Jobangebote+ passend zum Thema

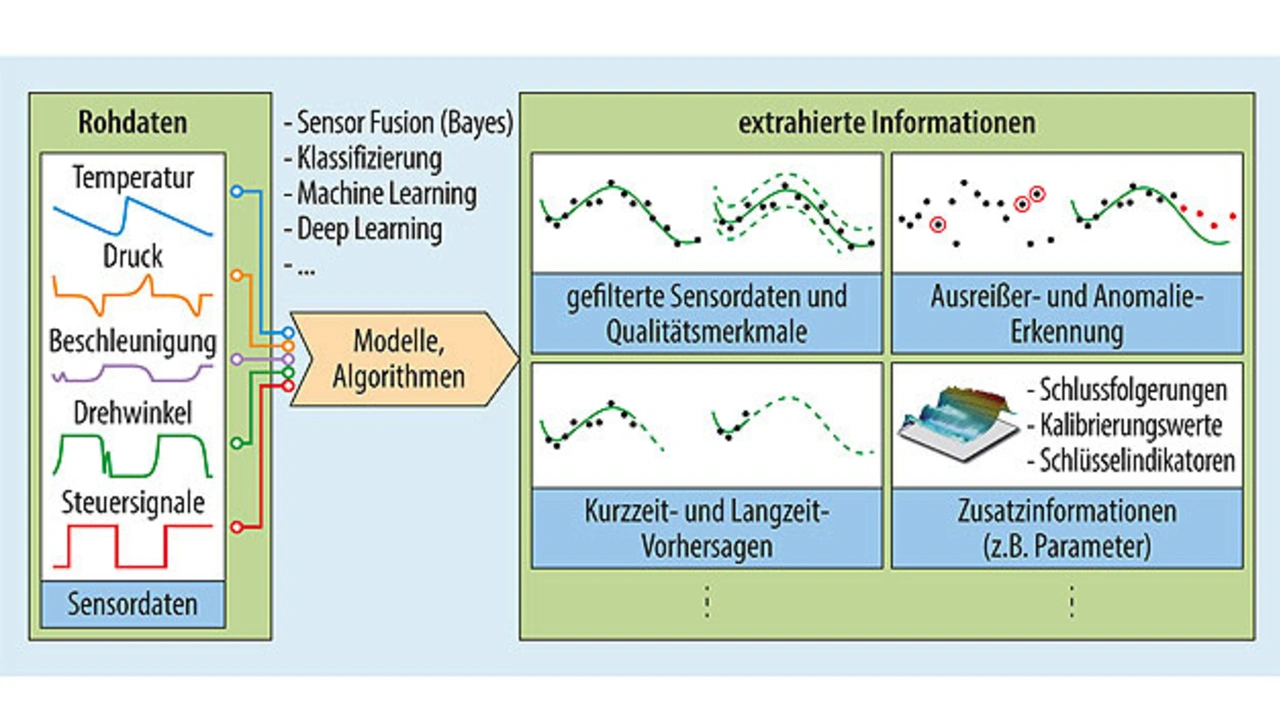

Damit ist eine Embedded-Analytics-Lösung vor allem bei sicherheitsrelevanten Systemen und überall dort, wo funktionale Sicherheit in Echtzeit gefordert ist, unumgänglich. Dies lässt sich sogar auf einem regulären ARM-Mikrocontroller umsetzen. Voraussetzung hierfür ist es, die Datenmenge zu reduzieren und schlanke Algorithmen in optimaler Kombination zu nutzen. Wie sich das umsetzen lässt, wird am Beispiel der Sensorfusion erklärt, wie sie etwa bei der vorausschauenden Wartung (Predictive Maintenance, Bild 2) vorkommt.

Von Big Data zu Smart Data in vier Schritten

Die Realisierung erfolgt in vier Schritten. Dabei muss jeder Schritt exakt auf das System abgestimmt werden. Zudem muss das grundsätzliche Problem der synchronen Datenverarbeitung bei der Sensorfusion berücksichtigt werden.

Der erste Schritt besteht in der Sen¬sor-Einsatzplanung, d. h., welche Sensortypen werden wo und in welcher Anzahl benötigt? Im zweiten Schritt folgt die Datenreduktion, um aus „Big Data“ „Smart Data“ zu extrahieren. Ziel ist es, dass so wenig Daten wie möglich übrig bleiben, aber so viele – und genau die richtigen – wie nötig. Als Leitlinie dient dabei die Frage: Welche Daten sind erforderlich, um Anomalien zu erkennen? Im dritten Schritt werden die Algorithmen für die Vorfilterung gewählt. Für Embedded Analytics müssen diese möglichst schlank aufgebaut sein. Damit empfehlen sich z. B. Matrizenberechnung, Vektoranalysen oder eine Fast-Fourier-Transformation (FFT). Im vierten Schritt werden die für die Analyse notwendigen Parameter extrahiert.

Bei der Sensorfusion ist zu berücksichtigen, was unter dem Akronym VUCA bekannt ist:

- Volatility (Volatilität) ist gegeben, da fortlaufend Änderungen innerhalb des Systems stattfinden, nicht nur hinsichtlich der Daten, sondern auch was die Dynamik, Geschwindigkeit und Grenzwerte angeht.

- Uncertainty (Unsicherheiten) entsteht z.B. durch Rauschen und unvorhersehbare Ereignisse.

- Complexity (Komplexität) ist vorhanden, weil kein simpler Ursache-Wirkung-Zusammenhang besteht.

- Ambiguity (Mehrdeutigkeit) zeichnet sich dadurch aus, dass dieselben Zustände aus verschiedenen Ursachen resultieren können

Um das System bestmöglich beschreiben zu können, müssen all diese »unkalkulierbaren« Informationen abgeschätzt werden. Hierzu dient eine Zustandsabschätzung. Dabei werden das physikalische System und die Zustände, die es in der Realität annehmen kann, beschrieben. Die entsprechenden Modelle lassen sich vorab im Labor definieren und dann im Look-Up-Table des Mikrocontrollers speichern.

Auf dieser Basis können die Sensordaten mit dem Modell verglichen und Ausreißer schnell als Anomalie erkannt werden. Das reduziert die Anzahl der notwendigen Messpunkte und den Speicherbedarf.

Beispielanwendung: Smarter Warmwasserspeicher

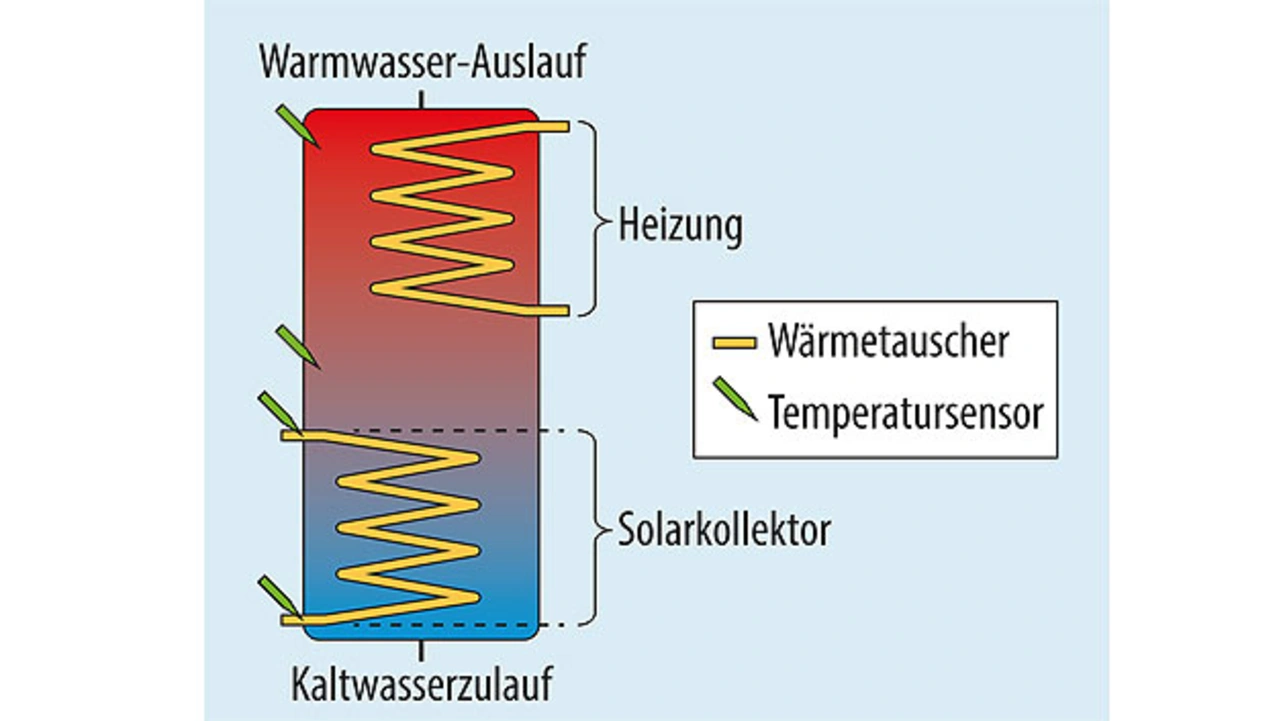

Am Beispiel eines intelligenten Warmwasserspeichers, der mit einer Photovoltaik-Anlage verbunden ist, wird das Vorgehen verdeutlicht (Bild 3). Wie beschrieben, besteht der erste Schritt in der Sensoreinsatzplanung. Hierbei wird festgelegt, wo wie viele Temperatur-, Druck- und Beschleunigungssensoren platziert werden.

Nun folgt die Zustandsabschätzung. Sie kann die Werte selbst betreffen, im Beispiel etwa die Temperatur am Sonnenkollektor. Sie kann sich in Mitteleuropa nur zwischen –20 °C und +50 °C bewegen. Alle Messwerte außerhalb dieser Spanne können als Messfehler betrachtet werden und brauchen nicht in die Auswertung einfließen. Auch das dynamische Verhalten über den Zeit- oder Frequenzbereich lässt sich mit Hilfe der Zustandsabschätzung einschränken. So kann sich z. B. die Wassertemperatur im Speicher rein physikalisch nicht innerhalb von einer Minute um 30 °C erhöhen oder senken, d. h., derartige Veränderungen können ebenfalls unberücksichtigt bleiben. Ebenso lässt sich die Detailtiefe eingrenzen. Bei dem Warmwasserspeicher hat ein Temperaturunterschied von einem Grad noch keinen entscheidenden Einfluss auf das System, d. h., die Daten müssen maximal bis auf ein Grad genau analysiert werden.

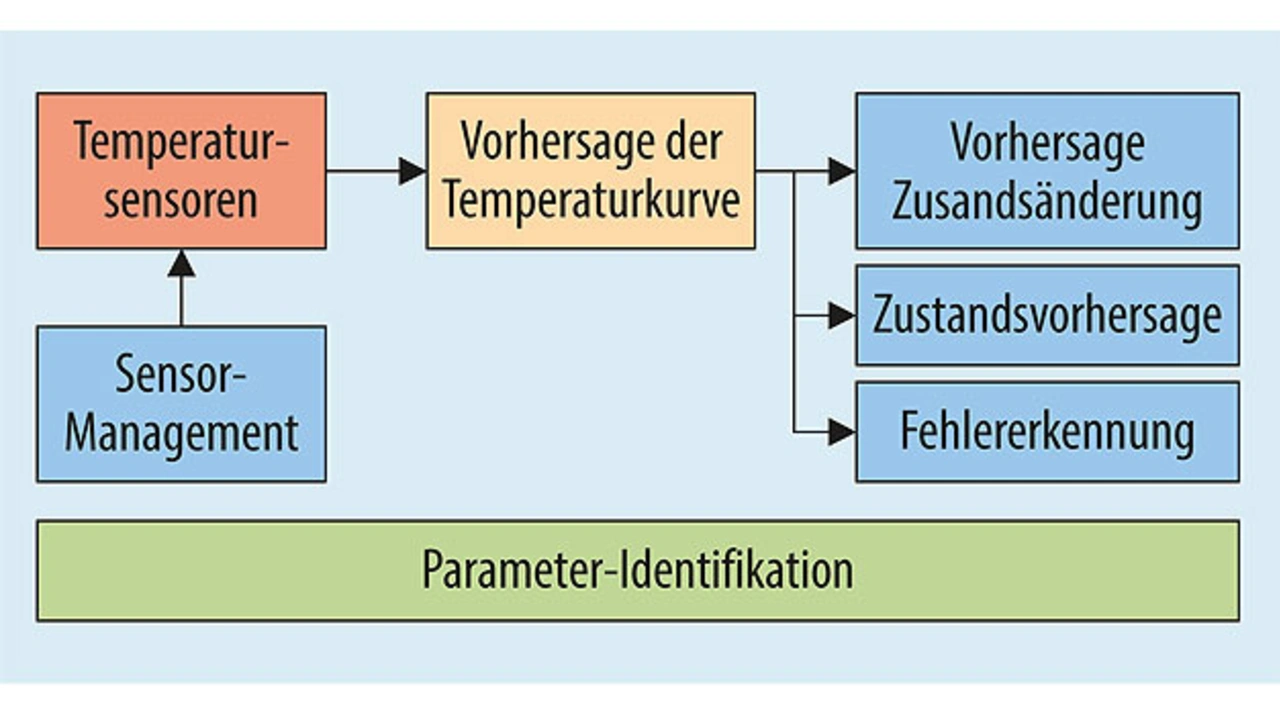

Nun gilt es, die relevanten Parameter zu identifizieren, die das System bei der spezifischen Aufgabenstellung beeinflussen (Bild 4). Eine solche Aufgabenstellung kann im Beispiel der Schutz vor Überhitzung sein. Hierfür sind die Temperaturen des Kalt- und Warmwasserzuflusses, des Wärmetauschers, des Brenners und der Sonnenkollektoren zu betrachten. Diese Daten müssen also aus der Sensorfusion gefiltert werden, etwa mit Hilfe eines Kalman-Filters. Alle anderen Messwerte sind für diese Analyse nicht nötig und können wegfallen. Um die Datenmenge noch weiter zu reduzieren, kann man auf weitere Filter zurückgreifen, z. B. Bayessche Filter zur Wahrscheinlichkeitsabschätzung.

- Sensorfusion auf Mikrocontroller

- Anomalien erkennen und beschreiben