Kamera, Bildverarbeitung und KI

Mission Embedded Vision

Embedded-Vision-Systeme vereinen Kamera, Bildverarbeitung und mehr in einem System. Wichtig sind Fertigung, Serienpreis, Langzeitverfügbarkeit sowie die Möglichkeit zum Update im Feld. Anforderungen, die sich mit dem Prozessor i.MX 8M Plus lösen lassen.

Embedded Vision hat in den vergangenen Jahren ein beinahe explosionsartiges Wachstum erfahren und dieser Trend wird sich den Marktprognosen zufolge weiter fortsetzen.

Früher war von Bildverarbeitung die Rede – dieser Begriff tritt zugunsten von »Embedded Vision« mehr und mehr in den Hintergrund. Kennzeichnend ist, dass es sich um eingebettete Systeme handelt, die einen hohen Integrationsgrad aufweisen und hardwareseitig bis auf Bauteilebene präzise an die Zielapplikation angepasst werden. Bei der »klassischen« industriellen Machine Vision greift der Entwickler typischerweise zu fertig verfügbaren Komponenten wie Gehäusekameras und Industrie-PCs, die er geeignet kombiniert. (Kosten-)optimierungen auf Komponentenebene spielen eine eher untergeordnete Rolle. Bei Embedded-Systemen mit entsprechend höheren Stückzahlen ist dies jedoch ein wichtiges Designziel.

Der Einsatz von Board-Level-Komponenten beim Embedded-Design führt einerseits zu mehr Flexibilität, erfordert auf der anderen Seite aber eine eingehendere Beschäftigung mit Fragen, die eher auf der Low-Level-Ebene der Bilddatenverarbeitung angesiedelt sind. Ein Beispiel ist die Vorverarbeitung der Bilddaten.

Aus Rohdaten wird RGB

Ein Bildsensor liefert zunächst einmal Rohdaten, die in einer Industriekamera meist für den Anwender transparent aufbereitet werden. Bei Embedded- Systemen beginnt die Entwicklung dagegen schon auf der Sensorebene. Der Entwickler sollte also ein Verständnis für Rohdaten und deren Aufbereitung haben. Der Vorteil ist, dass er diese Aufbereitung selbst in der Hand hat und effizient für die konkrete Anwendung gestalten kann.

Jobangebote+ passend zum Thema

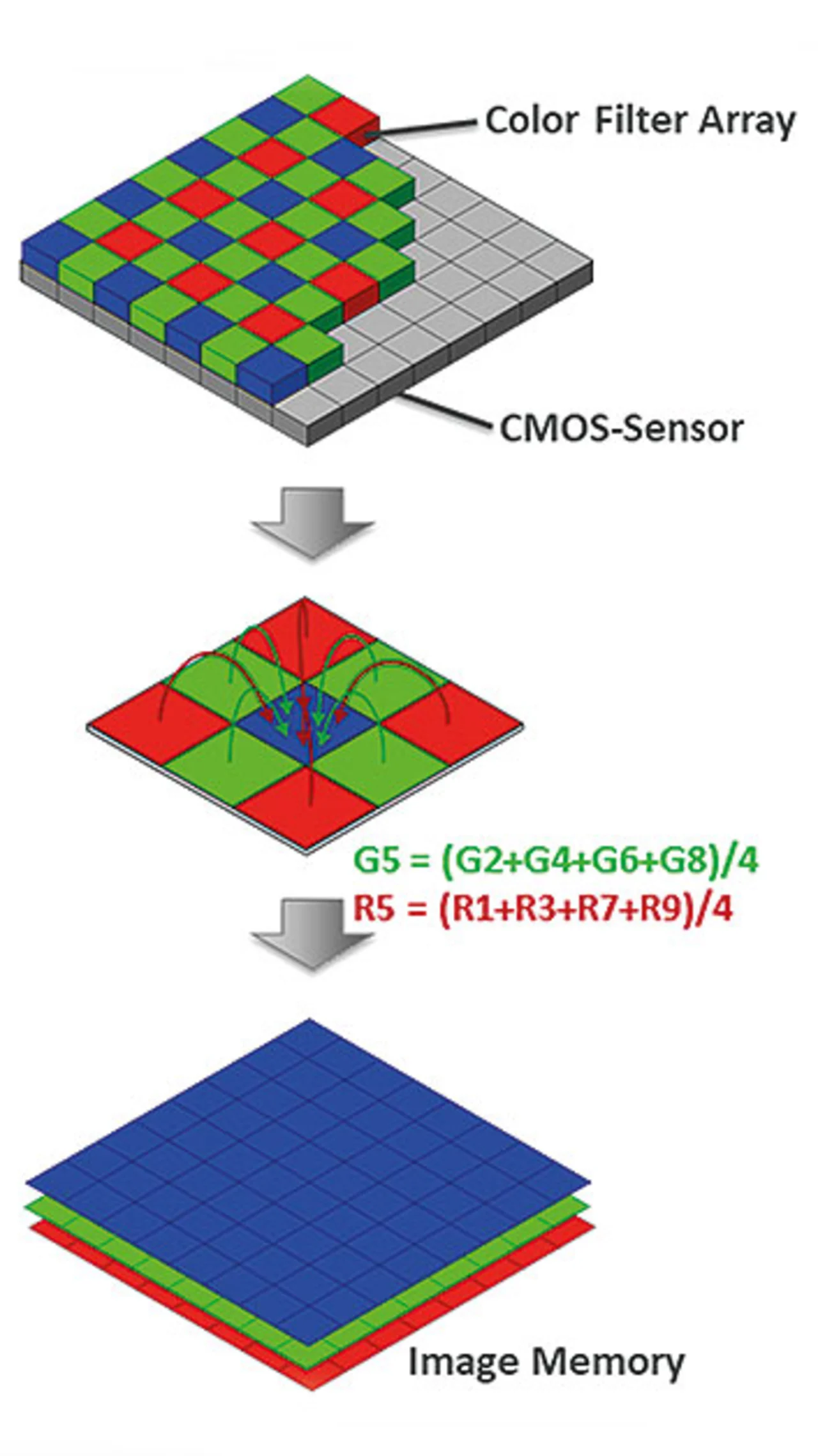

Einer der ersten und wichtigsten Schritte bei der Aufbereitung von Farbrohdaten von CMOS-Sensoren ist das Demosaicing, auch Bayer-Konvertierung genannt. Bildverarbeitungsalgorithmen erwarten in der Regel für jedes Pixel die vollständige Farbinformation, meist im RGB-Format, also als Wertetripel der Farbauszüge Rot, Grün und Blau. Einchip-Farbsensoren sind jedoch meist mit einer Bayer-Farbfiltermatrix versehen (Bild 1).

Die Pixel sind dabei zeilenweise abwechselnd mit roten und grünen bzw. grünen und blauen Farbfiltern abgedeckt. Jedes Pixel liefert also nur einen Farbauszug. Der höhere Anteil an grünen Pixeln geht auf eine Adaption an die Wahrnehmung des menschlichen Auges zurück. Zur Vervollständigung des RGB-Tripels müssen die Farbauszüge der benachbarten Pixel herangezogen werden. Im Bild ist ein (sehr einfaches) Verfahren skizziert, das die fehlenden Farbwerte aus den Mittelwerten der benachbarten Pixel bestimmt. Daneben gibt es eine Reihe weiterer Algorithmen für die Bayer-Konvertierung. Bei der Planung eines Vision-Systems mit einem Einchip-Farbsensor ist aufgrund des Debayerings (auch Demosaicing) eine etwas höhere räumliche Unschärfe zu berücksichtigen.

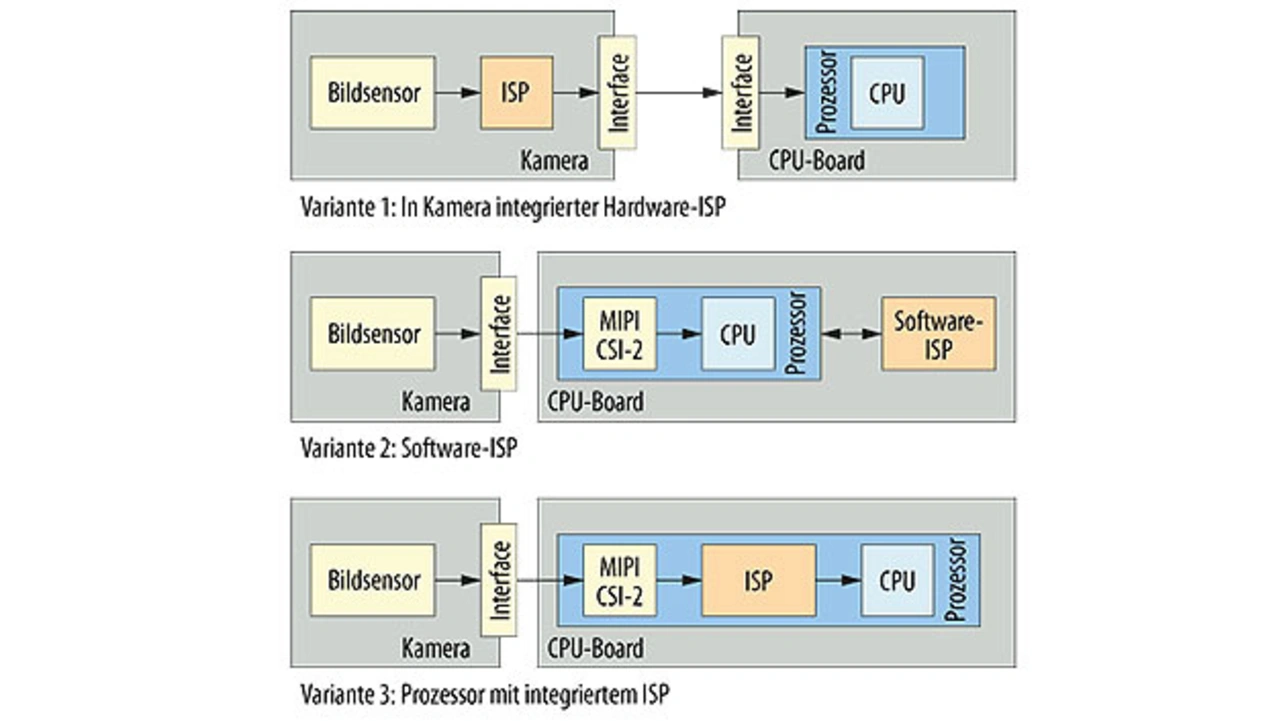

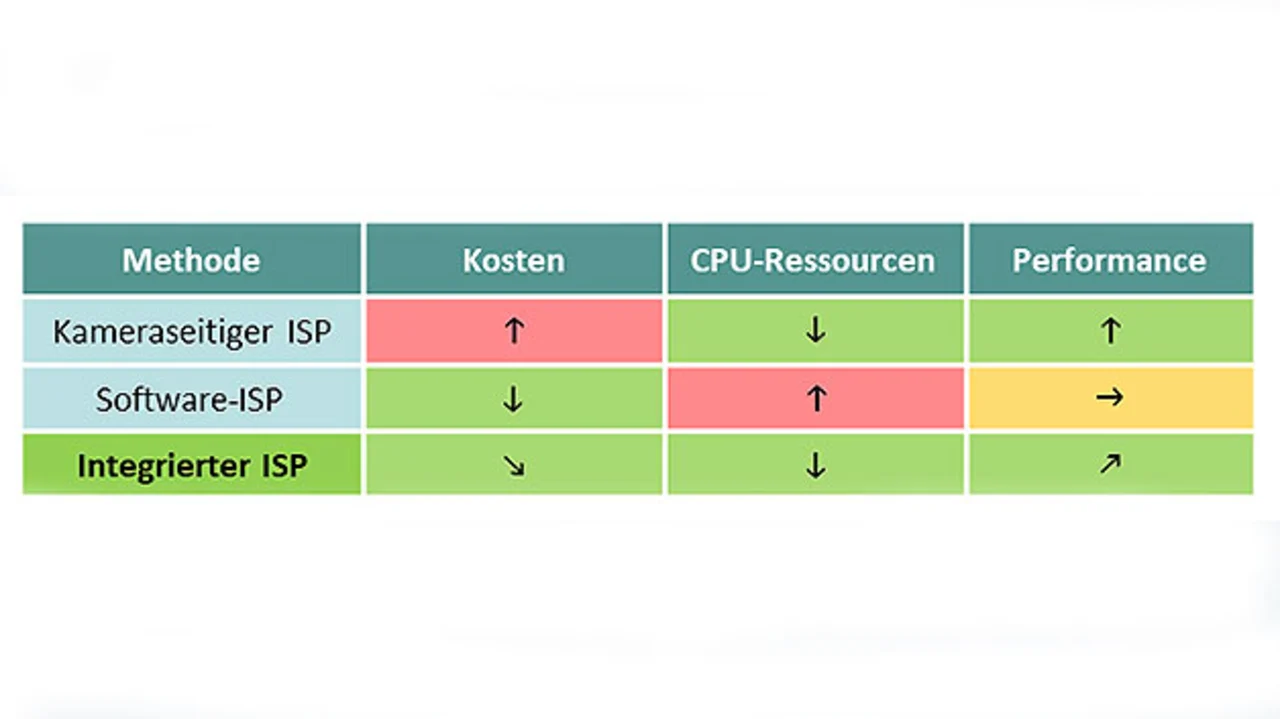

Für den Systemdesigner stellt sich die Frage, auf welche Weise das Demosaicing ausgeführt werden soll (Bild 2). Zum einen besteht die Möglichkeit, diese Umrechnung bereits auf dem Kameramodul durch einen dedizierten Vorverarbeitungsprozessor – meist Image Signal Processor (ISP) genannt – durchführen zu lassen. Vorteil ist hier, dass der Prozess transparent und ohne Ressourcenbeanspruchung abläuft, der separate Image Processor schlägt sich jedoch in höheren Hardwarekosten nieder.

Eine andere Option ist die Konvertierung in Software auf dem Anwendungsprozessor. Die Kosten für einen ISP können so eingespart werden. Allerdings beansprucht die Berechnung Rechenzeit der CPU. Hier muss abgewogen werden, ob diese Ressourcen zur Verfügung stehen. Bei kleineren Bildgrößen und nicht allzu hohen Anforderungen an die Framerate kann dies eine attraktive Lösung sein, insbesondere, wenn zur Berechnung eine Grafikeinheit (GPU) oder ein Vektor-Coprozessor (SIMD/NEON) verfügbar ist.

Moderne Arm-Prozessoren wie beispielsweise der i.MX 8M Plus von NXP eröffnen eine dritte Möglichkeit: Sie haben bereits Image-Signal-Prozessoren chipseitig integriert. Bildrohdaten von einem CMOS-Sensor mit MIPI-CSI-2-Schnittstelle lassen sich unabhängig von den Ressourcen des Anwendungsprozessors vorverarbeiten. Diese Lösung erreicht die Performance von separaten ISPs bei geringeren Kosten. Die Tabelle zeigt die Optionen im Vergleich.

| Praxistipps |

|---|

|

1. Bei der Planung eines Embedded-Vision-Systems sollte der tatsächliche Bedarf an Bildvorverarbeitung möglichst im Voraus ermittelt werden, um die passende Plattform auswählen zu können. Lassen Sie sich dabei von Embedded-Vision-Spezialisten der Komponentenhersteller wie z.B. Phytec beraten. Mit Ent-wicklungskits der Hersteller kann die Performance der infrage kommenden Plattformen realitätsnah bis auf Applikationsebene getestet werden, bevor die eigentliche Systementwicklung beginnt. 2. Bestimmte Vorverarbeitungsfunktionen wie z.B. Lens Shade Correction oder Verzeichnungskorrektur setzen eine Kalibrierung des ISPs auf Optik und Kamerasensor voraus, die teils aufwendige Toolsets erfordern. Sollen diese Funktionen genutzt werden, sollte geprüft werden, ob vorkalibrierte Komponenten verfügbar sind oder der Hardwarepartner die Kalibrierung als Dienstleistung übernehmen kann. 3. Die Langzeitverfügbarkeit von Komponenten spielt bei professionellen Produkten eine wichtige Rolle. Besonders bei Bildsensoren und Optik kann ein Redesign aufgrund abgekündigter Bauteile sehr aufwendig werden, aber auch schon der Ersatz von Halbleitern verursacht ärgerliche Produktpflegeaufwände in der Serie. Prüfen Sie deshalb vorab die Verfügbarkeiten. Zum Leistungsumfang mancher Komponenten-hersteller gehört ein umfangreiches Product Change Management, das Ihnen die Arbeit abnehmen kann. Informieren Sie sich, welche Optionen hierzu angeboten werden. 4. Das Betriebssystem ist das Bindeglied zwischen Hardware und Software. Prüfen Sie den Funktions-umfang. Welche Hardwarekomponenten werden bereits nativ unterstützt? Sind Anpassungen notwendig: Können Sie diese selber vornehmen? Bietet der Hersteller einen BSP-Anpassungsservice? Wird das Board Support Package (BSP) vom Hersteller gepflegt, gibt es Updates? Unterstützt das System das Ausrollen von Updates Ihrer Applikation im Feld, z.B. für notwendige Sicherheitspatches? |

- Mission Embedded Vision

- (Mehr-)Nutzen Image Signal Processor