Künstliche Intelligenz

Eine echte Alternative zu Nvidia?

Jeni Barovian, Vice President and General Manager in der Data Center AI Solutions Strategy & Product Management bei Intel, erklärt, dass die Kunden beim Thema »Generative AI« eine Alternative zu dem allgegenwärtigen Nvidia wollen. Mit Gaudi 3 soll es sie jetzt geben.

»Die Kunden fragen uns nach Wahlmöglichkeiten, nach wettbewerbsfähigen Preisen und Leistungen, nach der Time-to-Value und nach einem offenen Ecosystem für ihre KI-Implementierungen. Und Intel Gaudi 3 bietet genau das - eine überzeugende Kombination aus Preis, Leistung und Time-to-Value. Dazu setzen wir auf einen offenen Ansatz mit offenen Standards für die Skalierung von KI-Systemen, offener Software, um dadurch die größtmögliche Reichweite im Entwickler-Ecosystem und bei Unternehmensanwendungen zu gewährleisten«, erklärt Barovian weiter.

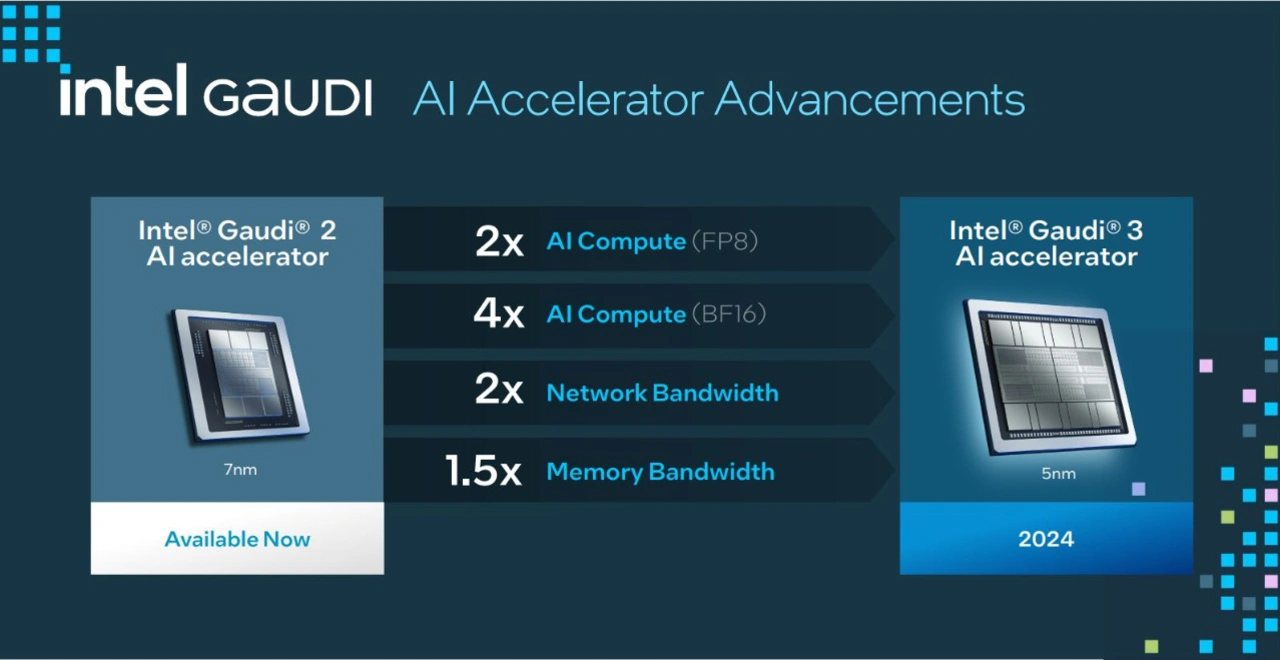

Der KI-Beschleuniger Gaudi 3 (5 nm) baut auf Gaudi 2 (7 nm) auf, kommt aber auf eine deutlich höhere Rechenleistung.

Jobangebote+ passend zum Thema

Leistungsvergleich zwischen Gaudi 3 und Nvida-Komponenten

Leistungsvergleich zwischen Gaudi 3 und Nvida-Komponenten

Gaudi 3 – KI-Beschleuniger für Gen AI

Gaudi 3 von Intel verfügt über insgesamt 64 TPCs (Tensor-Prozessorkerne der 5ten Generation) und acht MMEs (Matrix Multiplication Engines), die in zwei Dies untergebracht sind. Jeder Die ist mit 48 MB SRAM mit einer Bandbreite von 12,8 TB/s ausgestattet. Neben den zwei Compute-Dies sind noch acht HBM-Bänke (High Bandwidth Memory) integriert, so dass Gaudi 3 über »insgesamt 128 GB HBM-Speicher mit einer Bandbreite von 3,7 TB/s verfügt«, erklärt Eitan Medina, COO im Habana Labs von Intel. Für die Kommunikation sind die Gaudi 3-Beschleuniger mit 24 200 Gb-Ethernet-Ports ausgestattet, ein Punkt den Medina mit Blick auf Nvidia folgendermaßen kommentiert: »Ethernet ist ein offener Standards im Gegensatz zum proprietären InfiniBand.« Dazu kommen noch 16 PCIe 5 Lanes. Die zwei Compute-Dies kommunizieren über ein High-Speed-Interface, so dass »Gaudi 3 aus Software-Sicht wie ein einziger Chip agiert«, so Medina weiter.

Die Skalierung sieht folgendermaßen aus: In einem Node sind acht KI-Beschleuniger untergebracht; 64 dieser Nodes ergeben ein 64-node Cluster (mit 512 Beschleunigern), der nächste Schritt ist ein 512-node Cluster mit 4096 Beschleunigern. Der größte Ausbau ist ein 1024-node Cluster mit 8192 Beschleunigern. »Dank Ethernet können Racks und komplette Cluster mit buchstäblich Tausenden von Gaudi 3 Beschleunigern aufgebaut werden«, fährt Medina fort.

Leistungsvergleich mit H100 und H200 von Nvidia

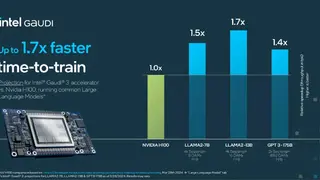

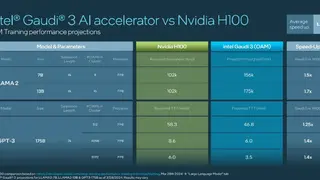

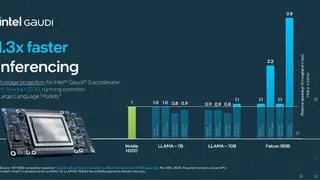

Um die hohe Leistungsfähigkeit von Gaudi 3 zu zeigen, hat sich Intel zu einem Vergleich mit Nvidia entschieden. Dazu muss allerdings gesagt werden, dass die Intel-Werte lediglich hauseigene Prognosen sind, da ja noch kein echtes Silizium vorliegt. Aber die prognostizierten Werte dürften Nvidia zumindest zum Teil aufhorchen lassen:

Die Trainingszeiten für Llama2 mit 7 Mrd. und 13 Mrd. Parametern und für GPT-3 mit 175 Mrd. Parametern fallen um bis zu 50 % niedriger aus.

Der Inferenzdurchsatz und die Leistungseffizienz beim Inferenzieren fällt bei Llama-Modellen mit 7 und 70 Mrd. Parametern und Falcon-Modellen mit 180 Mrd. Parametern um bis zu 50 respektive 40 Prozent höher aus. Wobei hier noch seitens Intel angemerkt wird, dass der Intel-Vorteil beim Inferenzieren sogar noch größer ausfällt, wenn mit längeren Eingabe- und Ausgabe-Sequenzen gearbeitet wird.

Das Inferenzieren bei Llama- (7 und 70 Mrd. Parameter) und Falcon-Modellen (180 Mrd. Parameter) läuft mit den Gaudi 3 Beschleunigern im Vergleich zu einem Nvidia H200 um 30 Prozent schneller ab.

Das sind Durchschnittsangaben, hinzu kommt noch, dass Gaudi 3 in dem einen oder anderen Fall auch schlechter abschneidet als Nvidia mit seinen H100- oder H200-Komponenten. Was die Vergleiche im Einzelnen ergeben haben, ist in der unten gezeigten Bildergalerie im Detail nachzuvollziehen.

Software

Medina: »Für Gen AI bzw. jede KI-Anwendung ist es extrem wichtig, den kompletten Software-Stack zur Verfügung zu stellen«, erklärt Medina. Das heißt von den KI-Applikationen über die KI-Software und Software-Suite bis hin zur Embedded Software. Medina: »Gaudi 3 eignet sich für eine breite Palette von KI-Anwendungen, wie beispielsweise Textgenerierung, Klassifizierung, Video-Erzeugung, Zusammenfassungen etc. Diese KI-Anwendungen beruhen auf unserer Software und unseren Modellen, die diese Kernfunktionen bereitstellen. Die wichtigsten Kernfunktionen sind die Unterstützung von Multimodalität, von großen Sprachmodellen und seit kurzem auch von RAG-Implementierungen.« (RAG: Retrieval-Augmented Generation). Bei der KI-Software geht es wiederum um KI-Modelle wie beispielsweise Llama, BLOOM, BERT, CLIP oder StarCode und typische Frameworks/Libraries von PyTorch, Hugging Face oder DeepSpeed, aber auch um Orchestrierungs-Software von RedHat oder kubernetes. Die Intel Gaudi Software Suite wiederum integriert das PyTorch-Framework und bietet optimierte, auf der Community basierende »Hugging Face«-Modelle – laut Medina das derzeit am weitesten verbreitete AI-Framework für GenAI-Entwickler. Dies ermöglicht es GenAI-Entwicklern, auf einer hohen Abstraktionsebene zu arbeiten, was die Nutzung und Produktivität erleichtert und die Portierung von Modellen über verschiedene Hardwaretypen hinweg vereinfacht. Medina rezitiert einen Intel-Kunden, stability.ai, der Gaudi 2 nutzt, und der sagt, »er hat weniger als einen Tag gebraucht, um seinen Produktionsmodelle, die sie auf einer GPU entwickelt haben, auf Gaudi 2 zu portieren«. Medina ist überzeugt, dass auch andere Kunden mit Gaudi 3 ähnliche Erfahrungen machen können, wenn sie ihre Modelle auf Gaudi 3 portieren.

Gaudi3 PCIe

Mit Gaudi 3 bietet Intel das erste Mal den KI-Beschleuniger auch als PCIe-Karte (HL-338) mit acht MMEs an. Barovian beziffert die Rechenleistung mit maximal 1835 TFLOPS (FP8), die TDP soll bei 600 W liegen und es steht eine HBM2e-Speichergröße von 128 GB zur Verfügung. Dazu kommen die typischen Bauformen: eine Beschleuniger-Karte (HL-325L, OAM-konform) mit 1835 TFLOPS (FP8) und 128 GB HBM2e-Speicher und ein Universal-Baseboard (HLB-325) mit 14,6 PFLOPS (FP8) und einem HBM2e von mehr als 1 TB.

Laut Barovian sollen im ersten Halbjahr dieses Jahres luftgekühlte Varianten von Gaudi 3 als Sample verfügbar sein. Muster der flüssiggekühlten Gaudi 3-Varianten sind für das zweite Quartal 2024 geplant. Die Serienproduktion von luftgekühlten »Gaudi 3«-Beschleunigern ist für das dritte Quartal geplant, die flüssiggekühlten Varianten in Produktionskapazitäten sind für das vierte Quartal vorgesehen.

OEMs, die auf Intel setzen

Zu den namhaften OEM-Anbietern, die Gaudi 3 nutzen wollen, gehören Dell Technologies, HPE, Lenovo und Supermicro. Die allgemeine Verfügbarkeit des Intel Gaudi 3-Beschleunigers wird für das dritte Quartal 2024 erwartet, und die Intel Gaudi 3-PCIe-Add-in-Karte wird voraussichtlich im letzten Quartal 2024 erhältlich sein.