Inferenzen immer leistungsfähiger

Embedded-Systeme mit KI-Funktionen ausstatten

Mit Methoden der künstlichen Intelligenz lassen sich viele Produkte auf eine neue Ebene heben. Gerade am Edge zur Datenaufnahme und -verarbeitung sind KI-Applikationen beliebt wie nie. Jedoch gehört mehr dazu als die bloße Hardware-Technik, wie der Beitrag von Advantech verrät.

Künstliche Intelligenz (KI) in Embedded-Systeme zu implementieren ist längst nicht mehr Trend, sondern Standard für die meisten Embedded-Unternehmen. Hierbei löst sich KI von statischem, regelbasiertem Programmieren und setzt dafür Inferenzsysteme mit dynamischem Lernen für eine »intelligentere« Entscheidungsfindung ein.

Fortschrittliche KI im Zuge des Internet of Things definiert heute ganze Branchen neu. Ein bemerkenswerter Trend ist hierbei das Verlagern von KI-Inferenzsystemen an das Edge, also näher an Steuerelemente und Sensoren, um die Latenz zu verbessern. Advantech ist bei praxisnahen Applikationen in dem Bereich schon sehr fortschrittlich und klärt auf, was dank der IoT/KI-Konvergenz in industriellen Applikationen bereits möglich ist.

Der Bedarf an KI-Hardware aller Art wächst schnell. Herausfordernd für Inferenzplattformen sind das Einspeisen von Daten mit einer hohen Bandbreite sowie die Entscheidungsfindung in Echtzeit. Gleichzeitig ist der Platzbedarf gering, und die Leistungsaufnahme soll möglichst niedrig sein. Jedoch gibt es bereits heute Applikationen für solche Anforderungen, beispielsweise in Branchen wie Produktion, Medizintechnik oder Transportwesen.

KI-Inferenz einfach erklärt

KI-Systeme basieren auf zwei Komponenten, die aufeinander aufbauen: Komponenten für das Training und für die Inferenz. Trainingssysteme untersuchen Datensätze und Ergebnisse, um einen Entscheidungsalgorithmus zu erstellen. Bei großen Datensätzen bieten sie den Vorteil, mit Servern, Cloud-Computing-Ressourcen oder im Extremfall mit Supercomputern skalieren zu können. Somit können sie sich Tage oder sogar Wochen für die Datenanalyse leisten.

Inferenz nutzt hingegen trainierte Algorithmen, um Vorhersagen zu treffen. Somit ist Inferenz sozusagen die Anwendung des trainierten Modells im laufenden Prozess. Logische Schlussfolgerungen werden aus bereits vorhandenen beziehungsweise angenommenen Prämissen abgeleitet. Im Gegensatz zum Training ist die Inferenz weniger rechenintensiv, erfordert jedoch eine effiziente KI-Beschleunigung, um schnell Entscheidungen zu treffen und mit den eingehenden Daten Schritt zu halten. Zu den beliebtesten Optionen für das Beschleunigen von Inferenzen gehören Graphics-Processing-Unit(GPU)-Cores, die mit vertrauten Programmier-Tools, hoher Leistungsfähigkeit und einem großen Ökosystem einhergehen.

Bisher liefen die ersten KI-Inferenz-Systeme auf zentralen oder dezentralen Servern, weit entfernt von der eigentlichen Applikation. Mit zunehmenden Datenraten und dem Ausführen von Datentransfers in Echtzeit verlagert sich das immer mehr in die Applikation, also an das Edge.

Jobangebote+ passend zum Thema

Vorteile der KI-Inferenzarchitektur

Edge-Computing bietet einen großen Vorteil in verteilten Architekturen, die große Mengen von Echtzeitdaten verarbeiten. Das Übertragen all dieser Daten zur Analyse in die Cloud oder auf einen dezentralen Server ist sehr herausfordernd für das Netzwerk und den Massenspeicher und beeinträchtigt sowohl die Bandbreite als auch die Latenz. Ein lokales Verarbeiten der Daten in der Nähe der Datenquellen, beispielsweise das Vorverarbeiten mit KI-Modellen, reduziert die Engpässe und senkt Netzwerk- und Speicherkosten.

Das Erweitern von Edge-Computing um KI-Inferenz bringt weitere Vorteile mit sich. Edge-KI-Inferenzen lassen sich mit dem Hinzufügen kleinerer Plattformen effizient skalieren. Alle Verbesserungen, die Entwickler mithilfe von Inferenzen auf einem Edge-Knoten erzielen, können hochgeladen und über ein ganzes System von Knoten hinweg zum Einsatz kommen. Ist es einer Inferenzplattform möglich, den gesamten Anwendungs-Stack mit Dateneingabe, Inferenz, lokaler Steuerung sowie Datenanbindung zu beschleunigen, bietet sie ein großes Potenzial für Systemarchitekten.

Advantech bringt sein jahrzehntelanges Know-how im industriellen Computing in die neuen KI-Inferenzsysteme ein, die eine breite Palette von »Jetson«-Modul-Systemen des Herstellers Nvidia umfassen. Sie sind mit Arm-Prozessoren mit Nvidia-GPU-Cores kombiniert. Zudem steht eine umfassende Software-Infrastruktur bereit, darunter das »JetPack«-Software-Development-Kit (SDK) von Nvidia. Es unterstützt viele Frameworks und Modelle für maschinelles Lernen (ML) sowie verschiedene Multimedia-, Wissenschafts- und Computer-Vision-Bibliotheken.

Entwickelt für den Betrieb einsatzkritischer Applikationen, gibt es zunehmend Anwendungsfälle für diese Inferenzplattformen, einschließlich

- Verarbeiten von IoT-Sensor- und Steuerungsdaten,

- Steuern von Bewegungsabläufen,

- Klassifizieren von Mehrkanal-Bildern und

- anderen »intelligenten« Anforderungen der Automation.

- Sie lassen sich einfach einrichten und sind zudem lange verfügbar.

Applikationen in der Praxis

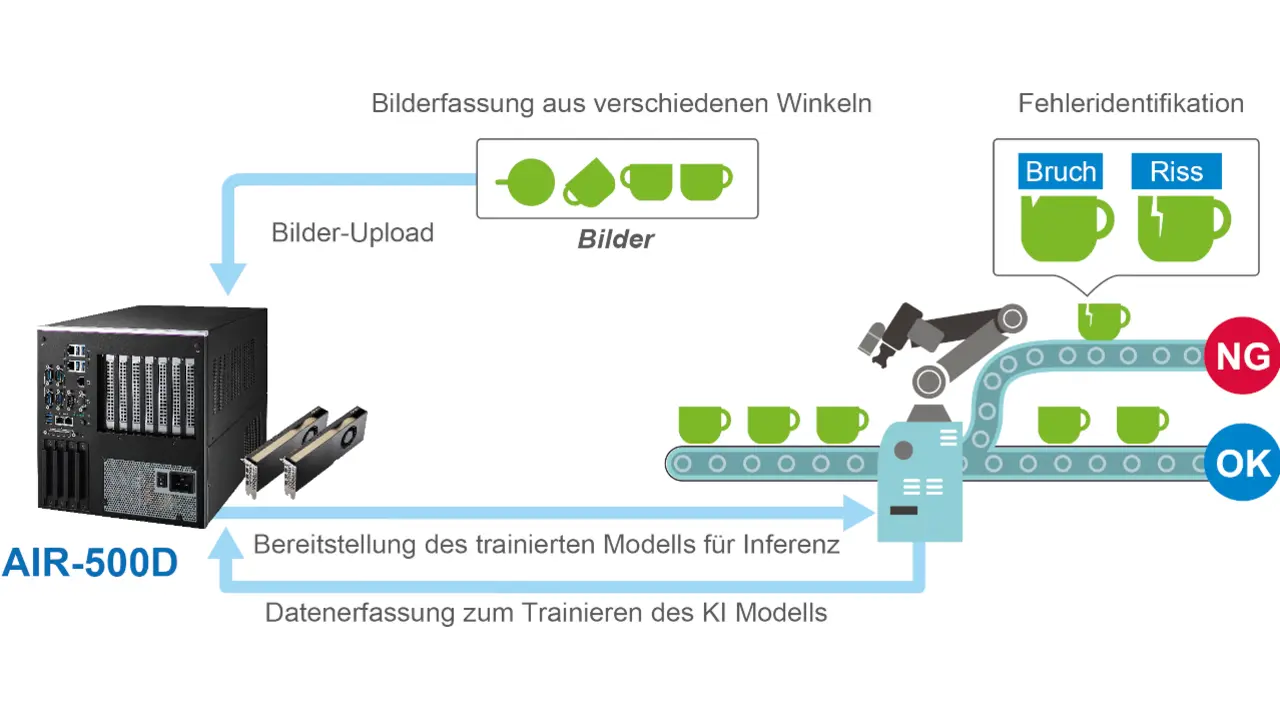

Ein Beispiel hierfür ist ein Hersteller von Bildverarbeitungsrobotern, der ein System der automatischen optischen Inspektion (AOI) entwickeln und fertigen sollte, das Endprodukte auf einem Förderband prüft.

Weil herkömmliche Bildverarbeitungssysteme aufgrund der Variabilität und Abweichung zwischen visuell ähnlichen Teilen manchmal nicht in der Lage sind, Mängel zu erkennen, setzte das Unternehmen auf Advantech und seine KI-basierten Produkte. Advantech half dem Spezialisten, seine Roboterarme für den Einsatz zum Erkennen von Fehlern mit KI-Funktionen zu kombinieren. Der Edge-KI-PC »AIR-500D« des Embedded-Herstellers nutzt zwei RTX-Grafikprozessoren, um sehr große Mengen an Bilddaten zu verarbeiten, die an verschiedenen Produktionslinien erfasst werden (Bild 1). Anschließend erkennt, klassifiziert und segmentiert der PC die Daten, um ein KI-Modell neu zu trainieren und die Gesamtgenauigkeit zu verbessern.

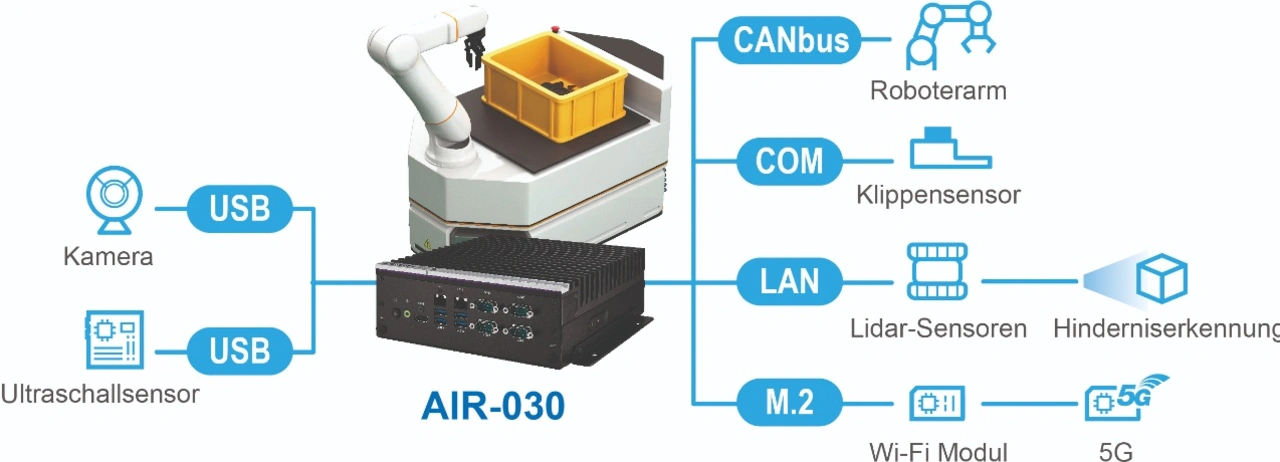

Ein anderer Anwendungsfall betrifft einen Hersteller von Autonomous Mobile Robots (AMRs). Sie kommen in Lagern zum Einsatz, um die Folgen des Arbeitskräftemangels, der steigenden Produktionskosten und der globalen Inflation zu überwinden. In dem Fall kommt Advantechs KI-Inferenzrechner »AIR-030« auf der Basis des »Jetson-AGX-Orin«-Moduls von Nvidia zum Einsatz (Bild 2). Er bietet eine hohe KI-Leistung und umfassende Input/Output(I/O)-Anschlüsse, um den PC mit Geräten wie Kameras, Sensoren oder drahtlosen Netzwerken zu verbinden. So kommen Ultraschall-, Lidar- und Klippensensoren zum Einsatz. Aufgrund seiner Konnektivität ist der AMR in der Lage, Hindernisse zu erkennen, während er sich selbstständig durch das Lager bewegt.

Ein derart breites Spektrum an Applikationen erfordert flexible CPUs und GPUs wie die der Jetson-Module. Weil sich KI-Modelle ständig weiterentwickeln, sind Faktoren wie Genauigkeit, Verarbeitungsspielraum und eine Auswahl an Frameworks wichtig. Hier helfen drei Säulen von Nvidia-Produkten Advantech beim Entwickeln. So kann der Embedded-Hersteller Inferenzen in die Realität umsetzen. Die drei Säulen sind skalierbare System-on-Modules (SoMs), SDKs für Inferenzen sowie Add-ons für Advantech-Produkte.

Drei Säulen der KI-Integration

Nvidias Jetson-Module sind die erste von drei Säulen für Edge-KI-Inferenz – von der Einstiegs- bis zur Serverklasse. Die Jetson-Module nutzen dieselbe Code-Basis, unterscheiden sich jedoch geringfügig in der Pinbelegung und Größe und bieten Funktionen wie Speicher, Video-Codierung und Decodierung, eMMC-Massenspeicher, Display-Schnittstellen oder Ethernet.

Die zweite Säule ist für eine große Basis von Entwicklern gemacht, die mit Nvidia »Cuda« entwickeln. Sie können sich ab sofort als KI-Inferenz-Entwickler bezeichnen – mit einem Software-Stack, der auf jedem Nvidia-Jetson-Modul läuft. Hiermit ergibt sich ein Ansatz für »Einmal entwickeln, überall einsetzen«.

Zu guter Letzt steht ein Ökosystem aus Bildverarbeitungskameras, Sensoren, Software, Systemen und Tools für KI-Applikationen bereit. Mehr als 100 Partner arbeiten in der Jetson-Umgebung zusammen und bieten qualifiziertes Know-how für eine unkomplizierte Integration.

Potenzial aufzeigen

Auf den jüngsten Messen in Europa hat Advantech ein Proof-of-Concept-System demonstriert, das aufzeigt, was die Kombination aus Advantech- und Nvidia-Technik ermöglicht. Das Demonstrations-System, das auf dem Box-PC »AIR-020« basiert, integriert Jetson-Module und nutzt Advantechs IoT-Management-Plattform »WISE-DeviceOn« oder alternativ die Azure-Cloud-Plattform. So zeigt der Anwendungsfall auf eine elegante Art und Weise das Verwenden von Edge-KI auf. Er konzentriert sich auf eine Applikation in der Lebensmittelindustrie, bei der eine Schale mit verschiedenen Früchten untersucht wird. Das System identifiziert nicht nur, welche Früchte sich in der Schale befinden, sondern bietet auch eine umfassende Berichtsfunktion.

Hervorzuheben ist hierbei, dass DeviceOn es dem Anwender erlaubt, sein eigenes Modell zu realisieren. Es ist nicht mehr nötig, das Modell auf dem Modul selbst zu trainieren. Anwender können es in der Cloud, vor Ort oder auf ihrer eigenen Infrastruktur trainieren. Sobald das Modell trainiert ist, lässt es sich in das »NX«-Format konvertieren und auf jedem einzelnen Edge-Gerät in der Produktion oder auf Hunderten von Geräten, die mit DeviceOn verbunden sind, bereitstellen.

Im Fall der Demo auf der Messe war die Aufgabe: Wurde die Schale mit der richtigen Art und Menge an Obst befüllt und ist damit bereit zum Verpacken? Fehlt etwas, ist das Obst falsch oder von schlechter Qualität? Nach dem Überprüfen werden die Rückschlussdaten an den Cloud-Server übermittelt. Das ist wichtig, da die Funktion den Nutzern ermöglicht, aus den Daten gegebenenfalls notwendige Folgeaktivitäten abzuleiten.

Mit dem AIR-020, das auf dem Jetpack vorinstalliert ist und das über DeviceOn verfügt, ist es möglich, Inferenzdaten in Echtzeit zu melden. Mithilfe von DeviceOn bietet das System Over-the-Air(OTA)-Update-Funktionen, um serienreife KI-Inferenzmodelle bereitzustellen. Nutzer können ebenfalls das integrierte Visualisierungstool in Advantech »Grafana« nutzen, um ein personalisiertes On-Cloud-Dashboard zu erstellen.

Eine weitere Option ist der kürzlich vorgestellte »AIR-030«, der auf Basis des Jetson AGX Orin für energieeffiziente autonome Maschinen KI-Inferenzfunktionen bietet. Das System ist mit I/O-Optionen ausgestattet, darunter CANBus für die Bewegungs- und Richtungssteuerung, LAN und optional Power over Ethernet (PoE) für den Kameraeingang sowie digitale I/Os für die Sensorsteuerung.

Außerdem unterstützt der AIR-030 mehrere Erweiterungen, um Funkmodule in Edge-KI-Applikationen integrieren zu können. Systeme wie der AIR-020 sowie der AIR-030 bringen Edge-KI-Inferenz in zuverlässigen, langlebigen Plattformen an das Edge und verschaffen der industriellen Welt damit weitreichende Vorteile.