Eingebettete KI

On-Edge Machine Learning

Fortsetzung des Artikels von Teil 2

Machine Learning im Edge - das MEMS-Sensor-Framework

Heute basieren zahlreiche Anwendungsfälle auf dem IoT. So werden in Privathaushalten Systeme für Sicherheitsaufgaben, zur Kontrolle des Energieverbrauchs und zur Steuerung von Hausgeräten verwendet. In Fabriken optimiert man die betrieblichen Abläufe und die Kosten mithilfe der vorausschauenden Instandhaltung. Städte kontrollieren den Verkehr und nutzen das IoT für die öffentliche Sicherheit. Logistikunternehmen verfolgen Lieferungen, nutzen Flottenmanagement-Lösungen und optimieren ihre Fahrtrouten. Restaurants gewährleisten die Lebensmittelsicherheit in Kühl- und Gefriergeräten, während der Einzelhandel intelligente digitale Regaletiketten einsetzt und fortschrittliche Bezahlsysteme implementiert. Diese Liste könnte man noch beliebig fortsetzen, denn überall geht der Trend heute zum Machine Learning. Analog dazu findet man auch Sensoren, und hier insbesondere MEMS-Sensoren, an allen möglichen Orten vor.

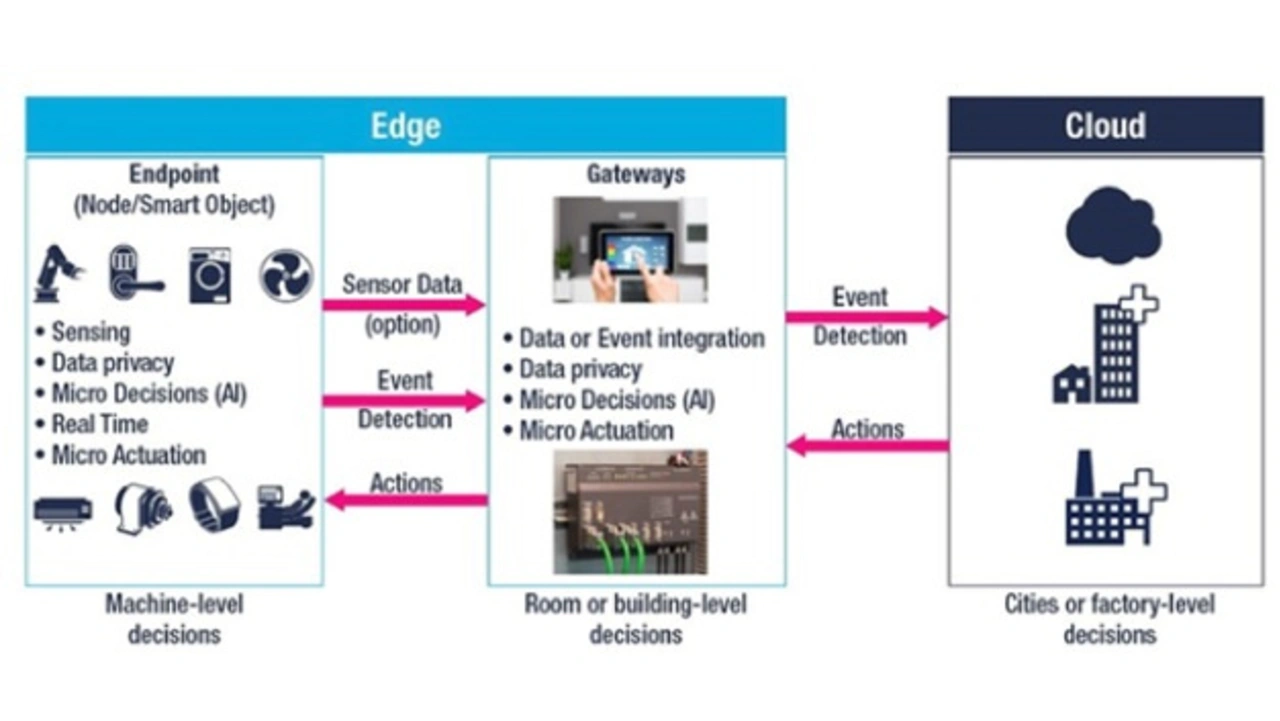

Ein weit verteiltes System setzt indes voraus, dass die von den Sensoren kommenden Rohdaten an eine zentrale, leistungsfähige Intelligenz (d. h. an eine Cloud) gesendet werden, was beträchtliche Anforderungen an die Datenbandbreite und die Rechenleistung stellt. Dieses Konzept würde die Reaktionsgeschwindigkeit beeinträchtigen, sobald man Audio-, Video- oder Bilddateien von Millionen von Endgeräten verarbeiten wollte.

Eine zentrale, cloudbasierte Implementierung reicht also nicht aus, da sie den benötigten Umfang an Daten nicht mit der heute erwarteten Geschwindigkeit bewältigen könnte. Ansätze für das Edge sind erforderlich, um die nötige Reaktionsgeschwindigkeit zu erzielen und eine bessere Nutzererfahrung zu bieten. Das »On-Edge-Paradigma« setzt allerdings eine lokale (und skalierbare) Implementierung der Rechen-Ressourcen mithilfe von Mikrocontrollern (MCUs) voraus. Welche Vorteile kann man sich aber durch den Umstieg von Cloud-Lösungen auf das Edge Computing erhoffen? Reichen die Cloud und Applikations-Prozessoren nicht aus, um ein IoT-System aufzubauen?

MCUs als kleine, preisgünstige Rechenbausteine werden häufig in IoT-Geräten der neuesten Generation eingesetzt, und man findet sie praktisch überall – jedes Jahr werden über 16 Mrd. MCUs verkauft. Ihr Vorteil ist ihr geringer Stromverbrauch: sie kommen monatelang mit einer Knopfzelle aus und benötigen keine Kühlkörper. Ihre Einfachheit trägt außerdem dazu bei, die Gesamtkosten des Systems zu senken.

Jobangebote+ passend zum Thema

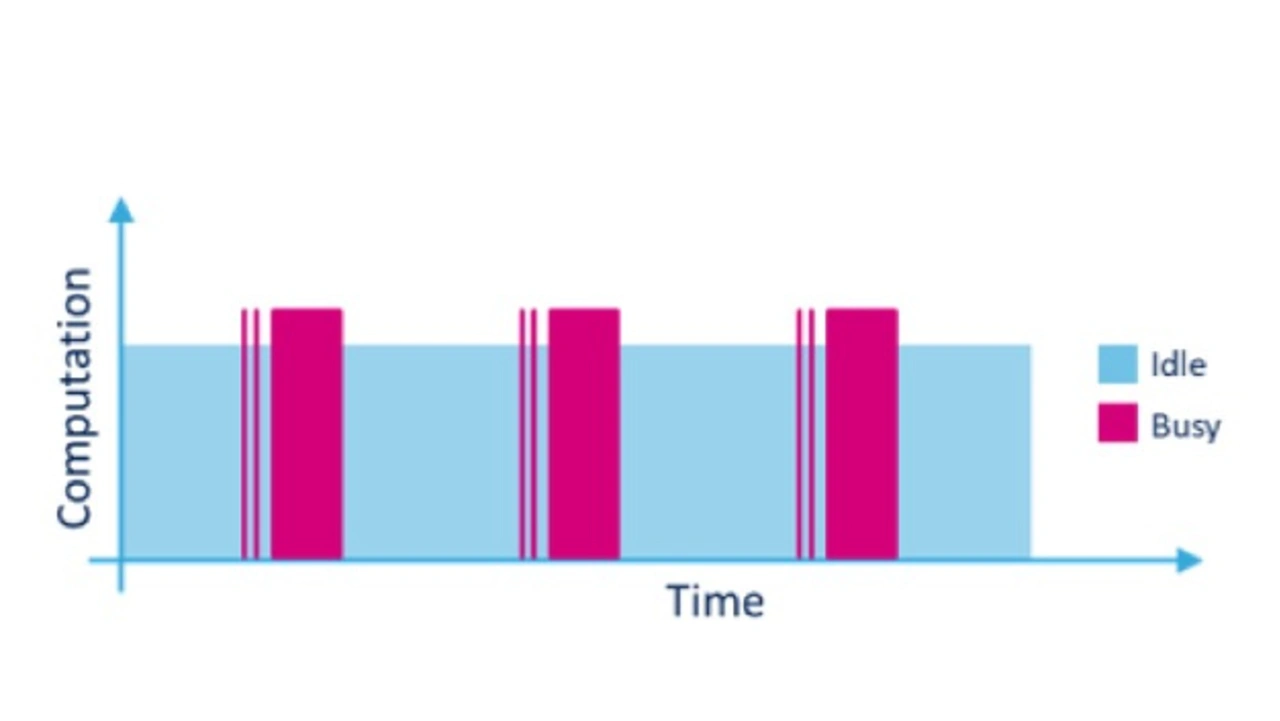

In den letzten Jahrzehnten, und heute mehr denn je, steigt die Rechenleistung von MCUs exponentiell, in vielen Fällen wird gleichzeitig der Stromverbrauch kontextabhängig gesenkt. In den meisten IoT-Anwendungen aber sorgt das Cloud Computing-Paradigma dafür, dass die MCUs nichts weiter tun, als Daten von den Sensoren in die Cloud-Infrastruktur zu transferieren. Diese Ressourcenvergeudung wird noch augenfälliger, wenn man bedenkt, dass moderne Mikrocontroller typischerweise mit Taktfrequenzen im dreistelligen Megahertz-Bereich arbeiten und über relativ viel Speicherkapazität verfügen. Bei diesem Ansatz (Cloud) sind die MCUs die meiste Zeit inaktiv, wie Bild 4 deutlich macht. Die Flächen in der Grafik geben die insgesamt verfügbare Rechenleistung des Mikrocontrollers an, wobei die aktiven Phasen, in denen Daten von den Sensoren erfasst sowie Displayinhalte, Timer und weitere Interrupts aufgefrischt werden, lila wiedergegeben sind. Die inaktiven Zeitspannen sind dagegen blau dargestellt. Stellt man sich Millionen solcher Bauelemente im realen Einsatz vor, so wird der große Umfang an ungenutzter Rechenleistung erkennbar.

Ein verteilter, dezentraler Ansatz auf Basis moderner »On-Edge«-Rechenressourcen kann die benötigte Bandbreite und Rechenleistung der Cloud-Server entscheidend reduzieren. Außerdem bietet dieses Konzept Vorteile hinsichtlich der Souveränität über die Benutzerdaten, denn Daten mit persönlichem Bezug werden vorab ausgewertet und den Service-Providern nur mit einem höheren Grad an Interpretation und Anonymisierung zur Verfügung gestellt.

ST hat sich bei ML- und DL-Implementierungen zunehmend für das On-Edge-Computing entschieden. Dank neuer KI-Lösungen können inzwischen fertig eingelernte ML-Algorithmen auf einem breiten Portfolio von STM32-Mikrocontrollern abgebildet werden.

Darüber hinaus hat ST die ML-Technologie in seine fortschrittlichen Inertialsensoren integriert, um Anwendungen wie ein adaptives Aktivitäts-Tracking mit hoher Performance und verbesserter Batterielebensdauer zu entwickeln. Diese Sensoren, z.B. die IMU »LSM6DSOX« (IMU: Inertial Measurement Unit), enthalten einen ML-Core und fortschrittliche digitale Funktionen, wodurch der angeschlossene STM32 oder das zentrale Applikationssystem in die Lage zu versetzen, in batteriebetriebenen IoT-, Gaming-, Wearable- oder Consumer-Applikationen zwischen einem Ultra-Low-Power-Status und sehr leistungsfähigen und präzisen KI-Funktionen zu wechseln.

Anwendungen, die mit dem LSM6DSOX bestückt sind, können mit »Always-On« aufwarten, ohne dass die Batterielaufzeit beeinträchtigt wird. Der Sensor verfügt außerdem über mehr Speicherkapazität und ein schnelles, digitales I3C-Interface, was längere Intervalle zwischen den Interaktionen mit dem Haupt-Controller sowie kürzere Verbindungszeiten ermöglicht, um zusätzlich Energie zu sparen. Da sich der Sensor außerdem einfach in gängige Mobil-Plattformen wie Android oder iOS integrieren lässt, vereinfacht sich der Einsatz in intelligenten Geräten für den Consumer-, Medizin- und Industrie-Markt.

- On-Edge Machine Learning

- Über- oder Unteranpassung

- Machine Learning im Edge - das MEMS-Sensor-Framework

- Vom Machine Learning zum Deep Learning