Eingebettete KI

On-Edge Machine Learning

Fortsetzung des Artikels von Teil 1

Über- oder Unteranpassung

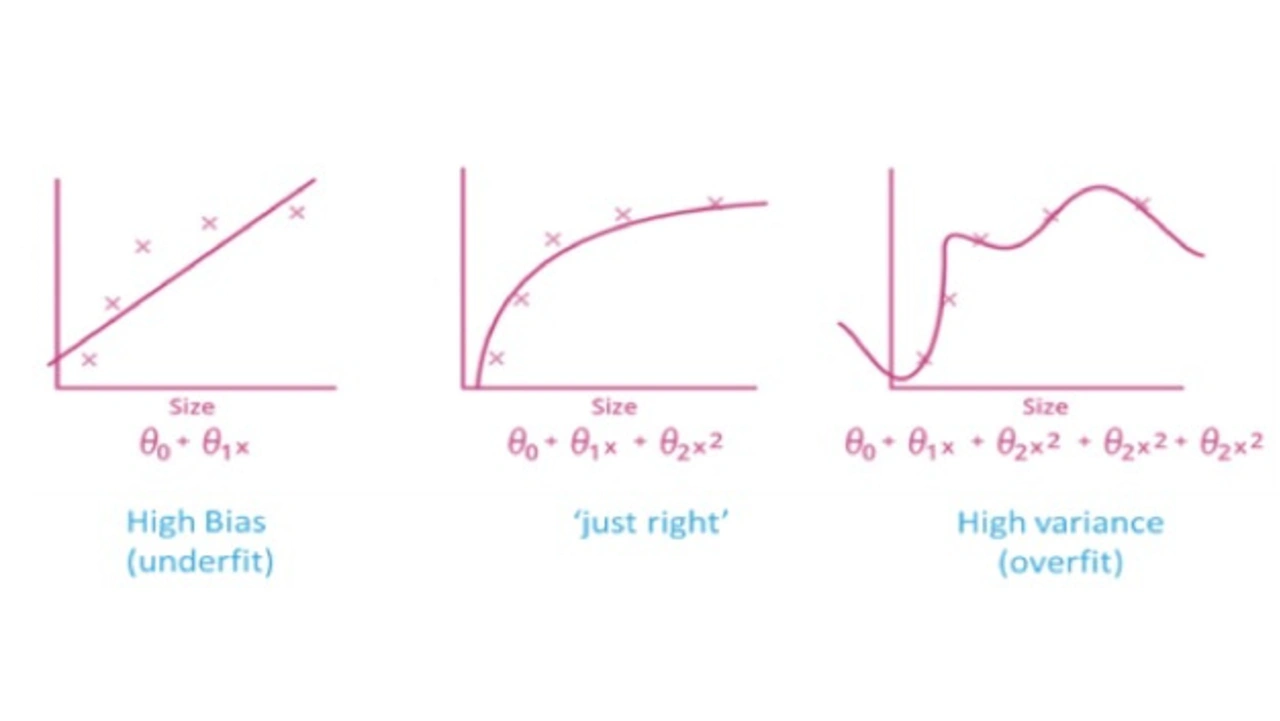

Abgesehen von der Bedeutung, die der Aufbereitung der Daten und der Auswahl der Merkmale zukommt, kann eine unzureichende Leistungsfähigkeit eines ML-Modells an inhärenten Problemen wie Unter- oder Überanpassung liegen. In der Statistik gibt die Anpassungsgüte (goodness of fit) an, wie gut die von einem Modell vorhergesagten Werte mit den beobachteten (tatsächlichen) Werten übereinstimmen. Ein Modell, das anstelle des Signals Rauschen gelernt hat, wird als »überangepasst« bezeichnet, weil es zwar dem Trainings-Datensatz sehr nahekommt, aber bei neuen Datensätzen nur eine unzureichende Übereinstimmung erzielt. Eine Möglichkeit, dieses Problem aufzudecken, zeigt das in Bild 2 skizzierte Bias-Varianz-Konzept. Man kann sich einen einfachen ML-Algorithmus als Regression vorstellen. Die Abwägung zwischen einem zu einfachen Modell (hoher Bias) und einem zu komplexen Modell (hohe Varianz) ist in der Abbildung klar erkennbar. Typischerweise kann man den durch Bias verursachten Fehler reduzieren, was aber den varianzbedingten Fehler erhöht (und umgekehrt). Ein entscheidendes Problem der Überanpassung besteht darin, dass der Algorithmus zwar bei den trainierten Daten hervorragend abschneidet, bei nicht im Training benutzten Daten aber nur mäßige Leistung bringt. Um dieses Problem zu lösen, kann der anfängliche Datensatz in separate Trainings- und Test-Datensätze aufgeteilt werden. So können wir eine Überanpassung als zu starke Konzentration auf die Trainingsdaten definieren, die zu komplexen Beziehungen führt, die sich auf neue Daten (Testdaten) nicht anwenden lassen. Im Gegensatz dazu ist eine Unteranpassung als zu geringe Konzentration auf die Trainingsmenge definiert, was dazu führt, dass der Algorithmus weder für den Trainings- noch für den Testdatensatz geeignet ist.

Folglich: Wenn das Modell beim Trainings-Datensatz deutlich besser abschneidet als beim Test-Datensatz, hat man es wahrscheinlich mit Überanpassung zu tun.

So nützlich das Erkennen einer Überanpassung auch sein mag – das Problem ist damit noch nicht gelöst. Glücklicherweise kann man mehrere Optionen ausprobieren, von denen hier die meistverwendeten vorgestellt werden:

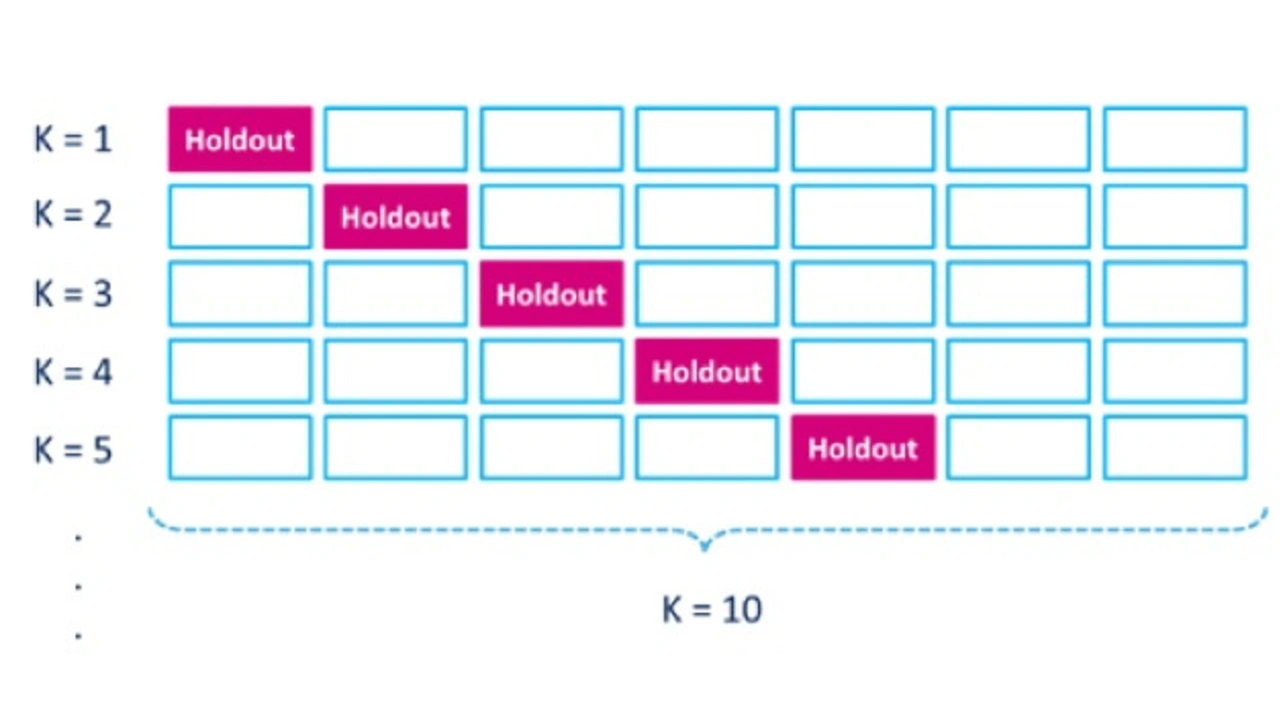

- Kreuzvalidierung: Dies ist eine wirkungsvolle vorbeugende Maßnahme gegen Überanpassung. Sie nutzt die Trainingsdaten, um mehrere kleine Train-Test-Splits zu erzeugen. Diese Splits werden zum Abstimmen und Validieren des ML-Modells genutzt (siehe Bild 3).

- Frühzeitiges Anhalten: Die Regel, die Hinweise darauf geben kann, wie viele Iterationen durchlaufen werden können, bevor es zu einer Überanpassung kommt.

Jobangebote+ passend zum Thema

Bei der herkömmlichen k-fachen Kreuzvalidierung werden die Daten in k Teilmengen unterteilt. Anschließend wird der Algorithmus iterativ an jeweils k-1 Teilmengen trainiert, während die übrige Teilmenge als Test-Datensatz (Holdout-Teilmenge) benutzt wird.

- On-Edge Machine Learning

- Über- oder Unteranpassung

- Machine Learning im Edge - das MEMS-Sensor-Framework

- Vom Machine Learning zum Deep Learning