Analog/Digital-Wandlung

Integriert oder besser mit eigenständigem IC?

Fortsetzung des Artikels von Teil 1

Genauigkeit und Präzision

Die Begriffe Genauigkeit und Präzision werden häufig synonym verwendet, bedeuten aber unterschiedliche Dinge. Genauigkeit ist die Fähigkeit der Messung, dem tatsächlichen Wert besonders nahe zu kommen; sie ist erforderlich, wenn man einen bestimmten Wert messen will. Präzision bezeichnet die konsistente Reproduzierbarkeit oder die Wiederholbarkeit einer Messung. Je präziser eine Messung ist, desto besser lassen sich kleinere Unterschiede erkennen. Ein Beispiel mit einer Waage verdeutlicht den Unterschied: Legt man 1000 Feinunzen Gold auf eine Waage, misst dreimal und erhält die Werte 1001, 1000 und 1000, dann weist die Waage eine hohe Präzision (0,0005 Unzen Standardabweichung) und hohe Genauigkeit (0,03 Prozent Fehler nach Mittelwertbildung) auf. Misst eine Waage hingegen 1018, 1017 und 1018 Unzen, so gilt dies immer noch als hohe Präzision (0,0005 Unzen Standardabweichung), aber die Genauigkeit ist geringer (1,8 Prozent Fehler).

Was zählt also mehr, Genauigkeit oder Präzision? Das kommt auf die jeweilige Anwendung an, es gibt aber viele Fälle, in denen sowohl Genauigkeit als auch Präzision nötig sind.

Genauigkeit: Um festzustellen, ob Genauigkeit erforderlich ist, muss man zunächst verstehen, wie der Sensor in der betreffenden Anwendung zum Einsatz kommt. Als Beispiel sei hier eine Temperaturmessung mit einem NTC-Thermistor (Negative Temperature Coefficient) genannt. Bei der Darstellung des Widerstands als Funktion der Temperatur fällt als Erstes die Nichtlinearität des Bausteins auf, wie in Bild 2 zu sehen ist.

Muss ein Entwickler mit dem NTC nur bei niedrigen Umgebungstemperaturen messen, kann er einen ADC mit geringerer Auflösung verwenden. Ist eine Temperaturmessung über den gesamten Temperaturbereich erforderlich, so muss er die ungünstigsten Bedingungen bei höheren Umgebungstemperaturen berücksichtigen und einen ADC mit wesentlich höherer Auflösung einsetzen.

Um dies mit der Systemgenauigkeit in Beziehung zu setzen, muss man den Temperaturbereich festlegen und berechnen, welche Temperaturgenauigkeit über diesen Bereich nötig ist. Den Temperaturbereich würde man in einen analogen Eingangsspannungsbereich für den ADC umwandeln. Die Genauigkeit wäre dann die kleinste Abweichung vom gemessenen analogen Eingangswert, die die Applikation tolerieren kann.

Präzision: Die Präzision muss im Idealfall besser sein als die Genauigkeit. Wird eine Temperaturmessung in der Rückkopplungsschleife eines Systems verwendet, sollte die Rückkopplungsschleife sehr stabil sein. Ist die Präzision schlechter als die Genauigkeit, könnte der Rückkopplungskreis aber instabil werden.

Jobangebote+ passend zum Thema

Kenngrößen von ADCs für Genauigkeit und Präzision

Die wichtigsten ADC-Parameter mit Einfluss auf die Genauigkeit sind integrale Nichtlinearität, differenzielle Nichtlinearität, Offset, Offsetdrift, Verstärkung und Verstärkungsdrift. Um die Genauigkeit zu bestimmen, müssen die Beiträge dieser Fehlerquellen bewertet werden. Ähnlich wird die Genauigkeit durch den Begriff »effektive Anzahl der Bits« (ENOB) definiert. Sie beschreibt die Abweichung, die bei einer Reihe von ADC-Messwerten vom wahren Mittelwert auftritt. Anders ausgedrückt: 68,3 Prozent der gemessenen ADC-Werte fallen in den durch ENOB definierten Bereich.

Zurück zum NTC-Beispiel: Angenommen, der Ausgang des NTC ist so kalibriert, dass er über den gesamten Temperaturbereich linear ist und 0 V bei –40 °C und 2,5 V bei +85 °C liefert, und man möchte mit einer Genauigkeit von 1 °C messen. Eine Genauigkeit von 1 °C über einen Bereich von 125 °C entspricht einer Genauigkeit von 0,8 Prozent über den gesamten Bereich.

Angenommen, ein 12-bit-ADC mit einem Gesamtfehler von 1 LSB und einem Eingangsbereich von 2,5 V wird verwendet, so ergibt sich eine ADC-Messgenauigkeit von 1/4096 oder 0,024 Prozent oder 2,5 V/4096 bit bzw. 610 µV/bit, was dem 33-Fachen der benötigten Genauigkeit entspricht. Daher sollte ein 12-bit-ADC theoretisch genug Genauigkeit für diese Anforderungen bieten.

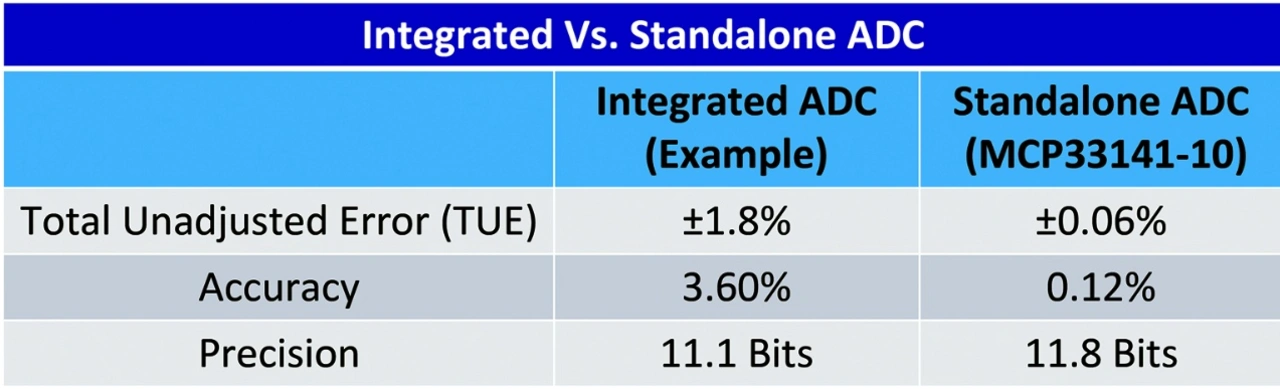

Nun ein genauerer Blick auf einen in eine MCU integrierten 12-bit-ADC mit 400 kSample/s. Im Datenblatt ist der gesamte unbereinigte Fehler (Total Unadjusted Error, TUE) mit ±1,8 Prozent von –40 bis +85 °C angegeben. Ein 6-bit-ADC mit einem Gesamtfehler von 1 LSB ergibt eine Genauigkeit von 1,6 Prozent. Was ist also mit den anderen 6 Bits des 12-bit-ADCs passiert? Darüber hinaus kann der Fehler auch noch positiv oder negativ sein, d. h. die Messwerte des ADC können um 3,6 Prozent oder 90 mV schwanken. In diesem Fall führt der große Verstärkungsfehler über die Temperatur zu einer stark reduzierten Genauigkeit. Dieser große Genauigkeitsfehler ist ein Nebenprodukt der prozessbedingten Einschränkungen. Bei der Lektüre von Datenblättern für integrierte ADCs sollte man sehr vorsichtig sein. In manchen Fällen gibt das Datenblatt für den integrierten ADC die ADC-Parameter unter Verwendung einer externen Spannungsreferenz an, da die integrierte Spannungsreferenz aufgrund ihres Rauschens, Drift und schlechter Leistung die Nutzung des internen ADC verbieten würde. Daher ist die Genauigkeit des integrierten ADC in diesem Fall nicht ausreichend für die Erfüllung der 0,8-Prozent-Anforderung.

- Integriert oder besser mit eigenständigem IC?

- Genauigkeit und Präzision

- Systembetrachtung