High-Performance Computer-on-Modules

PICMG stellt COM-HPC-Spezifikation 1.2 vor

Christian Eder, Chairman der COM-HPC Working Group und Director of Market Intelligence bei Congatec, sprach mit Markt&Technik über die wesentlichen Neuerungen der aktuellen COM-HPC-Spezifikation.

Die technischen Details dürften die Leser besonders interessieren, sind hiermit doch einige gefragte Applikationen möglich.

Markt&Technik: Herr Eder, bereits seit zweieinhalb Jahren gibt es die COM-HPC-Spezifikation. Wie hat sich die Nachfrage entwickelt?

Christian Eder, Congatec: Wir bewegen uns mit COM-HPC im High-Performance-Segment der Computer-on-Modules (CoMs), die man sowohl für modulare Server als auch Clients einsetzen kann. Die steigenden Anforderungen aufgrund der Digitalisierung und des IIoT, der Einsatz von künstlicher Intelligenz (KI) sowie die steigende Menge der zu verarbeitenden Daten tragen zu einer sehr hohen Nachfrage bei. Entwickler, die in diesen Anwendungsfeldern neue Designs aufsetzen, haben keinen Zweifel daran, dass COM-HPC-Module die richtige Lösung sind. Der Start verlief reibungslos und die Akzeptanz war von Anfang an sehr hoch. Das war beim Launch der COM-Express-Spezifikation noch ganz anders. Wir mussten viel mehr Überzeugungsarbeit leisten.

Jobangebote+ passend zum Thema

Was können Kunden von der neuen Revision erwarten?

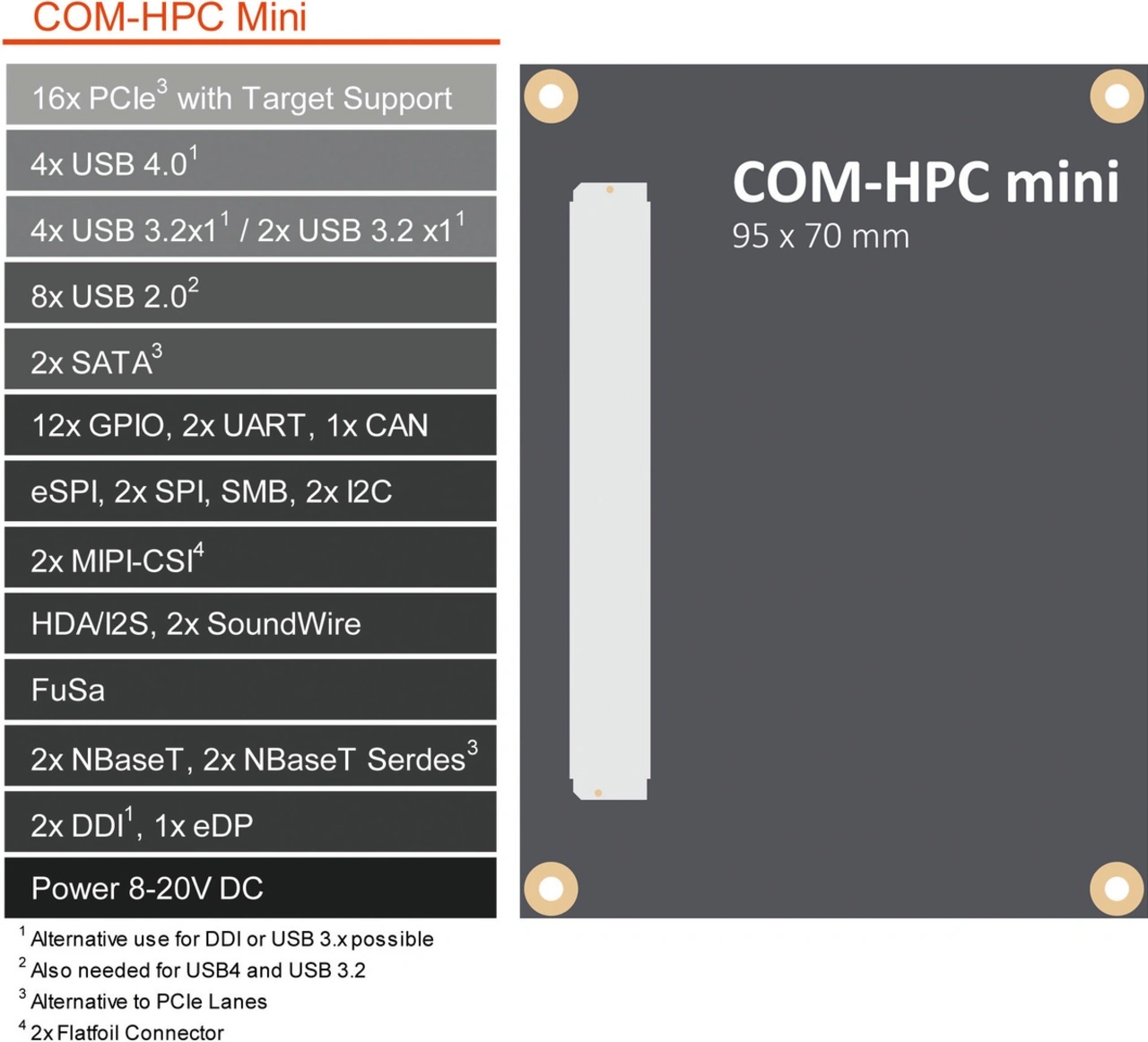

Es gibt wenige kleine Verbesserungen, die den Standard noch universeller einsetzbar machen sowie das Design robuster gestalten. Allen voran die erweiterten Footprint-Optionen um eine besonders kleine Modulgröße: COM-HPC Mini. Die neue Spezifikation ermöglicht High-Performance-Features auf einem besonders kleinen Formfaktor, der lediglich 95 mm x 70 mm misst. Selbst Geräte mit begrenztem Platzangebot profitieren ab sofort von dem mit 400 Pins sehr großen Schnittstellenangebot und einer hohen Bandbreite. Dies einschließlich Thunderbolt und PCIe Gen 5 sowie zukünftig Gen 6, sobald entsprechende Prozessoren verfügbar sind. COM-HPC-Module unterstützen zudem nicht nur spezifische Prozessoren auf x86- oder Arm-Basis, sondern ebenfalls FPGAs, ASICS und KI-Beschleuniger.

Warum ist die Mini-Spezifikation so wichtig?

Zum einen bedeutet Embedded immer ein geringes Platzangebot, kleine Geräte brauchen für KI und Situationsbewusstsein enorme Bandbreiten. Zum anderen passen die Abmessungen mit 95 mm x 70 mm sehr gut zum Migrationspfad von COM Express hin zu COM-HPC. Vom Platzbedarf her passen COM-HPC-Mini-Module in jedes Design, das auf Basis von COM Express Basic oder Compact entwickelt wurde. Die Transformation fällt also deutlich leichter, weshalb wir uns von diesem Formfaktor langfristig sehr viel versprechen.

COM-HPC Mini hat jedoch weniger Pins als COM Express Type 6. Sind die 10 Prozent weniger Pins nicht ein Bremsklotz?

Nein, COM-HPC Mini zielt auf kleine und mobile und nicht auf stationäre Geräte ab, oft sehr komplexe Systeme mit unzähligen Schnittstellen. Entwickler, die COM Express Type 6 voll ausreizen, sind vor allem Anwender von COM Express Basic. Sie migrieren in Richtung COM-HPC Size A und wollen sich die Option, deutlich mehr Schnittstellen anbieten zu können, nicht verbauen. Auch dieser Formfaktor ist mit 95 mm x 120 mm etwas kleiner als die 95 mm x 125 mm von COM Express Basic und bietet eine hohe Schnittstellenvielfalt und -dichte: Allein die 800 statt 440 Pins bringen mehr Schnittstellen und eine höhere Bandbreite mit sich. Obendrein sind bei COM-HPC die schnellen Schnittstellen wie PCI Express oder Ethernet um Dimensionen schneller ausgeführt. Der theoretische Leistungszuwachs aller möglichen Schnittstellen von COM Express Type 7 (Rev. 3.0) zu COM-HPC Server liegt etwa beim Faktor 15. Von COM Express (Rev. 3.0) zu COM-HPC Client steigt die mögliche I/O-Performance sogar um den Faktor 17.

Gibt es neben dem Formfaktor und den 400 Pins weitere Unterschiede zwischen COM-HPC Mini und den anderen COM-HPC-Formfaktoren?

Die Pins sind anders und teils mit mehreren Optionen belegt, um über die 400 Pins möglichst alle absehbaren Konfigurationen umsetzen zu können. Zudem wurde die Spannungsbelegung der Sideband-Signale angepasst, um den Energiebedarf zu reduzieren und vor allem Low-Power-Prozessoren zu unterstützen, die vermehrt mit 1,8 V arbeiten. Hiermit vereinfachen wir sowohl Modul- als auch Carrier-Board-Designs, weil es weniger Pegelwandler braucht, als wenn Entwickler bei der identischen Spezifikation der größeren COM-HPC-Formfaktoren blieben.

Man kann COM-HPC-Mini-Module nicht auf ein Carrier Board stecken, das für Size A designt wurde, da es weder elektrisch noch von den Schnittstellenbelegung her kompatibel ist. Auch der Heatspreader ist flacher geworden, um platzsparende Designs zu ermöglichen. Der MIPI-CSI-Support wird zudem nicht über den 400-Pin-Konnektor, sondern über zwei zusätzliche 22-Pin-Flatfoil-Konnektoren ausgeführt. Die COM-HPC-Mini-Spezifikation hat also eigentlich sogar 444 Pins. Diese Auslegung mit den zusätzlichen Konnektoren hat sich bereits bei SMARC und COM Express bewährt und wurde deshalb übernommen. Neben der höheren Pin-Anzahl haben wir mit dem Support von bis zu 107 W deutlich höhere Leistungsreserven als die bei SMARC möglichen 15 W.

Erklären Sie bitte das Multiplexing. Führt das nicht zu beliebigen Konfigurationen und damit Inkompatibilitäten?

Durch die Pin-Reduzierung im Vergleich zum COM-HPC Client stehen bei Mini acht Highspeed-Datenkanäle für die schnellen USB-3- beziehungsweise USB-4-Datenleitungen und für die digitalen Display Interfaces (DDI) bereit. Jedoch lässt sich nicht jeder Datenkanal beliebig verwenden. Aus diesem Grund haben wir fünf unterschiedliche Optionen definiert, um die acht Superspeed Lanes zwischen DDI- und USB-Belegungen bedarfsgerecht skalieren zu können. So sind zwischen zweifach DDI und vierfach USB 3 auf der einen Seite und vierfach USB 4 auf der anderen Seite ebenfalls Varianten mit DDI, USB 4 und vier USB 3 sowie DDI, zweifach USB 4 und zweifach USB 3 als auch dreifach USB 4 und zweifach USB 2 möglich. Es sind aber eben nur diese Belegungen erlaubt, was Planungssicherheit bietet.

Ähnlich ist es bei der Belegung von PCIe, Ethernet und SATA. Das bei COM-HPC eingeführte SERDES-Prinzip kennen Arm-Entwickler schon länger und es hat sich bewährt. Man muss sich allerdings ein wenig mehr mit den deutlich mehr möglich gewordenen Kombinationen befassen, um das Potenzial eines jeden einzelnen Moduls zu verstehen.

Schauen wir auf das COM-HPC-Server-Portfolio. Was zeichnet sich hier ab?

Es war interessant zu sehen, dass OEM beim Launch der Intel-Xeon-D-Prozessoren nicht die volle Speicherbandbreite der Prozessoren benötigen und deshalb auf Size D setzen, der nicht acht, sondern lediglich vier Steckplätze für RAM bietet. Das liegt daran, dass Edge-Server-Applikationen keine RAM-intensiven Server Workloads bewältigen müssen. Vielmehr müssen sie mehrere Echtzeitanwendungen nebeneinander hosten und benötigen daher so viele Kerne wie möglich. Außerdem müssen sie die Anforderungen der industriellen Kommunikation mit vielen kleinen Nachrichtenpaketen erfüllen, die in Echtzeit zu verarbeiten sind. Auch hier ist der Speicherplatz nicht so entscheidend wie bei datenbankgestützten Webservern, die tausende Personen parallel nutzen.

Kommen wir zu den weiteren Neuerungen der Spezifikation, die für alle Formfaktoren der Spezifikation gelten. Was sind hier die wichtigsten Änderungen?

Hier sind zwei Dinge zu nennen. Zum einen wurde der Konnektor in Richtung Robustheit weiter optimiert. Zum anderen wurde COM-HPC für PCIe Gen 6 vollständig qualifiziert.

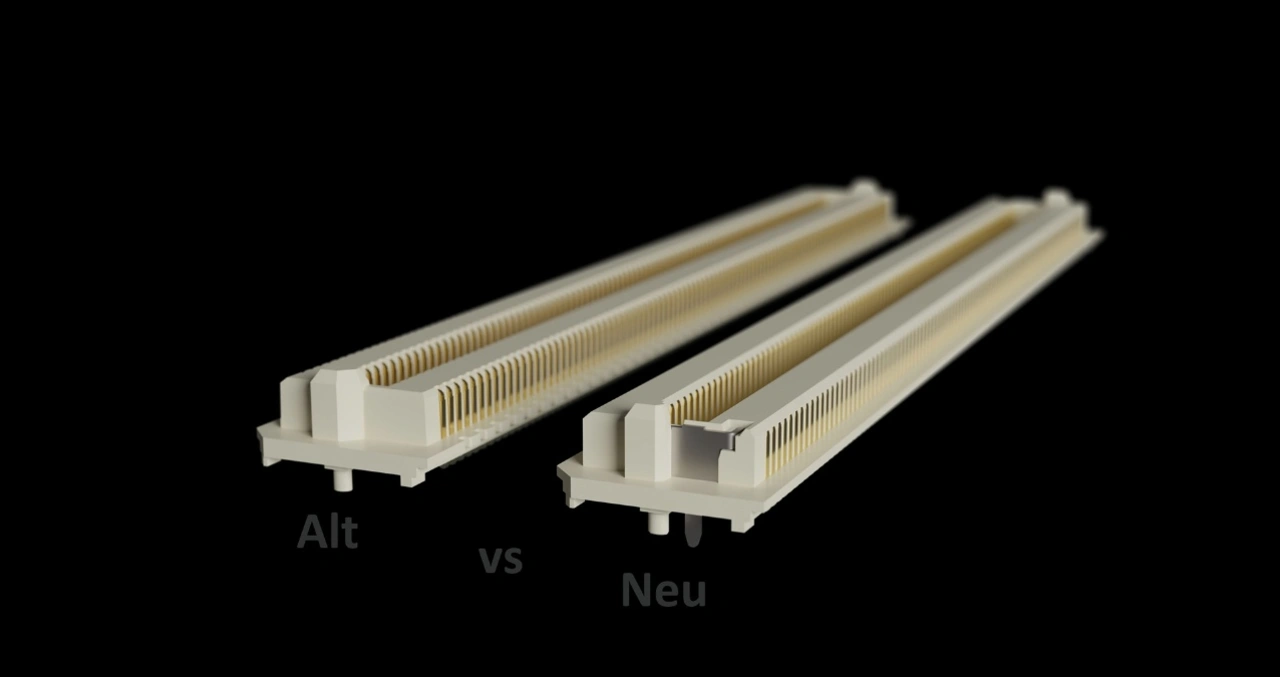

Hat der neue Konnektor Auswirkungen auf das Carrier Board?

Ja, denn um die Robustheit zu erhöhen, sind zwei kleine Bohrungen nötig. Dort werden die seitlichen Metallverstärkungen des Steckers verlötet, um eine erhöhte mechanische Stabilität zu erzielen. Ansonsten ändert sich jedoch nichts. Man kann den neuen Konnektor mit der Verstärkung also nur benutzen, wenn die Bohrung vorhanden ist. Sowohl der alte wie neue Konnektor lassen sich aber mit dem gleichen SMT-Lötverfahren bestücken. Insofern ist lediglich das Carrier Board Design geringfügig zu ändern, um der Revision 1.2 genüge zu tragen.

Ich gehe zudem davon aus, dass der bisherige Konnektor weiterhin geordert werden kann. Allerdings macht es Sinn, ihn nicht mehr für neue Carrier Boards zu verwenden. Der Umstieg ist unproblematisch – alter und neuer Stecker lassen sich in allen Kombinationen verwenden. Verfügbar ist der neue Konnektor im Übrigen bei mindestens drei Herstellern. Neben Samtec fertigen Amphenol und All Best die neue Variante in Lizenz, was Second-Source-Strategien ermöglicht.

Welche Änderungen mussten Sie für PCIe Gen 6 Designs machen – gibt es bereits Prozessoren, die diese Bandbreite unterstützen?

Generell kann man Carrier Boards bereits für Gen 6 auslegen, obwohl es noch keine Gen-6-unterstützende Prozessoren gibt. Sie werden aber über kurz oder lang erhältlich sein. Hierzu ist das Carrier Board für die PAM4-Modulierung anstelle der PAM2-Modulierung auszulegen. Hierbei werden nicht nur die Werte 0 und 1, sondern ebenso zwei Zwischenstufen genutzt – also zwei statt ein Bit pro Übertragung. Weil sich die übertragenen Frequenzen bei dem Upgrade nicht ändern, sollten kaum neue Herausforderungen in puncto Signalintegrität auftreten.

Ein sorgfältiges Design ist aber dennoch nötig, weil mit Gen 6 noch stärker als bei Gen 5 auf das Signalrauschen zu achten ist. Benötigt wird die erhöhte Bandbreite von 8 Gb/s pro Lane beispielsweise für Grafikanwendungen, mit der über 16 Lanes dann bis zu 128 Gb/s möglich werden. Zudem ist eine Bandbreite von 100 Gigabit Ethernet in vielen Bereichen schon Standard und diese Bandbreite muss bis zum Prozessor durchgereicht werden können.

Ist bei so viel Leistungszuwachs überhaupt noch ein robustes Embedded-Design möglich?

Zum Glück sind die Entwicklungen bei den Fertigungsprozessen in Richtung 7 nm und kleiner sowie bei der 3D-Technologie sehr positiv, was es ermöglicht, die Leistung bei gleicher Thermal Design Power (TDP) zu verdoppeln. Wir werden in Kürze neue Prozessoren launchen, die genau dieses Feature mit sich bringen. Wir können also die Leistung weiter steigern und uns dennoch innerhalb passiv kühlbarer Grenzen bewegen. Nur so können wir den steigenden Anforderungen an die Nachhaltigkeit gerecht werden.