CES 2018

ZF setzt auf Vernetzung, Autonomes Fahren und KI

Fortsetzung des Artikels von Teil 1

3. Generation ProAI wird zum Supercomputer

Auf der CES zeigt ZF ein Versuchsfahrzeug, in dem die Ingenieure der ZF-Vorentwicklung zahlreiche Fahrfunktionen realisiert haben, die vollautomatisiertes Fahren gemäß Level 4 möglich machen. Der Technologiekonzern machte sich dabei sein enges Kompetenznetzwerk zunutze, insbesondere bei der Ermittlung und Verarbeitung von Umfelddaten. Das Vorentwicklungsprojekt demonstriert die Leistungsfähigkeit und Praxistauglichkeit des erst vor einem Jahr von ZF und Nvidia vorgestellten Supercomputers ProAI. Dieser agiert als zentrale Steuereinheit im Versuchsträger. Ziel ist eine Systemarchitektur, die sich auf beliebige Fahrzeuge übertragen und je nach Einsatzzweck, verfügbarer Hardware-Ausstattung und gewünschtem Automatisierungs-Level zuschneiden lässt.

Für Ingenieure der Automobilindustrie gibt es keine Blaupause, nach der sie Entwicklungen für die jeweiligen Automatisierungsstufen realisieren können: »Das weite Feld des automatisierten Fahrens ist die Summe vieler einzelner Fahrfunktionen, die ein Auto ohne menschlichen Eingriff abrufen können muss und zwar ausfallsicher und auch unter verschiedensten Wetter-, Verkehrs- und Sichtverhältnissen«, erläutert Torsten Gollewski, Leiter Vorentwicklung von ZF Friedrichshafen.

Als System-Architekt für eine bedarfsgerechte Automatisierung baute ZF im Rahmen des Versuchsfahrzeugs eine komplette, modulare Entwicklungsumgebung unter Einsatz von künstlicher Intelligenz auf. »Wir haben hier beispielhaft eine Konfiguration für vollautomatisierte, also Level-4-Fahrfunktionen realisiert. Diese Konfiguration lässt sich modularisiert über die ZF-Domänen ‚see-think-act‘ auf den jeweiligen Anwendungsfall applizieren. Sie verhilft den Fahrzeugen zur notwendigen Seh- und Denkfähigkeit, etwa für innerstädtischen Verkehr«, erklärte Gollewski. Doch auch andere Automatisierungsstufen lassen sich dank dieser flexiblen Architektur in unterschiedlichsten Fahrzeugen umsetzen. Gleichzeitig gibt sie Aufschluss darüber, welche Hardware-Minimalkonfiguration für welchen Level unabdingbar ist.

In den vergangenen Monaten trainierten die ZF-Ingenieure dem Fahrzeug unterschiedliche Fahrfunktionen an. Dabei standen besonders urbane Situationen im Mittelpunkt wie etwa die Interaktion mit Fußgängern und Fußgängergruppen vor Zebrastreifen, eine Kollisions-Abschätzung, das Verhalten vor Ampeln und in Kreisverkehren. »Im Gegensatz zu einer Autobahn- oder Landstraßenfahrt ist es in städtischen Szenarien deutlich aufwändiger, ein gesichertes Verständnis der aktuellen Verkehrssituation herzustellen, das die Basis für angemessene Aktionen eines computergesteuerten Fahrzeugs bietet«, ergänzte Gollewski.

Skalierbare Rechenleistung mit ZF ProAI

Die ZF ProAI mit ihrer offenen Gesamtarchitektur ist skalierbar. Sowohl die Hardware-Komponenten, die angeschlossene Sensor-Ausrüstung als auch die Auswertungs-Software und Funktionsmodule lassen sich an den gewünschten Zweck und den Grad der Automatisierung anpassen. So lässt sich die ProAI beispielsweise in Bezug auf die Rechenleistung für nahezu jedes konkrete Anforderungsprofil konfigurieren. In der auf der CES gezeigten Anwendung nutzt die Steuerungseinheit den sogenannten Xavier-Chip mit 8-Kern-CPU-Architektur, 7 Milliarden Transistoren und entsprechend eindrucksvollen Leistungsdaten: Xavier bewältigt bis zu 30 Billionen Rechenoperationen pro Sekunde (TOPS, Trillion Operations per Second) bei einer Leistungsaufnahme von nur 30 W. Der Chip erfüllt wie die ProAI insgesamt die strengen Standards für automobile Anwendungen und schafft dort die Voraussetzung für künstliche Intelligenz und Deep Learning.

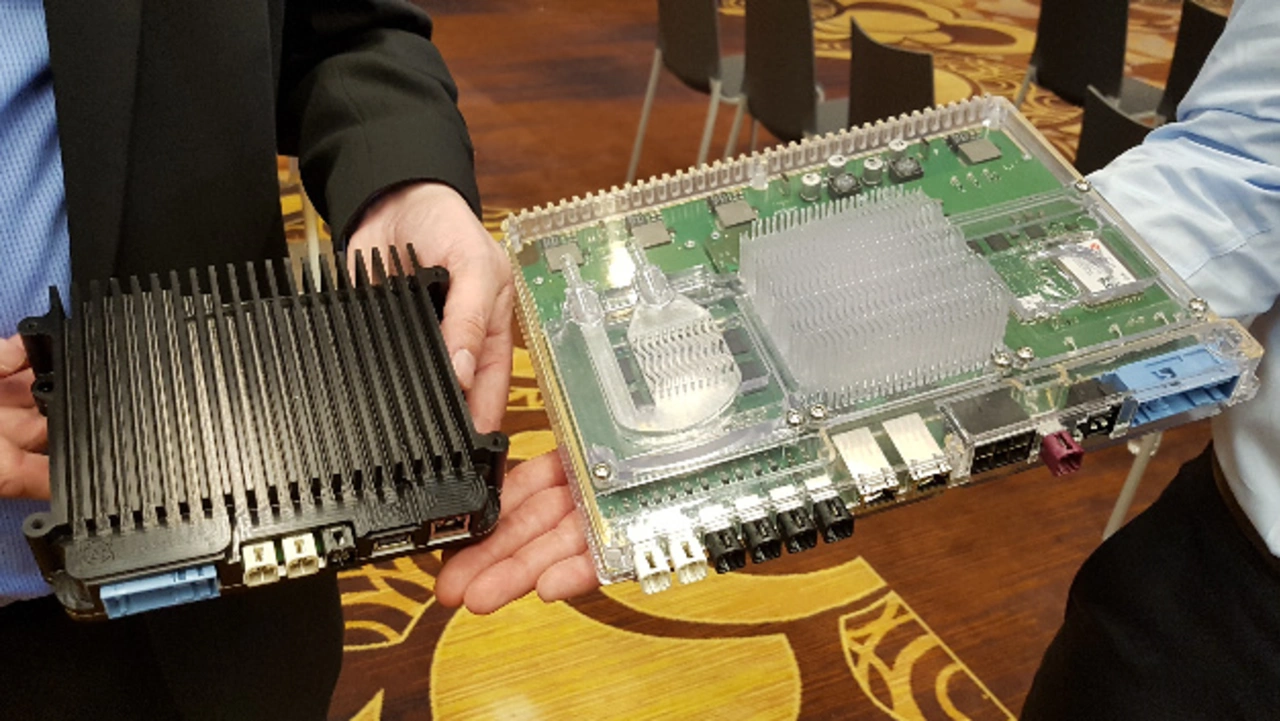

Darüber hinaus zeigte ZF auf der CES den Prototypen der 3. Generation von ProAI, eine Box, die sich mit maximal drei Platinen bestücken lässt und verschiedene Kühloptionen (Flüssigkeitskühlung, Kühlkörper) bietet. Die drei Platinen können mit Nvidia-Chips oder auch mit FPGAs, beispielsweise von Xilinx, bestückt sein.

Daten-Futter für ProAI

Um die Umgebung im Blick zu haben, spielt vor allem die umfassende Sensor-Ausstattung von ZF sowie dessen Partner-Netzwerk eine wichtige Rolle. Im aktuellen Fahrzeug sind Kamera-, Lidar- und Radar-Sensoren verbaut. Sie ermöglichen eine 360-Grad-Umfeldanalyse des Entwicklungsträgers, die alle 40 ms aktualisiert wird. Die enorme Datenflut — allein eine Kamera generiert 1 Gbit/s — wird von der Recheneinheit ProAI in Echtzeit analysiert. »Künstliche Intelligenz und Deep-Learning-Algorithmen dienen vor allem dazu, die Analyse zu beschleunigen und die Erkennung zu präzisieren. Es geht darum, aus der Flut der Daten wiederkehrende Muster in den Verkehrssituationen zu erkennen, etwa einen Fußgänger, der die Fahrbahn überqueren will«, erläuterte Gollewski. Die dann abgerufenen Reaktionsweisen des Fahrzeugs, die für die Berechnung der Längsbeschleunigung oder Verzögerung sowie der weiteren Fahrtrichtung ausschlaggebend sind, sind nach wie vor fest in der Software hinterlegt.

Der Versuchsträger am Messestand in Las Vegas »träumt« quasi eine Fahrt durch Friedrichshafen. ZF »füttert« das in Las Vegas statisch aufgebaute Fahrzeug mit Sensordaten, die bei einer Live-Erprobungsfahrt zwischen ZF-Forum und Forschungs- und Entwicklungszentrum in Friedrichshafen gewonnen wurden. Das Fahrzeug, insbesondere die darin verbaute ProAI, interpretiert diese Daten live, als wäre es gerade auf dieser Strecke unterwegs. Seine Handlungen wie Lenkeinschläge, Brems- und Beschleunigungsvorgänge, die auch am Messestand sichtbar sind, entsprechen exakt einer Fahrt 9.200 km Luftlinie entfernt — so, als träumte der Wagen von der Fahrt auf dem anderen Kontinent.

- ZF setzt auf Vernetzung, Autonomes Fahren und KI

- 3. Generation ProAI wird zum Supercomputer

- Cloud-Partnerschaft mit Microsoft