Bildverarbeitung und neuronale Netze

Augen für das autonome Fahren

Fortsetzung des Artikels von Teil 1

Wie hilft das selbstfahrende Fahrzeug?

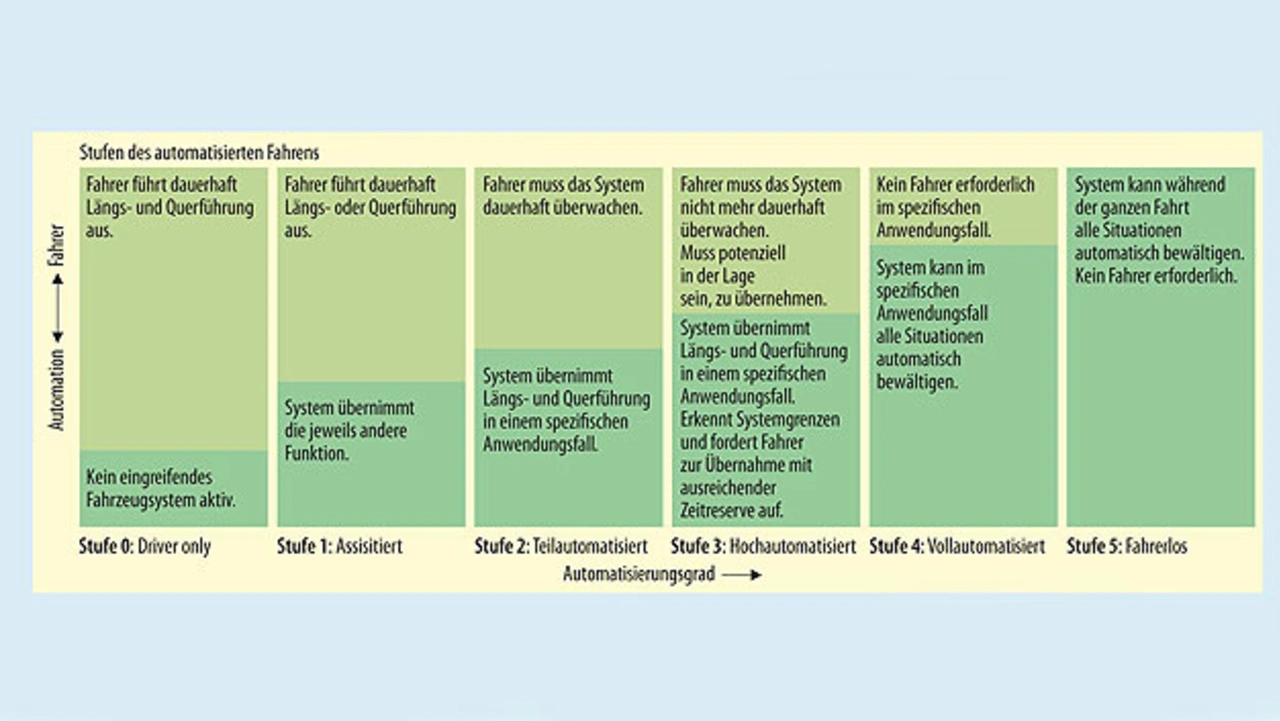

Der Weg zum autonomen Fahren führt über verschiedene Grade der Autonomie, wie sie Bild 2 zeigt. Heutige Serienfahrzeuge befinden sich auf Level 1. Sie sind mit Assistenzfunktionen wie einem Tempomat mit Abstandshalter (Längsführung) oder einem Spurhalte-Assistent (Querführung) ausgestattet. Der Übergang auf Level 4 und 5 wird schnell erfolgen, wobei das Jahr 2021 von vielen Automobilherstellern als das Jahr angepriesen wird, in dem erste Autos der Level 4/5 für autonome Taxi-Flotten zur Verfügung stehen sollen.

Es ist davon auszugehen, dass autonome Autos für jedermann nicht vor dem Jahr 2025 erhältlich sein werden. Da die Automobilindustrie aber ein sehr agiler Markt mit großen Herstellern und einem generell sehr hohem Interesse am selbstfahrenden Auto ist, kann sich dieser Zeitpunkt auch nach vorne verlagern.

Die Gesetzgebung seitens der Regierungen, die vorgesehenen Zeitabläufe und die Akzeptanz selbstfahrender Autos in der Öffentlichkeit sind allesamt ausschlaggebend. Viel Aufklärung ist nötig, um sicherzustellen, dass die Öffentlichkeit mit der Idee des selbstfahrenden Autos vertraut und dafür bereit ist, die Änderungen zu akzeptieren.

Ein entscheidender Schritt werden autonome Taxis sein. Wenn die Öffentlichkeit solche Taxis akzeptiert, die von einer Maschine gefahren werden, erhöht sich die Akzeptanz selbstfahrender Fahrzeuge. Letztlich muss man es selbst miterleben, dass selbstfahrende Autos sicher, von Vorteil und somit attraktiv sind.

Die Bedeutung der Bildverarbeitung

Technisch hängt der Übergang zum autonomen Fahren sicherlich sehr stark von einem speziellen Bereich der künstlichen Intelligenz ab: der digitalen Bildverarbeitung. Der Primärsensor autonomer Fahrzeuge ist die nach vorne gerichtete Kamera, zusammen mit LIDAR- (Laser) und Radar-Systemen. Die größte Menge an Informationen, die sich gewinnen lässt, wird allerdings durch Kamera-Subsysteme beigesteuert.

Bildverarbeitung gibt es schon seit vielen Jahren, genauso wie den Einsatz neuronaler Netze (CNN, Convolutional Neural Networks). Dabei handelt es sich um Sätze von Algorithmen, die aussagekräftige Informationen über einen Sensor beziehen. CNNs sind bei der Analyse einer Szene rechnerisch sehr effizient und können Dinge wie Autos, Menschen, Tiere, Verkehrsschilder, Straßenkreuzungen, Bordsteine, Straßenmarkierungen (Objekte) identifizieren und daraus die »relevante Realität« der Szene sozusagen extrahieren. Dies wird alles in Echtzeit durchgeführt. Sobald die Sensorerfassung abgeschlossen ist, beginnt der Prozess der Objektzusammenführung und der Entscheidungsfindung. Dazu werden Eingaben von einem oder allen Sensoren (LIDAR, Radar, Kamera, IR) beurteilt und Entscheidungen über die beste Vorgehensweise getroffen. Muss ein Auto plötzlich bremsen (außerhalb der Reaktionszeit des Fahrers), würden sofort der Abstand überprüft, die Geschwindigkeit erfasst und die Bremsen schneller eingesetzt, als jeder Mensch dazu in der Lage wäre.

Der Netzwerkteil des CNN besteht aus vielen Ebenen, die das Problem der Bilderkennung aufteilen – von der Suche nach Kanten, Ecken und Kreisen, um sie als Straßenschilder zu identifizieren, bis hin zur Erkennung, was das Verkehrsschild überhaupt vorgibt. Um diese Netzwerke funktionsfähig zu machen, müssen sie eine Trainingsphase durchlaufen. Dabei müssen sehr große Datensätze entsprechender Bilder in das CNN eingelernt werden, damit es die verschiedenen Objekte identifizieren kann. Damit werden die Koeffizientenanteile im Netzwerk aus den gelernten Datensätzen festgelegt. Dieser Trainingslauf ist in der Regel eine sehr rechenintensive Offline-Aktivität, die Stunden, wenn nicht Tage dauern kann.

Sobald das System in einem Auto in Betrieb ist, besteht die Möglichkeit, Anpassungen durchzuführen. Damit kann das Netzwerk Situationen in Echtzeit erfassen und die Koeffizienten aktualisieren, um eine höhere Genauigkeit auf der Straße zu gewährleisten. Mit seinem trainierten Wissen über die große Anzahl von Verkehrszeichen – auch bei wechselnden Lichtverhältnissen und Lichteinfallswinkeln – kann das CNN aussagekräftige Informationen beziehen, die dann einem Entscheidungsfindungselement zugeführt werden. Dies nimmt Informationen seitens der LIDAR-, Radar- und Kamera-Systeme auf und fügt sie zusammen, um die Szene zu analysieren und Entscheidungen zu treffen, wie das Auto reagieren sollte.

Diese Reihe von Entscheidungen wird dann verwendet, um entweder etwas auf dem Armaturenbrett anzuzeigen oder tatsächlich einzugreifen, wobei eine bestimmte Aktion wie Bremsen oder Fahrspurwechsel durchgeführt wird.

Neuronale Netze im Automobil

Der Einsatz von CNNs in Automobilanwendungen wird rasch zunehmen und die Grundlage für das kamerabasierte, autonome Fahren bilden. So wird ein neues Fahrparadigma geschaffen. Weniger Unfälle, Verkehrstote und Staus. Eine geringere Luftverschmutzung durch weniger und effizientere Fahrten, Car-Sharing und die Möglichkeit, Autos über Fahrzeug-zu-Fahrzeug-Kommunikation (Car2Car) enger zu parken. Das alles trägt dazu bei, mehr Lebensqualität zu schaffen.

Der Autor

Bryce Johnstone

ist Marketing Director in der Automobilsparte von Imagination Technologies. Er absolvierte die Edinburgh University und schloss mit einem der ersten akademischen Abschlüsse Großbritanniens in Mikroelektronik ab. In seiner mittlerweile 28-jährigen Berufslaufbahn war er lange Zeit für STC und Texas Instruments tätig, wo er als ASIC-Entwickler begann und später in die Bereiche digitale Signalprozessoren, ADSL und WLAN wechselte.

Bryce.Johnstone@imgtec.com

- Augen für das autonome Fahren

- Wie hilft das selbstfahrende Fahrzeug?