Matlab-Expo

Auf dem Weg zur Autonomie

Fortsetzung des Artikels von Teil 1

Wie sich Autonomie auf Roboter auswirkt

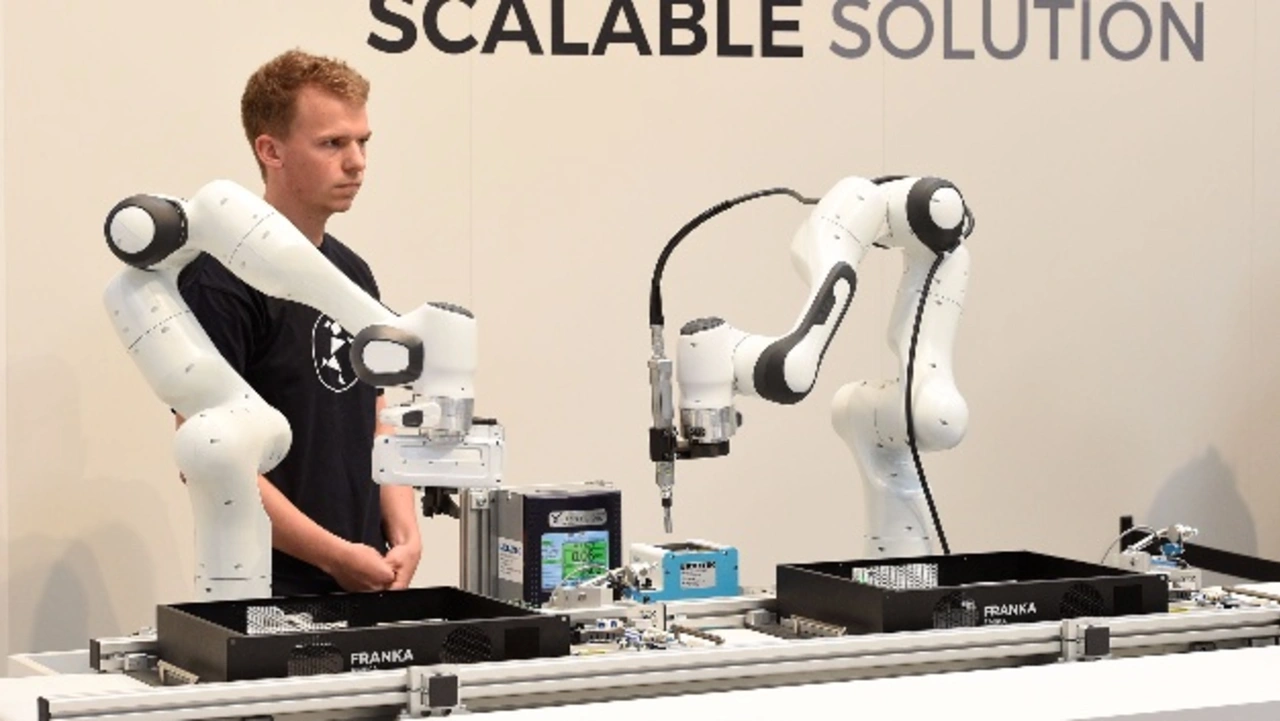

In einer zweiten Keynote zeigte Prof. Dr. Sami Haddadin die nächste Evolutionsstufe der Robotik. Wer heute von Robotern spricht, meint damit meist noch die Robotergeneration der achtziger Jahre, die dadurch gekennzeichnet ist, dass der Roboter simple mechanische Tätigkeiten ausführt und den ganzen Tag das Gleiche macht. Die neue Generation der Roboter wird hingegen interaktiv mit dem Menschen zusammenarbeiten können, wird vernetzt und lernfähig sein. Eine wichtige Voraussetzung dafür ist, dass der Roboter den Menschen nicht gefährdet. Dazu war es nötig, den Roboter mit einen Tastsinn und »Kollisionsreflexen« auszustatten, so dass er den Menschen bei einer Berührung nicht verletzt. Technisch wird dies mit einer sog. Impedanzregelung oder Drehmomentenregelung realisiert, die auch bewirkt, dass der Roboter Gegenstände mit einer gewissen Kraft berührt, die so groß ist, dass das Werkstück keinen Schaden nehmen kann.

Schon heute können Roboter sehen, hören und fühlen und werden bereits als »Remote-Person« an gefährlichen Orten eingesetzt. So machte ein Roboter z.B. erste Bilder aus dem Inneren des havarierten Atommeiler von Fukushima. Weitere Ort für derartige Robotereinsätze sind unter Wasser oder im Weltraum. Der nächste Entwicklungsschritt wird sein, dass Roboter zu Werkzeugen und persönlichen Assistenten werden, etwa in der »Geriatronik«, die schwerbehinderten Menschen bei einem selbstbestimmten Leben zuhause helfen soll. In einem Animationsfilm zeigte Haddadin, wie ein derartiger Roboter Essen anrichtet, ein Getränk eingießt und serviert, das Geschirr abräumt und in die Spülmaschine einräumt, die Schuhe bringt usw.

Jobangebote+ passend zum Thema

Neue Programmierparadigmen

Autonomie und künstliche Intelligenz kommen hier bei der Roboterprogrammierung ins Spiel. »Die Programmierung autonomer Systeme ist etwas anderes als die Programmierung eines PCs oder eines Smartphones,« sagt Prof. Haddadin. Denn das System bzw. der Roboter muss mit einer unvorhersehbaren Umwelt interagieren. Eine prozedurale Programmierung ist hier nicht mehr möglich. Am Beispiel des Robotes Franka Emika zeigte Haddadin, wie ein Roboter durch menschliche Führung eingelernt wird: Der Roboterarm wird an die Hand genommen wie ein kleines Kind und geführt. Auf einem PC, der an den Roboter angeschlossen ist, gibt es Apps für bestimmte »Handgriffe« und Bewegungen, die noch parametriert werden können.

Eine weitere, in den Forschungslabors befindliche Entwicklungsstufe ist schließlich der neuronal gesteuerte Roboter, der durch Gedanken gesteuert wird. Hierbei werden Prothesen so bewegt, dass der Mensch denkt, es seien seine eigenen Gliedmaßen.

- Auf dem Weg zur Autonomie

- Wie sich Autonomie auf Roboter auswirkt

- Autonom fahrende Nutzfahrzeuge