Automatisiertes Fahren

Warum Objekterkennung keine Sicherheit gewährleistet

Für Fahrfunktionen mit höherem Automatisierungsgrad ist eine sichere Bahnplanung nötig, die dynamische Objekte berücksichtigt. Bei der expliziten Erkennung von Objekten kann es zur Fehlerfortpflanzung in der Verarbeitungskette kommen. Integrierte Sensorfusionsalgorithmen vermeiden solche Fehler.

Verlässliche Objektdynamikdaten für eine konsistente Bahnplanung

Die Aufgabe jeder übergeordneten automatisierten Fahrfunktion ist es, zu bestimmen, wohin das Fahrzeug in Zukunft fahren soll. Aus globaler Sicht ist dies eine Navigationsaufgabe, die eine verlässliche Positionierung und eine Karte erfordert. Um jedoch nicht mit anderen Verkehrsteilnehmern oder Hindernissen zu kollidieren, ist zusätzlich zur globalen Planung eine kurzfristige Bewegungsplanung nötig. Die Bestimmung einer solchen kurzfristigen Planung wird oft als »Bahnplanung« bezeichnet.

Aus reiner Sicherheitsperspektive kann ein Fahrzeug an jede Stelle fahren, die nicht von einem Hindernis besetzt ist oder die freien Raum darstellt. In statischen Umgebungen lässt sich freier Raum mit einem Sensor wie einem LiDAR-Sensor bestimmen. Dann würde es ausreichen, die Bahn so zu planen, dass sich das Fahrzeug während der Fahrt immer innerhalb des ermittelten Freiraums befindet. Dies wäre sicher, da in statischen Umgebungen alle Objekte an ihrer aktuellen Position bleiben, während sich das Fahrzeug bewegt.

Sobald die Umgebung aber dynamische Objekte enthält, ist eine statische Bahnplanung nicht mehr sicher, da sich der freie Raum ändern könnte, während das Fahrzeug den geplanten Weg fährt. Um diese Einschränkung zu überwinden, muss die Bahn unter Berücksichtigung der Bewegung anderer Verkehrsteilnehmer geplant werden. Sobald die Dynamik der Objekte und somit ihre Geschwindigkeit und Fahrtrichtung bekannt ist, lässt sich vorhersagen, wo diese Objekte zu einem zukünftigen Zeitpunkt Raum einnehmen werden, und die geplante Bahn wird entsprechend angepasst.

Architekturen basierend auf Objekterkennung

Im Allgemeinen liefern Sensoren keine (Kamera, LiDAR) oder nur begrenzte (Radar) Informationen über die Dynamik eines Objekts. Stattdessen liefern sie 2D- oder 3D-Positionen von Reflexionen (LiDAR, Radar) und Daten auf Pixelebene (Kamera). Radarsensoren bilden eine Ausnahme, da sie zusätzlich die Radialgeschwindigkeit (Doppler) der Objekte liefern. Sie können jedoch nicht die Geschwindigkeit kreuzenden Verkehrs bestimmen und enthalten oft weitere Geschwindigkeits-Mehrdeutigkeiten. Der klassische Ansatz zur Bestimmung der Objektdynamik beruht auf

- einer Extraktion oder Erkennung von Objekten in den Sensor-Rohdaten, um 2D/3D-Bounding-Boxes in Welt- oder Bildkoordinaten zu erhalten und

- der Anwendung von Objektverfolgungsansätzen auf die erkannten Bounding Boxes und der Ableitung der Dynamik im Zeitverlauf.

Typischerweise haben Erkennungsfehler wie Falsch-Negative eine viel größere negative Auswirkung auf die Qualität des resultierenden Umfeldmodells als zusätzliche Sensorfehler, wie etwa die Genauigkeit der Entfernungsmessung eines Radars. Deshalb bergen Ansätze, die auf einer reinen Objekterkennung basieren, inhärente Risiken für sicherheitsrelevante Faktoren wie die Bahnplanung.

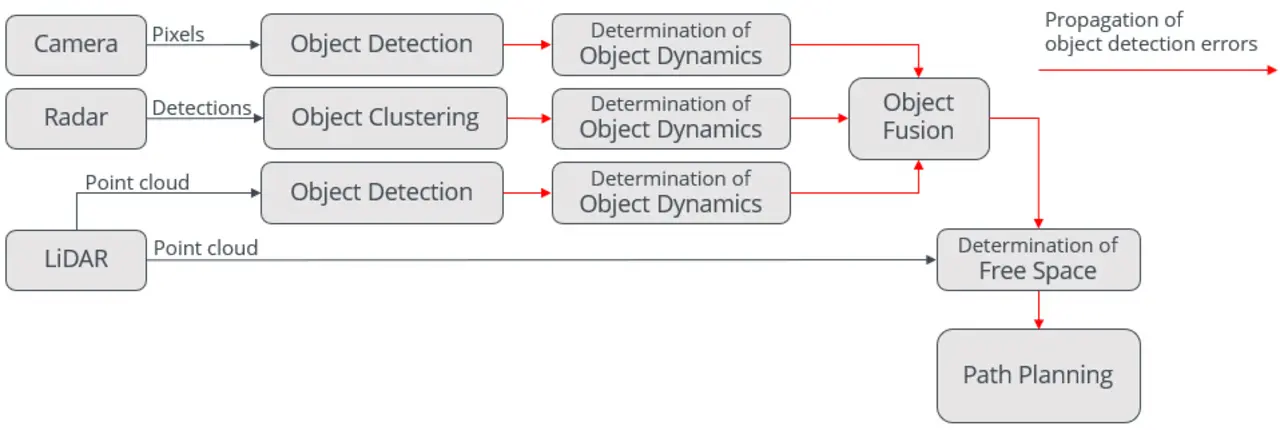

Für diese auf Objekterkennung basierenden Ansätze gibt es mehrere Architekturvorschläge. Bei der einzelsensorbasierten Objekterkennung und Dynamikbestimmung (Bild 1) werden die Objekte von jedem Sensor unabhängig erkannt/geclustert und verfolgt; anschließend erfolgt die Objektdatenfusion. Der freie Raum wird durch ein statisches Belegungsraster bestimmt. Dieses wird um die per Objektdatenfusion bereitgestellten dynamischen Objekte ergänzt.

Risiken für die Bahnplanung

Jedoch werden bei dieser Vorgehensweise Fehler bei der Objekterkennung auf die Bahnplanung übertragen, wodurch diese Architektur eine Reihe von potenziellen Nachteilen hat:

- Einzelsensorbasierte Objekterkennung und -verfolgung: Typisch für diese Architektur sind sogenannte intelligente Sensoren, die Objekte auf Grundlage der individuellen Informationen des Sensors erkennen und verfolgen. Intelligente Sensoren sind oft direkt mit einer Level-2-Fahrfunktion wie AEB (Autonomous Emergency Braking, Notbremsassistent) oder ACC (Adaptive Cruise Control, Abstandsregeltempomat) verbunden und daher auf niedrige Fehlalarmraten optimiert. Folglich übersehen diese Systeme eher ein Objekt, als dass sie einen Fehlalarm auslösen.

- Objektdatenfusion bei bereits verfolgten Objekten: Jeder intelligente Sensor hat abweichende Annahmen und modelliert Objekte unterschiedlich. Oft sind diese Annahmen dem Entwickler der Objektdatenfusion kaum bekannt, was zu falschen Modellen und eingeschränkter Objektdatenfusionsleistung führt. Selbst wenn die Annahmen bekannt sind, können sie aufgrund der typischen Modellierungsbeschränkungen der Algorithmen oft nicht in die Objektdatenfusion integriert werden.

- Weitergabe von Erkennungsfehlern: Die Bahnplanung erfolgt nach mehreren Verarbeitungsschritten, bei denen Fehler weitergegeben und potenziell akkumulieren können. Da die Objektdynamik von erkannten Objekten abgeleitet wird, führt jeder Fehler bei der Objekterkennung potenziell zu Fehlern in der Objektdynamik und beeinträchtigt somit die Sicherheit der Bahnplanung.

Detektionsbasierte Architekturen

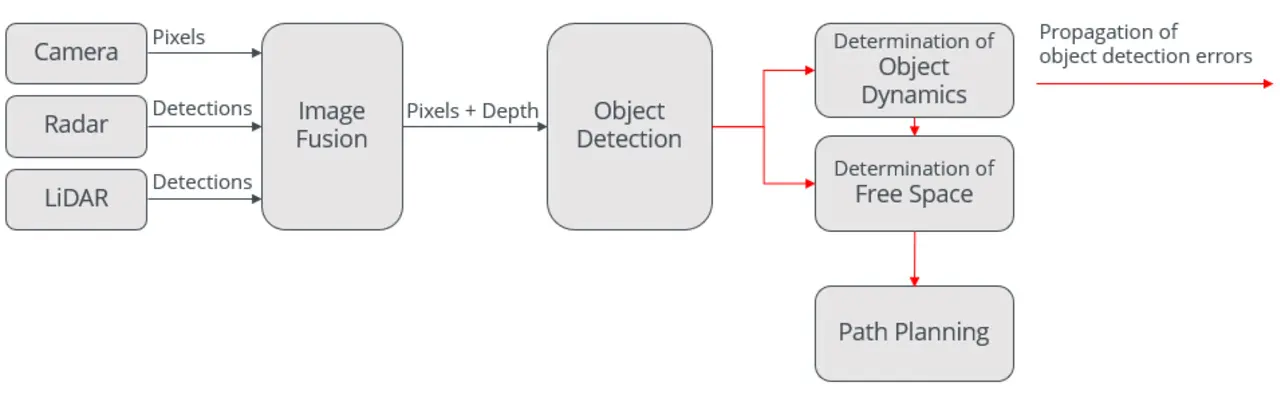

Verbesserte Architekturen kombinieren die Sensordaten auf einem niedrigen Level und erkennen und verfolgen Objekte auf Grundlage dieser fusionierten Informationen. Beim verbesserten detektionsbasierten Ansatz (Bild 2) werden Objekte mit künstlicher Intelligenz (KI) aus kombinierten Rohdaten extrahiert und erkannt. Anschließend wird die Objektdynamik über die Zeit mithilfe einer Objektdatenfusion abgeleitet und der freie Raum bestimmt.

Dennoch häufen sich die Fehler bei der Objekterkennung und landen in der Bahnplanung, da detektionsbasierte Architekturen weiter auf einer Objekterkennung und einer separaten Bestimmung von dynamischen Objekten und freiem Raum beruhen und können daher von denselben Fehlerquellen betroffen sein. Darüber hinaus hat dieser Ansatz weitere Nachteile:

- Zentralisierte Objekterkennung: Obwohl die Objekterkennung auf mehr Informationen zurückgreifen kann, hängt die Gesamtarchitektur immer noch von der Leistung der Objekterkennung ab, und Fehler bei der Objekterkennung wirken sich auf die Bahnplanung aus.

- Training erforderlich: Künstliche Intelligenz als Teil der Objekterkennung erfordert ein spezifisches Training für die aktuelle Sensorkonfiguration. Deshalb können keine vollständig vortrainierten Module (zum Beispiel von einem Zulieferer) verwendet werden.

Dynamische Grid-Datenfusion

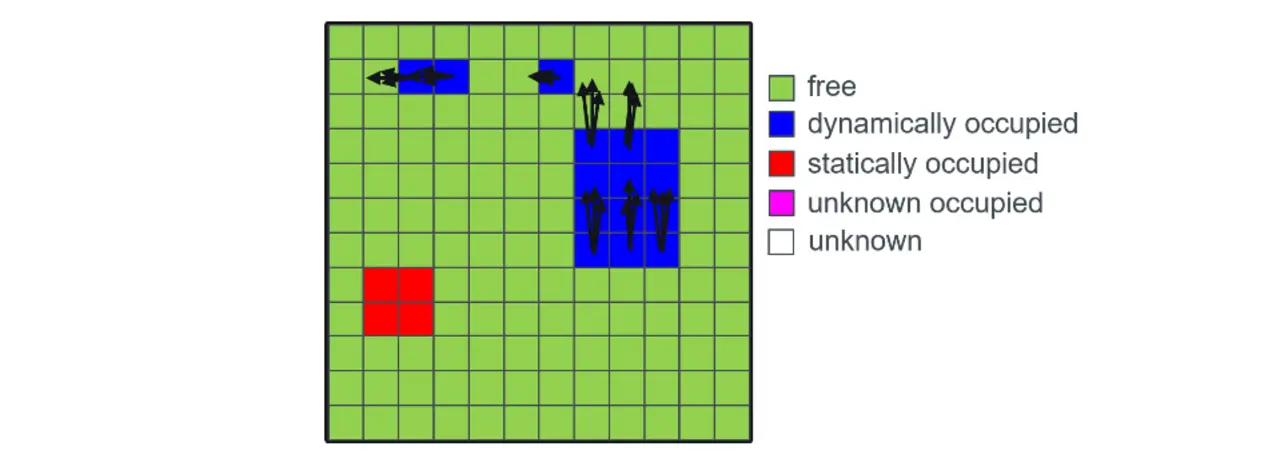

Während der klassische Ansatz die Erkennung von Objekten erfordert, um ihre Dynamik abzuleiten, und damit potenziell Fehler mit sich bringt, bestimmt die dynamische Grid-Datenfusion Größen wie Geschwindigkeit und Fahrtrichtung auf einer niedrigeren Ebene: der Zellenebene. Als Track-before-detect-Ansatz müssen mit Dynamic Grid Objekte nicht explizit erkannt werden. Stattdessen werden die dynamischen Größen für jede Zelle einzeln bestimmt (Bild 3).

Diese zellenbasierte Bestimmung dynamischer Größen erfordert weniger a-priori-Wissen über relevante Objekte für die Bahnplanung. Dies ermöglicht die Ableitung der Dynamik von Objekten, selbst wenn ihre Form zum Entwicklungszeitpunkt unbekannt ist.

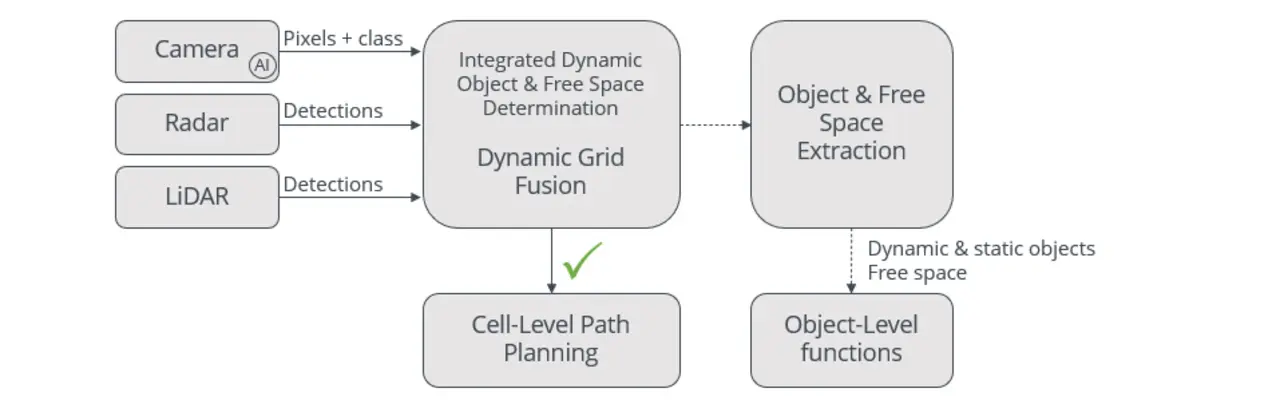

Wenn Objekte nicht explizit erkannt und klassifiziert werden müssen, können typische Erkennungsfehler die Bahnplanung von vornherein nicht beeinträchtigen. Für andere Funktionen können jedoch explizit erkannte Objekte erforderlich sein, zum Beispiel für die Anwendung von Verkehrsregeln wie die Vorfahrt für andere Verkehrsteilnehmer. Eine Architektur, die auf einer dynamischen Grid-Datenfusion basiert (Bild 4), ermöglicht die freie Wahl der besten Datenebene für jede Funktion: Auf Zellebene für die Bahnplanung; auf Objektebene für andere Funktionen.

Frühzeitige und konsistente Bahnplanung

In einer Architektur basierend auf einer Dynamic-Grid-Datenfusion bestimmt der Low-Level-Sensor-Fusion-Ansatz dynamische und statische Objekte sowie den freien Raum auf integrierte Weise. Die Extraktion potenziell fehlerhafter Objekte erfolgt erst nach der Bahnplanung und hat somit keinen Einfluss auf deren Sicherheit. Dieser Ansatz hat zahlreiche Vorteile:

- Sichere Bahnplanung durch konsistente Belegungsschätzung: Die Belegung der relevanten Bereiche wird auf Zellenebene konsistent vorhergesagt. Da keine Objekterkennung involviert ist, können sich Erkennungsfehler nicht auf die Bahnplanung übertragen.

- Unterstützung für unbekannte dynamische Objekte: Das Dynamic Grid bestimmt die Dynamik von Objekten, auch wenn ihr Typus zum Zeitpunkt der Entwicklung noch unbekannt ist.

- Ohne künstliche Intelligenz: Die Dynamic-Grid-Datenfusion enthält keine künstliche Intelligenz und basiert rein auf statistischen Methoden. Bei sicherheitskritischen Anwendungen erfordern Verifizierung und Validierung weniger Aufwand.

- Optionale Objekterkennung: Obwohl die Bahnplanung auf Zellenebene erfolgen kann, ist eine explizite oder zusätzliche Objektextraktion möglich und wird gut unterstützt. Denn die verfügbaren dynamischen Informationen erhöhen die Zuverlässigkeit der Objektextraktion und des Clustering.

- Flexible Sensorkonfiguration: Je nach Anwendung können verschiedene Sensorarten frei kombiniert werden, ohne dass eine bestimmte Art (zum Beispiel eine Kamera) erforderlich ist.

- Kein Training: Da am Dynamic Grid keine KI beteiligt ist, ist kein datenintensives Training nötig. Optional kann die Dynamic-Grid-Architektur vollständig vorbereitete Module von Anbietern enthalten.

Der Autor

Dr. Eric Richter

ist Director Technology Innovation und Mitgründer von Baselabs.